Procesamiento asociativo en memoria escalable para inferencia de redes neuronales en gráficos

Introducción: Las redes neuronales de grafos o GNN han demostrado un gran potencial en análisis de redes sociales, descubrimiento de fármacos y sistemas de recomendación, pero la inferencia en grafos de gran tamaño choca con cuellos de botella por el intenso movimiento de datos y operaciones de paso de mensaje. Presentamos AGIA, Associative Graph Inference Accelerator, una propuesta de arquitectura basada en procesamiento asociativo en memoria que reduce drásticamente la transferencia de datos y acelera la inferencia manteniendo precisión elevada.

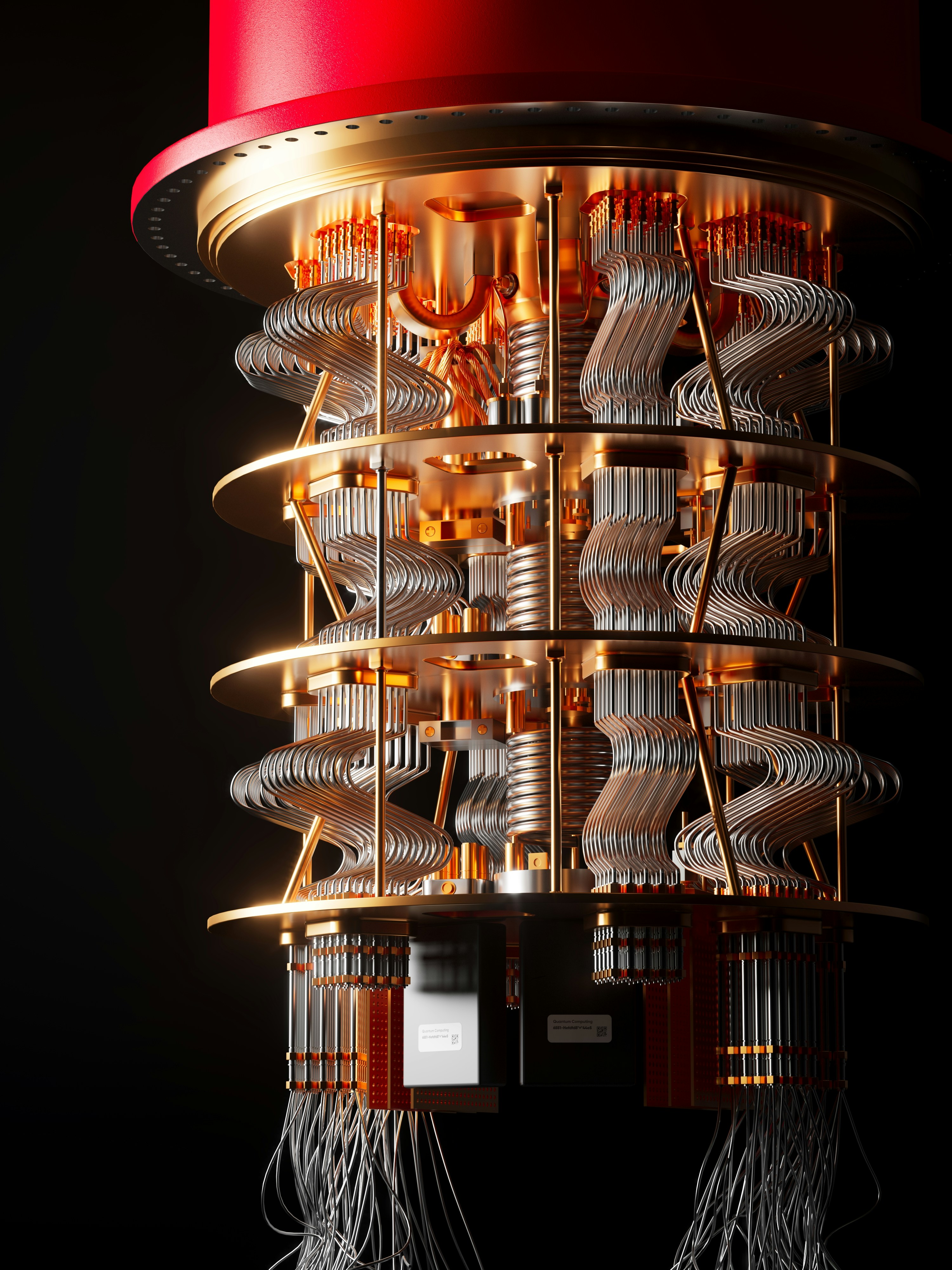

Contexto y trabajos previos: Las aceleraciones actuales para GNN suelen descansar en GPUs o ASICs optimizados para multiplicaciones matriciales, pero las GNN ejercen accesos irregulares y trabajan con grafos dispersos, escenarios donde estos aceleradores no rinden de forma ideal. El procesamiento asociativo en memoria, usado tradicionalmente en bases de datos, ofrece una vía para explotar la naturaleza asociativa de los grafos y ejecutar convoluciones de grafo dentro de la memoria. AGIA extiende conceptos de near memory computing hacia una solución escalable y programable para inferencia de GNN.

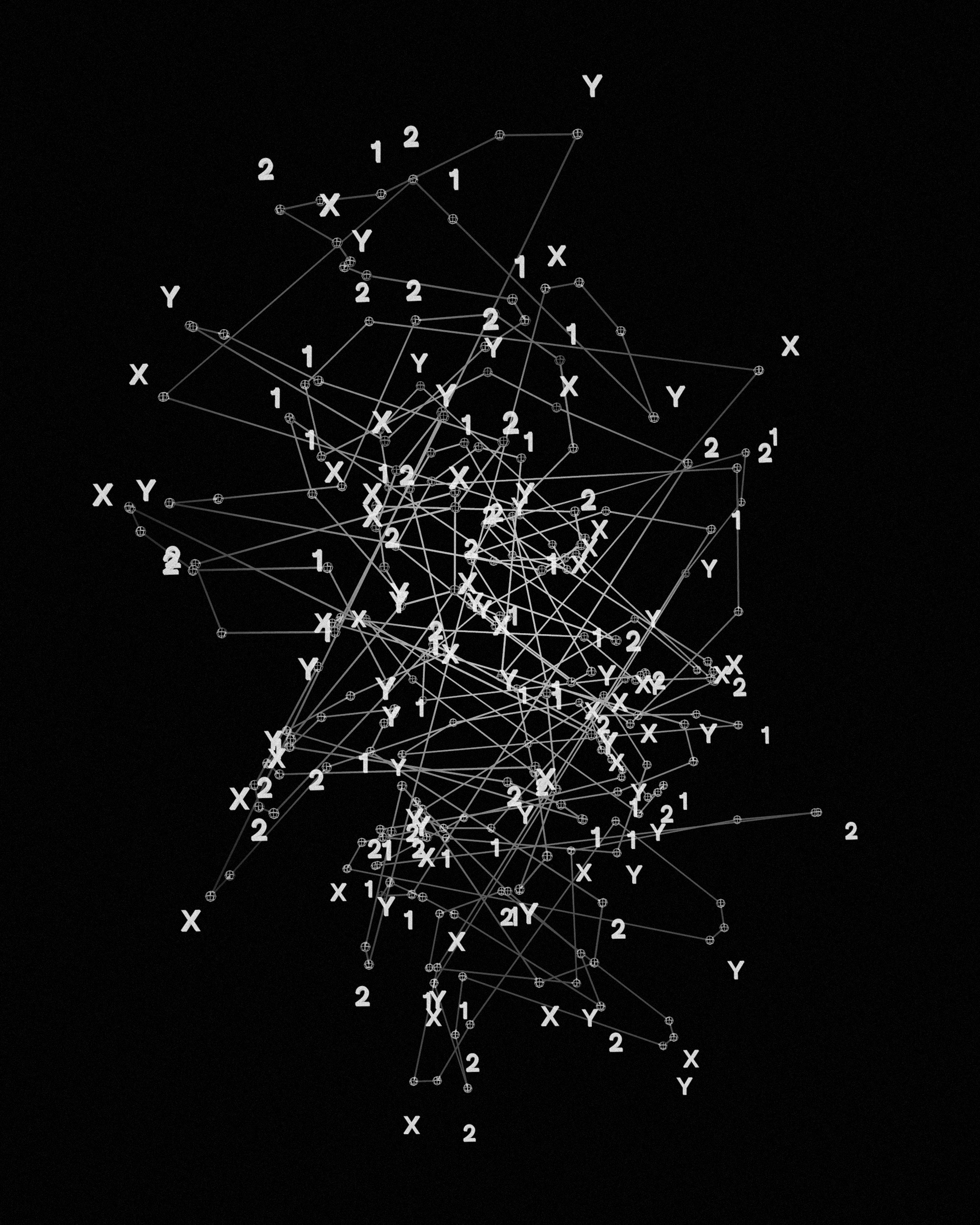

Visión general de la arquitectura: AGIA reconfigura una matriz de memoria resistiva ReRAM para funcionar como un procesador asociativo masivamente paralelo. La matriz de ReRAM representa la matriz de adyacencia del grafo. Las características de los nodos se codifican como vectores binarios que se aplican sobre la matriz, permitiendo que la operación asociativa realice el paso de mensaje correlacionando características de nodos según la conectividad directamente en memoria. Los bloques principales son: un buffer de entrada para cargar características, la matriz ReRAM como motor asociativo, un buffer de salida para las características agregadas y una unidad de control que orquesta el flujo de datos.

Operación de convolución asociativa: La convolución de grafo clásica se describe como H(l+1) = s(D(-1/2) A D(-1/2) H(l) W(l)). En AGIA se distribuyen las tareas así: la normalización por la matriz de grado se incorpora en la configuración de resistencias de la ReRAM, la multiplicación A H(l) con normalización se realiza de forma asociativa y en paralelo dentro de la matriz resistiva, y la multiplicación por los pesos W(l) y la activación s se llevan a cabo en una unidad de procesamiento posterior. Este enfoque minimiza las transferencias de memoria y aprovecha la paralelización nativa de la ReRAM.

Diseño experimental: Evaluaremos AGIA en conjuntos de datos estándar como Cora, CiteSeer y ogbn-arxiv, comparando contra implementaciones de inferencia en GPU. Las métricas serán velocidad de inferencia en muestras por segundo, eficiencia energética por inferencia y exactitud. Además desarrollaremos protocolos de calibración y control para gestionar variabilidad y resistencia de los dispositivos ReRAM.

Adaptación y optimización: Para ajustar los estados resistivos de la ReRAM se empleará un algoritmo iterativo apoyado en técnicas de optimización bayesiana y aprendizaje por refuerzo. La función objetivo combinará tiempo medio de inferencia, consumo energético y precisión del modelo en una función de coste que permita priorizar robustez cuando sea necesario.

Resultados esperados e impacto: Se estima que AGIA puede ofrecer aceleraciones de 5x a 10x en tiempo de inferencia y mejoras de 2x a 5x en eficiencia energética frente a soluciones GPU, lo que facilitaría despliegues de GNN de escala real en entornos cloud y edge. El impacto comercial incluye aplicaciones en sistemas de recomendación, análisis de redes sociales y descubrimiento en biomedicina. Académicamente, el trabajo ampliará el campo del procesamiento asociativo en memoria para tareas de grafo.

Hoja de ruta de escalabilidad: en el corto plazo construiremos prototipos con matrices ReRAM a pequeña escala y validaremos en grafos de referencia. En el medio plazo escalaremos la matriz, mejoraremos la interfaz de alta banda y exploraremos arquitecturas ReRAM para densidad y rendimiento. En el largo plazo se buscará integración 3D y un producto comercial listo para inferencia de GNN a gran escala.

Funciones matemáticas y representación de datos: El comportamiento de la ReRAM se modelará mediante funciones físicas de la forma R(V) = k V(-alpha V) con parámetros dependientes del material, y la codificación de conexiones se realizará mediante funciones no lineales tipo sigmoide para mapear fuerza de conexión a valores resistivos. Las características de nodo se cuantizarán y codificarán como vectores binarios por bits para su almacenamiento en la matriz resistiva. La optimización de hiperparámetros X seguirá una función objetivo de carácter multiobjetivo que combine tiempo, energía y precisión para orientar el aprendizaje por refuerzo.

Verificación y confiabilidad: Se aplicarán algoritmos de control en tiempo real para estabilizar resistencias y compensar deriva, junto con simulaciones detalladas y experimentos a pequeña escala para validar exactitud numérica frente a implementaciones de referencia. También se evaluará la resistencia a ruido y la tolerancia a fallos para garantizar resultados reproducibles.

Contribución técnica: AGIA introduce el uso directo del procesamiento asociativo en memoria para realizar la convolución de grafos, cambiando la paradigmas de cálculo de multiplicación matricial tradicional por operaciones asociativas dentro de la memoria ReRAM, y combinando esto con algoritmos de adaptación aprendidos que maximizan precisión y eficiencia.

Aplicaciones prácticas y servicios: En Q2BSTUDIO somos una empresa de desarrollo de software especializada en soluciones a medida y en inteligencia artificial aplicada a empresas. Ofrecemos servicios de software a medida y aplicaciones a medida, integración con servicios cloud aws y azure, ciberseguridad y pentesting, así como servicios de inteligencia de negocio y Power BI. Podemos ayudar a transformar prototipos como AGIA en soluciones integradas con arquitecturas cloud y pipelines de despliegue continuo. Conozca nuestras propuestas de IA y consultoría técnica en IA para empresas y descubra nuestras capacidades en desarrollo de aplicaciones en software a medida y aplicaciones a medida.

Palabras clave: aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA, power bi.

Conclusión: El procesamiento asociativo en memoria escalable para inferencia de GNN representa una vía prometedora para superar las limitaciones actuales en rendimiento y consumo energético. AGIA propone una integración innovadora de tecnología ReRAM, algoritmos de adaptación y un enfoque orientado al producto que facilita su transferencia a entornos comerciales y cloud. Q2BSTUDIO está preparada para apoyar el desarrollo, validación y despliegue de soluciones derivadas de esta investigación, integrando experiencia en inteligencia artificial, ciberseguridad y servicios cloud para llevar la tecnología del laboratorio a la producción.

Comentarios