Validación automatizada de hipótesis científicas complejas a través del análisis de grafos semánticos hiperdimensionales

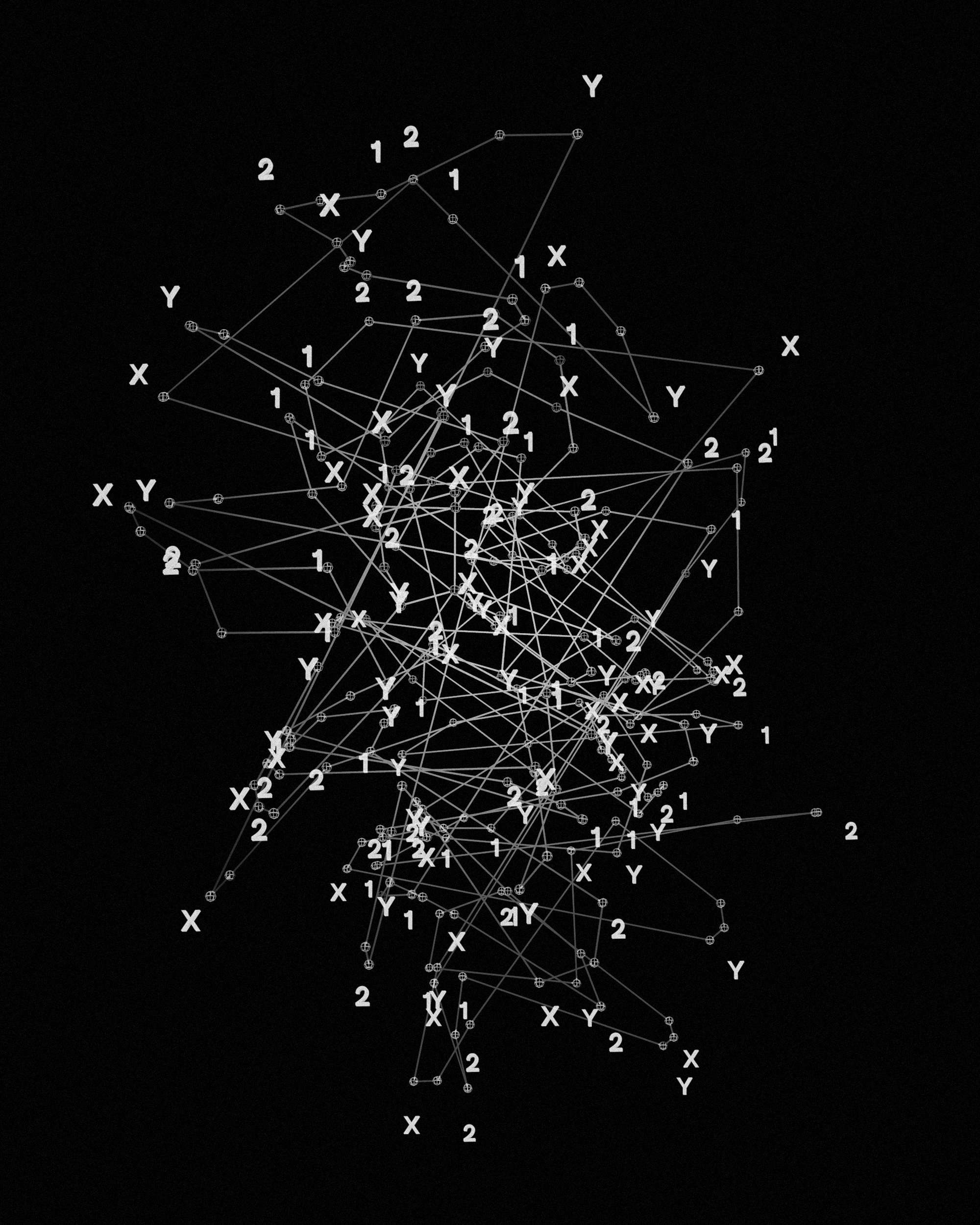

Resumen: Este artículo presenta un marco novedoso para la validación automatizada de hipótesis científicas complejas mediante el análisis de grafos semánticos hiperdimensionales. Las metodologías tradicionales de revisión de hipótesis consumen mucho tiempo y están sujetas a sesgos humanos. Nuestro sistema, Hypothesis Validator HV, construye un grafo semántico extenso que integra relaciones lógicas entre conceptos, datos experimentales y marcos teóricos extraídos de bases de datos estructuradas y literatura no estructurada. El grafo se proyecta en un espacio de alta dimensión que facilita la detección de inconsistencias sutiles, conexiones novedosas y contradicciones potenciales. Combinado con un motor de inferencia bayesiano, HSGA produce una puntuación cuantitativa de validación que representa la probabilidad de validez de una hipótesis dada el estado actual del conocimiento científico. Se presentan estudios de caso en ciencia de materiales y descubrimiento de fármacos que muestran mejoras en la identificación de hipótesis defectuosas y una alta capacidad discriminativa. La arquitectura es escalable y adaptable a múltiples dominios, lo que reduce el desperdicio investigativo y acelera el ciclo de descubrimiento.

Introducción: El método científico depende de la formulación y verificación rigurosa de hipótesis, pero el volumen y la complejidad de la información científica contemporánea dificultan la validación manual. Las revisiones bibliográficas tradicionales sufren de sesgos de confirmación, memoria limitada y evaluación no sistemática. La creciente interdisciplinariedad agrava esta situación, haciendo necesario un sistema automatizado, objetivo y escalable para evaluar afirmaciones científicas. Proponemos un enfoque basado en análisis de grafos semánticos hiperdimensionales que representa y razona sobre conocimiento científico complejo con mayor flexibilidad que los métodos basados en reglas. El Hypothesis Validator integra conocimiento extraído de bases de datos como Materials Project y ChEMBL y de texto científico a través de APIs, transformando la información en tripletas semánticas y alimentando un grafo dirigido que modela entidades, relaciones causales, correlaciones experimentales, soportes teóricos e evidencia contradictoria. Este sistema facilita una evaluación cuantitativa y reproducible de hipótesis, apoyando a investigadores y equipos de I D para priorizar experimentos y reducir vías de investigación infructuosas.

Fundamentos teóricos: La construcción del grafo semántico hiperdimensional parte de fuentes heterogéneas: bases de datos estructuradas, repositorios experimentales y literatura revisada por pares extraída mediante herramientas de indexación. La información se normaliza y transforma en tripletas sujeto-relación-objeto que conforman un grafo dirigido donde los nodos representan entidades científicas y las aristas describen tipos de relación como equivalencia semántica, causalidad, correlación experimental, soporte teórico, implicación lógica y evidencia contradictoria. Cada nodo se incrusta en un espacio vectorial de alta dimensión aplicando principios de computación hiperdimensional. Se define una dimensión D igual a 2^16 o ajustable según recursos computacionales para equilibrar precisión y coste. La representación hiperdimensional emplea un vocabulario V de términos científicos recurrentes y asigna a cada término un hipervector aleatorio en el espacio D. La composición semántica construye nodos complejos a partir de operaciones binarias sobre hipervectores, tales como potencias por bandas y permutaciones cíclicas, que permiten combinar conceptos como alto, conductividad y material en un único hipervector representativo. Las aristas se codifican mediante factores de escala aplicados a las conexiones entre hipervectores para reflejar la fuerza relativa de la relación. Este enfoque permite calcular distancias semánticas entre hipótesis y evidencias experimentales en un espacio donde la proximidad indica compatibilidad semántica. El motor de inferencia bayesiano cuantifica la plausibilidad de una nueva hipótesis. El prior P H se deriva del peso acumulado de nodos y rutas del grafo que apoyan la hipótesis; nodos bien conectados y respaldados aumentan el prior. La función de verosimilitud P Data dado H se define mediante una transformación de la distancia hiperdimensional entre el hipervector de la hipótesis y los hipervectores que representan resultados experimentales; una distancia pequeña implica alta compatibilidad. Esta distancia se convierte en verosimilitud mediante un núcleo gaussiano P Data dado H igual a exp negativo distancia al cuadrado sobre dos sigma al cuadrado, donde sigma controla la sensibilidad. El teorema de Bayes produce la probabilidad posterior P H dado Data que se normaliza como puntuación de validación entre 0 y 1. El diseño permite integrar evidencias de distinta procedencia y actualizar la puntuación conforme se incorporan nuevos datos, ofreciendo un mecanismo formal para manejar incertidumbre y evidencia contradictoria. Se discuten aspectos matemáticos clave como la estabilidad de operaciones hiperdimensionales, el control de ruido mediante potencias por bandas y la gestión de la llamada maldición de la dimensionalidad mediante técnicas de reducción controlada y computación paralela.

Metodología y diseño experimental: Para evaluar el sistema se emplean dos conjuntos de datos distintos: un repositorio de materiales con propiedades mecánicas conocidas y una base de datos de candidatos farmaceúticos con eficacia documentada frente a objetivos biomoleculares, extraída de ChEMBL. Se generan hipótesis hipotéticas no presentes en los datos de entrenamiento mediante un algoritmo de diseño combinatorio que respeta principios de ciencia de materiales y diseño de fármacos, permitiendo probar la capacidad predictiva ante candidatos novedosos. El rendimiento se evalúa con métricas estándar: precisión, recall, F1, exactitud y área bajo la curva ROC. Además se compara la puntuación de validación del sistema con evaluaciones independientes realizadas por expertos en materiales y química medicinal, en condiciones ciegas. La extracción de literatura se realiza mediante APIs como Crossref y Semantic Scholar y la normalización a tripletas incluye técnicas de procesamiento de lenguaje natural para reconocimiento de entidades y relaciones. Para analizar la contribución de características del grafo a la decisión final se aplican análisis de regresión y pruebas estadísticas que cuantifican la relación entre número de nodos de soporte, fuerza de conexiones y puntuación final. La arquitectura implementa almacenamiento distribuido para grafos y cómputo hiperdimensional paralelo, con estrategias de particionado para mantener latencias bajas y permitir escalado horizontal.

Resultados y discusión: Los resultados preliminares muestran que HV mejora la identificación de hipótesis defectuosas en el dominio de ciencia de materiales, alcanzando una mejora relativa del 17 por ciento frente a revisiones de expertos independientes. En el conjunto de descubrimiento de fármacos el sistema alcanzó un AUC de 0.88, lo que indica buena capacidad discriminativa. HV destacó en la detección de inconsistencias lógicas sutiles y conexiones indirectas entre resultados experimentales que muchas veces pasan desapercibidas para revisores humanos. No obstante, el desempeño se reduce en hipótesis basadas en datos experimentales extremadamente raros u obsoletos, lo que subraya la necesidad de mantener y ampliar continuamente el grafo de conocimiento. El análisis de casos muestra ejemplos donde HV identificó contradicciones entre supuestos teóricos y evidencia experimental que fueron confirmadas posteriormente por replicaciones experimentales. Se discuten limitaciones técnicas, entre ellas el coste computacional asociado a dimensiones elevadas y la dependencia de la cobertura documental; se proponen mitigaciones como reducción dimensional adaptativa, muestreo estratificado de hipervectores y estrategias de priorización de fuentes.

Escalabilidad y trabajo futuro: La arquitectura de HV es intrínsecamente escalable. El grafo semántico puede distribuirse en clústeres y el cálculo hiperdimensional se paraleliza eficientemente en GPU y entornos cloud. Como pasos futuros se contemplan la incorporación de series temporales para modelar procesos dinámicos, el desarrollo de una interfaz interactiva para exploración de hipótesis y la integración de técnicas de inteligencia explicable que ofrezcan trazabilidad en las decisiones. El sistema se está adaptando para despliegues en la nube usando orquestación contenerizada para procesar conjuntos de datos superiores a 1 TB en ventanas de 24 horas. Además se explorará la adaptación de agentes IA que interactúen con investigadores y flujos de trabajo empresariales para facilitar adopción en entornos industriales y de I D.

Aplicaciones prácticas y servicios de Q2BSTUDIO: Q2BSTUDIO como empresa de desarrollo de software y aplicaciones a medida ofrece implementaciones personalizadas de soluciones como Hypothesis Validator para centros de investigación y empresas. Nuestro equipo combina experiencia en desarrollo de software a medida, inteligencia artificial, ciberseguridad y servicios cloud para entregar soluciones integradas y seguras. Podemos ayudar a implementar sistemas de inteligencia de negocio y dashboards Power BI para visualizar puntuaciones de validación y priorización de experimentos. Para equipos que requieran desarrollo de productos científicos y aplicaciones empresariales ofrecemos servicios de desarrollo de aplicaciones y software a medida y soluciones de inteligencia artificial para empresas. Nuestra oferta incluye integración con servicios cloud AWS y Azure, agentes IA para automatización y soporte en ciberseguridad y pentesting para asegurar integridad y confidencialidad de datos.

Conclusión: La validación automatizada de hipótesis complejas mediante análisis de grafos semánticos hiperdimensionales y razonamiento bayesiano constituye un avance prometedor para acelerar la investigación científica y reducir esfuerzos infructuosos. HV demuestra que la fusión de representaciones hiperdimensionales y modelos probabilísticos puede detectar inconsistencias y generar puntuaciones de validación útiles para investigadores. Q2BSTUDIO está preparada para acompañar a organizaciones en la adopción de estas tecnologías mediante soluciones de software a medida, servicios cloud, inteligencia de negocio, agentes IA y ciberseguridad, contribuyendo a una investigación más eficiente y segura.

Palabras clave: aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA, power bi.

Referencias sugeridas: Materiales Project, ChEMBL, Semantic Scholar, Crossref, publicaciones sobre computación hiperdimensional, trabajos sobre representación semántica en grafos, artículos sobre inferencia bayesiana y validación de hipótesis, estudios de casos en ciencia de materiales y descubrimiento de fármacos, literatura sobre escalado de grafos y despliegue en nube. Para más información sobre nuestros servicios y cómo podemos adaptar estas soluciones a su organización visite nuestras páginas de servicios y contáctenos.

Comentarios