Por qué converge el descenso de gradiente en redes neuronales (a veces no)

Este artículo revisa la implementación de algoritmos de descenso de gradiente para minimizar funciones de pérdida global en redes neuronales, con especial atención a problemas gobernados por condiciones de Rankine-Hugoniot. En problemas con discontinuidades o soluciones tipo choque, la función de pérdida puede presentar regiones abruptas y no suaves, pero el descenso de gradiente sigue siendo una herramienta viable para aproximar soluciones siempre que se elijan estrategias numéricas adecuadas.

El descenso de gradiente converge en muchos casos porque reduce iterativamente la pérdida siguiendo la dirección de mayor disminución local. Sin embargo, esa convergencia no es automática: depende del paisaje de la función de pérdida, del condicionamiento del problema, del tamaño del paso o learning rate, y de la arquitectura de la red. En presencia de condiciones como Rankine-Hugoniot, que imponen restricciones en interfaces y saltos de variables, la pérdida global puede ser especialmente compleja y requerir tratamientos que respeten esas condiciones para que el algoritmo encuentre soluciones físicas correctas.

Entre las razones por las que a veces no converge se encuentran la presencia de mínimos locales poco favorables, puntos silla plateados donde el gradiente es nulo pero no hay mínimo, gradientes que desaparecen o explotan en redes profundas, y una mala elección del learning rate que provoca oscilaciones o pasos demasiado pequeños. Estrategias como normalización de datos, inicializaciones adecuadas, optimizadores adaptativos, momentum, tasa de aprendizaje escalonada y arquitecturas con atajos ayudan a mitigar estos problemas.

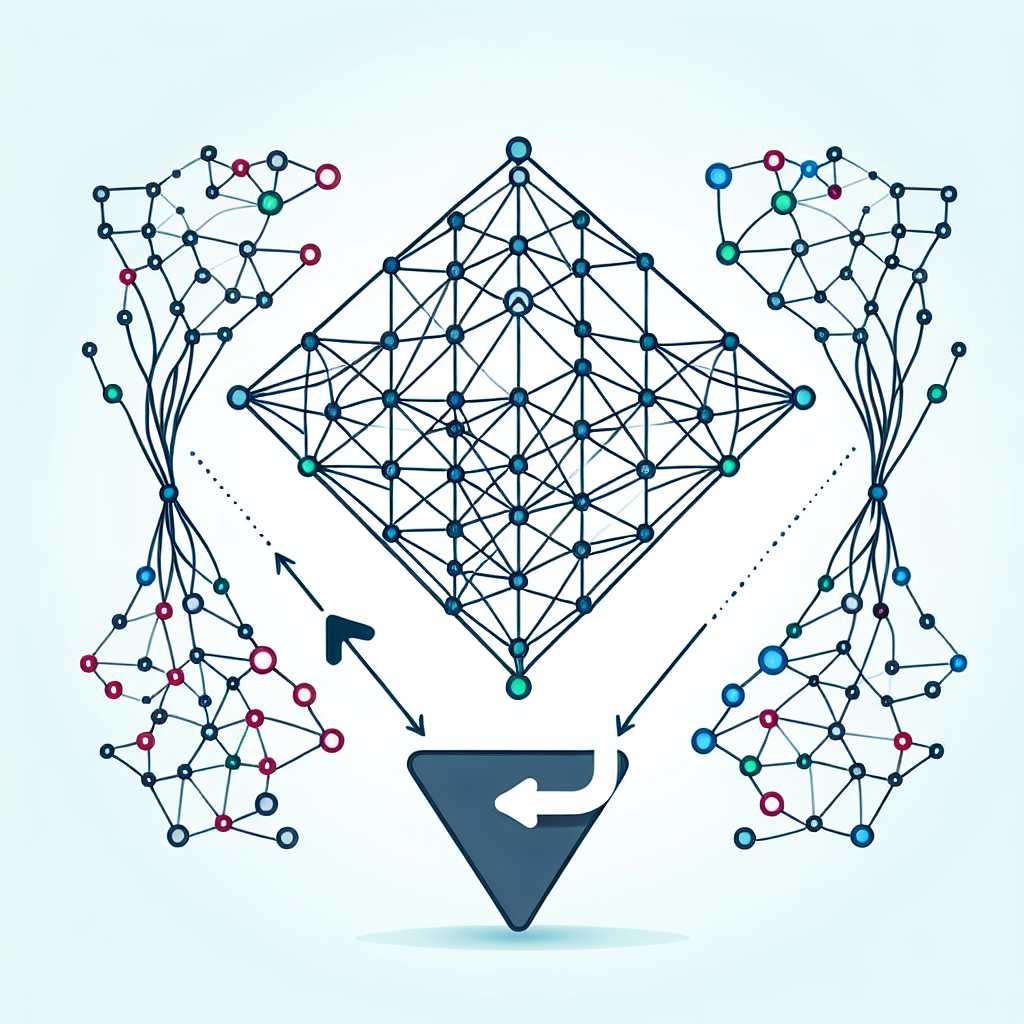

Cuando la dimensión del dominio crece y se acoplan muchas redes entre sí, surgen problemas de escalabilidad: calcular y propagar gradientes globales puede ser costoso y lento. Para afrontar esta limitación, se puede emplear un método de descomposición del dominio DDM que divide el problema global en subdominios y define pérdidas locales asociadas a cada subdominio. Las subredes optimizan sus pérdidas de forma paralela y se coordinan mediante condiciones de interfaz que garantizan coherencia con las condiciones de Rankine-Hugoniot. Este enfoque reduce el coste computacional, mejora la paralelización y acelera la convergencia en problemas grandes y acoplados.

El uso de DDM combinado con técnicas de aprendizaje profundo ofrece ventajas prácticas: menor tiempo de entrenamiento gracias al cálculo distribuido, mejor escalado en clústeres y nubes, y una arquitectura modular que facilita la depuración y el ajuste fino. En entornos industriales, estas soluciones se benefician de infraestructuras escalables como servicios cloud aws y azure y herramientas de monitorización que permiten observar métricas de convergencia en tiempo real.

En Q2BSTUDIO diseñamos soluciones que integran investigación numérica y buenas prácticas de ingeniería para garantizar convergencia y escalabilidad. Como empresa de desarrollo de software y aplicaciones a medida, ofrecemos servicios que abarcan desde el desarrollo de aplicaciones a medida hasta la creación de modelos de inteligencia artificial preparados para producción. Nuestro equipo de especialistas en inteligencia artificial y ciberseguridad trabaja para que los modelos sean robustos frente a fallos y ataques, y para que la infraestructura cumpla requisitos de rendimiento y confidencialidad.

Además, Q2BSTUDIO presta servicios integrales que incluyen ciberseguridad, pentesting, servicios cloud aws y azure, servicios inteligencia de negocio y soluciones con power bi para visualizar y analizar resultados de entrenamiento y métricas de negocio. Ofrecemos también soluciones de ia para empresas y agentes IA que automatizan procesos críticos y aportan inteligencia accionable. Si necesita una estrategia completa que combine investigación en optimización, despliegue en la nube y seguridad, podemos diseñar un proyecto a medida que acelere la adopción de IA en su organización.

Para maximizar la probabilidad de convergencia en proyectos reales recomendamos prácticas concretas: controlar la escala del gradiente mediante normalización y regularización, adaptar el learning rate con técnicas de calentamiento y decrecimiento, emplear precondicionadores o optimizadores basados en segundo orden cuando sea viable, y aprovechar la descomposición del dominio y el entrenamiento distribuido para problemas de gran escala. La adopción de pipelines reproducibles y monitorización continua favorece la detección temprana de problemas y la toma de decisiones informadas.

En resumen, el descenso de gradiente es una herramienta potente para minimizar pérdidas incluso en problemas complejos con condiciones de Rankine-Hugoniot, pero su éxito depende de diseño de la red, elección del optimizador, tratamiento de interfaces y estrategia de computación. Q2BSTUDIO puede acompañar a su empresa en todo ese recorrido, desde la concepción del algoritmo hasta el despliegue seguro en producción y la integración con sistemas empresariales mediante servicios personalizados. Con una combinación de experiencia en software a medida, inteligencia artificial y ciberseguridad, ayudamos a transformar investigaciones avanzadas en soluciones reales y escalables.

Comentarios