Optimización de un algoritmo de equilibrio de carga para minimizar el tiempo de ejecución de un proceso estático

Este artículo presenta una versión reescrita y traducida al español de un estudio sobre la optimización del equilibrio de carga de ejecuciones de pruebas Cypress en procesos estáticos, y cómo una alternativa al tradicional round-robin mejora significativamente los tiempos totales de ejecución. Además, incluimos cómo Q2BSTUDIO, empresa de desarrollo de software y especialista en aplicaciones a medida, inteligencia artificial y ciberseguridad, puede ayudar a integrar soluciones similares en entornos productivos.

Problema con el enfoque round-robin en procesos estáticos: El algoritmo round-robin reparte tareas en orden secuencial entre los workers o runners. Para tráfico de red dinámico esta aproximación es adecuada porque mantiene la carga distribuida en tiempo real. Sin embargo, para la ejecución de pruebas mediante el comando cypress run, que es un proceso estático con inicio y fin definidos, el objetivo no es solo repartir archivos sino minimizar el tiempo total hasta que todas las pruebas han terminado. Con round-robin, si los archivos se ordenan por duración, un runner puede recibir sistemáticamente los archivos de mayor duración, provocando grandes desequilibrios y aumentando el tiempo total de la suite de pruebas.

Nuevo objetivo: minimizar el tiempo total de ejecución mientras se distribuyen los archivos de prueba de forma equilibrada entre los runners disponibles. Para ello hay que basarse en mediciones históricas de cada archivo de prueba para estimar su duración futura y aprovechar estos datos al asignar cargas.

Observaciones clave sobre cypress run: es un proceso estático con inputs concretos que recibe una lista de archivos o patrones. El tiempo total de ejecución es la suma de los tiempos de los archivos asignados a cada runner paralelizado. Si cada archivo pudiera ejecutarse por separado en paralelo, el tiempo mínimo sería el del archivo más largo. Por eso es fundamental que la suma de los tiempos asignados a cada runner sea lo más equilibrada posible y, cuando exista un archivo extremadamente largo, preferirle su propio runner para que no afecte al resto.

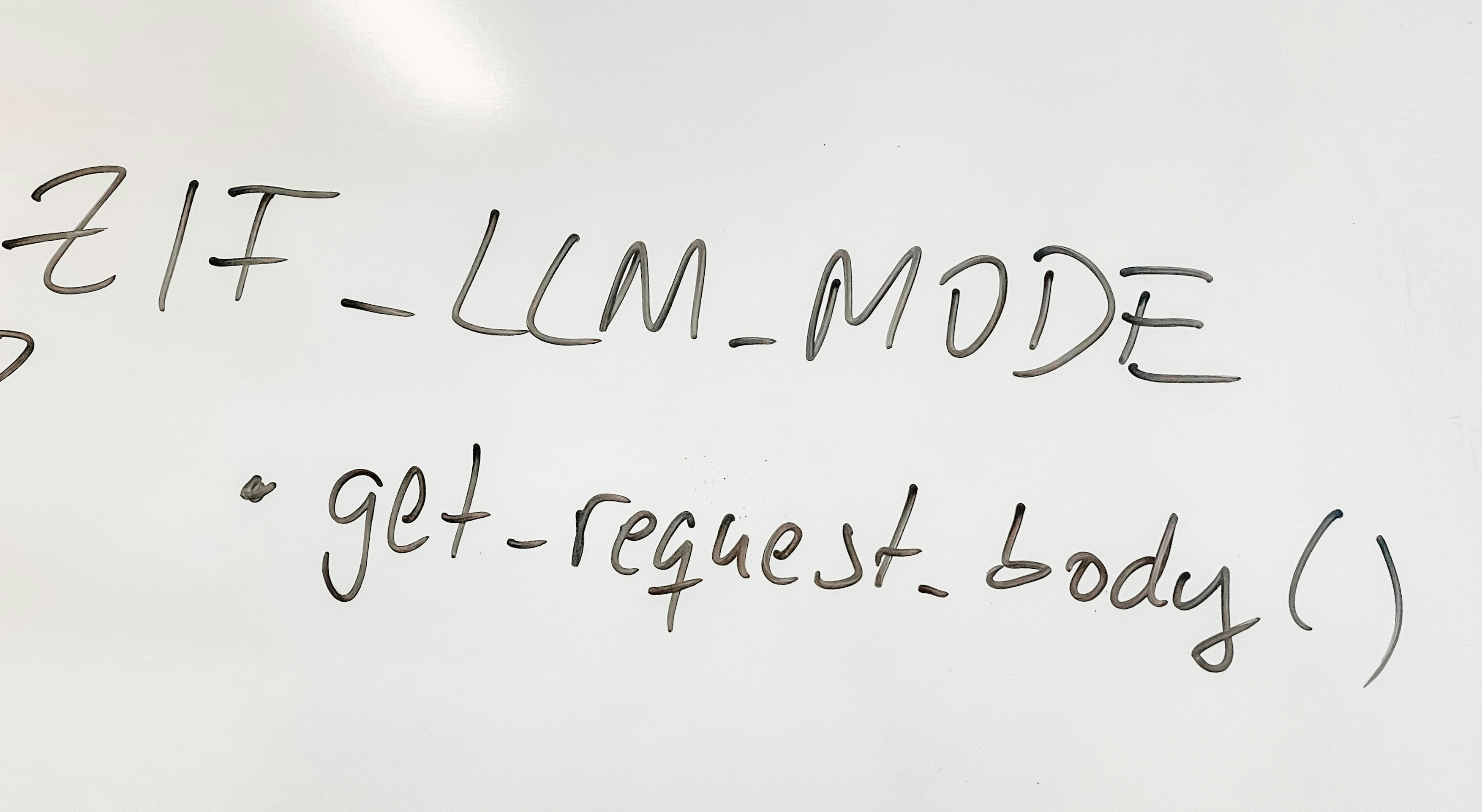

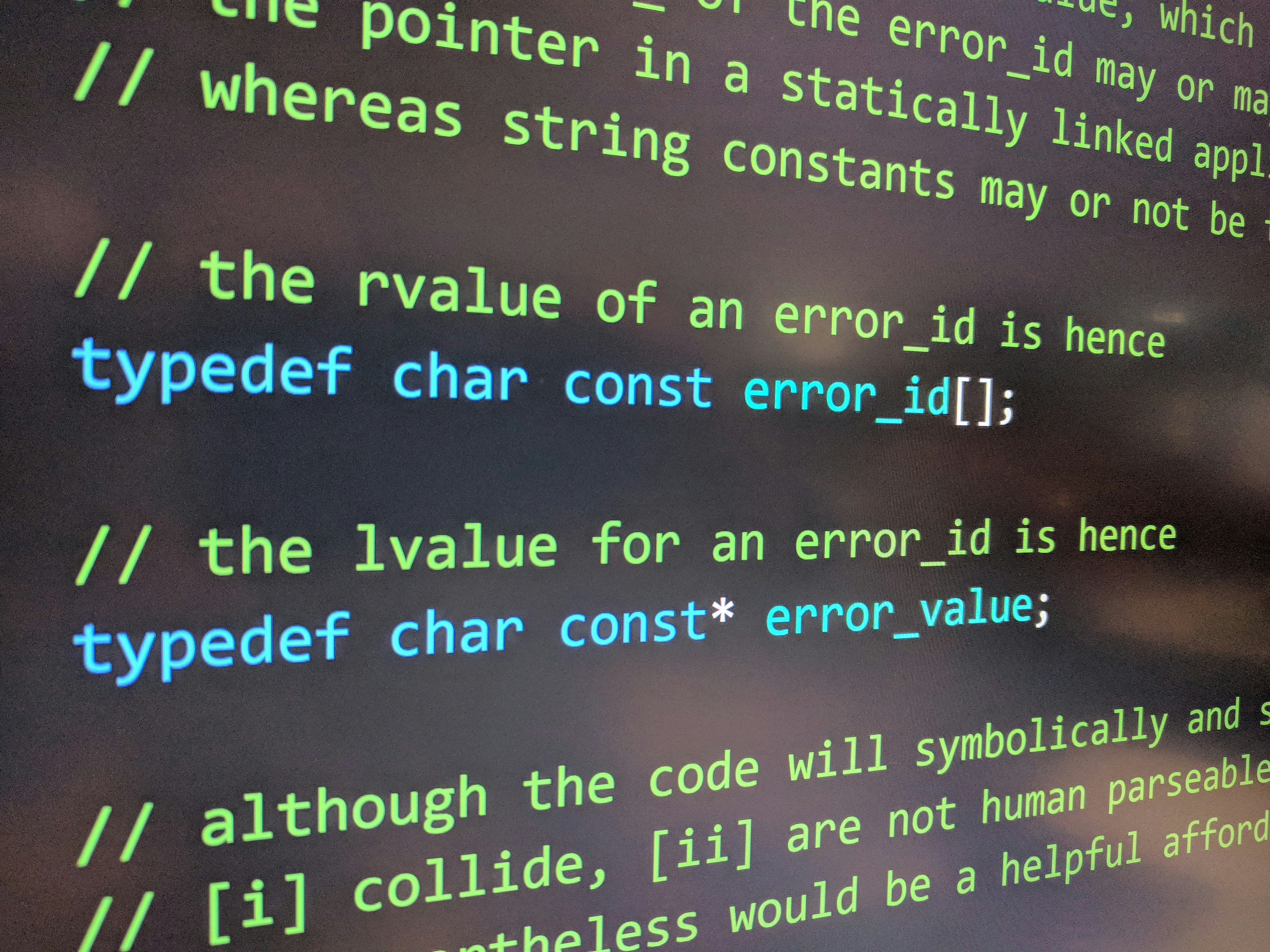

Requisitos de la solución: 1) disponer de un fichero estadístico persistente con las mediciones de cada archivo, incluyendo medianas; 2) registrar en un plugin de Cypress los tiempos reales tras cada ejecución y mantener actualizada la estadística en un archivo como .cypress_load_balancer/spec-map.json; 3) el balanceador recibirá la lista de archivos, el número de runners y accederá a la estadística para decidir la asignación; 4) si un archivo es nuevo y no tiene historiales, se asume una duración inicial razonable, por ejemplo cero o una estimación conservadora.

Algoritmo weighted-largest resumido: 1) obtener la mediana de tiempo para cada archivo y ordenar los archivos de mayor a menor duración; 2) inicializar X runners vacíos; 3) repartir inicialmente los X archivos de mayor duración uno por runner para garantizar que cada runner empiece con una carga representativa; 4) en cada iteración ordenar los runners por tiempo total de menor a mayor y añadir al runner más ligero el siguiente archivo más largo disponible, siempre comprobando contra el tiempo del runner actualmente más cargado; 5) si todos los runners quedan equilibrados y todavía quedan archivos, asignar uno por runner antes de volver a reordenar; 6) repetir hasta agotar la lista de archivos. En la práctica se utiliza la mediana de tiempos para mitigar outliers y variaciones entre ejecuciones.

Por qué mejora sobre round-robin: en ejemplos con nueve archivos con tiempos descendentes, round-robin produce grupos con sumas muy dispares, mientras que weighted-largest reduce la diferencia entre el runner más lento y el más rápido, disminuyendo el tiempo total de la suite. En distribuciones reales y con alta variabilidad el beneficio puede ser notable, por ejemplo mantener un archivo extremadamente largo en su propio runner y equilibrar el resto para que no supere ese tiempo máximo.

Ejemplos prácticos: en pruebas sintéticas con distintas distribuciones de tiempos el algoritmo weighted-largest suele reducir la diferencia entre el runner más cargado y el más liviano, y en varios casos reales mostró mejoras drásticas: en un conjunto de 130 tests de componentes distribuidos en 6 runners, la solución redujo el mayor tiempo de ejecución de más de 9 minutos a menos de 4 minutos por runner. En una colección de 45 end to end tests con mucha variabilidad y tiempos máximos por archivo superiores a 45 minutos, la estrategia permitió aislar el test más largo y equilibrar el resto con 16 runners, minimizando el impacto en el tiempo total.

Consideraciones de implementación: almacenar estadísticas fiables y actualizarlas tras cada ejecución es esencial. Usar la mediana ayuda frente a outliers y fallos puntuales. El algoritmo presentado es sencillo y legible; puede optimizarse para uso a gran escala reduciendo reordenamientos frecuentes y usando estructuras que mantengan los totales de cada runner de forma incremental. Además es importante integrar esto en pipelines CI para que las asignaciones se actualicen con datos frescos y reflejen cambios en la suite de pruebas.

Integración con servicios empresariales y beneficios para Q2BSTUDIO: en Q2BSTUDIO ayudamos a implantar soluciones de testing y automatización que se integran con infraestructuras cloud y procesos DevOps. Podemos adaptar este enfoque al desarrollo de aplicaciones a medida y pipelines de integración continua, aprovechando servicios cloud como AWS y Azure para escalar runners de manera elástica. Si desea explorar cómo aplicar estas optimizaciones a proyectos de software a medida visite nuestra página sobre desarrollo de aplicaciones a medida y descubra casos prácticos y servicios.

Además, nuestra experiencia en inteligencia artificial nos permite analizar grandes volúmenes de métricas de pruebas para generar modelos predictivos de duración de archivos y optimizar la asignación de cargas de forma automática. Ofrecemos soluciones de ia para empresas y agentes IA personalizados que pueden integrarse en su pipeline de testing, más información disponible en servicios de inteligencia artificial. Combinando IA, automatización y buenas prácticas de ciberseguridad y pentesting podemos garantizar que las mejoras en rendimiento no comprometan la calidad ni la seguridad de las aplicaciones.

Palabras clave y servicios: este enfoque encaja con soluciones de aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA y power bi. En particular, podemos conectar las métricas de ejecución con soluciones de Business Intelligence y Power BI para obtener paneles que muestren tendencias de tiempos, regresiones en pruebas y recomendaciones de optimización.

Conclusión: para procesos estáticos como cypress run, un algoritmo que priorice minimizar el tiempo total de ejecución y que haga uso de estadísticas históricas de cada archivo ofrece ventajas claras frente al round-robin. El algoritmo weighted-largest es una solución práctica y efectiva que, combinada con instrumentación de métricas y herramientas de IA, permite reducir tiempos de CI y mejorar la eficiencia del equipo. Si desea que Q2BSTUDIO le acompañe en la adopción de estas técnicas y su integración con servicios cloud, inteligencia artificial o auditorías de seguridad, nuestro equipo está preparado para diseñar e implantar la solución.

Comentarios