De FP16 a Q4: Comprendiendo la Cuantización en Ollama

De FP16 a Q4: Comprendiendo la Cuantización en Ollama

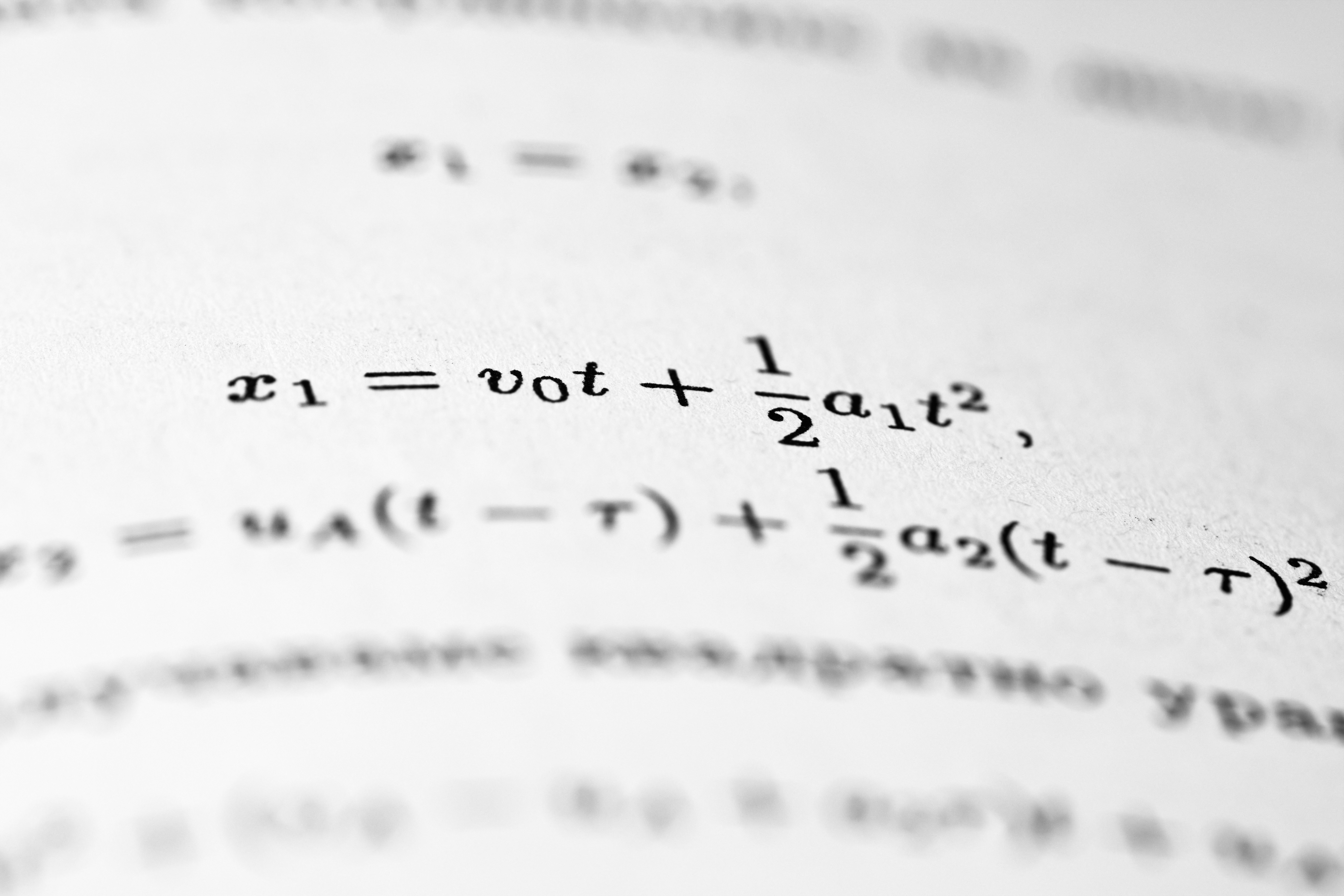

Si ejecutas modelos localmente, seguro has oído el término cuantización. ¿Qué es la cuantización? Un LLM normal almacena pesos como float32 FP32 y float16 FP16. La cuantización consiste en almacenar y calcular esos pesos usando menos bits para reducir tamaño y consumo de memoria.

Ejemplos comunes de representaciones por bits: FP16 16 bits, INT8 8 bits, INT4 4 bits, INT2 2 bits. Reducir bits implica aproximar valores; por ejemplo un número como 0.12345678 en 32 bits puede aproximarse a 0.12 en 8 o 4 bits, con pérdida de precisión pero ahorro significativo en espacio y velocidad.

Ollama y los formatos de cuantización. Cuando ves nombres de modelos como llama3:8b-q4_K_M o mistral:7b-q8_0, el sufijo indica el formato de cuantización. Comprender ese sufijo te ayuda a elegir el modelo según tus requerimientos de calidad, memoria y velocidad.

Formatos y significado resumido: Q2 aproximadamente 2 bits extremo en compresión y baja calidad, Q4_0 4 bits rápido con calidad inferior, Q4_K 4 bits optimizado por kernel, Q4_K_M 4 bits mejor equilibrio en Q4, Q5_K_M 5 bits mayor calidad y más uso de RAM, Q6_K 6 bits calidad cercana a FP16, Q8_0 8 bits muy alta calidad y FP16 16 bits prácticamente el original en precisión.

Toma de decisiones práctica: si necesitas ejecutar agentes IA en entornos con recursos limitados, un Q4_K_M suele ser buen compromiso entre velocidad y calidad. Para tareas criticas de precisión considera Q6_K o FP16 si la memoria lo permite. Para prototipos y pruebas rápidas Q4_0 o Q2 aceleran la inferencia a costa de resultados menos finos.

En Q2BSTUDIO combinamos experiencia en desarrollo de software a medida y aplicaciones a medida con soluciones de inteligencia artificial para empresas. Si buscas integrar modelos locales optimizados, podemos ayudarte a diseñar una arquitectura que use cuantización adecuada, agentes IA y pipelines eficientes para producción. Conoce nuestros servicios de inteligencia artificial en servicios de inteligencia artificial y aprovecha soluciones hechas a medida.

Además ofrecemos desarrollo de software a medida, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio y Power BI para transformar datos en decisiones. Si tu objetivo es construir una aplicación robusta que incorpore modelos locales y automatización, visita nuestra página de desarrollo de aplicaciones y software multiplataforma para explorar opciones.

Resumen final: la cuantización permite ejecutar LLMs con menos recursos, eligiendo formatos desde Q2 hasta FP16 según tus prioridades. Ejecutar modelos localmente abre posibilidades para privacidad, latencia baja y personalización, y en Q2BSTUDIO estamos listos para acompañarte con soluciones en inteligencia artificial, ciberseguridad, agentes IA, servicios cloud aws y azure, automatización y business intelligence con Power BI.

Comentarios