Domando las ventanas contextuales: deshabilitar la compactación automática para una mejor IA

¿Alguna vez estabas en una sesión intensa de programación con un asistente de IA y de repente viste el mensaje compacting o compactación automática y la calidad de las respuestas bajó drásticamente? Esto no es una sensación, es una limitación real de las herramientas de IA para código y entenderla marca la diferencia entre pelear con la herramienta y diseñar flujos de trabajo efectivos.

La compactación automática es un mecanismo de seguridad diseñado para evitar que el historial de la conversación supere la ventana de contexto. Cuando la conversación se acerca al límite, el sistema comprime mensajes antiguos en resúmenes y descarta detalles considerados menos relevantes. En teoría suena útil, pero en flujos de trabajo agentivos de programación resulta un asesino silencioso de calidad.

Cada vez que ocurre una compactación se pierde información concreta que suele ser crítica: nombres de variables se generalizan, mensajes de error detallados se convierten en frases vagas, decisiones arquitectónicas pierden matices y patrones de código establecidos se olvidan. El resultado es que las sesiones largas se degradan porque la IA literalmente olvida detalles técnicos precisos.

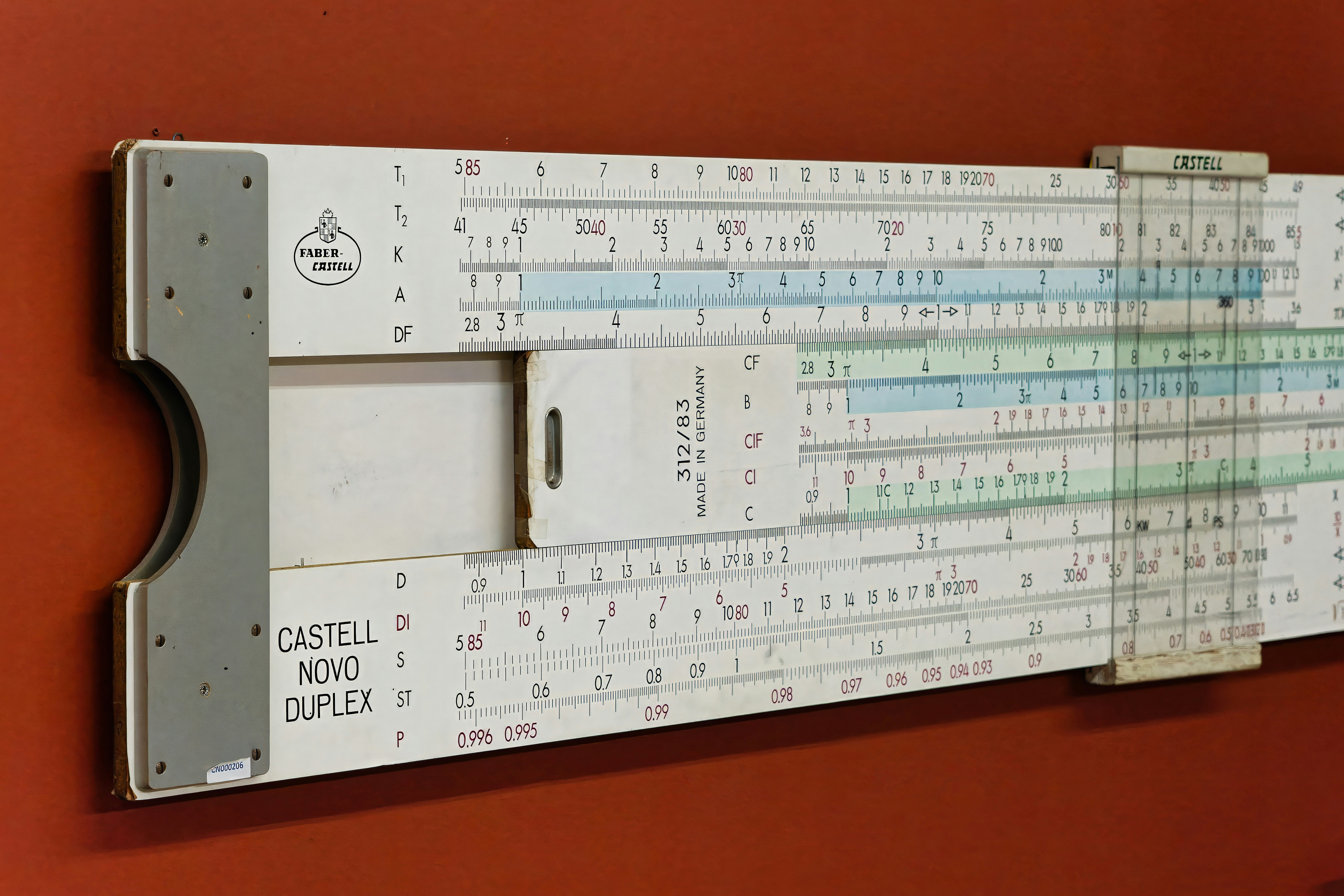

Un experimento sencillo ilustra el impacto. En Claude Code puedes ejecutar comandos como /prime para cargar contexto y /context para comprobar el uso de la ventana. En muchos casos la compactación automática consume un porcentaje significativo del contexto disponible antes de que empieces a codificar activamente. Ese coste oculto reduce la potencia de cada sesión.

La solución desde la ingeniería agentiva es cambiar el enfoque: dejar de intentar hacerlo todo en una única sesión y diseñar flujos de trabajo compuestos y basados en archivos. En lugar de mantener todo en el historial de chat, externaliza el estado en artefactos claros como plan.md, código, tests y documentación. Cada tarea se ejecuta en una sesión independiente que lee sus entradas desde archivos y escribe salidas a archivos, evitando la acumulación de ruido conversacional.

Un flujo de trabajo recomendado: primer sesión de planificación con /prime y /plan que produce plan.md, limpiar la sesión con /clear y ejecutar una sesión de implementación /implement que toma plan.md y produce cambios en code, luego una sesión de pruebas /test que genera resultados, y así sucesivamente. Cada sesión arranca con la máxima ventana de contexto disponible y nunca llega a compactar porque finaliza antes de alcanzar el límite.

Si vas a diseñar flujos independientes tiene sentido desactivar la compactación automática para recuperar esos tokens consumidos por el buffer. En Claude Code entra en la configuración y desactiva la opción Auto Compact para recuperar capacidad de contexto. Úsalo con disciplina: desactívalo cuando cada tarea tiene artefactos claros y puedes aceptar que la sesión termine al llenarse el contexto, y mantenlo activado en sesiones exploratorias largas donde necesitas continuidad indefinida.

El verdadero poder está en los artefactos de archivo. Un plan claro, código como fuente de verdad, resultados de pruebas y comentarios de revisión permiten que cada nueva sesión de IA lea solo lo que importa sin cargar todo el historial de conversaciones. Piensa en cada workflow como una función pura: entradas por archivos, salidas por archivos, sin depender del estado conversacional previo.

En Q2BSTUDIO aplicamos este enfoque en proyectos de software a medida y aplicaciones a medida para garantizar que las intervenciones de IA sean consistentes y reproducibles. Nuestro equipo combina experiencia en desarrollo de software, agentes IA y procesos de automatización para transformar planes en entregables concretos. Si necesitas soluciones que integren inteligencia artificial para empresas o agentes IA especializados, podemos ayudarte a diseñar pipelines que eviten la degradación por compactación.

Además, en Q2BSTUDIO cubrimos todo el espectro tecnológico: desde ciberseguridad y pentesting hasta servicios cloud aws y azure, pasando por servicios inteligencia de negocio y Power BI. Si tu proyecto requiere integración cloud o análisis avanzado, nuestros expertos implementan arquitecturas seguras y escalables que mantienen la coherencia del contexto relevante para la IA. Conéctate con nuestros equipos de software a medida y aplicaciones a medida o explora nuestras capacidades en inteligencia artificial para empresas para ver cómo podemos optimizar tus flujos.

Prácticas recomendadas rápidas para gestionar ventanas de contexto: usar /context con regularidad para monitorizar uso, estructurar una única tarea por sesión, empujar decisiones importantes a archivos plan.md, diseñar workflows que lean y escriban artefactos y pensar en sesiones de IA como funciones sin estado. Estas prácticas preservan la precisión técnica y evitan que la IA se vuelva más vaga con el tiempo.

La limitación de memoria es real: ventanas de contexto finitas e inevitable pérdida de información durante compactaciones. No podemos eliminar estas restricciones todavía, pero sí podemos diseñar alrededor de ellas. Los equipos que entienden las ventanas de contexto no pelean con sus herramientas; arquitectan flujos que maximizan cada token disponible.

Si quieres que evaluemos cómo aplicar estos principios a tu proyecto, desde automatización de procesos hasta soluciones de inteligencia de negocio con Power BI, en Q2BSTUDIO ofrecemos consultoría y ejecución completa. Podemos ayudarte a diseñar pipelines donde agentes IA actúen con contexto claro, integrando ciberseguridad, servicios cloud aws y azure y software a medida que garantice resultados reproducibles y seguros.

¿Te interesa optimizar tus sesiones de IA y evitar la pérdida de contexto? Contacta con Q2BSTUDIO y descubre cómo convertir limitaciones técnicas en ventajas competitivas mediante workflows compuestos, artefactos persistentes y una arquitectura pensada para agentes IA, inteligencia artificial, ciberseguridad y análisis con power bi.

Comentarios