Estándares de diseño de almacenes de datos: capas, tipos y ciclo de vida

Descubre los principios fundamentales de la arquitectura del modelo de datos tal como se presenta en el Handbook of Emerging Data Lake and Warehouse Design and Practice 2025, adaptados a las necesidades prácticas de las empresas modernas.

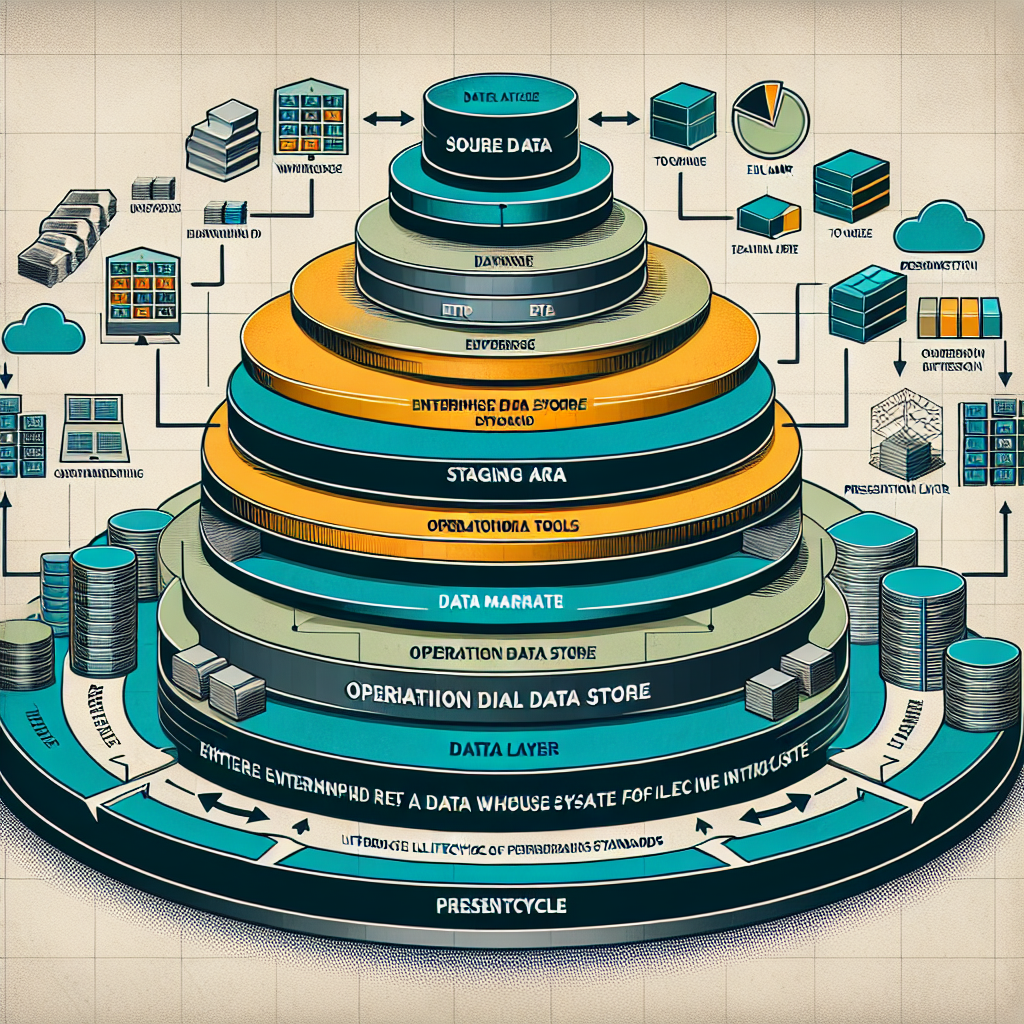

Estándares de diseño de almacenes de datos: capas, tipos y ciclo de vida es una guía para estructurar soluciones robustas y escalables. Un diseño estándar suele contemplar capas claras: ingesta, almacenamiento, procesamiento, gobernanza y consumo. En la capa de ingesta se definen formatos, frecuencias y garantías de entrega. En almacenamiento se decide entre data lake, data warehouse o lakehouse según los requisitos de latencia y calidad. La capa de procesamiento aborda ETL/ELT, transformaciones y enriquecimiento con reglas de negocio. Finalmente, la capa de consumo entrega datasets optimizados para BI, ML y aplicaciones a medida.

Tipos de almacenes de datos: data lake para grandes volúmenes en bruto, data warehouse empresarial para modelos tabulares y analíticos, data marts para dominios específicos y operational data stores para procesos en tiempo real. Las arquitecturas modernas tienden a combinar estas aproximaciones en soluciones híbridas que permiten análisis exploratorio sin perder gobernanza.

El ciclo de vida de un almacén de datos incluye fases de descubrimiento y requisitos, modelado lógico y físico, implementación de pipelines de datos, pruebas de calidad, despliegue y monitoreo, además de políticas de retención y archivado. La trazabilidad del dato y la metadata son esenciales para cumplir normativas y facilitar auditorías.

Estándares y buenas prácticas recomendadas: aplicar modelos dimensionales cuando sea pertinente, usar catálogos de datos y linaje, automatizar pruebas de calidad, versionar esquemas, cifrar datos en tránsito y reposo, configurar controles de acceso basados en roles y documentar SLA de ingestión y frescura. También es clave integrar alertas y dashboards que midan la salud de los pipelines y la calidad de los datos.

Q2BSTUDIO acompaña a las organizaciones en todo este recorrido. Como empresa de desarrollo de software y aplicaciones a medida ofrecemos soluciones personalizadas que incluyen integración con plataformas cloud, despliegue de pipelines, desarrollo de software a medida y creación de agentes IA para automatizar tareas repetitivas. Nuestra experiencia en inteligencia artificial y servicios inteligencia de negocio permite convertir datos en decisiones accionables.

Para desplegar infraestructuras escalables y seguras trabajamos con proveedores líderes. Podemos diseñar arquitecturas en la nube y migraciones a plataformas empresariales mediante servicios cloud aws y azure que optimizan costos, disponibilidad y rendimiento. Además implementamos soluciones completas de inteligencia de negocio y visualización con power bi y servicios inteligencia de negocio para que los stakeholders obtengan insight inmediato y confiable.

La ciberseguridad es un pilar en cualquier diseño de datos: políticas de acceso, auditoría, pruebas de penetración y monitorización continua protegen la integridad y confidencialidad. En Q2BSTUDIO ofrecemos servicios de ciberseguridad y pentesting integrados en los proyectos para garantizar cumplimiento y resiliencia.

Finalmente, adoptar estándares en la arquitectura de datos facilita la escalabilidad, reduce riesgos y mejora el time to value. Si buscas un partner que combine software a medida, inteligencia artificial para empresas, agentes IA, power bi, y seguridad, Q2BSTUDIO ofrece capacidades técnicas y metodologías ágiles para llevar tu almacén de datos desde el diseño a la producción con garantías de calidad y rendimiento.

Comentarios