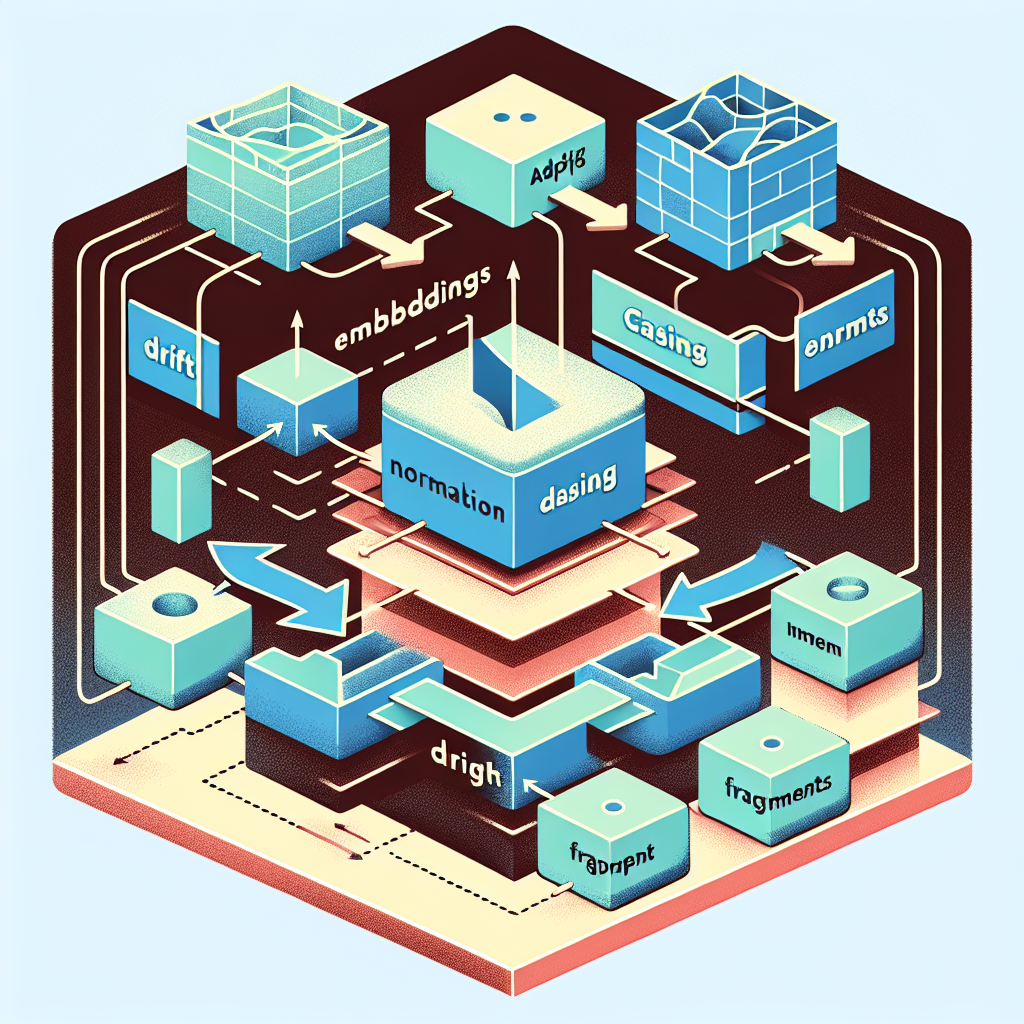

Drift en Embeddings: Normalización, Casing y Fragmentos

Drift en embeddings: Normalización, casing y fragmentos explicado de forma práctica para equipos que desarrollan búsqueda semántica y recuperación vectorial

Si has trabajado con búsqueda vectorial o retrieval semántico probablemente te hayas encontrado con este problema habitual: los embeddings parecen correctos, el índice se construye sin errores, pero las búsquedas devuelven resultados vacíos o irrelevantes. No es que FAISS, pgvector o Milvus estén rotos. El fallo suele venir de desajustes silenciosos en la canalización de generación y consulta de vectores.

Modos de fallo comunes: normalización mixta donde conviven vectores crudos y normalizados en el mismo almacén; drift de casing cuando texto en mayúsculas y minúsculas produce embeddings distintos; desajuste de tokenizador entre ingestión y consulta; fragmentos solapados mal alineados por errores off by one; y cambios silenciosos de dimensión de embedding tras actualizar un modelo, por ejemplo de 1536 a 3072, sin reconstruir el índice.

Qué es lo que realmente se rompe: no son bugs aislados sino contratos que se rompen entre componentes. Retrieval asume vectores normalizados pero la ingestión no lo hace. Las consultas se lowercasean y los vectores almacenados no. Las librerías de tokenización cambian entre versiones. La lógica de stride y ventana difiere entre pipelines y aparecen huecos o duplicados. Un nuevo modelo duplica la dimensión y el esquema de índice queda obsoleto. El resultado es que la matemática de similitud colapsa y la similitud coseno y el recall se degradan sin avisar.

Controles mínimos para estabilizar una canalización de embeddings: normalizar siempre aplicando L2 tanto en ingestión como en consulta; fijar una política de casing y aplicarla de forma consistente a ambos lados; bloquear la versión del tokenizador y verificar checksum en tiempo de ejecución; asegurar un contrato de fragmentación con stride y window idénticos en ingestión y consulta; validar la dimensión de embeddings contra el esquema del índice y fallar rápido si hay discrepancia.

Objetivos de aceptación recomendados: deriva de similitud coseno entre crudo y normalizado menor o igual a 0.02; tasa de fragmentos duplicados o perdidos 1% en el corpus; drift de checksum de tokenizador igual a 0 entre entornos; detección de mismatch de dimensión 100% antes de construir el índice.

Checklist rápida de implementación: 1) Establecer normalización L2 como contrato obligatorio. 2) Definir y documentar política de casing. 3) Pinchar versiones de tokenizador y modelo y comprobar sumas. 4) Automatizar comprobaciones de stride y ventana. 5) Validar dimensión de embedding antes de cualquier ingesta masiva o rebuild.

Cómo usar la referencia Global Fix Map: abre el Global Fix Map README y ve a la sección Embeddings Pipeline. Aplica la checklist mínima y valida contra los objetivos de aceptación descritos arriba. Estas acciones reducen drásticamente los riesgos operativos al desplegar soluciones de recuperación semántica en producción.

En Q2BSTUDIO entendemos estos retos técnicos y ofrecemos servicios integrales para implementar soluciones robustas de embeddings y búsqueda semántica dentro de proyectos de software a medida. Somos una empresa de desarrollo de software y aplicaciones a medida, especialistas en inteligencia artificial, ciberseguridad y servicios cloud AWS y Azure, capaces de diseñar tanto la arquitectura de datos como los controles necesarios para evitar drift en producción.

Si tu proyecto necesita integración de IA empresarial, agentes IA o diseño de pipelines de embeddings con garantías operativas podemos ayudar. Conectamos la ingeniería de modelos con prácticas de devops y seguridad para que tus índices vectoriales permanezcan consistentes y recuperables. Conoce nuestras propuestas de inteligencia artificial e IA para empresas y cómo aplicamos estos principios en desarrollos reales.

Además podemos acompañarte en servicios complementarios como ciberseguridad y pentesting para proteger los pipelines de datos, servicios de inteligencia de negocio y visualización con Power BI, así como migraciones y despliegues en la nube. Si buscas construir experiencia conversacional o motores de búsqueda semántica dentro de una plataforma de desarrollo de aplicaciones a medida nuestras soluciones integradas cubren desde el prototipo hasta la operación segura en AWS o Azure.

Prácticas finales: instrumenta métricas de similitud y cobertura, automatiza tests de fragmentación y dimensionado, y documenta el contrato de ingestión y consulta. Estos pasos evitan que pipelines aparentemente 'verdes' fallen en producción por desalineamientos invisibles.

Próximo tema relacionado: orquestación multiagente y por qué los agentes pueden bloquearse, sobrescribir memorias o entrar en bucles infinitos si no se definen contratos de memoria y acceso compartido.

Palabras clave integradas: aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA, power bi.

Comentarios