Búsqueda de palabras clave vs. búsqueda semántica con IA

Al construir funcionalidades de búsqueda para una aplicación normalmente se presentan dos enfoques generales: búsqueda tradicional por palabras clave que empareja términos de forma literal o con pequeñas variantes, y búsqueda semántica o por vectores que empata significado y contexto mediante embeddings de IA. También existe un enfoque híbrido que combina lo mejor de ambos, pero lo dejaré para otro artículo.

En este artículo explico cómo funcionan ambos enfoques usando Python, MariaDB y un modelo de embeddings, y señalo sus diferencias y casos de uso. Para el ejemplo practiqué con MariaDB Cloud y en pocos minutos tuve una instancia serverless gratuita. Creé una base de datos demo, una tabla products y cargué alrededor de 500 nombres de productos con LOAD DATA LOCAL INFILE. Es un dataset muy pequeño pero suficiente para experimentar. Después preparé una pequeña aplicación en Python con FastAPI donde primero implementé una búsqueda por palabras clave usando índice full text y luego una búsqueda semántica usando embeddings de IA y el soporte vectorial de MariaDB.

Resumen del flujo técnico: ingesté los nombres de producto, calculé embeddings con un modelo de IA y almacené esos vectores en MariaDB mediante la integración de LangChain. En tiempo de consulta también calculo el embedding de la frase del usuario con el mismo modelo y realizo una búsqueda de similitud con el algoritmo HNSW para recuperar los k vecinos más cercanos y devolver los productos relacionados. La integración de LangChain con MariaDB facilita la creación de las tablas necesarias para almacenar colecciones y embeddings y reduce la complejidad de gestión del almacenamiento vectorial.

Búsqueda por palabras clave: simple y rápida. Con un índice full text en la columna name se puede consultar directamente desde SQL y obtener resultados veloces cuando el usuario escribe términos exactos o muy similares. Ventajas: rápido, sencillo y sin dependencia de modelos externos. Desventajas: no detecta sinónimos ni intención, y depende mucho del vocabulario exacto. En mi demo una consulta por running shoes devolvía varios productos no relevantes al intento de búsqueda.

Búsqueda semántica: empata significado. Al convertir nombres y consultas a vectores con un modelo de embeddings, la búsqueda recupera elementos contextual y semánticamente cercanos aunque no compartan las mismas palabras. En el ejemplo la misma consulta por running shoes devolvió productos que no contenían literalmente running ni shoes pero sí eran relevantes por proximidad semántica. Requiere integrar un modelo de embeddings y soporte para almacenamiento e índice vectorial, pero aporta flexibilidad para manejar sinónimos, intención y variación en lenguaje natural.

Comparativa rápida: la búsqueda por palabras clave es ideal cuando el dominio es pequeño o se necesitan coincidencias exactas y se quieren dependencias mínimas. La búsqueda semántica es recomendable cuando hay variación lingüística, necesidad de entender intención o manejar sinónimos. En muchas aplicaciones reales conviene un enfoque híbrido: intentar primero coincidencia exacta y cuando falle aplicar búsqueda semántica o combinar ambos resultados para mejorar relevancia.

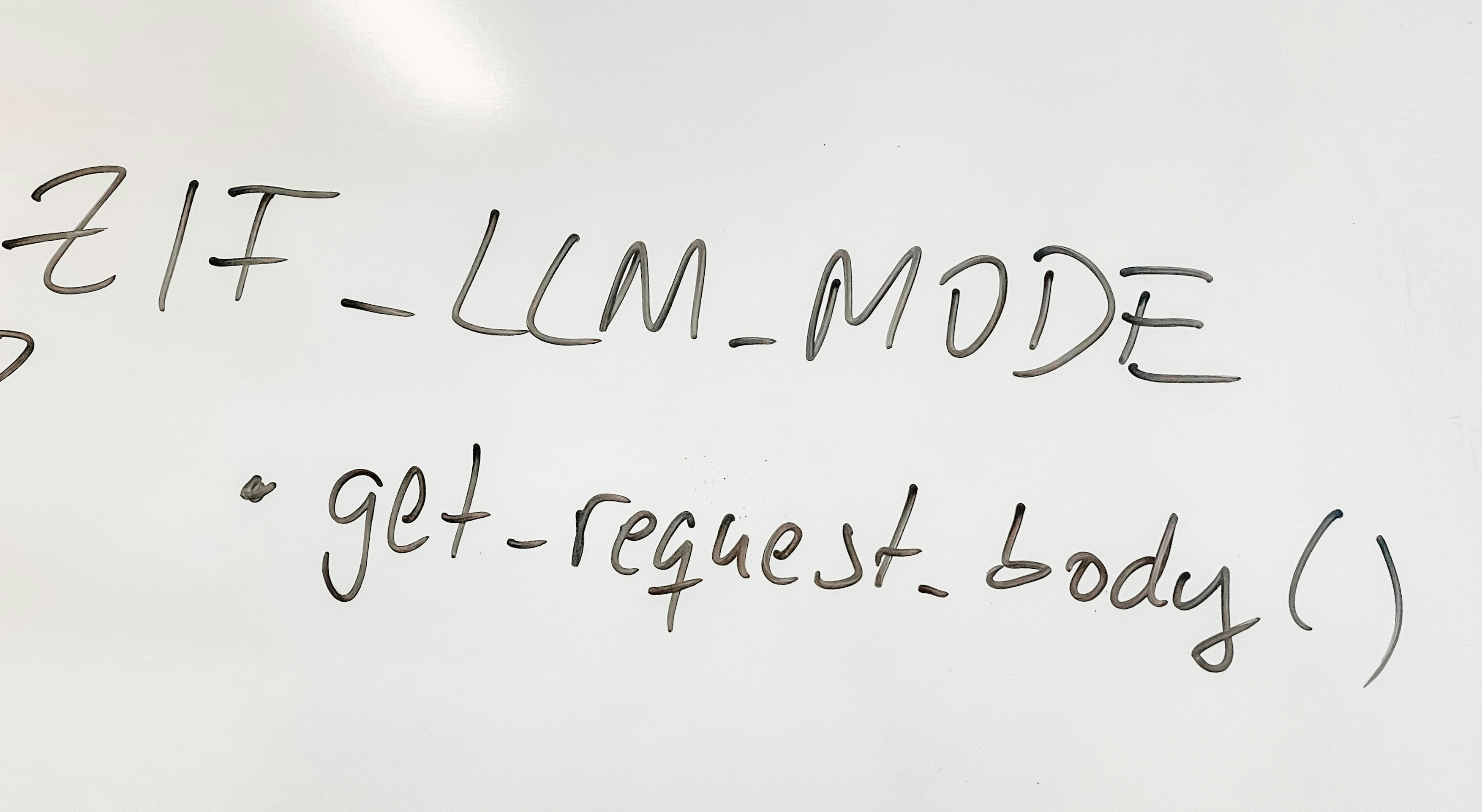

Cómo lo hice en Python: usé FastAPI para exponer endpoints que leen y devuelven resultados. Un endpoint ingest copia los nombres, calcula embeddings y los guarda en MariaDB. Otro endpoint realiza la búsqueda semántica consultando el vector store de LangChain. La mayor parte del trabajo pesado lo gestiona la integración entre LangChain y MariaDB, que crea colecciones y tablas de embeddings y permite consultas de similitud con alto rendimiento.

Pros y contras resumidos: la búsqueda por palabras clave es eficiente y directa, sin IA, pero limitada a coincidencias literales. La búsqueda semántica mejora la calidad al reconocer relaciones de significado, pero añade coste de cómputo y dependencia del modelo de embeddings y del almacenamiento vectorial. Para muchas soluciones productivas conviene combinar ambas estrategias.

En Q2BSTUDIO somos especialistas en desarrollar soluciones que integran estas técnicas según las necesidades del cliente. Ofrecemos desarrollo de aplicaciones a medida y software a medida pensando en escenarios que requieren búsquedas precisas o búsquedas semánticas con IA. Si tu proyecto necesita una arquitectura cloud escalable podemos desplegarla en plataformas líderes como AWS y Azure y gestionar servicios cloud aws y azure para optimizar rendimiento y costes. Además incorporamos prácticas de ciberseguridad y pentesting para proteger tus datos y aplicaciones y ofrecemos servicios de inteligencia de negocio y Power BI para transformar resultados en decisiones accionables.

Si te interesa llevar la búsqueda de tu producto o catálogo al siguiente nivel podemos ayudarte a diseñar la solución adecuada, ya sea mediante una estrategia de búsqueda por palabras clave, una implementación basada en embeddings para búsqueda semántica o un enfoque híbrido. Con experiencia en ia para empresas y agentes IA desarrollamos integraciones personalizadas que combinan backend en Python, bases de datos como MariaDB y modelos de IA. Conecta con nuestro equipo para soluciones de software a medida y aplicaciones a medida o para explorar nuestras capacidades en inteligencia artificial para empresas. También brindamos soporte en automatización de procesos, servicios inteligencia de negocio, agentes IA y dashboards con power bi para mejorar la experiencia y la toma de decisiones.

Palabras clave relevantes para SEO incluidas de forma natural en este texto: aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA, power bi. Si quieres un prototipo, una implementación productiva o una auditoría de seguridad para tu motor de búsqueda, en Q2BSTUDIO ofrecemos consultoría, desarrollo y mantenimiento a medida para llevar tu proyecto desde la idea hasta la producción.

Comentarios