Cómo hice un servidor MCP que me ahorra una hora por semana

Últimamente he viajado por el país impartiendo talleres sobre cómo crear MCP Servers y agentes IA sin servidor en Cloud Run, y en cada sesión surge la misma pregunta: cómo aplicar lo aprendido a casos reales. En este artículo explico cómo transformé un sencillo script de Python en un servidor MCP que me ahorra tiempo real en la publicación de episodios del podcast, y cómo esta idea puede adaptarse para empresas que necesitan soluciones de aplicaciones a medida y automatización con inteligencia artificial.

Como coanfitrión del Kubernetes Podcast desde Google, disfruto mucho las conversaciones y aprender sobre nuevas tecnologías, pero publicar cada episodio implica muchas tareas manuales: escuchar el audio, redactar show notes, subir el audio y llenar metadatos, actualizar el sitio y promover el episodio en redes sociales. El paso de crear show notes y redactar textos para redes es uno de los más laboriosos, y ahí apareció la oportunidad perfecta para aplicar la IA.

Mi primer experimento fue un script de Python que hacía tres cosas: convertir audio a transcripción usando un modelo de IA, generar un borrador de show notes en markdown y preparar publicaciones para redes sociales. Con ese script ahorré entre 1,5 y 2 horas por episodio porque no tenía que pausar continuamente para tomar notas; la IA me daba un primer borrador que luego reviso y edito. Esa mejora me motivó a compartir la solución con mis coanfitriones, pero había un problema: solo yo lo usaba porque no estaba integrado en su flujo de trabajo.

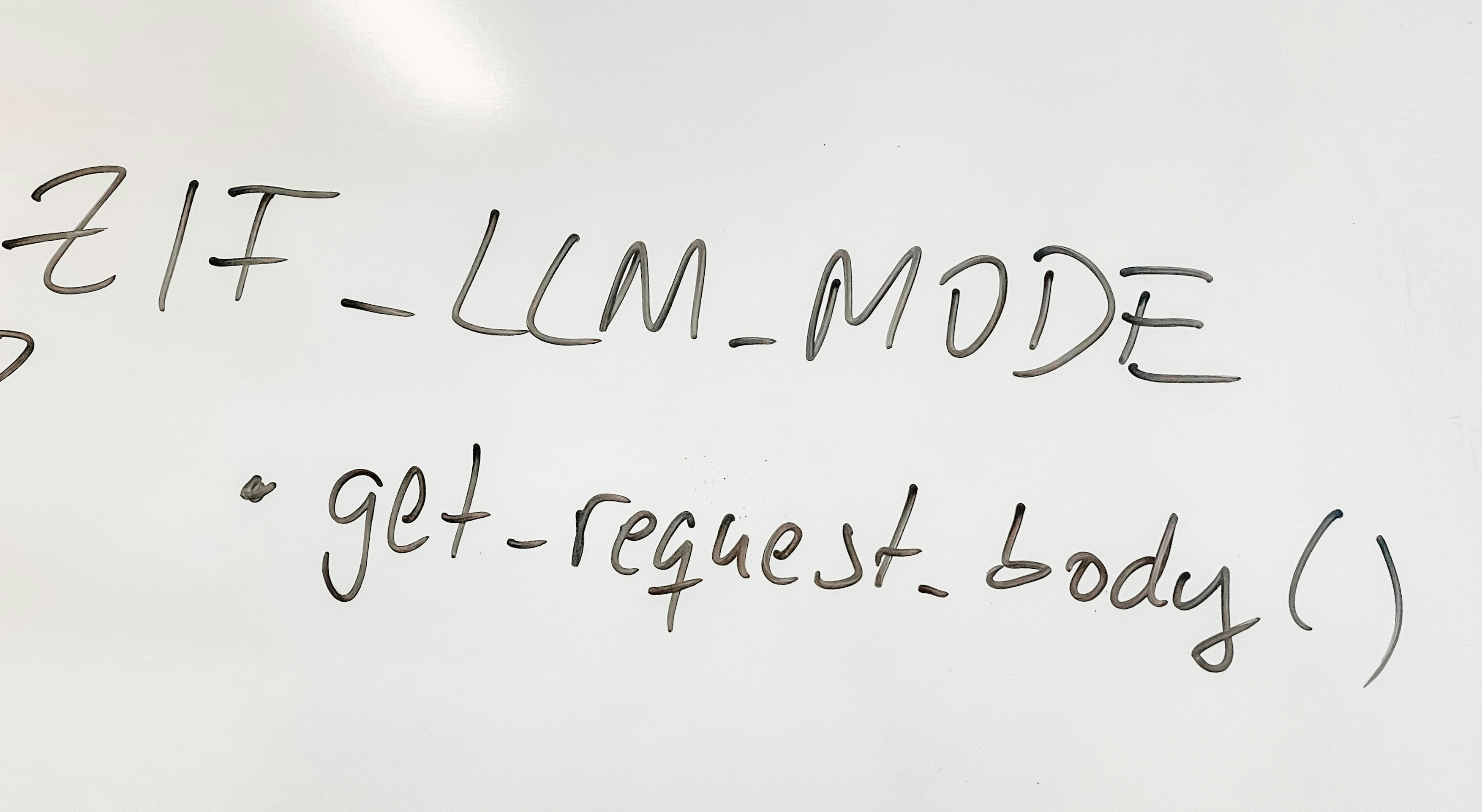

Para que mi equipo aprovechara la automatización decidí transformar el script local en un servidor MCP compartible. Planteé inicialmente una app web compleja, pero prioricé la simplicidad y la adopción rápida. La solución que funcionó fue crear un MCP server, una arquitectura ligera que se integra con herramientas de línea de comandos como la Gemini CLI y permite añadir nuevas funciones de forma incremental. Así nació podcast-assistant-mcp, construido con FastMCP y las librerías de GenAI, empaquetado en Docker y desplegado en Cloud Run.

El diseño tiene varias ventajas importantes: interfaz mínima expuesta al usuario, independencia entre herramientas internas (transcripción, shownotes, blog, redes), y extensibilidad para añadir por ejemplo publicar directamente en plataformas o generar un post para el sitio. Además, al desplegarlo en Cloud Run con autenticación, el servidor es accesible para mis compañeros sin abrirlo al público general.

Cómo funciona la herramienta: el servidor ofrece herramientas independientes que pueden ejecutarse por separado o en secuencia. La primera herramienta recibe un archivo de audio en Google Cloud Storage y genera una transcripción con etiquetas de hablante y timestamps, guardando el resultado en un bucket. La segunda toma esa transcripción y genera show notes en markdown ajustadas al estilo del podcast. La tercera crea un artículo tipo blog en markdown, pensado como borrador para cuando se implemente un blog en el sitio. La cuarta genera borradores de publicaciones para X y LinkedIn con el tono y límite de caracteres adecuados. Todos los resultados se guardan en GCS para revisión y descarga.

Tecnologías clave y decisiones de diseño: utilicé FastMCP para estructurar el servidor, google-genai para interactuar con modelos Gemini en Vertex AI y google-cloud-storage para persistencia en buckets. En pruebas iniciales tuve problemas de timeout con versiones más pesadas del modelo, así que opté por Gemini 2.5 Flash por su rapidez y fiabilidad en operaciones que implican generación y guardado en bucket dentro de los límites de tiempo del cliente. Otra decisión importante fue implementar herramientas completas en lugar de solo prompts, porque necesitaba control explícito sobre el guardado del texto en el bucket y la devolución de URIs para los siguientes pasos del flujo.

La seguridad se resolvió exigiendo autenticación en Cloud Run, evitando exponer el servidor a uso público no autorizado. Para facilitar el acceso con la Gemini CLI describí varias opciones de autenticación: uso de token temporal, proxy que maneja autenticación y reenvío, o el uso de cuentas de servicio para escenarios de integración más avanzados. Para mi equipo, las opciones rápidas y el proxy fueron las más cómodas, y la elección puede cambiar a medida que evolucionen las necesidades.

Este enfoque es un ejemplo práctico de cómo la inteligencia artificial y arquitecturas serverless pueden acelerar tareas de contenido y publicación. En Q2BSTUDIO, empresa dedicada al desarrollo de software a medida, aplicaciones a medida y especialistas en inteligencia artificial y ciberseguridad, vemos frecuentemente cómo soluciones similares transforman procesos internos y elevan la productividad. Si tu organización necesita integrar agentes IA, automatización de procesos o construir un servicio que combine generación de contenido con pipelines de publicación, podemos ayudar a diseñar e implementar una solución escalable y segura.

Además de la automatización con IA, en Q2BSTUDIO ofrecemos experiencia en servicios cloud AWS y Azure, integración de inteligencia de negocio y desarrollos con Power BI para generar informes accionables. Si buscas construir un producto propio o modernizar flujos existentes, nuestras capacidades en software a medida y en Inteligencia artificial para empresas permiten crear agentes IA, pipelines serverless y soluciones de automatización que encajan con tus objetivos de negocio.

Resumen y próximos pasos: el MCP server me permitió compartir la automatización con mi equipo y ahorrar colectivamente tiempo valioso, además de ofrecer una base extensible para añadir funcionalidades como publicación directa, evaluaciones de calidad automáticas o integración con plataformas de CMS. Si quieres replicar este patrón, considera tres puntos clave: elegir el modelo de IA adecuado a tus límites de latencia, diseñar herramientas que persistan resultados en almacenamiento accesible, y proteger el servicio con autenticación. Para proyectos a medida que impliquen agentes IA, ciberseguridad, servicios cloud aws y azure o implementación de soluciones de inteligencia de negocio y power bi, en Q2BSTUDIO estamos listos para acompañarte desde el diseño hasta la puesta en producción.

Palabras clave aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA, power bi

Comentarios