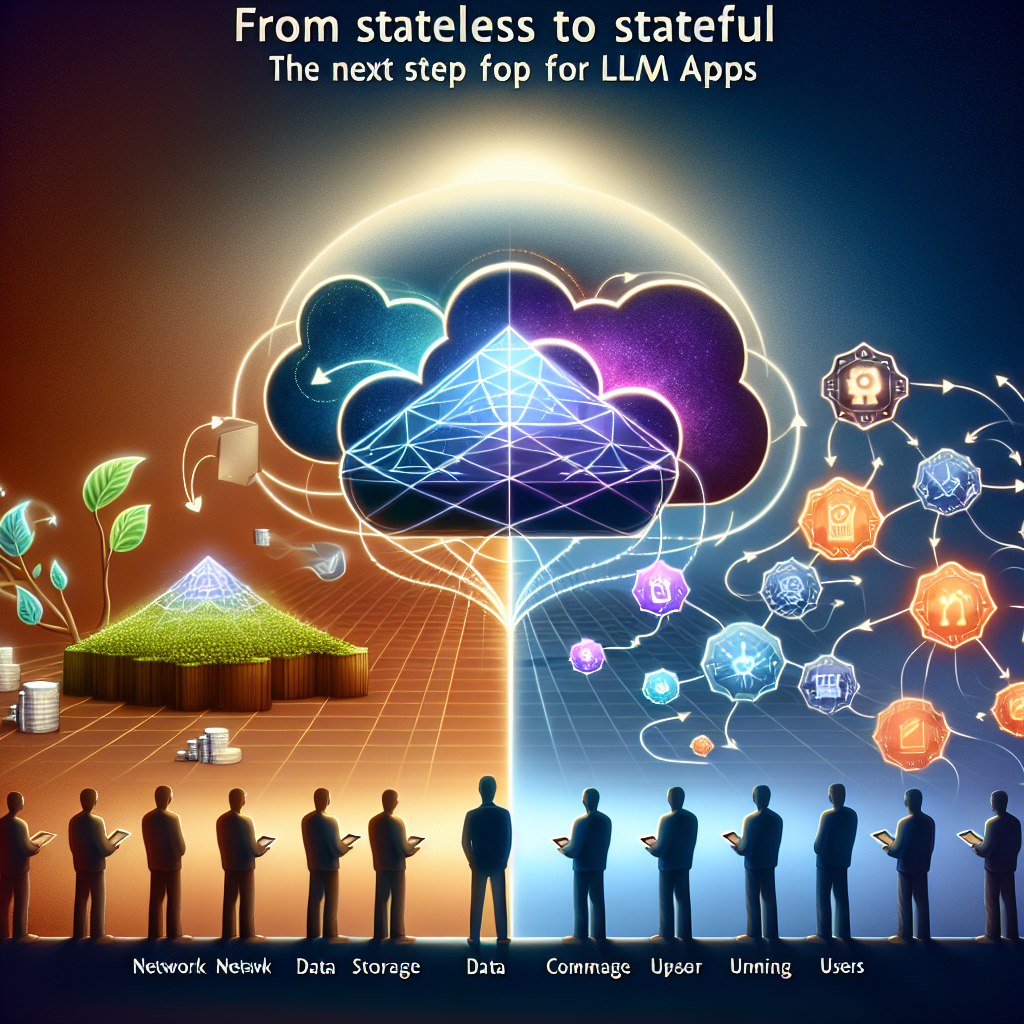

De Sin Estado a Con Estado: El Siguiente Paso para Apps con LLM

De Sin Estado a Con Estado: El Siguiente Paso para Apps con LLM

La llegada de los grandes modelos de lenguaje ha revolucionado la forma en que interactuamos con sistemas digitales. Sin embargo, la mayoría de las aplicaciones actuales basadas en LLM funcionan de forma sin estado, es decir no conservan memoria ni contexto entre interacciones. El tránsito hacia aplicaciones con estado no es solo beneficioso sino inevitable para crear soluciones de inteligencia artificial contextuales, adaptativas y personalizadas que aporten verdadero valor a empresas y usuarios.

¿Qué significa una app sin estado? En el modelo sin estado cada petición al LLM se trata como una solicitud aislada. No existe memoria de interacciones previas y cada respuesta se genera desde cero con base en la entrada actual. Esto provoca limitaciones claras: falta de continuidad en conversaciones, instrucciones repetitivas, escasa personalización y mayor consumo de recursos por tener que reintroducir contexto constantemente. Para tareas largas o sistemas que requieren seguimiento, las arquitecturas sin estado se quedan cortas.

Por qué las aplicaciones con estado son el futuro Las aplicaciones con estado retienen conocimiento de interacciones previas, habilitan memoria persistente, razonamiento contextual y experiencias personalizadas. Imitan la comunicación humana al construir sobre conversaciones pasadas y entendimientos compartidos. Entre sus ventajas destacan la mejora de la contextualidad para diálogos multi-turno, la personalización al recordar preferencias y tono, la continuidad en tareas como asistentes de desarrollo o tutores y la reducción de la carga cognitiva al evitar que el usuario repita contexto.

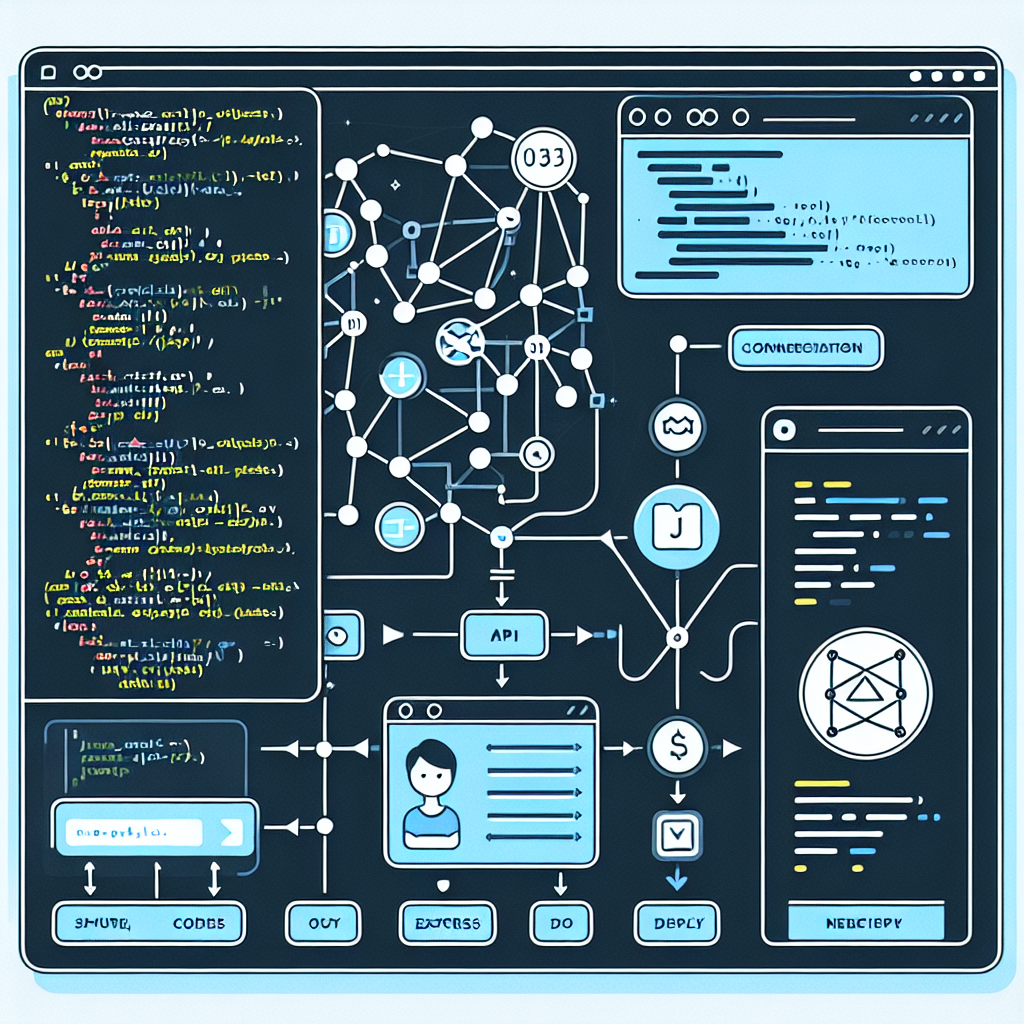

Componentes clave de arquitecturas con estado Diseñar una aplicación con estado exige orquestar memoria, almacenamiento, gestión de sesiones y sistemas de recuperación de información. Componentes esenciales:

1. Capa de memoria persistente Permite recordar perfiles de usuario, historial de conversaciones y hechos relevantes. Puede implementarse con bases de datos vectoriales, almacenes clave-valor embebidos o bases de conocimiento externas.

2. Gestión de la ventana de contexto Aunque los LLM actuales soportan ventanas de contexto grandes, las aplicaciones reales suelen superarlas. Estrategias habituales incluyen la summarización y fragmentación de historiales, búsquedas semánticas para recuperar solo lo relevante y ventanas deslizantes que priorizan interacciones recientes.

3. Gestión de sesiones y seguimiento de usuario Asignar identificadores únicos de sesión, almacenar logs de interacción por sesión y rastrear objetivos evolutivos permite sistemas orientados a metas y la construcción de memorias a largo plazo.

4. Optimización del modelo para cargas con estado Más allá de la arquitectura de memoria, el propio modelo puede optimizarse: ingeniería de prompts que incorpore memoria recuperada, y fine tuning para adaptar más profundamente el modelo a un dominio o estilo, reduciendo dependencia del contexto externo. El fine tuning implica coste y complejidad por lo que hay que balancearlo con la flexibilidad de un modelo general soportado por una robusta capa de memoria.

Casos de uso que impulsan la adopción Agentes persistentes como asistentes inteligentes, tutores personalizados y terapeutas virtuales que recuerdan progreso y estado emocional; colaboradores persistentes en desarrollo de software que recuerdan decisiones de diseño y objetivos de proyecto; generación de contenidos personalizada para marketing y comunicación con memoria del tono y la voz de marca; automatización de workflows empresariales en sectores complejos como legal, finanzas y recursos humanos donde el contexto organizacional y decisiones previas son críticos.

Retos en la implementación Persistir datos de usuarios plantea riesgos de privacidad y seguridad por lo que es imprescindible cumplir GDPR, cifrado y modelos de memoria basados en consentimiento. Mantener demasiada historia genera latencias y recalls irrelevantes, por lo que hay que encontrar equilibrio entre granularidad y rendimiento. Arquitecturas con estado incrementan la complejidad del backend al sumar stores vectoriales, bases de datos e identidad, elevando el coste de ingeniería. Además persisten limitaciones del modelo como el desvanecimiento de contexto, las alucinaciones y la desalineación de memoria que requieren monitorización continua.

Buenas prácticas Empezar con memoria episódica para gestionar historiales a corto plazo antes de escalar a memorias de largo plazo, usar modelos híbridos que combinen preferencias estáticas con datos dinámicos de sesión, definir con claridad el alcance de la memoria señalando qué se recuerda y por cuánto tiempo, ofrecer transparencia al usuario para ver editar o borrar información almacenada y monitorizar la deriva para asegurar que la memoria mejore en lugar de degradar la experiencia.

Hacia agentes con memoria a largo plazo El futuro de los agentes IA apunta a aprendizaje de por vida y memoria persistente. Veremos sistemas neurosimbólicos que combinan lógica y redes neuronales, aprendizaje por refuerzo con memoria para tomar decisiones más inteligentes, y sistemas de memoria autorreparables capaces de olvidar información obsoleta o dañina. La colaboración multiagente con memorias compartidas abrirá nuevos escenarios para ejecutar tareas complejas en equipo.

Q2BSTUDIO y su papel en la transición En Q2BSTUDIO nos especializamos en desarrollar aplicaciones a medida y software a medida pensadas para aprovechar las ventajas de arquitecturas con estado. Ofrecemos soluciones de inteligencia artificial y servicios pensados para empresas, desde la integración de agentes IA hasta plataformas personalizadas que incorporan memoria persistente y gestión de sesiones. Nuestro equipo combina experiencia en diseño de software, ciberseguridad y servicios cloud para entregar proyectos robustos y seguros. Podemos ayudarte a desplegar modelos con memoria sobre infraestructuras escalables y seguras en la nube como AWS y Azure, optimizando costes y rendimiento con prácticas de DevOps y seguridad.

Si buscas implementar soluciones de IA empresarial o agentes con memoria, conoce nuestras propuestas de inteligencia artificial para empresas y cómo desplegamos infraestructuras escalables con servicios cloud aws y azure. Además prestamos servicios en ciberseguridad y pentesting para proteger la memoria y los datos de tus usuarios, y ofrecemos capacidades de inteligencia de negocio y Power BI para explotar los insights generados por tus sistemas inteligentes.

Conclusión El paso de aplicaciones sin estado a con estado representa una evolución esencial en la interacción humano IA. Adoptar memorias persistentes, gestión de contexto y arquitecturas orientadas a sesiones transforma la experiencia de usuario y habilita casos de uso avanzados. En Q2BSTUDIO diseñamos y desarrollamos soluciones de software a medida que integran estas capacidades, combinando inteligencia artificial, ciberseguridad y servicios cloud para que tu empresa aproveche al máximo la era de los LLM stateful.

Comentarios