De modelos a la infraestructura de IA

Todos los desarrolladores que conozco están obsesionados con las métricas equivocadas. Debaten si Claude supera a GPT-4, si el razonamiento de Gemini es mejor que el de ChatGPT o si el último modelo de Anthropic u OpenAI lo cambiará todo. Están peleando una guerra de ayer. Mientras discutimos qué modelo genera mejor código o escribe ensayos más coherentes, la transformación real ocurre en una capa completamente distinta de la pila tecnológica. Las empresas que dominarán los próximos cinco años no serán las que tengan los modelos individuales más inteligentes. Serán las que resuelvan la orquestación de IA a escala. Las guerras de modelos están terminando. Las guerras de infraestructura apenas comienzan.

La falsa promesa de la superioridad del modelo. Vivimos el final de la era del cuanto mayor el modelo, mejores resultados. En los últimos años cada avance pareció venir de contar parámetros o innovaciones en entrenamiento. GPT-3 nos sorprendió con 175 000 millones de parámetros. GPT-4 añadió capacidades multimodales. Claude empujó los límites del razonamiento. Gemini prometió mejor integración. Nació una narrativa seductora: encuentra el mejor modelo y has resuelto la IA. Pero pregúntale a cualquier desarrollador que haya desplegado funciones de IA a escala y verás otra realidad. La elección del modelo rara vez es el cuello de botella. El problema es todo lo demás: gestión del contexto, ingeniería de prompts, estrategias de fallback, optimización de costes, requisitos de latencia, garantías de fiabilidad y, sobre todo, la capa de orquestación que lo une todo.

Un ejemplo real: ayudé a una startup a migrar su servicio de atención al cliente potenciado por IA. Llegaron convencidos de que su problema era elegir modelo porque Claude no entendía tan bien el contexto como GPT-4 para su caso. Tres semanas después habíamos mejorado el rendimiento del sistema un 40 sin cambiar de modelo. Las mejoras vinieron de caching inteligente de prompts, ventanas de contexto optimizadas y un sistema de fallback que manejaba los casos límite con gracia. El problema nunca fue el modelo, fue la infraestructura alrededor del modelo.

El reto de la orquestación. Lo que la obsesión por modelos pasa por alto es que las aplicaciones reales no usan un solo modelo. Usan redes de modelos. Un sistema de producción puede enrutar consultas distintas a modelos diferentes según complejidad, coste y latencia. Preguntas simples van a modelos rápidos y económicos. Tareas de razonamiento complejo se envían a opciones más potentes. El análisis de imágenes fluye por modelos especializados en visión. La generación de código puede usar una canalización distinta a la del lenguaje natural. No se trata solo de disponer de varios modelos: se trata de la capa de orquestación inteligente que decide qué modelo usar, cuándo usarlo, cómo encadenar llamadas y cómo manejar fallos con degradación elegante.

Construir esa capa exige resolver problemas que nada tienen que ver con las capacidades intrínsecas del modelo: lógica de enrutamiento dinámico capaz de evaluar la complejidad de una consulta en tiempo real, preservación del contexto entre fronteras de modelos, algoritmos de optimización de coste que balanceen rendimiento y gasto, gestión de latencia que prediga y minimice tiempos de respuesta, manejo de errores que degrade de forma segura cuando un modelo no está disponible y marcos de A B testing para evaluar distintas estrategias de enrutamiento. Ninguno de estos retos se soluciona con modelos más grandes. Requieren infraestructura.

La jugada de plataforma. Las empresas que entienden esto construyen plataformas, no solo modelos. Crean la tubería que hace posible la orquestación de IA para desarrolladores que no quieren pasar seis meses desarrollando su propia lógica de enrutamiento. Plataformas como la que ofrecemos en Q2BSTUDIO ejemplifican este cambio. En lugar de apostar todo a un único modelo, damos acceso a múltiples modelos a través de una interfaz unificada. El valor no está en las capacidades individuales del modelo, sino en la capa de abstracción que hace trivial comparar, cambiar y orquestar modelos. Es el mismo patrón que vimos al inicio del cloud: no importaba tener el procesador más rápido, importaba quién hacía invisibles las decisiones de infraestructura. Hoy la pregunta no es qué modelo es mejor sino qué plataforma facilita usar el modelo adecuado para cada tarea.

Mejor experiencia de desarrollador. La mayoría de herramientas de IA hoy obligan a los desarrolladores a pensar como investigadores de IA en lugar de como ingenieros de software. Exponen detalles internos del modelo, requieren conocimientos profundos de prompt engineering y fuerzan decisiones de infraestructura que no deberían ser su responsabilidad. La infraestructura de IA lista para producción debería sentirse más como las capas de abstracción de bases de datos: defines lo que quieres y el sistema decide cómo entregarlo de forma eficiente. No deberías tener que saber si tu consulta encaja mejor en Claude o GPT. No deberías implementar manualmente lógica de reintentos ni estrategias de optimización de costes. Herramientas como tutores de IA o resúmenes automáticos de investigación anticipan lo que es posible cuando la orquestación está bien diseñada.

En Q2BSTUDIO diseñamos soluciones que permiten a las empresas enfocarse en su negocio mientras nosotros nos ocupamos de la orquestación, la integración y la seguridad. Somos especialistas en desarrollo de aplicaciones a medida y software a medida, construimos agentes IA para flujos complejos y desplegamos soluciones de servicios cloud aws y azure para garantizar escalabilidad y fiabilidad. Además ofrecemos servicios de ciberseguridad y pentesting para proteger las integraciones, servicios de inteligencia de negocio y Power BI para convertir datos en decisiones accionables y automatización de procesos que reduce costes operativos.

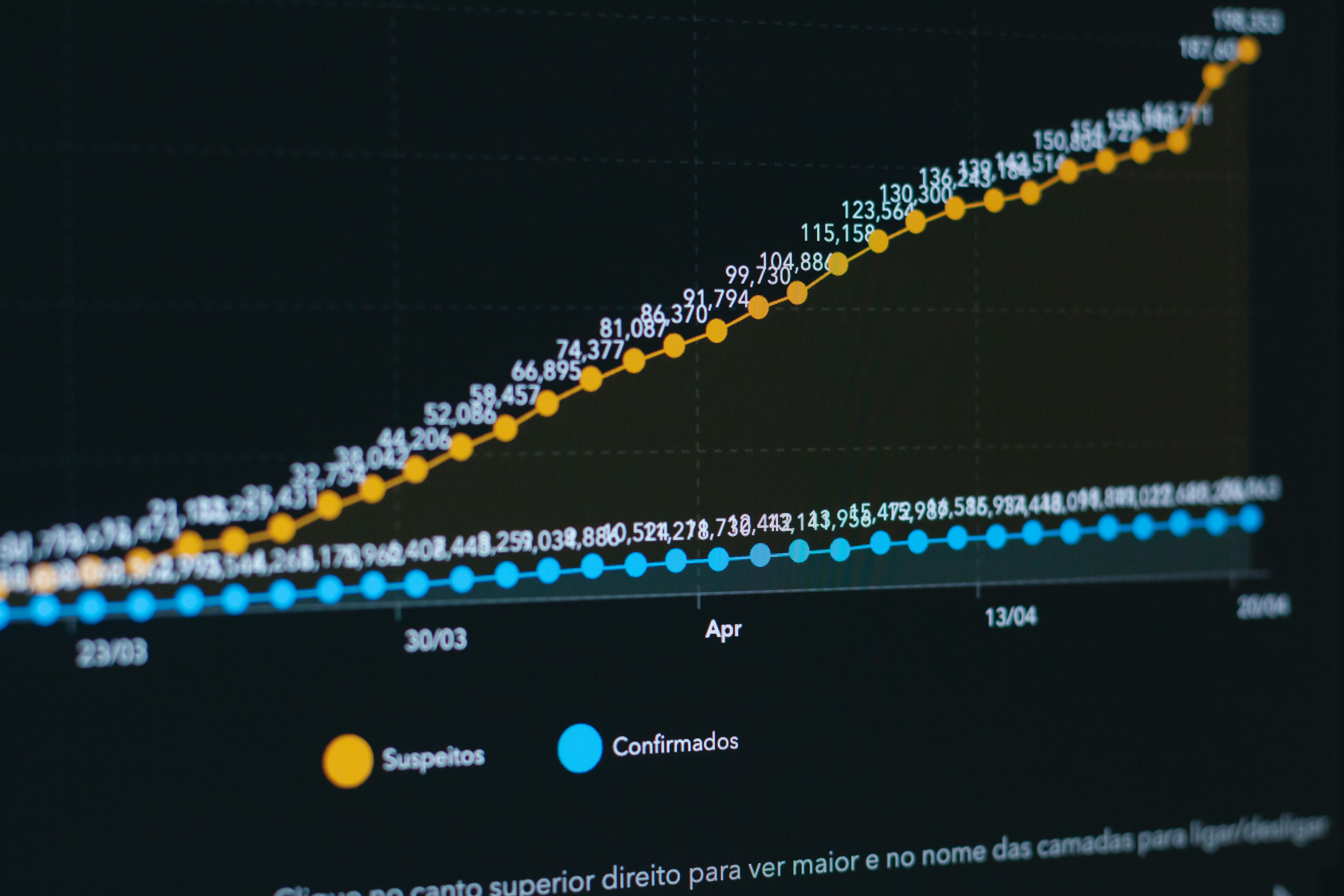

Hacia la estandarización. Nos acercamos a un punto en que las capacidades básicas de los modelos se volverán commodities. GPT 5, Claude 4 o Gemini Ultra serán todos sorprendentemente competentes en tareas de lenguaje. Los diferenciadores serán la velocidad y optimización de costes, la fiabilidad y uptime, las capacidades de integración, la calidad de la experiencia de desarrollador y las herramientas especializadas para dominios concretos como código, análisis o redacción. Esas ventajas no dependen de más datos de entrenamiento sino de mejores infraestructuras, abstracciones y herramientas para desarrolladores.

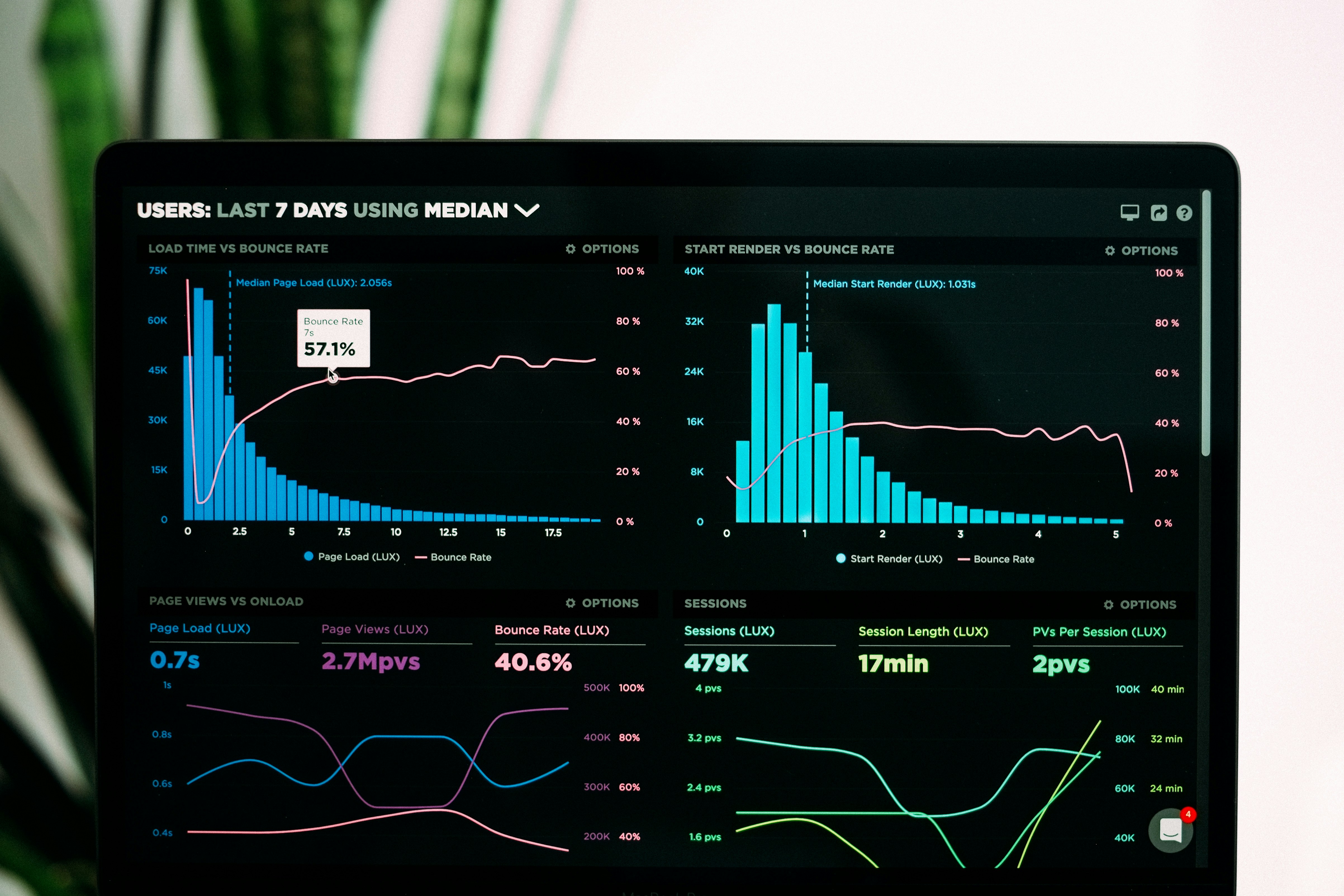

Pila de infraestructura. La pila de infraestructura de IA está tomando forma con capas clave: enrutador de modelos que decide en tiempo real, gestor de contexto que mantiene estado entre interacciones, optimizador de costes que elige proveedores según objetivo, monitor de rendimiento que rastrea latencia y precisión, sistemas de fallback que degradan con gracia y herramientas para desarrolladores como APIs y SDKs que abstraen la complejidad. Las empresas que construyan versiones superiores de estos componentes capturarán más valor que las que solo entrenan modelos.

Implicaciones estratégicas. Para desarrolladores esto cambia todo en la adopción de IA: deja de optimizar por selección de modelo y empieza a optimizar por arquitectura que se adapte a distintos modelos sin fricciones. Evita apostar por un único proveedor y construye sobre plataformas que ofrezcan opcionalidad y eviten vendor lock in. Piensa en IA como un sistema distribuido con componentes especializados. Aprovecha plataformas que resuelvan la orquestación por ti en lugar de construir infraestructura personalizada desde cero.

La batalla real por venir no será por el laboratorio que presente la demo más impresionante sino por la plataforma que haga la orquestación invisible mientras entrega mejor rendimiento, fiabilidad y eficiencia de costes. El enfoque centrado en infraestructura beneficia a todos: los desarrolladores obtienen mejores herramientas y abstracciones, las empresas capacidades de IA más fiables y rentables y los usuarios finales experiencias que emplean el mejor modelo para cada tarea sin que nadie lo note. En Q2BSTUDIO estamos listos para ayudarte a dar ese salto con soluciones de inteligencia artificial para empresas, agentes IA, power bi y servicios de ciberseguridad que garantizan que tu transición a una infraestructura-first sea segura y rentable.

Comentarios