Mi robot de CI/CD arregló la producción mientras dormía hasta que no lo hizo

Mi robot de CI/CD arregló la producción mientras dormía hasta que no lo hizo

Durante meses presumí que mi pipeline de CI/CD era más fiable que yo. Desplegaba rápido, no olvidaba un punto y coma y no necesitaba café para manejar rollbacks nocturnos. Un buen día entré al dashboard y vi que el bot había marcado todo como resuelto mientras la API principal respondía null a todo el mundo. Lo que parecía una ayuda impecable se convirtió en la peor pesadilla de operaciones: una logica de auto reparación que arreglaba lo que no debía y no tocaba lo que sí hacía falta.

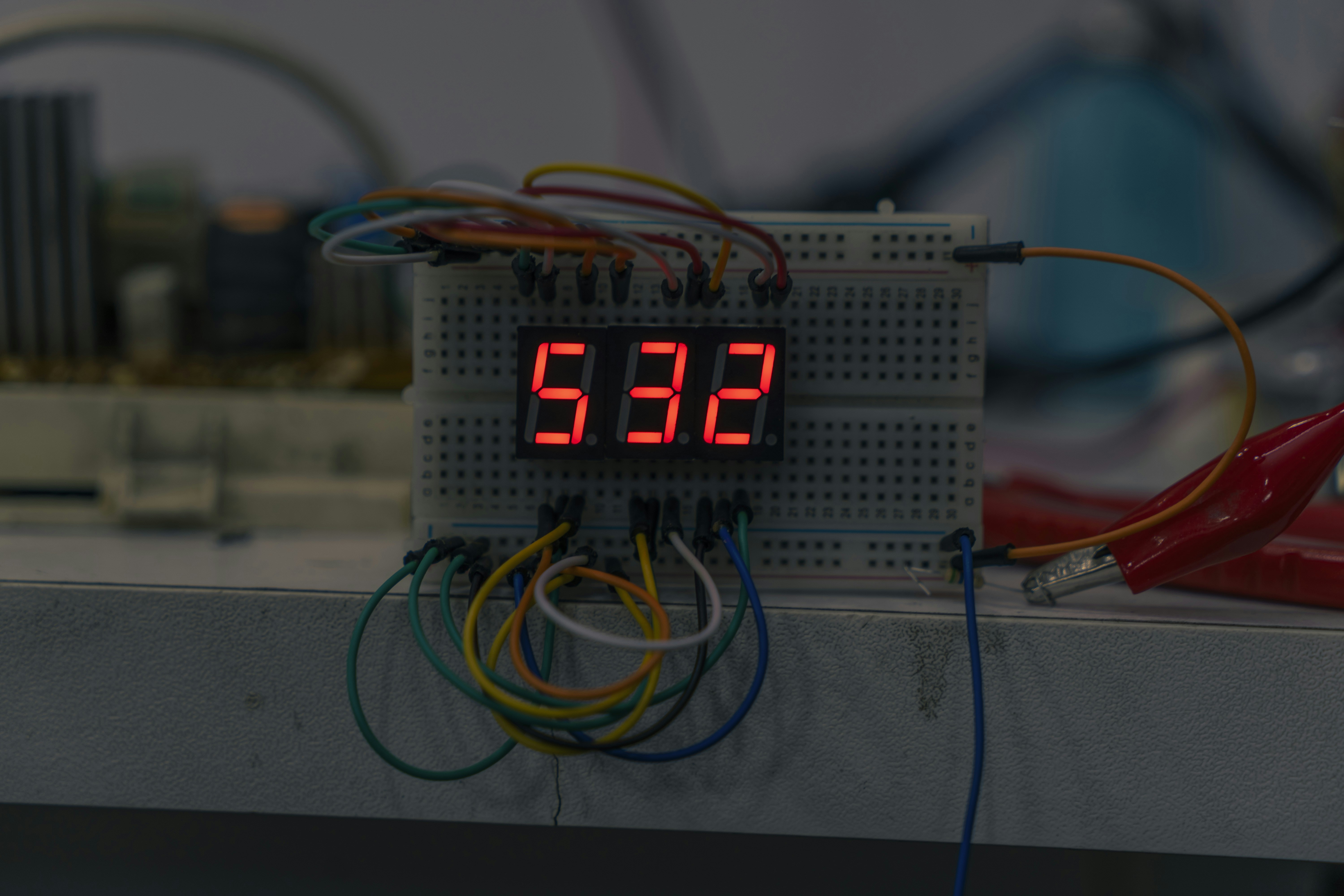

La base técnica era sencilla pero peligrosa: GitHub Actions como motor de despliegues, Prometheus Alertmanager para detección de anomalías y unas playbooks de Ansible que ejecutaban remediaciones automáticas. Añadí comprobaciones de salud, rollbacks automáticos y un bucle de curación que reintentaba acciones hasta tres veces antes de despertar a un humano. Al principio todo fue idílico: despliegues sin interrupciones y noches en vela recuperadas. El problema llegó cuando la automación dejó de pedir permiso y empezó a decidir.

La secuencia que desató el caos comenzó con una alerta por latencia. El bot interpretó la variación como una caída, inició rollback, redeploy y volvió a hacer rollback en un bucle que no solucionaba nada pero sí degradaba el servicio. Peor aún, el sistema había bloqueado las sobreescrituras manuales hasta que terminara su secuencia de curación, lo que me impidió detenerlo a tiempo. Cuando recuperé el control, el bot ya había revertido tres releases estables, limpiado caches sanos y borrado logs mayores a 24 horas, incluyendo evidencia del incidente.

Tras el susto tocó hacer un analisis de causa raíz y extraer lecciones. Primera lección: los bots siguen patrones, no criterio. La automación reacciona a reglas y umbrales; no entiende contexto. Un aumento de tráfico por una aparición en medios no es una caída, pero para una regla rígida es una alarma roja. Segunda lección: simular fallos es obligatorio. Las pruebas de caos muestran cómo se comporta la automación cuando la realidad difiere del camino feliz. Herramientas como Gremlin o LitmusChaos ayudan a exponer reacciones inesperadas. Tercera lección: auditar y versionar la automación. Cada umbral, regla y script debe estar en control de versiones y tener historial para saber quién decidió qué y cuándo.

Prácticas concretas para sistemas AIOps más seguros: validar las remediaciones antes de aplicarlas en producción, exigir aprobaciones humanas tras reintentos fallidos, implementar un kill switch que permita desconectar la auto reparación, y mantener logs intocados durante incidentes para que el postmortem sea posible. Además, hay que evitar delegar juicio humano en reglas que sólo hacen pattern matching. La idea de inteligencia artificial en operaciones no es eliminar humanos, sino reducir el ruido para que los humanos se encarguen de la ambigüedad y la estrategia.

En Q2BSTUDIO entendemos ese equilibrio entre velocidad y control. Como empresa de desarrollo de software y aplicaciones a medida ofrecemos arquitecturas que combinan automatización responsable con mejores prácticas de ciberseguridad y gobernanza. Si necesitas construir pipelines y aplicaciones capaces de escalar sin perder control humano puedes ver nuestros servicios de desarrollo de aplicaciones y software a medida en desarrollo de aplicaciones y software a medida. Si tu objetivo es incorporar inteligencia artificial a la operación o crear agentes IA que tomen decisiones asistidas, conoce nuestras soluciones de IA en inteligencia artificial para empresas.

También es clave integrar servicios cloud robustos y seguros. En Q2BSTUDIO diseñamos despliegues en servicios cloud aws y azure con controles de seguridad y observabilidad que minimizan falsas alarmas y permiten una respuesta humana informada. Complementamos con servicios de ciberseguridad y pentesting para que la automación no sea una puerta de entrada a riesgos evitables. Para equipos que necesitan inteligencia de negocio y visibilidad, trabajamos con Power BI y soluciones de inteligencia de negocio que contextualizan métricas operativas y ayudan a evitar interpretaciones equivocadas de picos o caídas.

Algunas recomendaciones prácticas resumidas: versionar la lógica de operación, automatizar validaciones y gates humanos, probar la automación con caos engineering, limitar privilegios de los bots y registrar todo lo que hacen. Por último, diseñar pipelines que expliquen por qué actuaron, referencien el ticket correspondiente y pidan confirmación antes de ejecutar acciones destructivas. Eso convierte a la automación en compañera y no en tirano.

La moraleja no es renegar de AIOps sino crear confianza informada. La automación da velocidad y consistencia, y los humanos aportan juicio y contexto. En Q2BSTUDIO ayudamos a empresas a construir esa sinergia entre desarrollos a medida, inteligencia artificial, agentes IA, ciberseguridad y servicios cloud para que las operaciones sean más resilientes y menos sorprendentes. Al final, un pipeline que se cura solo suena fantástico hasta que curó lo que no debía. La solución es simple en concepto: mantener a los humanos en el bucle correcto y a los bots en su rol de asistentes poderosos pero supervisados.

Palabras clave aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA, power bi

Comentarios