Entendiendo el Protocolo de Contexto del Modelo (MCP): Más allá de la Exageración

El Protocolo de Contexto del Modelo MCP es un estándar abierto que busca resolver la fragmentación actual del ecosistema de IA evitando integraciones punto a punto entre cada modelo y cada herramienta. En lugar de escribir un conector distinto para cada combinación de modelo y recurso, MCP actúa como un conector universal que permite que una misma herramienta sea consumida por múltiples modelos sin código de pegado personalizado.

Arquitectura esencialmente triangular: el Host es la aplicación de cara al usuario que orquesta la experiencia y contiene al modelo, el Cliente es la librería o puente embebido en el Host que negocia capacidades con los servidores, y el Server es donde reside la lógica y donde se envuelven capacidades como bases de datos, sistemas de ficheros o APIs externas para exponerlas mediante primitivas estandarizadas.

Las primitivas centrales que suelen ofrecer los MCP Servers son tres: Recursos para lecturas pasivas de datos, Herramientas para ejecutar acciones o efectos sobre sistemas externos, y Prompts o plantillas reutilizables para proporcionar contexto inicial a las conversaciones. Un mecanismo clave es el descubrimiento de capacidades: cuando un Cliente se conecta pregunta que puede hacer el Server y recibe una lista de herramientas y esquemas que definen los argumentos esperados, lo que permite al modelo conocer tipos y parámetros de forma segura.

Para la capa de transporte MCP aprovecha JSON RPC 2.0 porque permite comunicación bidireccional, sesiones de larga duración y un mismo formato de mensajes sobre distintos transportes. Esto facilita implementaciones locales por stdio y despliegues remotos por SSE o WebSockets sin cambiar la semántica de los mensajes.

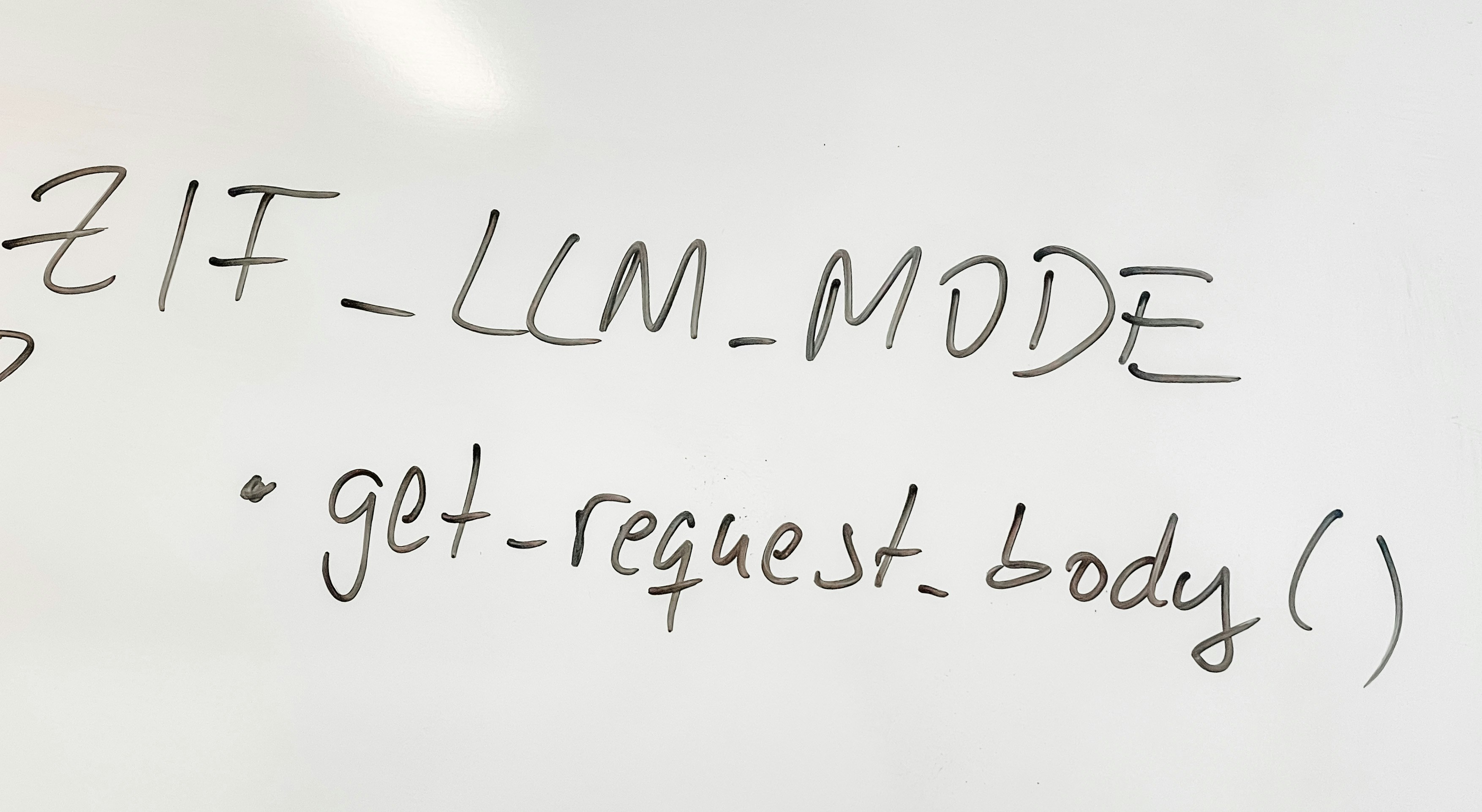

Un flujo típico sería que el usuario solicita una acción al Host, el LLM determina la intención y pide al Cliente que llame a la herramienta adecuada en el Server, el Server ejecuta la lógica y devuelve los resultados que se integran en el contexto del modelo para producir la respuesta final.

MCP va más allá de simples llamadas RPC con características avanzadas. El mecanismo de sampling permite al Server delegar tareas creativas o de generación de texto de vuelta al Host mientras ejecuta una operación. Las roots ofrecen un límite de seguridad para declarar alcances concretos de acceso, por ejemplo limitando un Server a un directorio o a una base de datos en particular, reduciendo riesgos de escalada de privilegios.

En cuanto a transportes y actualizaciones en tiempo real, MCP soporta notificaciones iniciadas por el Server sin necesidad de sondeo constante. Esto permite que un servidor de ficheros notifique cambios, o que un proceso de compilación transmita logs en streaming a medida que se producen, y funciona con stdio, SSE y extensiones sobre WebSockets cuando se necesita baja latencia o conexiones persistentes.

No es la solución perfecta para todo. Es ideal cuando se requieren integraciones interactivas entre modelos y herramientas, cuando múltiples proveedores de IA deben compartir las mismas capacidades o cuando las herramientas evolucionan con frecuencia. No es la opción principal para integraciones puntuales simples, para trabajos por lotes sin interacción o cuando la latencia ultra baja es el requisito dominante.

Desplegar MCP en producción introduce desafíos prácticos. Primero la escala: el modelo 1 host por 1 server por stdio no escala a miles de usuarios concurrentes, por lo que se recurre a gateways que hagan pooling de conexiones y multiplexen sesiones lógicas sobre menos conexiones físicas. Segundo la seguridad: MCP define el transporte pero deja abierta la autenticación, por lo que hay que reforzar headers, tokens y aislamiento mediante contenedores y configuración de roots. Tercero la observabilidad: depurar un flujo de mensajes continuo requiere trazabilidad, correlation ids y herramientas que sigan la traza Host gateway Server para entender la latencia y los fallos.

En la práctica, experimentar con MCP ayuda a comprender sus ventajas. Empezar construyendo un Server sencillo para una fuente de datos cotidiana permite comparar la experiencia frente a integraciones tradicionales punto a punto y valorar cuánto se reduce la complejidad.

En Q2BSTUDIO combinamos experiencia en desarrollo de software a medida y aplicaciones a medida con especialización en inteligencia artificial empresarial, ciberseguridad y servicios gestionados en la nube. Si quieres integrar agentes IA en tus procesos o llevar modelos a producción con buenas prácticas de seguridad y escalado, podemos ayudarte a diseñar la arquitectura y desarrollar tanto los Hosts como los Servers necesarios. Con soluciones personalizadas cubrimos desde la integración de agentes IA y pipelines de datos hasta la implementación de aplicaciones a medida y la orquestación en la nube.

Nuestros servicios incluyen también consultoría y despliegue en servicios cloud aws y azure, protección y auditoría mediante pentesting y ciberseguridad, y desarrollo de soluciones de servicios inteligencia de negocio con soporte para power bi y reporting avanzado. Ofrecemos proyectos de IA para empresas que abarcan desde prototipos de agentes colaborativos hasta integraciones completas de modelos y herramientas para automatización y análisis.

Si te interesa explorar MCP en un contexto empresarial seguro y escalable, o si necesitas una prueba de concepto que conecte modelos con tus sistemas internos, en Q2BSTUDIO podemos acompañarte en todas las fases: diseño, implementación, pruebas de seguridad y operación. Conoce más sobre nuestras capacidades en IA para empresas y proyectos de inteligencia artificial y descubre cómo adaptamos la tecnología a tus necesidades.

Recursos y referencias sobre MCP y su ecosistema ayudan a profundizar y a comparar implementaciones disponibles, pero la mejor forma de aprender es construir uno mismo un Server simple y medir el impacto en la disminución de integraciones m por n a una topología m más n que simplifica el mantenimiento a largo plazo.

Comentarios