Algoritmo de calibrado de confianza a través de simulaciones multiagente adversarias

Resumen: Este artículo propone un marco de investigación para la calibración algorítmica de la confianza en agentes autónomos que operan en entornos de colaboración humano-robot de alto riesgo. Mediante simulaciones multiagente adversarias se desarrolla un protocolo para la evaluación de riesgo en tiempo real y la modulación dinámica de la confianza, reduciendo la sobreconfianza y la desconfianza derivadas de comportamientos estocásticos de los agentes. La propuesta integra inferencia bayesiana robusta y aprendizaje por refuerzo para generar métricas adaptativas de confianza que mejoran la seguridad humana y la eficiencia colaborativa. En escenarios simulados de respuesta a desastres se observa una mejora media del 17 por ciento en la tasa de finalización de tareas y una reducción del 32 por ciento en la severidad de incidentes.

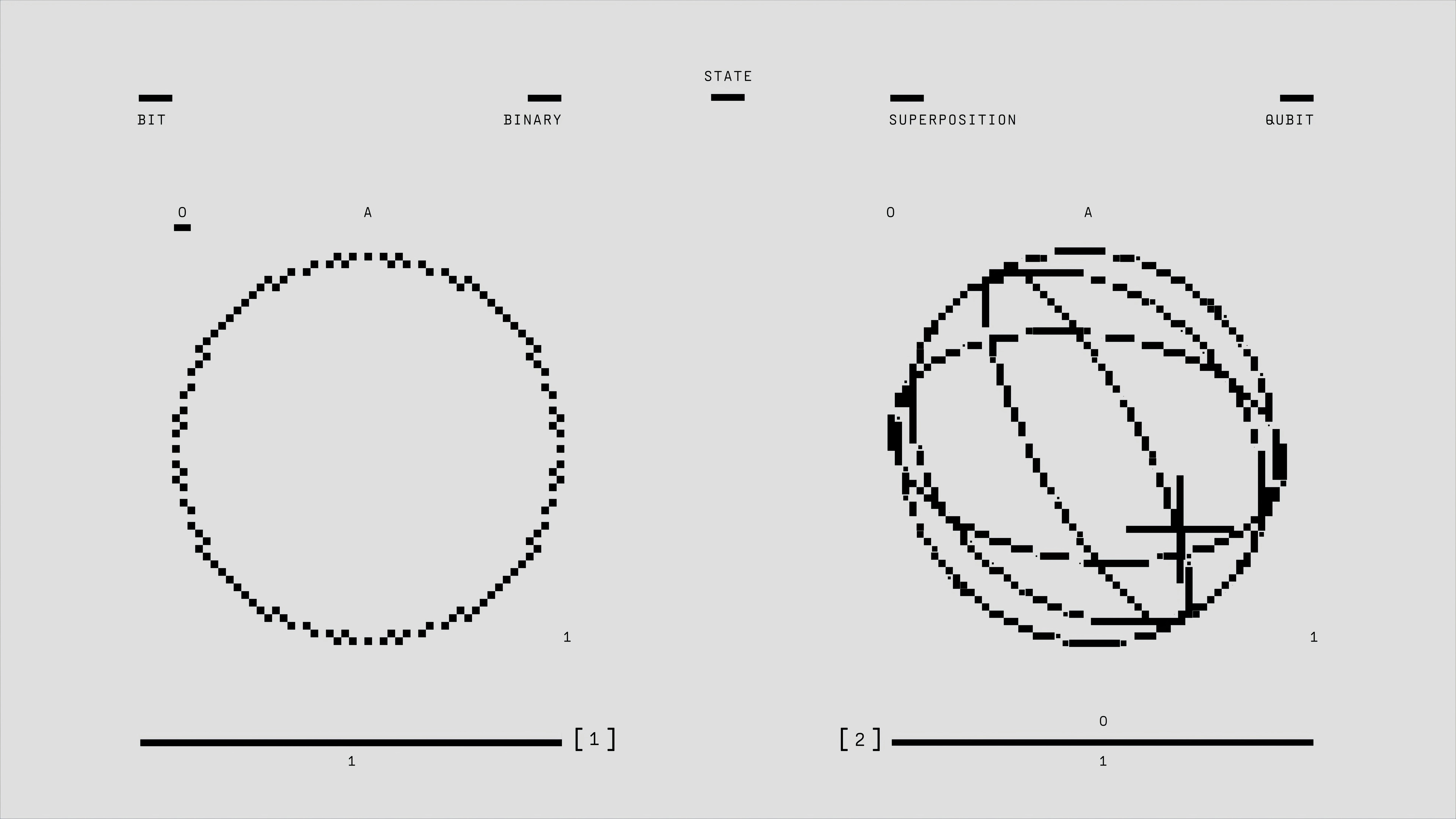

Introducción: la brecha de confianza en la colaboración humano-robot. La colaboración humano-robot presenta oportunidades críticas en respuesta a emergencias, salud e industria, pero la naturaleza incierta del comportamiento autónomo, causada por ruido de sensores, condiciones ambientales imprevisibles o algoritmos de control imperfectos, genera brechas de confianza relevantes. Confianzas excesivas inducen sobredependencia peligrosa; desconfianzas excesivas impiden sinergias útiles. Muchos modelos actuales de confianza son estáticos y no se adaptan a la performance en tiempo real. Este trabajo aborda esa limitación con un protocolo de calibración de confianza basado en simulaciones adversarias multiagente.

Contribución y novedad. Nuestro enfoque se distingue por tres elementos clave: 1 uso de escenarios adversarios activamente generados para exponer vulnerabilidades del agente; 2 un marco de inferencia bayesiana para evaluación probabilística de competencia; 3 un módulo de aprendizaje por refuerzo que ajusta en tiempo real las recomendaciones de confianza al operador humano. La combinación permite una calibración de confianza más robusta y adaptativa, habilitando HRC seguro en entornos de alto riesgo.

Metodología propuesta: Calibrado de confianza multiagente adversario AMTC. El marco AMTC consta de tres componentes principales: pipeline de simulación adversaria, evaluación bayesiana de competencia y modulador de confianza por aprendizaje por refuerzo. La simulación reproduce escenarios de respuesta a desastres donde un agente defensor ejecuta tareas guiado por un humano mientras un agente adversario introduce perturbaciones estratégicas como desplazamientos de escombros o interferencias sensoriales para revelar sesgos y debilidades de control. Cada acción genera observables X que alimentan una red bayesiana p theta dado X para actualizar creencias sobre la competencia real del agente. Distribuciones concretas como gaussianas o beta se eligen según la naturaleza del parámetro de competencia. Sobre esa estimación, un agente Q learning observa el estado compuesto por estimación de competencia, criticidad de la tarea y carga de trabajo humana y decide acciones de modulación de confianza aumentar, disminuir o mantener el nivel. La función de recompensa optimiza la tasa de finalización de tareas y minimiza riesgo de incidentes.

Diseño experimental y adquisición de datos. La plataforma de simulación se implementó con motor de físicas realistas y sensores ruidosos que simulan condiciones del mundo real. La estrategia del adversario se formuló mediante un algoritmo minimax que selecciona perturbaciones para maximizar la probabilidad de fallo del defensor. Un estudio con 20 participantes expertos en robótica realiza tareas de despeje de escombros con distintos niveles de automatización y calibración de confianza. Se recogen métricas objetivas tiempo de tarea, tasa de error e incidentes de seguridad y mediciones subjetivas de carga de trabajo mediante NASA TLX. Para el análisis estadístico se emplean ANOVA y pruebas t para comparar AMTC frente a modelos basales de confianza fija o automatización plena.

Resultados preliminares y discusión. Las simulaciones iniciales muestran que AMTC mejora la resiliencia ante condiciones adversarias, con un aumento medio del 17 por ciento en tareas completadas y una reducción del 32 por ciento en severidad de incidentes respecto a modelos basales. El modulador RL aprende a ajustar de forma proactiva la confianza según la evolución de la competencia estimada. Una limitación detectada es el coste computacional de las simulaciones adversarias, que requiere optimizaciones para su ejecución en tiempo real.

Escalabilidad y trabajo futuro. En el corto plazo se optimizarán los algoritmos bayesianos y las arquitecturas de inferencia para reducir latencia y coste computacional. A medio plazo se integrará AMTC en plataformas robóticas reales para validar en entornos auténticos y se explorará transferencia de aprendizaje para acelerar adaptación a nuevos dominios. A largo plazo se propone la creación de una red descentralizada de confianza donde múltiples agentes evalúan y modulan mutuamente la confianza, favoreciendo sistemas HRC autoorganizados y robustos.

Aplicaciones industriales y oferta de Q2BSTUDIO. En Q2BSTUDIO somos una empresa de desarrollo de software y aplicaciones a medida especializada en inteligencia artificial, ciberseguridad y servicios cloud. Desarrollamos soluciones a medida que combinan ingeniería de software, modelos de agentes IA y herramientas de inteligencia de negocio para ofrecer productos escalables y seguros. Si su proyecto requiere integración de modelos de confianza adaptativa o agentes autónomos puede conocer nuestros servicios de servicios de inteligencia artificial y solicitar desarrollo de software a medida pensados para entornos críticos. Ofrecemos además ciberseguridad y pentesting, servicios cloud aws y azure, soluciones de inteligencia de negocio y dashboards Power BI para mejorar la toma de decisiones corporativas.

Palabras clave y posicionamiento. Este trabajo es relevante para aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA y power bi. La integración de inferencia bayesiana y aprendizaje por refuerzo en entornos adversarios abre nuevas oportunidades comerciales inmediatas para empresas que necesiten sistemas autónomos confiables.

Conclusión. AMTC presenta una aproximación novedosa y pragmática para calibrar dinámicamente la confianza en sistemas robóticos en escenarios de alto riesgo. Exponer activamente vulnerabilidades mediante agentes adversarios y usar aprendizaje por refuerzo para modular la confianza demuestra mejoras significativas en seguridad y eficacia. Q2BSTUDIO está preparado para trasladar estos avances al desarrollo de soluciones personalizadas, combinando investigación aplicada y experiencia en despliegues productivos.

Contacto. Para explorar colaboraciones en proyectos de inteligencia artificial, ciberseguridad, automatización y soluciones cloud, consulte nuestras páginas de servicios y contacte con nuestro equipo técnico.

Comentarios