Pruebas y Optimización Rápida para Sistemas LLM Agentic: Un Marco Práctico con Maxim AI

Los sistemas agentic con modelos de lenguaje grande ya son esenciales en soporte al cliente, asistentes de programación, búsqueda y aplicaciones de conocimiento. Su fiabilidad depende de una gestión disciplinada de prompts, trazabilidad de agentes y evaluaciones continuas. Este artículo describe un marco práctico que puede desplegarse en producción, centrado en instrumentación, versionado, simulación, observabilidad y control de seguridad. También explica cómo un gateway de IA estabiliza la variabilidad entre proveedores mediante conmutación por error, enrutamiento y telemetría.

Resumen operativo Trate a los prompts, las trayectorias de los agentes y las evaluaciones como artefactos de ingeniería de primera clase. Instrumente trazas y spans para obtener observabilidad completa entre sesiones, herramientas y llamadas al modelo. Versione los prompts con gobernanza y adjunte resultados de evaluación a cada cambio. Simule flujos de agentes a escala antes del despliegue para detectar fallos en llamadas a herramientas y en las políticas de recuperación. Use un gateway para normalizar proveedores, reducir latencia y coste, y añadir conmutación por error y enrutamiento. Aplique guardarraíles de seguridad que mitiguen inyección de prompts mediante separación de privilegios y validación determinista.

Por qué importa esto: los LLM modernos son estocásticos y sus líneas base cambian con las actualizaciones de modelos. Los flujos agentic añaden complejidad multi-servicio con llamadas a herramientas, memoria y recuperación. Los equipos necesitan evaluaciones portables, telemetría robusta y experimentos reproducibles. A continuación se mapean los requisitos a componentes prácticos que puede implementar hoy.

Componentes clave Experimentación y gestión de prompts. Simulación y depuración de agentes. Canal unificado de evaluación. Observabilidad de producción con trazas y spans. Motor de datos para curación multimodal. Gateway de IA para estabilidad multi-proveedor y gobernanza. Postura de seguridad contra inyección de prompts y jailbreak.

Experimentación y gestión de prompts Use un sistema que versionee prompts, compare variantes y rastree coste y latencia entre modelos y parámetros. Integre revisiones humanas y evaluadores automáticos. Mantenga los cambios auditables y reversibles. Implemente plantillas de prompt con historial de versiones y diffs de cambios, variables de despliegue para probar parámetros sin editar código, comparaciones entre modelos con métricas de calidad coste y latencia, y revisiones automáticas o humanas según riesgo. Resultado: menor deriva de prompts, rollbacks seguros e identificación temprana de regresiones entre proveedores.

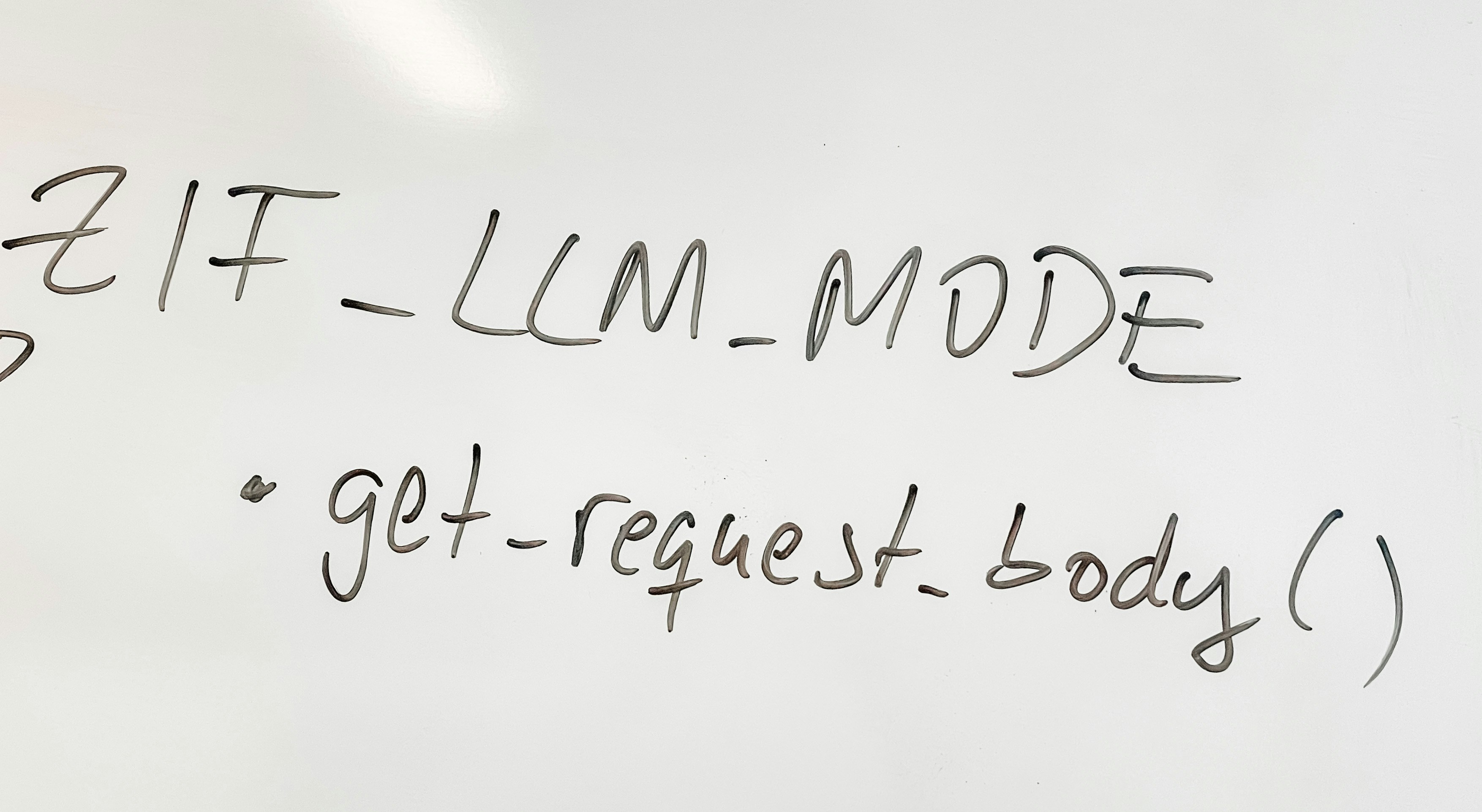

Simulación y depuración de agentes Las simulaciones convierten escenarios realistas en pruebas repetibles de las trayectorias de los agentes. Mida la corrección en el uso de herramientas, la finalización de objetivos y la capacidad de recuperación ante fallos. Reejecute desde cualquier paso para análisis de causa raíz. Evalúe personalidades, intenciones y casos extremos, la validez de llamadas a herramientas y precondiciones, la completitud de conversaciones y la calidad de las transiciones a operadores humanos, y las políticas de recuperación y timeouts. Resultado: menos incidentes de producción y depuración más rápida mediante replays deterministas.

Canal de evaluación unificado Mezcle comprobaciones deterministas, métricas estadísticas y juicios de LLM con revisiones humanas para la sutileza del dominio. Persista resultados y adjúntelos a versiones de prompts y agentes. Incluya validación programática de formatos y corrección de llamadas a herramientas, groundedness y relevancia de contexto para sistemas RAG, distribuciones de coste y latencia con detección de deriva y revisiones humanas para la calidad final y alineamiento con políticas. Resultado: evaluaciones portables y repetibles, umbrales documentados para promoción o rollback y detección más rápida de problemas sistémicos.

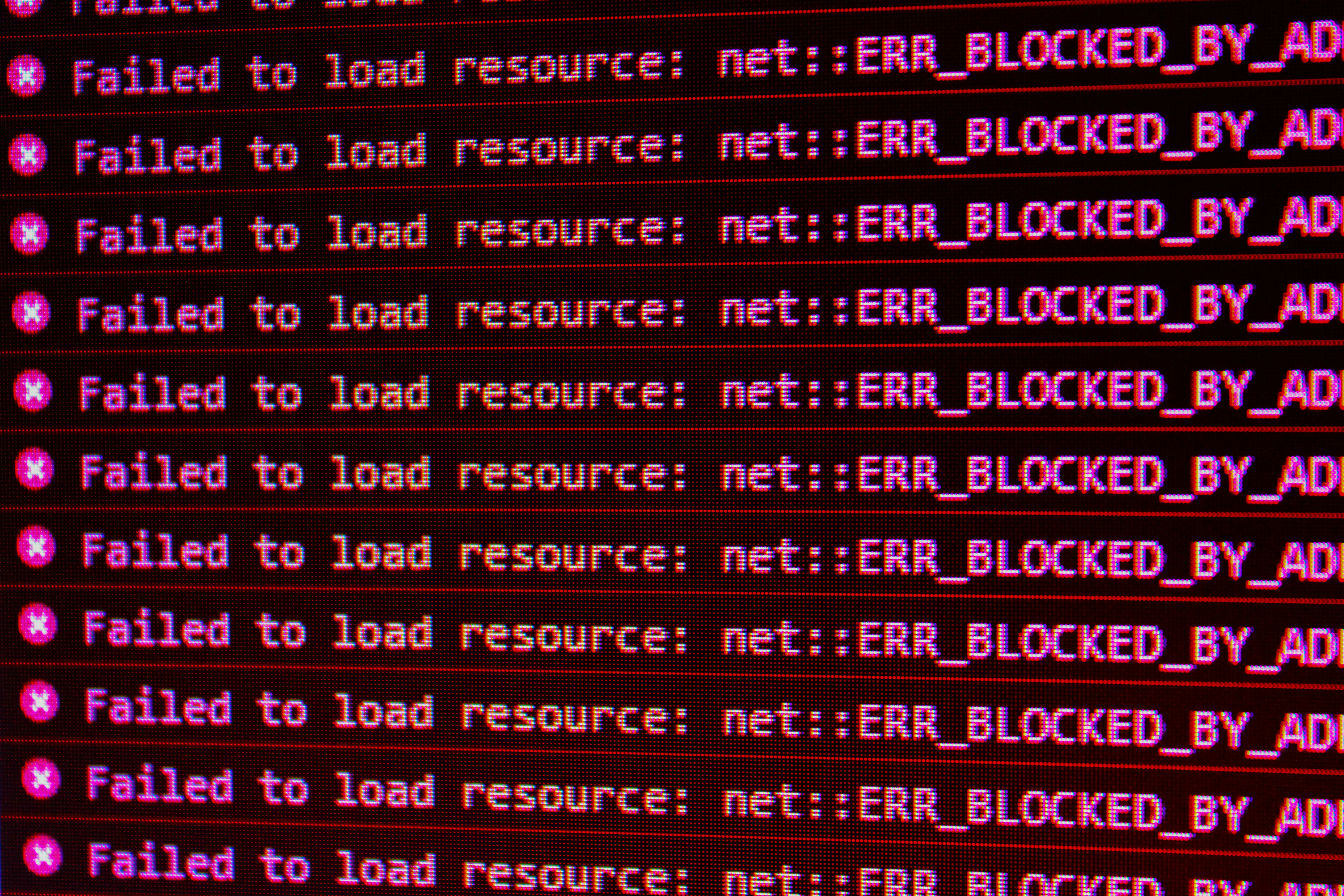

Observabilidad de producción con trazas y spans Instrumente sesiones, llamadas al modelo, invocaciones de herramientas y fetches de datos externos. Use trazado distribuido para construir la vista end to end de cada petición. Rastrée atributos como versión de prompt, configuración de evaluador y estado del agente. Registre logs en vivo, spans y códigos de estado; atributos semánticos para modelo, versión de prompt y nombres de herramientas; enlaces de spans para relaciones causales; y alertas sobre fallos de groundedness, desencadenantes de alucinaciones y uso anómalo de herramientas. Resultado: triage y resolución más rápida con contexto completo, señales de calidad correlacionadas con coste y latencia y conjuntos de datos de producción curados para futuras evaluaciones.

Motor de datos para curación multimodal La calidad de los datos determina la fidelidad de las evaluaciones. Importe texto, imagen y interacciones multimodales. Cuele y enriquezca registros de producción con retroalimentación humana y señales de evaluadores. Construya particiones dirigidas para evaluaciones de agentes, RAG, voz y chatbots. Mantenga datasets iterativos que reflejen dominios en evolución y establezca bucles de retroalimentación de problemas de producción hacia entrenamiento y evaluación. Resultado: mejor cobertura de casos extremos del mundo real y ciclo de mejora continua fundamentado en señales de producción.

Estabilizar proveedores con un gateway de IA Normalice diferencias entre proveedores y modelos con una capa de gateway que aporte conmutación por error automática, balanceo de carga, caché semántico, gobernanza y observabilidad. Use una API compatible para migración sin fricciones. El gateway reduce la latencia y el coste mediante enrutamiento inteligente y caché semántica, permite políticas de gobernanza y presupuestos por equipo y facilita la recuperación ante caídas de proveedores. Resultado: rendimiento consistente pese a la variabilidad, menor coste y controles de cumplimiento en entornos de producción.

Postura de seguridad contra inyección de prompts y jailbreak Trate todo contenido externo como no confiable. Contraina el comportamiento del modelo con prompts de sistema que describan capacidades y limitaciones, valide salidas de forma determinista con parsers y esquemas estrictos, filtre entradas y salidas sensibles, y aplique separación de privilegios con tokens de API con alcance reducido. Exija aprobación humana para acciones de alto riesgo, segmente contenido externo y ejecute pruebas adversariales de forma regular para detectar vectores directos e indirectos de inyección. Resultado: menor radio de impacto ante exploits en sistemas multiagente y menor riesgo de exfiltración de datos o acciones no autorizadas.

Plan de implementación Instrumentación y trazado: añada spans para llamadas a modelos, herramientas y recuperación; propague contexto entre servicios y configure alertas en fallos de evaluadores y anomalías. Versionado y gobernanza de prompts: rastree cambios y adjunte resultados de evaluación a cada versión; compare variantes entre modelos y parámetros. Simulación antes del despliegue: ejecute simulaciones de personas y flujos a escala y condicione el despliegue en corrección de llamadas a herramientas. Gateway para estabilidad y control de costes: unifique proveedores, habilite failover, balanceo y caché semántica, y aplique gobernanza y presupuestos. Guardarraíles de seguridad: limite comportamientos, valide formatos y haga separación de privilegios; segmente contenido externo y exija aprobaciones en acciones sensibles. Datos y evaluaciones continuas: convierta registros de producción en datasets multimodales, ejecute evaluaciones periódicas y use resultados como puertas de despliegue.

Estándares y cumplimiento El marco de gestión de riesgos de IA de NIST promueve AI confiable mediante gobernanza, medición y mejora continua. OpenTelemetry aporta un lenguaje común para trazas y spans. Seguir estos marcos facilita auditoría, cumplimiento y operación a escala.

En Q2BSTUDIO como empresa de desarrollo de software y aplicaciones a medida ofrecemos experiencia para implantar este modelo operativo. Somos especialistas en software a medida, inteligencia artificial aplicada a empresas, ciberseguridad, servicios cloud aws y azure y servicios de inteligencia de negocio y power bi. Podemos ayudar a versionar prompts, montar pipelines de evaluación, desplegar observabilidad con OpenTelemetry, y configurar gateways y estrategias de failover. Descubra nuestras soluciones de inteligencia artificial visitando la página de inteligencia artificial de Q2BSTUDIO o conozca nuestros servicios de desarrollo para crear aplicaciones y software a medida en desarrollo de aplicaciones multiplataforma.

Conclusión: la fiabilidad en sistemas agentic con LLM se diseña y construye. Instrumente la ruta completa de las peticiones, versionee prompts con evaluadores adjuntos, simule decisiones de agentes antes del despliegue, normalice proveedores con un gateway y aplique guardarraíles de seguridad contra inyección de prompts. Mantenga datasets multimodales y evaluaciones continuas. Este modelo operativo reduce incidentes, mejora la calidad y controla coste y latencia, al tiempo que facilita el cumplimiento y la escalabilidad de soluciones de IA empresariales y agentes IA.

Comentarios