Haciendo que el código de IA sea consistente con los linters

A medida que asistentes de codificación con inteligencia artificial como GitHub Copilot, Cursor y Claude Code se popularizan, surge un patrón claro y valioso para equipos de desarrollo: los proyectos que imponen reglas estrictas de linting y estilo obtienen resultados mucho mejores cuando colaboran con agentes IA.

El problema habitual es la inconsistencia creativa de la IA. Si le pides a un asistente implementar una misma función en varios lugares, es frecuente recibir soluciones funcionalmente correctas pero estilísticamente diferentes, lo que genera deuda técnica desde el primer commit. Esa variabilidad complica revisiones, pruebas y el mantenimiento del código.

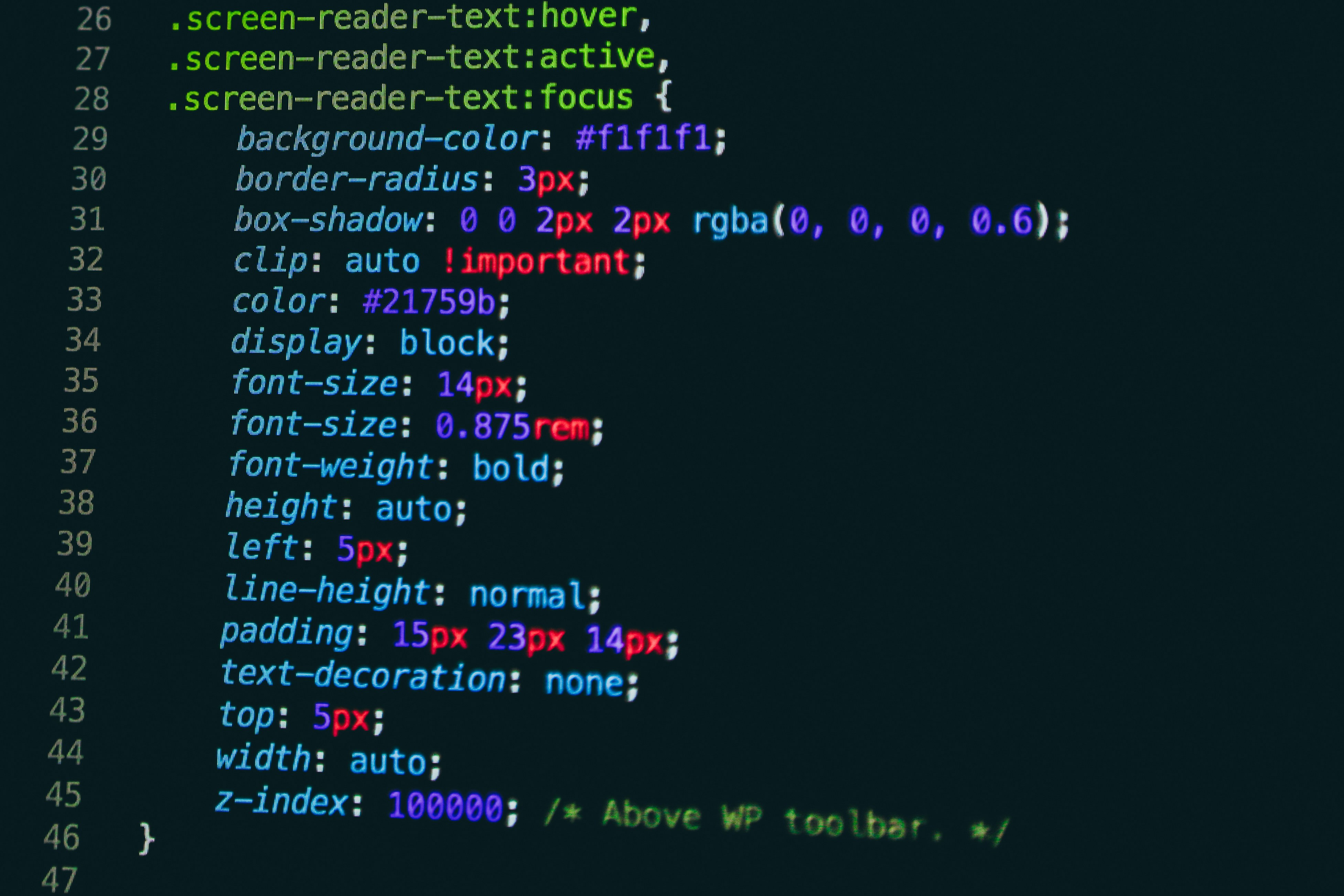

La solución pasa por enseñarle a la IA los estándares de tu proyecto mediante reglas de linting estrictas y convenciones claras. Cuando defines reglas que obligan a patrones consistentes, la IA deja de improvisar y comienza a producir código predecible y seguro. Esto aplica tanto a control de tipos en TypeScript como a convenciones de nombres, consistencia en imports y estructuras de módulos.

En TypeScript, activar strict y combinarlo con reglas de ESLint obliga a la IA a evitar atajos peligrosos y a respetar guardas de tipo, firmas explícitas y validaciones de datos. El resultado es código que falla de forma controlada y que facilita la integración continua y las pruebas automatizadas.

Integrar Prettier para el formateo y ESLint para las reglas semánticas produce un código que parece escrito por el equipo humano: mismo estilo, mismas comas finales, mismo uso de comillas simples o dobles y mismas reglas para paréntesis en funciones flecha. Esa uniformidad reduce la fricción en revisiones de pull request y acelera despliegues.

Una práctica emergente muy eficaz es aplicar reglas más estrictas a código generado por IA que a código escrito por humanos. Las reglas que resultan molestas para un desarrollador son triviales para un agente IA, por eso muchos equipos usan archivos de configuración separados para código humano y código AI. De este modo se obtiene consistencia perfecta sin entorpecer la creatividad y la productividad del equipo.

En la práctica conviene crear workflows que distingan autoría y apliquen el linter adecuado en CI CD. Por ejemplo, ejecutar lint para humanos en commits normales y un linting más severo para archivos generados por asistentes IA o ubicados en carpetas dedicadas. También es recomendable añadir validaciones que detecten imports inconsistente y reglas de complejidad para evitar funciones gigantes en código generado.

En Q2BSTUDIO, empresa especializada en desarrollo de software y aplicaciones a medida, aplicamos estas prácticas para ofrecer soluciones robustas en inteligencia artificial, ciberseguridad y servicios cloud. Nuestro enfoque combina experiencia en software a medida y agentes IA con prácticas de seguridad y despliegue en plataformas como AWS y Azure. Si buscas integrar IA en tus procesos productivos o desarrollar aplicaciones empresariales a medida contamos con experiencia probada en ia para empresas y en el despliegue de servicios cloud aws y azure.

Ofrecemos servicios que van desde creación de aplicaciones a medida y software a medida hasta proyectos avanzados de inteligencia artificial. Para iniciativas centradas en agentes IA y analítica también integramos soluciones de servicios inteligencia de negocio y Power BI que facilitan la toma de decisiones.

Si te preocupa la calidad del código generado por IA o necesitas una estrategia para combinar agentes IA con prácticas de ingeniería sólidas, en Q2BSTUDIO diseñamos pipelines y reglas de linting personalizadas que maximizan beneficios y reducen riesgos. Contáctanos para conocer cómo podemos implementar reglas, automatizaciones y controles que conviertan tu repositorio en un marco de colaboración eficiente entre humanos y máquinas.

Comentarios