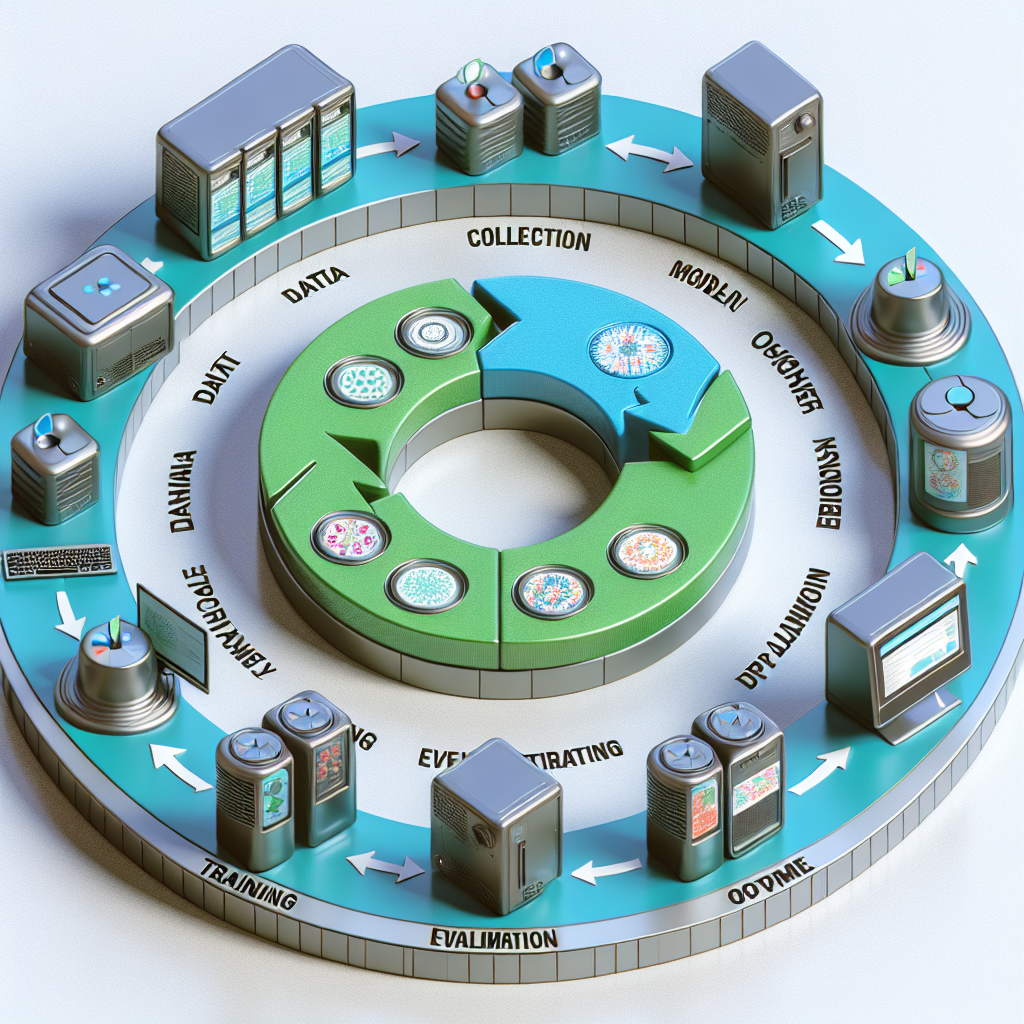

Modelos de SageMaker y el Ciclo de ML en Acción

El ciclo de vida del aprendizaje automático o ML se puede entender como el crecimiento de un ser vivo desde la infancia hasta la madurez: un proceso iterativo que va desde un objetivo de negocio hasta una solución operativa. Comprender este ciclo ayuda a reducir la complejidad técnica y a aplicar buenas prácticas que aumentan las probabilidades de éxito de un proyecto de ML.

Identificación del objetivo de negocio Es fundamental definir con claridad el problema que se quiere resolver y el valor medible que se espera obtener. Sin una métrica de negocio clara es difícil priorizar recursos y evaluar impacto.

Formulación del problema de ML En esta fase se transforma el reto de negocio en un problema de aprendizaje automático: qué variable hay que predecir, cómo se medirá el rendimiento y qué métricas de error se optimizarán. Elegir la etiqueta correcta y definir métricas alineadas con el negocio son pasos críticos.

Procesado de datos Esta etapa es la base para entrenar modelos precisos. Incluye recolección de datos relevantes y diversos, limpieza para tratar valores faltantes y atípicos, preprocesado para estandarizar formatos y codificar variables, ingeniería de características para crear señales útiles y análisis exploratorio de datos para detectar patrones y sesgos. El objetivo es transformar datos crudos en un formato utilizable para el entrenamiento.

Desarrollo del modelo Implica construcción, entrenamiento, ajuste de hiperparámetros y evaluación. Se prueban algoritmos, se validan resultados con datos fuera de entrenamiento y se controla el sobreajuste. Modelos como XGBoost suelen entrenarse en la nube para escalabilidad mientras que modelos locales como Random Forest sirven de referencia y comparación.

Despliegue y producción El modelo entrenado se pone en producción mediante estrategias de despliegue que permiten realizar inferencias en tiempo real o por lotes. En entornos gestionados como Amazon SageMaker los modelos se empaquetan y exponen mediante endpoints seguros para integrar predicciones en aplicaciones corporativas.

Monitorización y mantenimiento Una vez en producción es vital monitorizar rendimiento, detectar desviaciones por deriva de datos, validar integridad y actualizar modelos. Sistemas de monitorización permiten detección temprana de problemas y acciones de mitigación para mantener la fiabilidad y el cumplimiento.

Principios de diseño bien arquitectado para ML Las buenas prácticas en la nube facilitan soluciones sostenibles y seguras. Entre ellas asignar responsabilidades claras y recursos adecuados, proteger datos y endpoints con controles de seguridad, garantizar resiliencia mediante versionado y trazabilidad, promover la reutilización con componentes modulares, asegurar reproducibilidad con control de versiones de infraestrucutra, datos y código, optimizar recursos y costes mediante análisis de trade offs, automatizar pipelines con CI CD y entrenamiento continuo, y minimizar impacto ambiental mediante servicios gestionados y hardware eficiente.

Cómo funciona el modelo de forma intuitiva Un modelo aprende a partir de características y pesos. Las características son variables relevantes del conjunto de datos y los pesos indican su influencia en la predicción. En un ejemplo lineal la predicción es una suma ponderada de las características más un sesgo. En un sistema de recomendación un modelo puede sumar las contribuciones ponderadas de coste, marca y tipo para decidir si recomendar un producto.

Uso de Amazon SageMaker en el ciclo de ML Amazon SageMaker Studio ofrece un entorno gestionado para construir, entrenar y desplegar modelos de forma integrada. La plataforma facilita entrenamientos escalables con contenedores preconstruidos como XGBoost, gestión de datos en S3, y despliegue de endpoints para inferencia. Para casos de generación de lenguaje y aplicaciones Gen AI hay capacidades específicas que permiten acelerar desarrollos sin invertir en modelos totalmente personalizados.

Resumen práctico de pasos habituales 1 Iniciar sesión en la consola de AWS y seleccionar la región. 2 Crear un notebook en SageMaker y seleccionar un kernel con entornos como conda para preparar experimentos. 3 Preparar y limpiar el dataset, dividirlo en entrenamiento y prueba y subir los CSV a un bucket de S3. 4 Entrenar un modelo en SageMaker, por ejemplo XGBoost en contenedor gestionado, y ajustar hiperparámetros para regresión o clasificación. 5 Entrenar localmente un modelo de referencia como Random Forest con Scikit Learn para comparar rendimiento. 6 Desplegar el modelo entrenado como endpoint para realizar predicciones en tiempo real. 7 Limpiar recursos cloud para evitar costes innecesarios y comprobar en S3 que artefactos y el modelo empaquetado han sido almacenados.

Por qué confiar en Q2BSTUDIO Q2BSTUDIO es una empresa especializada en desarrollo de software y aplicaciones a medida con experiencia en proyectos de inteligencia artificial y ciberseguridad. Ofrecemos servicios integrales que abarcan desde la consultoría estratégica hasta la implementación y operación en la nube, incluyendo servicios cloud aws y azure, agentes IA para automatizar procesos y soluciones de inteligencia de negocio con Power BI. Si necesita desarrollar soluciones personalizadas puede conocer más sobre nuestras propuestas en aplicaciones a medida y si busca impulsar proyectos de IA para su empresa visite nuestra propuesta de inteligencia artificial.

Palabras clave presentes en esta guía aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA y power bi ayudan a mejorar el posicionamiento web y a conectar esta información con necesidades reales de negocio.

Conclusión Entender y ejecutar el ciclo de vida de ML permite transformar objetivos de negocio en soluciones operativas y sostenibles. Con prácticas bien arquitectadas, monitorización continua y el apoyo de especialistas como los de Q2BSTUDIO es posible construir modelos que aporten valor real, sean seguros y se integren eficientemente en la infraestructura cloud.

Comentarios