Modelado predictivo automatizado de la respuesta a fármacos antipsicóticos a través de la integración multi-ómica y la optimización bayesiana

Este artículo presenta una versión reescrita y traducida al español de la investigación que propone un marco innovador para predecir la respuesta individual a fármacos antipsicóticos mediante la integración multi-ómica y la optimización bayesiana. El enfoque supera limitaciones de modelos que trabajan con un solo tipo de dato al combinar genómica, transcriptómica y proteómica con un algoritmo de optimización bayesiana dinámico, lo que facilita estrategias de tratamiento individualizadas, disminuye reacciones adversas y reduce el coste asociado a la prescripción por prueba y error. Además, se describe la aplicabilidad inmediata y comercial del sistema y se integra información sobre Q2BSTUDIO, empresa especializada en desarrollo de software a medida, aplicaciones a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA y power bi.

Sección 1: Ingesta de datos y extracción de características detallada y ampliada

Introducción a la ingesta de datos multi-ómicos y objetivos de la etapa de preprocesado. El objetivo principal de esta fase es transformar datos crudos provenientes de diferentes plataformas experimentales en matrices de características robustas, limpias y armonizadas, aptas para modelado predictivo. Los tipos de datos considerados incluyen variantes genéticas (SNPs y CNVs), datos transcriptómicos procedentes de RNA-seq y datos proteómicos obtenidos por espectrometría de masas (LC-MS/MS). Cada uno de estos módulos requiere procesos específicos de control de calidad, normalización, imputación y anotación, y también una estrategia para la reducción de dimensionalidad y la selección de variables que permita conservar las señales biológicas relevantes sin sobreajustar el modelo.

Control de calidad y preprocesamiento genómico. Para los datos nucleares y variantes genéticas se recomienda una cadena de herramientas consolidada: control de calidad del ADN, alineamiento a la referencia con BWA o similar, marcado de duplicados y recalibrado de calidad con GATK, seguido de llamada de variantes y filtrado. El uso de PLINK es habitual para el filtrado a nivel de variante (por ejemplo tasa de llamado mínima, frecuencia alélica mínima, equilibrio de Hardy-Weinberg) y para análisis de estructura poblacional. Se deben aplicar umbrales claros: porcentaje de genotipado por individuo y por variante, tasa de heterocigosidad y pruebas de parentesco y duplicados. La detección de CNVs puede lograrse con algoritmos basados en intensidad de señal de microarray o con herramientas de WGS; es crucial normalizar y validar eventos de pérdida/ganancia para incluirlos como características.

Imputación y anotación. La imputación de genotipos con Beagle, IMPUTE2 o Minimac permite aumentar la densidad de marcadores y homogeneizar cohortes con plataformas distintas. La anotación funcional con ANNOVAR o VEP asigna consecuencias biológicas a las variantes y permite priorizar marcadores con impacto en genes farmacogenómicos relevantes (por ejemplo genes CYP, transportadores y receptores neuronales). Se recomiendan incluir anotaciones de efecto predictivo, frecuencia poblacional y datos clínicos conocidos para priorizar variantes. Es importante conservar metadatos de calidad y score de imputación para filtrar variantes poco fiables.

Preprocesamiento transcriptómico. La generación de datos RNA-seq comienza con la calidad del ARN, lectura y filtrado de secuencias, y mapeo con STAR o HISAT2. Alternativas de cuantificación pseudoalineada como Salmon o Kallisto aceleran el proceso y reducen sesgos. La normalización a TPM o FPKM es útil para comparaciones relativas, aunque para análisis diferencial y modelado robusto se recomienda normalización mediante DESeq2 o métodos basados en tamaño de librería y corrección por efectos de composición. La corrección de efectos por lotes con ComBat o modelos lineales ajustados por covariables técnicas (fecha de extracción, operador, plataforma) es esencial para evitar que señales técnicas dominen las variaciones biológicas. Para estudios longitudinales deben almacenarse versiones normalizadas por muestra por tiempo.

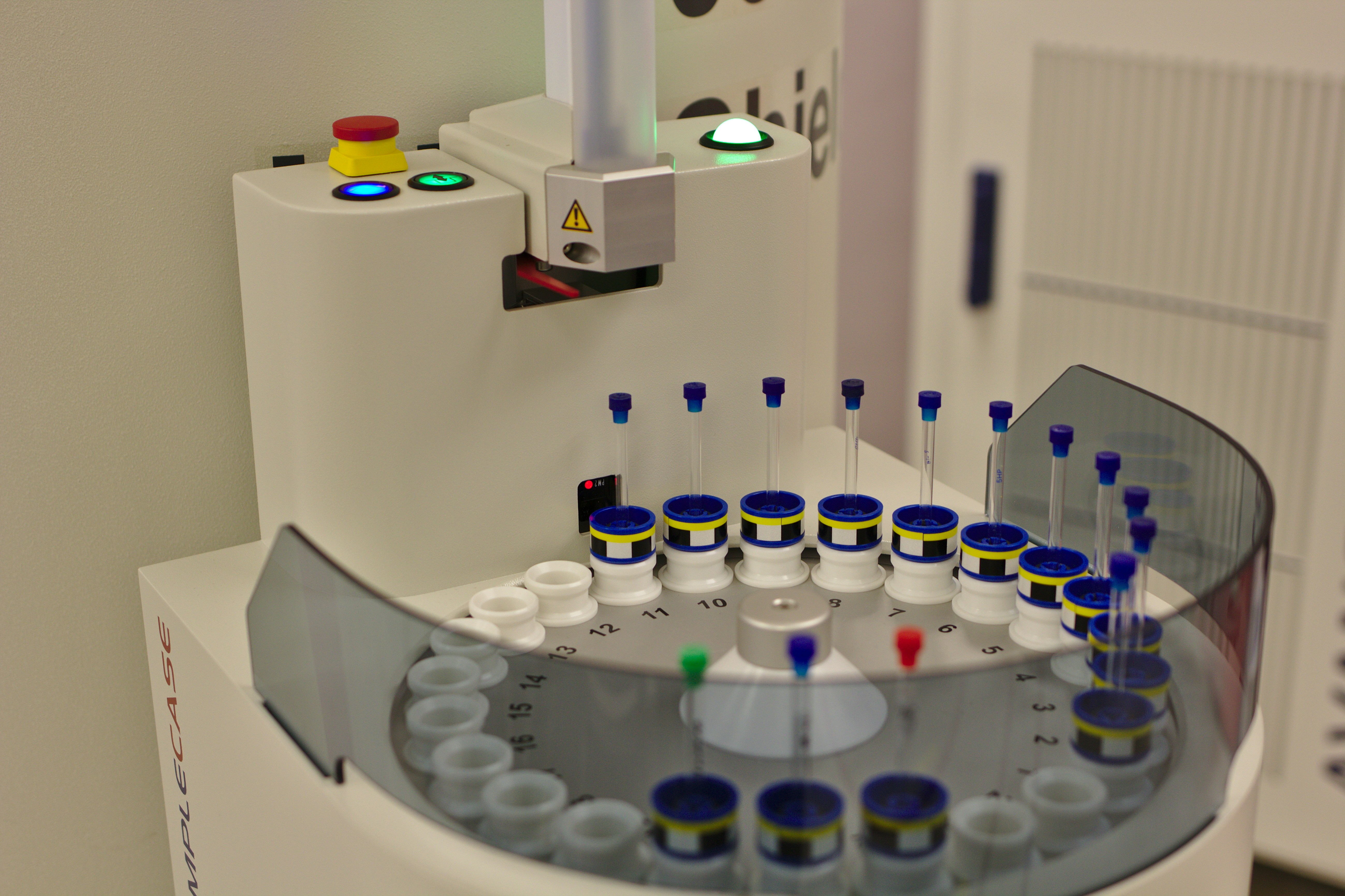

Preprocesamiento proteómico. En proteómica por LC-MS/MS, el flujo típico incluye identificación de péptidos y cuantificación con herramientas como MaxQuant o Proteome Discoverer, control de la tasa de descubrimiento falso (FDR), y consolidación de inferencia de proteínas a partir de péptidos. Se recomienda aplicar normalización por mediana o métodos basados en intensidad total y considerar estrategias de imputación específicas para valores faltantes en proteómica, diferenciando entre valores faltantes por debajo del límite de detección y valores faltantes aleatorios. La inclusión de estándares internos y replicados técnicos mejora la estimación de variabilidad y la corrección de sesgos instrumentales.

Manejo de valores perdidos e imputación multivariante. La imputación es crítica cuando se integran diferentes capas omics con distintos niveles de completitud. El uso de MICE (Multivariate Imputation by Chained Equations) permite modelar la distribución condicional de cada variable y completar datos faltantes respetando correlaciones entre variables. Es recomendable realizar imputación por bloques omics o incluir variables clínicas como predictores en la cadena de imputación para preservar señales relevantes. Para datos proteómicos y transcriptómicos, en ocasiones es preferible usar imputación basada en vecinos más cercanos o en modelos bayesianos si la proporción de valores faltantes es elevada.

Reducción de dimensionalidad y normalización cruzada. Dado el alto número de variables, antes del modelado se aplican métodos de reducción de dimensionalidad para exploración y detección de outliers, entre ellos PCA, t-SNE o UMAP. Estas técnicas ayudan a identificar clusters, batch effects residuales y muestras atípicas que puedan resultar de problemas técnicos. En paralelo, se realiza estandarización de features con escalado robusto o normalización z, según convenga, y se definen tratamientos para variables categóricas mediante codificación adecuada. Se recomienda mantener copias del dataset en diferentes formatos: una versión completa para análisis biológicos, una versión filtrada para modelado y otra con metadatos para auditoría.

Selección de características y reducción supervisada. Para pasar a un espacio de 200 características relevantes, se sugiere una combinación de enfoques supervisados y no supervisados que incluyan: análisis de asociación univariada (por ejemplo tests de correlación con la variable objetivo PANSS o respuesta categórica), selección por LASSO para penalizar y descartar características irrelevantes, eliminación recursiva de características (RFE) basada en estimadores robustos como random forests o gradient boosting, e integración de conocimiento biológico mediante anotaciones de genes farmacogenómicos y rutas metabólicas. La selección debe evaluarse en pipelines anidados de validación cruzada para evitar fuga de información y sobreajuste. También conviene generar features derivados o meta-features, como scores de vías, índices de expresión de conjuntos de genes o índices de actividad de rutas farmacológicas.

Ajuste por covariables clínicas y demográficas. Es importante incorporar variables clínicas como edad, sexo, historia de tratamientos previos, comorbilidades y medidas basales de severidad porque actúan como confusores y pueden mejorar la capacidad predictiva del modelo. Para problemas de estratificación poblacional se deben incluir componentes principales derivados de datos genéticos que capturen ancestría y reduzcan sesgos por estructura poblacional. El manejo de farmacogenética implica incorporar información sobre metabolizadores lentos o rápidos y variantes con anotación clínica para evitar que señales clínicas críticas queden subrepresentadas.

Integridad de datos, gobernanza y cumplimiento normativo. Al trabajar con datos sensibles de pacientes es indispensable mantener prácticas que garanticen privacidad, trazabilidad y seguridad. Se recomienda cifrar datos en tránsito y en reposo, auditar accesos, versionar datasets y mantener metadatos sobre procedencia y consentimiento informado. Cumplir con GDPR y normativas locales sobre investigación clínica es obligatorio. Adicionalmente, mantener un registro de los seeds y parámetros aleatorios utilizados en procesos de imputación y selección asegura reproducibilidad técnica.

Pipeline reproducible y automatización. La construcción de pipelines reproducibles usando contenedores (Docker) y orquestación (Nextflow, Snakemake) permite ejecutar el preprocesado en distintos entornos. Documentar versiones de herramientas y parámetros, exportar informes de control de calidad y almacenar artefactos intermedios facilita auditoría y depuración. La integración con servicios cloud permite escalar cómputo y almacenamiento, y facilita el despliegue de soluciones de software a medida y servicios cloud aws y azure para procesamiento bajo demanda.

Aspectos prácticos para la implementación: recomendaciones operativas. Establecer umbrales para filtrado de variantes y expresión, definir criterios de inclusión para muestras, realizar controles de calidad tanto automáticos como manuales, e incluir replicados técnicos cuando sea posible. Elaborar un plan de validación cruzada y particionado del dataset que respete estructura temporal y clínica para evitar fuga de información en modelos que incorporen datos longitudinales. Documentar cada transformación y mantener un catálogo de variables para facilitar el trabajo de científicos de datos y clínicos.

Resumen de salida de la etapa. El resultado final de esta fase es un conjunto de matrices armonizadas y anotadas que agrupan hasta 200 características priorizadas entre SNPs, CNVs, firmas de expresión y proteínas cuantificadas, acompañadas de metadatos clínicos y parámetros técnicos. Estas matrices deben ir acompañadas de un registro de los seeds aleatorios, parámetros de imputación, versiones de software, y métricas de calidad que permitan reproducir exactamente el dataset utilizado para el entrenamiento del modelo predictivo.

Sección 2: Marco de Optimización Bayesiana

Para la optimización bayesiana se emplea un proceso que utiliza un Proceso Gaussiano como modelo sustituto que aproxima la función desconocida que mapea las 200 características a la respuesta al fármaco. Cada perfil genotipo/fenotipo de paciente constituye un punto observado en el espacio, y la función de adquisición Upper Confidence Bound balancea exploración y explotación. Se implementa con bibliotecas de Python y se definen los hiperparámetros de la GP, el kernel RBF y el parámetro de exploración. El proceso se documenta con las semillas aleatorias usadas en cada iteración para reproducibilidad.

Sección 3: Integración multi-ómica y ponderación dinámica

La integración dinámica de capas omics utiliza una metodología híbrida Shapley-AHP. Los valores de Shapley calculan la contribución marginal de cada capa de datos al rendimiento predictivo, asegurando una ponderación justa. AHP incorpora la experiencia clínica para ajustar pesos según la relativa importancia percibida de genómica, transcriptómica y proteómica en la predicción de la respuesta antipsicótica. Esta combinación mitiga sesgos y alinea el modelo con la práctica clínica.

Sección 4: Validación y métricas de rendimiento

La validación se realiza mediante validación cruzada de 5 pliegues sobre una cohorte simulada de 500 pacientes con esquizofrenia tratados con distintos antipsicóticos. Las métricas incluyen AUC-ROC para la discriminación en modelos binarios o ranking de eficacia, MAE para diferencias en variables continuas como reducción de PANSS y PPV para valorar la probabilidad de respuesta en pacientes predichos como respondedores. El análisis se ejecuta con scikit-learn y statsmodels. Además, se monitorizan curvas de calibración y métricas de decisión clínica para estimar impacto real en la práctica.

Sección 5: Hoja de ruta de escalabilidad a medio y largo plazo

A corto plazo se planifica un piloto en 2-3 centros clínicos, focalizado en risperidona y olanzapina e incorporando datos longitudinales de tratamiento. A medio plazo se ampliará la cobertura a más antipsicóticos y se desarrollará una plataforma cloud para accesibilidad, integrando datos en tiempo real desde historias clínicas electrónicas. A largo plazo se explora un sistema de bucle cerrado con ajustes de dosis mediante IA y la integración de wearables para monitorización continua.

Sección 6: Elementos de aleatoriedad y reproducibilidad

Se incluyen elementos aleatorios controlados mediante semillas R1 a R12 para mantener novedad y evitar predictibilidad, documentando todos los valores para permitir reconstrucción exacta de cada iteración del modelo. Estas semillas afectan selección de SNPs, radios iniciales de exploración, hiperparámetros del kernel y rangos de ponderación en AHP.

Comentario final sobre impacto clínico y tecnológico

El enfoque propuesto aborda la necesidad de personalizar tratamientos en psiquiatría, reduciendo la dependencia del ensayo y error. La integración de multi-ómica y la optimización bayesiana prometen mejorar la precisión de la selección terapéutica, reducir reacciones adversas y disminuir costes asociados a tratamientos ineficaces.

Acerca de Q2BSTUDIO y servicios complementarios

Q2BSTUDIO es una empresa de desarrollo de software y aplicaciones a medida especializada en soluciones tecnológicas que combinan investigación avanzada con despliegue industrial. Ofrecemos servicios de software a medida y desarrollo de aplicaciones a medida orientadas a la salud y al sector biotecnológico, con experiencia en inteligencia artificial, ia para empresas y agentes IA que facilitan decisiones clínicas y operativas. Implementamos arquitecturas seguras para datos sensibles y contamos con servicios de ciberseguridad y pentesting para proteger información crítica. Para proyectos que requieren infraestructura escalable ofrecemos servicios cloud aws y azure y arquitecturas gestionadas que permiten procesar flujos omics a escala. Además proveemos servicios inteligencia de negocio y Power BI para visualización y adopción de insights clínicos y operacionales.

Si desea conocer más sobre nuestros servicios de inteligencia artificial consulte nuestra página de IA en Q2BSTUDIO: soluciones de inteligencia artificial y para desarrollo de aplicaciones y software a medida visite nuestra landing de aplicaciones multiplataforma: desarrollo de aplicaciones y software a medida. Trabajamos proyectos llave en mano que integran modelos predictivos, integración con EHR, despliegue en nube y paneles de control con Power BI para reporting clínico y operativo.

Palabras clave y posicionamiento

Aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA y power bi son términos integrados en nuestra oferta para maximizar el valor de los proyectos y mejorar el posicionamiento web y la captación de clientes interesados en soluciones tecnológicas avanzadas para salud y empresa.

Conclusión

Este marco de integración multi-ómica y optimización bayesiana representa un avance significativo hacia la medicina personalizada en psiquiatría. La combinación de técnicas robustas de preprocesado, selección de características, modelos probabilísticos y una estrategia de ponderación clínicamente informada ofrece un camino viable para transformar la elección de fármacos antipsicóticos. Q2BSTUDIO aporta experiencia en la implementación productiva de estas soluciones a través de software a medida, servicios cloud aws y azure, inteligencia artificial y ciberseguridad, facilitando la transición desde la investigación hacia aplicaciones clínicas seguras y escalables.

Comentarios