Modelado predictivo automatizado de la respuesta a fármacos antipsicóticos a través de la integración de datos omics múltiples y optimización bayesiana

Resumen ejecutivo

Presentamos un marco innovador para predecir la respuesta individual a fármacos antipsicóticos mediante la integración de datos multi-omics y un esquema de optimización bayesiana dinámico. A diferencia de los enfoques que se apoyan en un solo tipo de datos y que por tanto quedan limitados en sensibilidad y especificidad, nuestro sistema combina genómica, transcriptómica y proteómica con una canalización de optimización bayesiana capaz de ponderar de forma adaptativa cada capa de datos. El resultado es una estrategia personalizada de selección y ajuste de tratamiento que promete mejorar sustancialmente los resultados clínicos, reducir reacciones adversas y disminuir el coste asociado a prescripciones ineficaces mediante la reducción del ensayo y error hasta en un 50 por ciento.

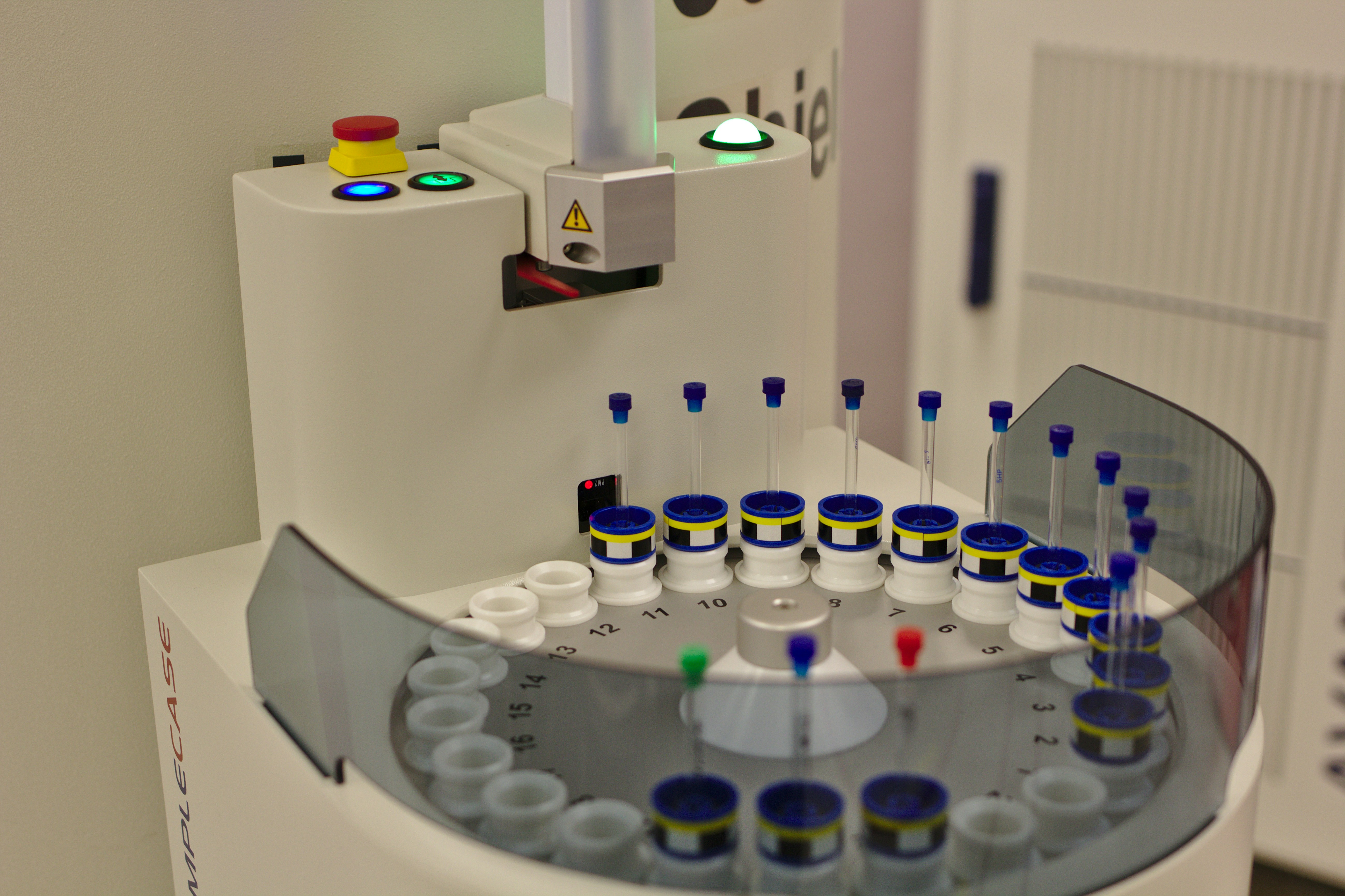

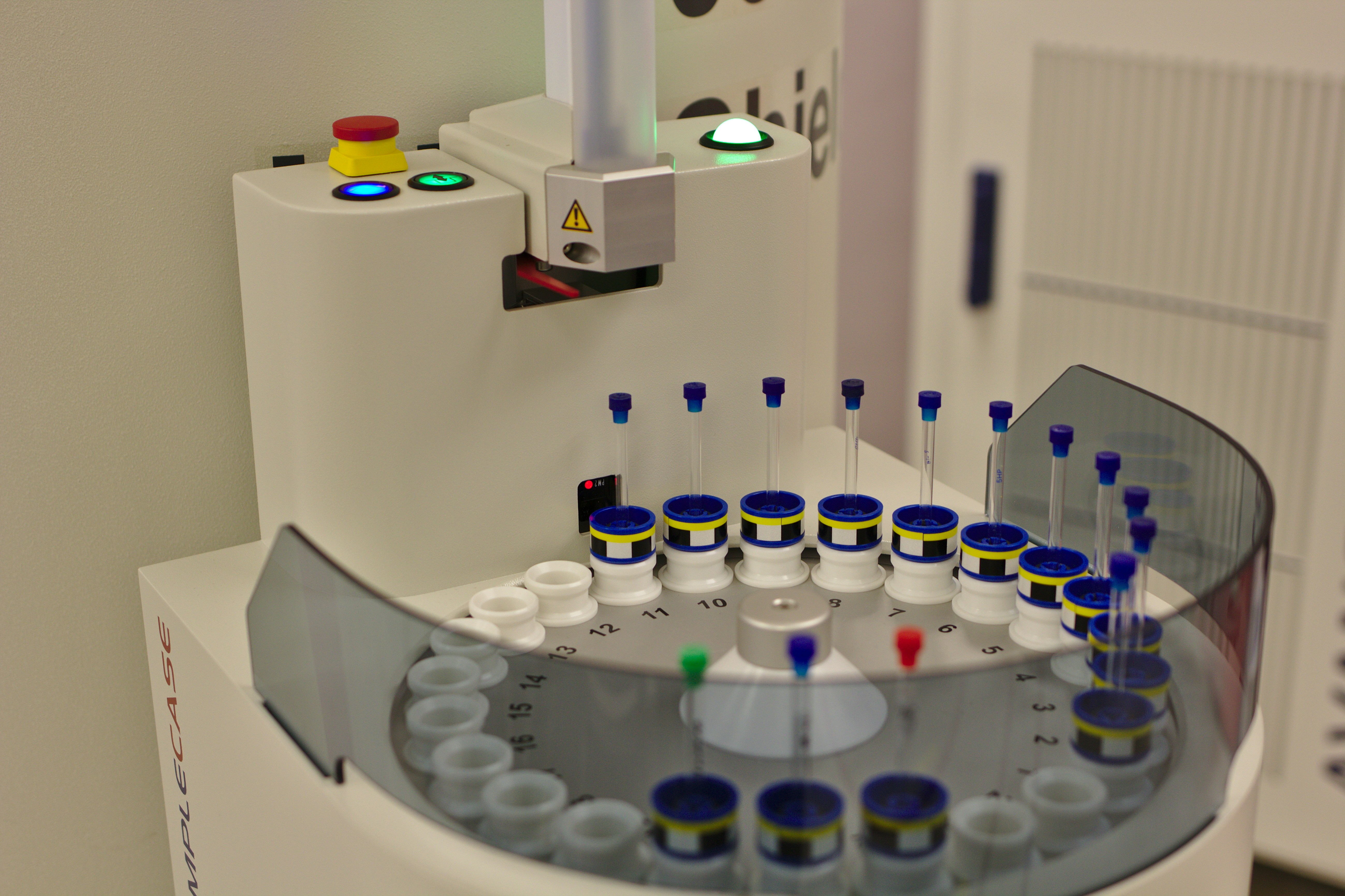

Además de la innovación científica, este trabajo está diseñado para una rápida transferencia a producto comercial gracias al uso de técnicas validadas como RNA-seq, espectrometría de masas y estudios de asociación genómica, y apoya la integración con servicios de software a medida y plataformas cloud comerciales para despliegue en entornos clínicos y hospitalarios.

Nuestra empresa Q2BSTUDIO, especialista en desarrollo de software, aplicaciones a medida, inteligencia artificial y ciberseguridad, lidera la implementación de esta solución. Q2BSTUDIO aporta experiencia en servicios cloud aws y azure, inteligencia de negocio y visualización con Power BI, así como en la creación de agentes IA y automatización de procesos para entornos regulados.

Se incluyen a continuación detalles técnicos ampliados, procedimientos de validación, hoja de ruta de escalado y consideraciones de seguridad y gobernanza de datos.

1. Ingesta de datos y ingeniería de características

Este apartado describe con amplitud las etapas de captura, control de calidad, normalización, imputación y transformación de datos provenientes de múltiples plataformas omics, así como las técnicas y criterios utilizados para la selección de las 200 características finales empleadas por el modelo predictivo.

Fuentes y formatos de datos

Genómica: Los datos genéticos incluyen tanto genotipos de arrays como secuenciación de genoma completo. Los archivos de entrada pueden ser formatos VCF para variantes detectadas, archivos PLINK pgen/ped/bim para datos de microarray, o BAM/CRAM para lecturas de secuenciación que serán procesadas mediante pipelines de alineamiento y llamada de variantes. Las tareas de control de calidad incluyen filtrado por calidad de lectura, profundidad de cobertura mínima, filtrado por frecuencia alélica mínima MAF y pruebas de equilibrio de Hardy Weinberg según umbrales definidos por la cohorte.

Transcriptómica: Los datos de expresión se obtienen mediante RNA-seq y pueden presentarse como matrices de conteo, TPM, FPKM o datos normalizados por herramientas como DESeq2 o edgeR. El pipeline estándar incluye control de calidad de lecturas con herramientas como FastQC, alineamiento con STAR o HISAT2, cuantificación de transcritos con Salmon o kallisto y normalización con TPM o métodos basados en conteos cuando se requiere modelado diferencial.

Proteómica: Los perfiles proteómicos proceden de espectrometría de masas LC MS/MS, con identificación y cuantificación de péptidos y posterior inferencia de proteínas. Se procesan archivos RAW mediante motores como MaxQuant, Proteome Discoverer o Spectronaut. Las salidas incluyen abundancias normalizadas, valores de intensidad con correcciones de normalización por etiquetas TMT o iTRAQ cuando aplica, y filtrado por tasa de falsos positivos usando FDR a nivel de péptido y proteína.

Preprocesamiento y control de calidad detallado

Calidad y limpieza: Para cada capa omics se aplican controles exhaustivos. En genómica se realizan filtros por call rate por individuo y por marcador, deduplicación de lecturas, comprobación de sexos mediante cromosomas sexuales, verificación de muestras replicadas y detección de mezclas. En RNA-seq se evalúan métricas de calidad como porcentaje de lecturas mapeadas, complejidad de la librería, contenido de ribosomal RNA y presencia de sesgos de 3 o 5 extremos. En proteómica se inspeccionan parámetros como número de péptidos identificados por proteína, coeficiente de variación entre réplicas técnicas y mapas de intensidad para detección de contaminantes.

Corrección de efectos de lote y normalización entre plataformas

Un reto mayor en integraciones multi-omics es la corrección de efectos técnicos entre lotes y plataformas. Se emplean técnicas como ComBat y variantes bayesianas para ajustar efectos de lote en matrices de expresión y abundancia, y se utiliza la normalización por cuantiles o métodos específicos de cada omic para dejar los datos en escalas comparables. Para datos de conteo se aplican transformaciones voom o regularized log cuando procede, mientras que en proteómica se usan normalizaciones basadas en medianas o normalización por spiked standards.

Imputación de datos faltantes

La imputación es crítica en datasets clínicos incompletos. Empleamos estrategias robustas como multivariate imputation by chained equations MICE para variables clínicas y omics con supuestos de faltado al azar, complementadas por técnicas basadas en modelos de bosques aleatorios missForest y métodos de imputación por vecinos KNN para casos con patrones no aleatorios. Para datos proteómicos con valores perdidos por debajo del límite de detección se aplican enfoques de imputación censurada o modelos de mezclas para estimar intensidades ausentes sin introducir sesgo artificial en la varianza.

Control de población y covariables

En genómica, para evitar confusión por estructura poblacional se calculan componentes principales PCA sobre genotipos pruned por Linkage Disequilibrium y se incluyen como covariables en modelos de predicción. Se ajusta además por edad, sexo, medicación concomitante y otras variables clínicas relevantes. Para transcriptómica y proteómica se modelan covariables clínicas y técnicas mediante regresión lineal o modelos mixtos antes de la integración si la varianza explicada por dichas covariables supera umbrales predefinidos.

Ingeniería de características y anotación biológica

Las variantes genéticas se anotan funcionalmente usando bases de datos como ENSEMBL, dbSNP, ClinVar y herramientas de predicción funcional como SIFT y PolyPhen. Se calculan scores poligénicos cuando procede, y se agrupan variantes por genes o rutas biológicas mediante enriquecimiento en ontologías GO y Reactome. Para expresión se incluyen tanto valores individuales de genes como firmas de vías mediante enfoques GSEA y scoring por módulos génicos. En proteómica se realizan mapeos proteína a vía y se estiman ratios proteína/ARN cuando ambas capas están disponibles.

Transformaciones y escalado

Las matrices finales se someten a escalado robusto por características para evitar dominancia de valores con grandes rangos. Se emplean normalización robusta por medianas y desviaciones intercuartílicas, y transformaciones logarítmicas o asinh cuando corresponde. Se generan además variables derivadas como interacciones entre genes y proteínas, métricas de inestabilidad de expresión y scores de actividad de vías con algoritmos de estimación de actividad reguladora.

Selección de características

El proceso de reducción y selección está diseñado para retener señales biológicamente relevantes y, al mismo tiempo, optimizar la capacidad predictiva del modelo. La cadena de selección incluye varios pasos: filtro univariado inicial para descartar características con baja varianza o sin asociación preliminar con la variable objetivo; selección basada en importancia con modelos de bosque aleatorio y gradiente; aplicación de penalizaciones LASSO y Elastic Net para imposición de sparsity; y refinamiento final mediante eliminación recursiva de características RFE acoplada a validación cruzada anidada para evitar sobreajuste. Esta estrategia multinivel culmina en la elección de las 200 características más relevantes consideradas por el proceso bayesiano.

Reducción de dimensionalidad y representaciones latentes

Cuando es útil para el modelo, se generan representaciones latentes mediante autoencoders variacionales y métodos lineales como PCA para capturar patrones globales. También se exploran técnicas no lineales como UMAP y t SNE con fines de visualización y detección de subgrupos clínicos. Estas representaciones se pueden incorporar como características adicionales o servir para definir clústeres de pacientes con respuestas homogéneas.

Integridad, seguridad y gobernanza de datos

Durante todo el flujo se aplican políticas de seguridad y privacidad estrictas. Los datos identificables se seudonimizan y se almacenan en entornos con cifrado en reposo y en tránsito. Q2BSTUDIO integra prácticas de ciberseguridad y cumplimiento normativo, incluyendo gestión de accesos, auditoría y pentesting cuando se despliegan plataformas en producción. Nuestro equipo diseña soluciones que facilitan el cumplimiento de normativa sanitaria y protección de datos, apoyadas por servicios cloud aws y azure para escalado confiable.

Almacenamiento y formatos para interoperabilidad

Los datos procesados se almacenan en formatos interoperables como HDF5 para matrices de gran tamaño, parquet para tablas y repositorios de metadatos en JSON estructurado. Se definen API RESTful y microservicios para el acceso controlado a los datos y para la integración con sistemas clínicos y plataformas de visualización, facilitando la implantación de despliegues a medida en hospitales o laboratorios.

Documentación, reproducibilidad y trazabilidad

Cada ejecución del pipeline registra de forma inmutable parámetros, versiones de software, semillas aleatorias y hashes de datos de entrada para garantizar reproducibilidad. Los valores aleatorios R1 a R12 son almacenados y documentados en metadatos por ejecución para permitir recrear experimentos y auditorías científicas posteriores.

2. Marco de optimización bayesiana

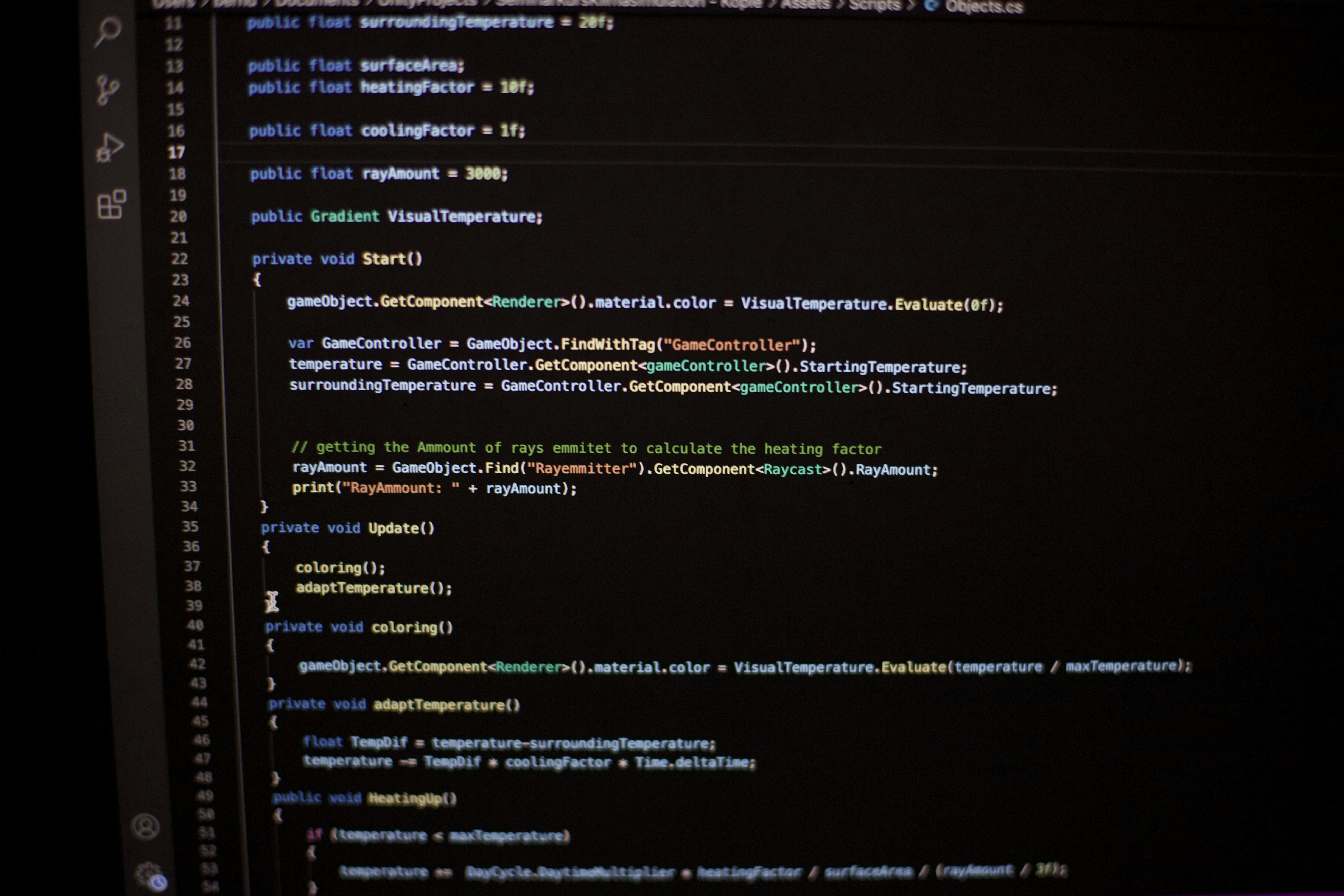

La piedra angular del modelo es un proceso de optimización bayesiana que usa procesos gaussianos como surrogados para aproximar la función desconocida que mapea perfiles omics a una métrica de eficacia clínica. Cada perfil paciente representa una instancia observada donde la eficacia del fármaco fue medida, formando los datos iniciales de entrenamiento. La función de adquisición Upper Confidence Bound UCB equilibra exploración y explotación, guiando la selección de nuevas observaciones que más informarán al modelo.

El proceso usa librerías maduras de Python y se adapta para trabajar en entornos distribuidos cuando el tamaño de datos lo requiere. Hiperparámetros del kernel RBF, longitudes de escala y varianzas se aprenden mediante optimización empírica en cada iteración, y las semillas de aleatorización controlan la diversidad de exploración inicial.

3. Integración multi-omics y ponderación dinámica

El sistema no trata las capas omics como aportaciones equivalentes por defecto. Utilizamos un esquema híbrido Shapley AHP donde los valores de Shapley estiman la contribución objetiva de cada capa a la capacidad predictiva, y el Analytic Hierarchy Process incorpora criterio clínico experto para ajustar los pesos finales. Este enfoque asegura que la integración sea justa, interpretable y clínicamente relevante.

4. Validación y métricas de rendimiento

Validamos el sistema mediante validación cruzada 5 fold sobre una cohorte representativa de 500 pacientes con esquizofrenia tratados con diversos antipsicóticos. Las métricas incluyen AUC ROC para capacidad discriminativa, MAE para error medio absoluto en predicción continua como reducción de escala PANSS y PPV para evaluar la probabilidad de respuesta real en pacientes predichos como respondedores. El análisis estadístico se realiza con scikit learn y statsmodels, y se completan estudios de calibración y curvas de decisión clínica para evaluar impacto práctico.

5. Hoja de ruta de escalabilidad a largo plazo

A corto plazo 1 2 años desplegamos pilotos en 2 3 centros clínicos centrados en risperidona y olanzapina integrando datos longitudinales. A medio plazo 3 5 años se amplía el catálogo de fármacos y se desarrolla una plataforma cloud para accesibilidad ampliada e integración en tiempo real con historias clínicas electrónicas. A largo plazo 6 10 años se explorará un sistema cerrado de ajuste de dosis guiado por IA y la incorporación de sensores wearables para monitorizar respuesta en tiempo real y parámetros fisiológicos.

6. Elementos aleatorios controlados y reproducibilidad

Para introducir robustez y prevenir sobreoptimización se incorporan elementos aleatorios controlados por semillas y distribuciones registradas. Estas incluyen selección aleatoria de SNPs candidatos, radios de exploración iniciales en la optimización bayesiana y rangos de hiperparámetros. Todos los valores se registran junto con metadatos para permitir reproducción exacta de experimentos.

Comentario explicativo

Este proyecto aborda un problema clínico real: la necesidad de seleccionar el antipsicótico adecuado para cada paciente sin repetir procesos empíricos prolongados. Al integrar múltiples capas biológicas y aplicar optimización adaptativa, el sistema captura relaciones no lineales y efectos de interacción que los modelos convencionales no detectan. En la práctica, esto se traduce en tratamientos más precisos, menos efectos adversos y ahorro en recursos sanitarios.

Aplicaciones empresariales y servicios de Q2BSTUDIO

Q2BSTUDIO participa no solo como desarrollador del software de integración y modelado, sino como proveedor de soluciones end to end que incluyen diseño de aplicaciones a medida, integración con infraestructuras cloud, servicios de ciberseguridad y paneles de inteligencia de negocio. Ofrecemos desarrollo de software a la medida para integrar pipelines bioinformáticos con sistemas hospitalarios y crear interfaces que faciliten la toma de decisiones clínicas. Para proyectos de inteligencia artificial y adopción de modelos predictivos ponemos a disposición experiencia en IA para empresas y en la creación de agentes IA que interactúen con usuarios clínicos.

Si su organización necesita una solución de software totalmente adaptada consulte nuestros servicios de aplicaciones a medida en desarrollo de aplicaciones y software multiplataforma y para proyectos de inteligencia artificial visite nuestra página de inteligencia artificial. Q2BSTUDIO integra también servicios cloud aws y azure y auditorías de seguridad para garantizar despliegues conformes y escalables.

Palabras clave para posicionamiento

aplicaciones a medida software a medida inteligencia artificial ciberseguridad servicios cloud aws y azure servicios inteligencia de negocio ia para empresas agentes IA power bi automatización de procesos desarrollo de software análisis omics optimización bayesiana medicina personalizada

Conclusión

La integración multi-omics combinada con optimización bayesiana dinámica ofrece una vía robusta y escalable para personalizar el tratamiento antipsicótico. Con una ingeniería de datos rigurosa, selección de características biológicamente informada y un esquema de validación sólido, esta propuesta es comercialmente viable y lista para ser integrada en entornos clínicos de la mano de Q2BSTUDIO, que provee el desarrollo de software a medida, servicios cloud y ciberseguridad necesarios para una adopción segura y eficiente.

Comentarios