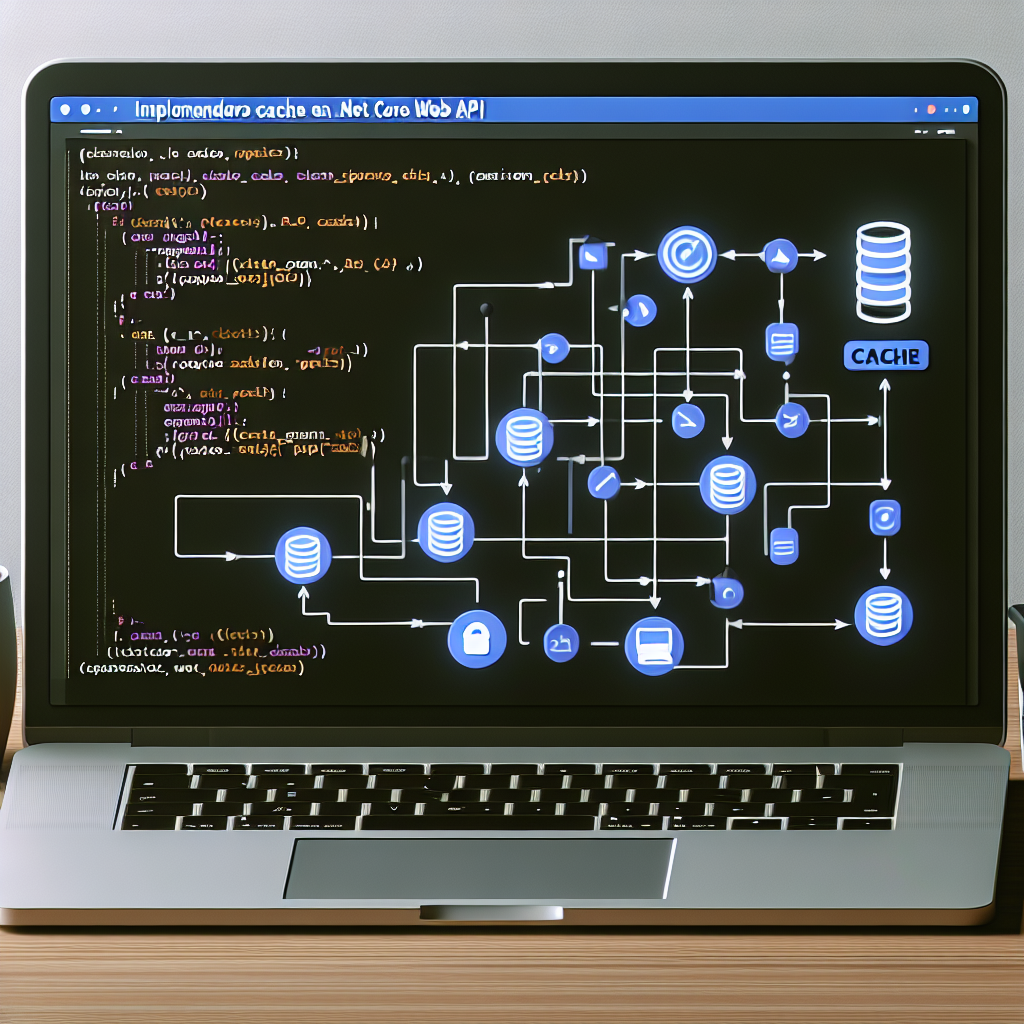

Implementando caché en .NET Core Web API

Implementando caché en .NET Core Web API: mejorar rendimiento y escalabilidad explicando opciones prácticas para Response Caching, caché en memoria e implementación distribuida.

El caché es una de las técnicas más efectivas para reducir la carga sobre la base de datos, acelerar tiempos de respuesta y soportar mayor tráfico sin degradar la experiencia del usuario. En entornos de APIs en .NET Core conviene elegir la estrategia adecuada según la arquitectura: caché de respuesta para clientes, caché en memoria para una sola instancia y caché distribuido para entornos con balanceo de carga.

Respuesta de caché: Response Caching permite que respuestas de la API sean almacenadas y reutilizadas durante un periodo definido. En .NET Core se habilita con AddResponseCaching y UseResponseCaching en Program.cs y se controla por ejemplo con el atributo ResponseCache en los controladores. Es ideal para recursos públicos y datos que cambian poco, ya que reduce ancho de banda y mejora la latencia percibida por el cliente.

Caché en memoria: IMemoryCache almacena información en la memoria del servidor y es muy rápido para lecturas repetidas dentro de una misma instancia. Se registra con AddMemoryCache y se inyecta IMemoryCache en los controladores. Conviene definir políticas de expiración absoluta y deslizante, limitar el tamaño de entradas y manejar la invalidez cuando los datos subyacentes cambian para evitar servir información desactualizada.

Caché distribuido: Para arquitecturas con múltiples instancias es recomendable usar un caché fuera de la aplicación, por ejemplo Redis. En .NET Core se puede integrar con AddStackExchangeRedisCache apuntando a la instancia Redis y usando IDistributedCache para GetStringAsync y SetStringAsync. El caché distribuido permite coherencia entre instancias, facilita el escalado horizontal y es compatible con soluciones en la nube como AWS y Azure.

Buenas prácticas: definir Time to Live adecuados, evitar cachar datos sensibles sin cifrado, invalidar o actualizar cachés tras operaciones de escritura, usar compresión o serialización eficiente para valores grandes, y monitorizar hits y misses para ajustar políticas. Además considerar qué datos son aptos para caché por su naturaleza y frecuencia de cambio.

Casos de uso: almacenar catálogos o listados que cambian poco, resultados de consultas caras, respuestas de servicios externos con límites de tasa, y materializar vistas para operaciones de inteligencia de negocio o Power BI. Integrar caché con servicios cloud mejora fiabilidad y permite usar características gestionadas como snapshots y persistencia.

En Q2BSTUDIO somos una empresa de desarrollo de software que crea aplicaciones a medida y software a medida, especialistas en inteligencia artificial y ia para empresas, con experiencia en ciberseguridad, agencias de IA y agentes IA. Ofrecemos servicios cloud aws y azure para desplegar soluciones escalables y seguras, además de servicios inteligencia de negocio y power bi para explotar los datos de manera estratégica. Si necesitas desarrollar una API escalable con caché integrado y soluciones a medida visita nuestros servicios de desarrollo de aplicaciones y software a medida y para opciones de despliegue en la nube revisa Servicios cloud AWS y Azure.

Resumen: Response Caching para caché en el cliente, IMemoryCache para caching rápido en una sola instancia y Redis o equivalente para un caché distribuido. Implementando estas técnicas correctamente se reduce la carga en bases de datos, se mejora la experiencia de usuario y se habilita escalado eficiente de APIs en .NET Core Web API.

Comentarios