Guía de un desarrollador senior para el Protocolo de Contexto del Modelo

Estamos presenciando una crisis de fragmentación en el ecosistema de inteligencia artificial que hace imprescindible replantear cómo conectamos modelos, interfaces y datos. El Protocolo de Contexto del Modelo MCP transforma esta realidad. MCP actúa como un puerto universal para agentes IA, un equivalente arquitectural al USB C para inteligencia artificial, y permite que un servidor estándar funcione con cualquier cliente compatible sin reescribir integraciones cada vez que cambiamos de proveedor o de interfaz.

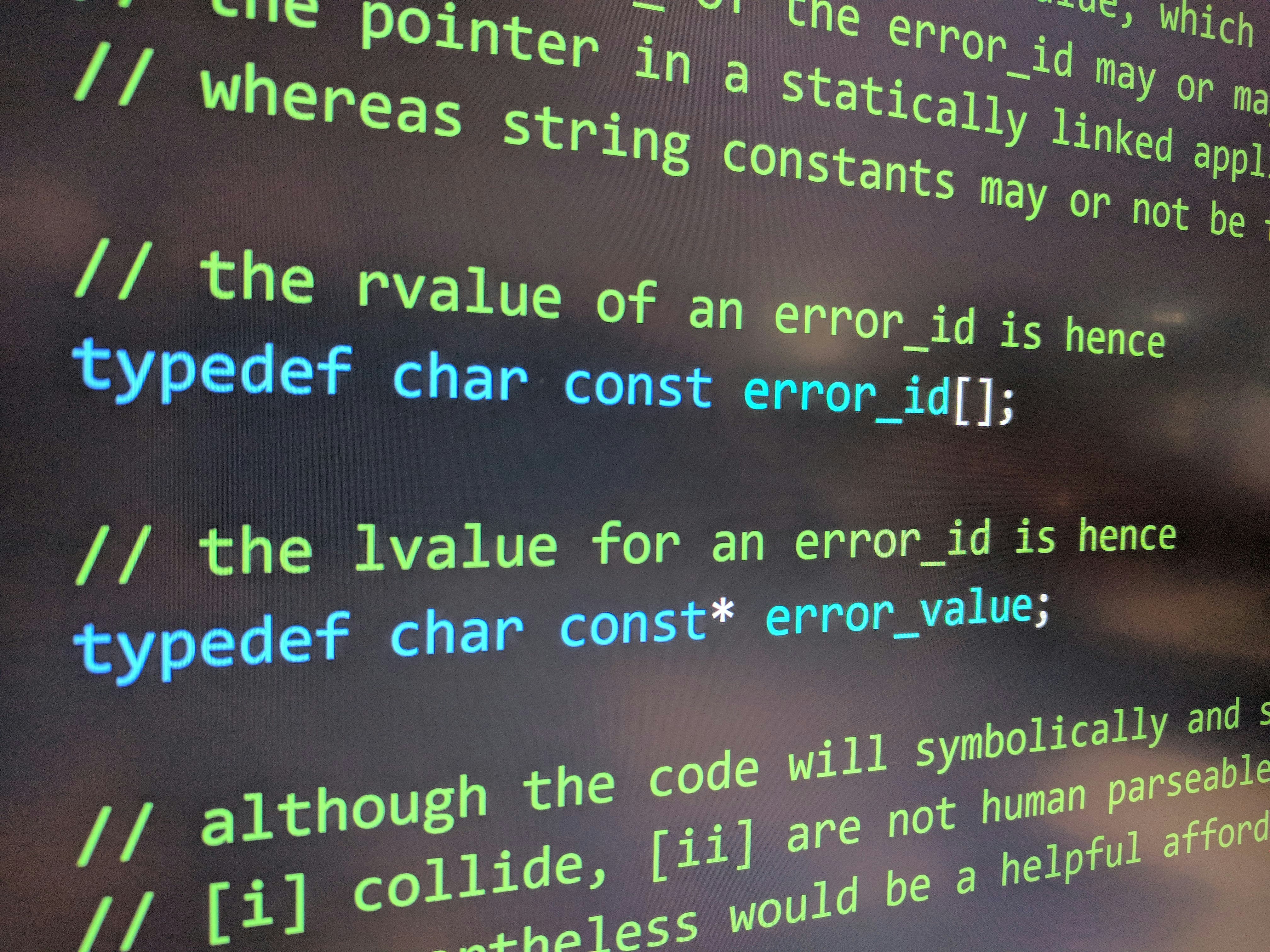

Tradicionalmente los modelos de lenguaje grande funcionaban como cerebros en un frasco: poderosos para predecir tokens pero carentes de manos, ojos y memoria persistente. La técnica de Function Calling intentó cubrir esa carencia mediante llamadas a APIs externas que la aplicación ejecutaba, pero las APIs no están diseñadas para modelos de lenguaje y exigen headers, autenticación y parámetros rígidos que se rompen con cada cambio. MCP introduce una capa de abstracción que envuelve fuentes de datos y servicios y los expone en un formato optimizado para consumo por LLMs, habilitando el descubrimiento dinámico: cuando un cliente MCP se conecta a un servidor MCP solicita la lista de herramientas y recursos y recibe descripciones, plantillas de prompt y capacidades de ejecución sin que el host necesite código adicional.

Arquitectónicamente MCP separa el sistema en tres pilares que todo arquitecto senior debe comprender: el Host, el Server y la Capa de Transporte. El Host es la aplicación donde interactúa el usuario, por ejemplo un IDE o una app de escritorio. En su interior existe un Cliente MCP que mantiene la conexión y enruta solicitudes. El Server es la capa de abstracción que los desarrolladores construyen para registrar herramientas ejecutables, recursos de solo lectura y plantillas de prompt reutilizables. La Capa de Transporte define cómo se comunican Host y Server: stdio para despliegues locales mediante procesos hijos y JSON RPC, o conexiones tipo SSE sobre HTTP para servidores remotos que necesitan streaming asíncrono y tareas de larga duración.

Dentro del Server las tres capacidades principales son Tools ejecutables, Resources para datos solo lectura y Prompts dinámicos que guían el comportamiento del modelo. Un detalle crucial es escribir descripciones ricas y precisas de cada herramienta: el LLM decide cuándo invocarlas en base a esas descripciones, no por nombres de función crípticos.

Un aspecto práctico y económico es la estrategia del System Prompt. Muchos ingenieros tienden a sobrecargar el system prompt con reglas extensas, pero cada token allí genera latencia y coste. En lugar de eso, en MCP es mejor comenzar con un system prompt mínimo y confiar en las descripciones y el esquema de las herramientas para dirigir el modelo. Si aparece un fallo concreto, se añade iterativamente una restricción puntual. La optimización real proviene de definir bien las herramientas, no de llenar el prompt del sistema.

Pasos para implementar un servidor MCP: preparar el entorno y dependencias, definir la lógica del servidor registrando nombre y versión, decorar funciones como Tools con docstrings detallados, exponer Resources con URIs adecuados y configurar el transporte para que el Host pueda descubrir el servidor mediante un archivo de configuración. Para desarrollo local stdio es rápido y fácil de depurar; para despliegue en la nube conviene usar HTTP con SSE para streaming. Utiliza la herramienta Inspector MCP para probar manualmente las herramientas, visualizar logs y depurar las llamadas JSON RPC antes de desplegar en producción.

Los flujos avanzados muestran el verdadero poder de MCP. Plataformas como n8n pueden actuar como cliente y servidor MCP a la vez, permitiendo encapsular un workflow visual en una sola Tool accesible por el LLM. Esto facilita automatizaciones complejas sin costes elevados por conectores de terceros. Herramientas visuales como Flowise integradas con LangChain permiten usar MCP para mejorar pipelines de RAG y garantizar frescura de datos al combinar búsquedas vectoriales con llamadas en tiempo real a fuentes actualizadas.

Con el poder viene la responsabilidad. La superficie de ataque se amplía cuando un servidor MCP expone el sistema de archivos, repositorios privados o bases de datos. Surge la amenaza del Tool Poisoning: datos manipulados pueden inyectar payloads que ordenen al agente realizar acciones dañinas si el servidor tiene permisos de escritura y lectura. Para mitigar riesgos recomendamos patrones de seguridad claros: exigir confirmación humana para acciones que modifican estado, aplicar principio de menor privilegio evitando accesos holísticos al root, y preferir recursos read only por defecto.

La adopción de MCP genera un efecto red importante. Hoy existen miles de servidores MCP públicos y la comunidad está adaptando servicios desde modelado 3D hasta geolocalización. Construir una integración interna como servidor MCP no solo la habilita para clientes actuales como Claude o Cursor sino para futuros clientes y frameworks aún por aparecer. En lugar de reescribir wrappers API una y otra vez, conviene invertir en una única implementación estándar y reutilizable.

En Q2BSTUDIO como empresa de desarrollo de software y aplicaciones a medida nos especializamos en diseñar soluciones robustas que integran MCP en arquitecturas empresariales. Ofrecemos servicios de software a medida y aplicaciones a medida pensadas para explotar agentes IA con garantías de ciberseguridad y cumplimiento. Nuestro equipo combina experiencia en inteligencia artificial, ciberseguridad, servicios cloud aws y azure y servicios de inteligencia de negocio para ofrecer proyectos escalables orientados a resultados. Si su objetivo es desplegar agentes IA seguros y productivos podemos ayudar desde el diseño del servidor MCP hasta la integración con plataformas de automatización y BI como Power BI.

Si desea explorar cómo incorporar agentes IA a sus procesos productivos, conocer opciones de integración o desarrollar un servidor MCP a medida contacte a nuestro equipo para una consultoría técnica y estratégica. Con Q2BSTUDIO podrá aprovechar nuestras capacidades en servicios de inteligencia artificial y en desarrollo de software a medida garantizando seguridad, escalabilidad y alineación con objetivos de negocio.

Palabras clave integradas naturalmente para SEO: aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA, power bi.

Comentarios