Guía del desarrollador senior para el Protocolo de Contexto del Modelo

Estamos presenciando una crisis de fragmentación en el ecosistema de IA que obliga a repensar cómo conectamos modelos, interfaces y datos. Tradicionalmente se han tratado los grandes modelos de lenguaje como procesadores aislados y se han cosido integraciones a mano cada vez que cambia un servicio. El Protocolo de Contexto del Modelo MCP transforma ese paradigma y actúa como un puerto universal tipo USB-C para inteligencia artificial, permitiendo que un único servidor exponga herramientas, recursos y plantillas de prompt consumibles por cualquier cliente compatible sin reescribir integraciones.

Fragmentación y capas fundamentales El ecosistema se divide en tres capas: la capa lógica donde residen los LLM como Claude, GPT y Gemini; la capa de interfaz donde operan aplicaciones como Cursor, Windsurf o builders visuales; y la capa de datos que engloba bases de datos, archivos locales y APIs internas. Antes, habilitar que un LLM accediera a una base de datos implicaba crear llamadas de función rígidas y propensas a romperse al cambiar de proveedor o de entorno. MCP introduce una abstracción estandarizada que transforma las fuentes de datos en objetos optimizados para consumo por modelos, permitiendo descubrimiento dinámico y uso inmediato desde el host sin código pegamento.

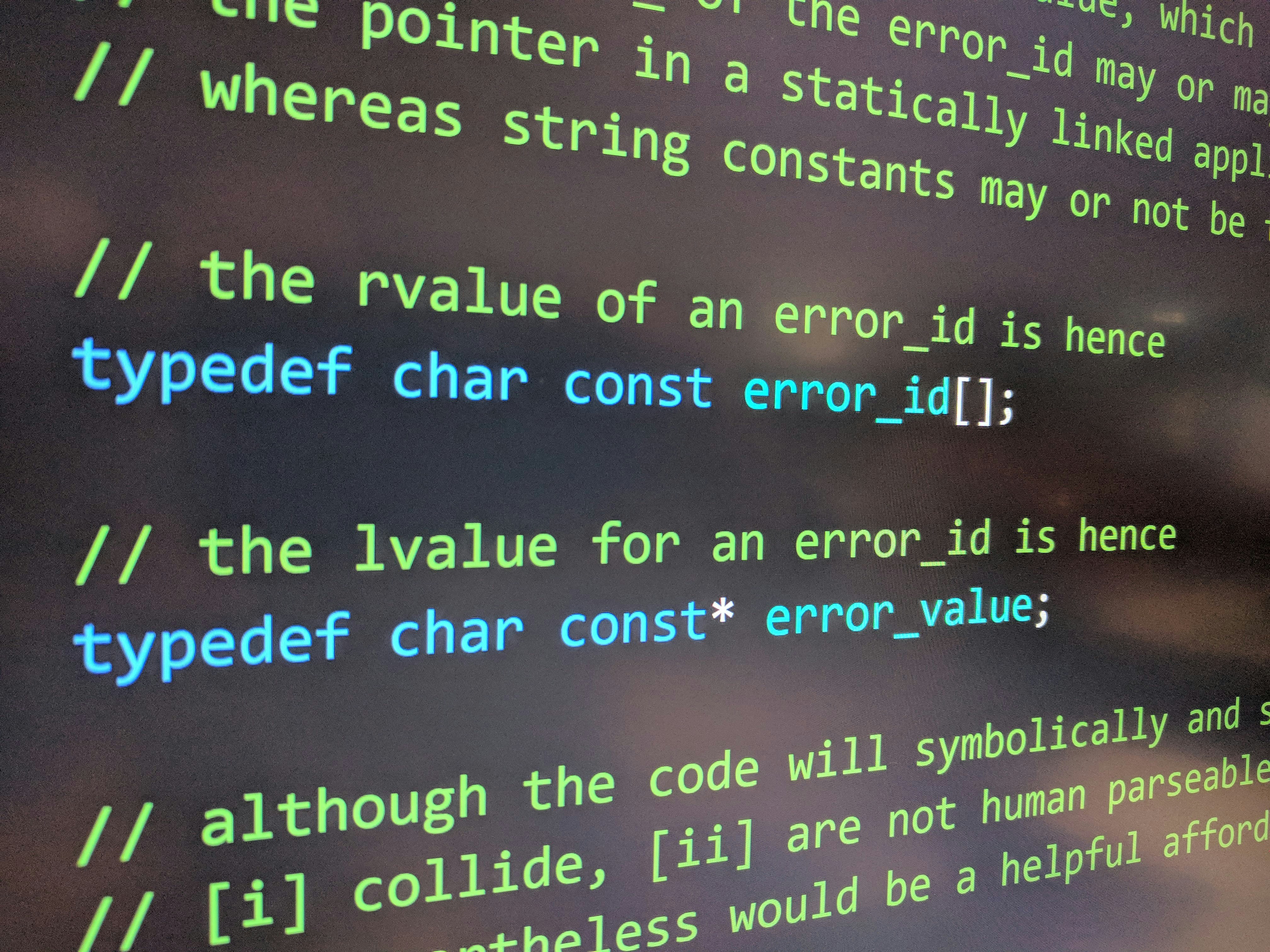

Qué expone un servidor MCP Un MCP Server no es un proxy ciego, es una capa semántica que define tres capacidades: herramientas ejecutables para acciones como redimensionar imágenes o consultar SQL; recursos de solo lectura como contenidos de ficheros o responses de APIs; y prompts reutilizables que guían el comportamiento del modelo. Estos tres tipos permiten que el cliente LLM conozca cuándo y cómo invocar capacidades externas de forma explícita y documentada.

Arquitectura en tres componentes 1 El Host es la aplicación de usuario donde se integra un MCP Client que mantiene la conexión y enruta las peticiones. 2 El Server es la implementación que registra herramientas, recursos y prompts y entrega definiciones ricas que los modelos usan para decidir acciones. 3 El Transport es la capa que comunica Host y Server; en local se usa stdio lanzando el servidor como subprocess para comunicación JSON RPC, y para despliegues remotos se usan HTTP streamable o Server Sent Events para permitir respuestas asíncronas en tareas de larga duración.

Por qué evitar prompts enormes en el sistema Los prompts de sistema largos suponen coste y latencia en cada turno conversacional. Muchos proveedores ya inyectan instrucciones robustas. En MCP la recomendación es empezar sin un prompt de sistema extenso y confiar en la definición de herramientas y recursos; sólo incorporar instrucciones adicionales iterativamente para corregir fallos concretos, por ejemplo forzar comprobación de fuentes o inyectar variables temporales para búsquedas en tiempo real.

Guía práctica para implementar un MCP Server Fase 1 Gestión de entorno y dependencias Utiliza gestores modernos y SDKs oficiales del protocolo; en Python herramientas ligeras como uv y el paquete mcp facilitan desarrollo y aislamiento. Fase 2 Definición de lógica Registra el servidor con nombre y versión, decora funciones como herramientas y proporciona descripciones ricas en los docstrings porque el modelo los utiliza para decidir. Registra recursos con esquemas URI para bases de datos y ficheros. Fase 3 Configuración del transporte No necesitas construir UI, el Host detecta servidores mediante un archivo de configuración local que indica comando y argumentos para spawnear el proceso via stdio. Fase 4 Depuración Usa un Inspector MCP que actúa como cliente intermedio para invocar herramientas manualmente, ver logs y traza JSON RPC antes de desplegar en producción.

Workflows avanzados y automatización real El protocolo brilla cuando se conecta con plataformas de automatización. Herramientas visuales como n8n pueden funcionar tanto como cliente como servidor MCP, permitiendo exponer flujos complejos compuestos como una sola herramienta accesible desde el LLM. Esto facilita integrar scraping, transformación y almacenamiento en una sola llamada. Para pipelines RAG, conectar MCP Tools desde visores como Flowise o agentes basados en LangChain permite decidir entre consultar un vector store estático para contexto histórico o llamar en tiempo real a una fuente viva para datos frescos, mejorando la frescura de la información sin reconstruir continuamente índices vectoriales.

Seguridad, cumplimiento y riesgo de envenenamiento de herramientas El mayor vector de ataque es el envenenamiento de herramientas: si un atacante introduce datos maliciosos en una fuente que el servidor MCP lee y el agente tiene capacidades de escritura, se pueden ejecutar acciones peligrosas por instrucción contenida en los datos. Buenas prácticas: incorporar confirmación humana para acciones que modifican estado, aplicar principio de menor privilegio limitando accesos a carpetas o bases necesarias y preferir recursos en modo solo lectura por defecto. Auditar logs y filtrar entradas de usuario en las capas de recurso reduce superficie de ataque.

Efecto red y adopción generalizada Muchas objeciones sobre complejidad de adopción ignoran el efecto red. Ya existen miles de servidores MCP públicos que envuelven servicios desde modelado 3D hasta mapas y productividad. Construir tus integraciones como servidores MCP hoy multiplica su valor porque no sólo sirven a un host sino a cualquier cliente futuro. En Q2BSTUDIO, empresa de desarrollo de software y aplicaciones a medida, ayudamos a transformar integraciones monolíticas en servidores MCP preparados para producción. Como especialistas en software a medida ofrecemos soluciones que integran inteligencia artificial con prácticas de ciberseguridad y despliegues cloud escalables.

Servicios y capacidades en Q2BSTUDIO Ofrecemos desarrollo de aplicaciones y software a medida para empresas que necesitan agentes IA productivos y seguros, integración con servicios cloud aws y azure y soluciones de inteligencia de negocio con Power BI. Si buscas potenciar tu organización con modelos y agentes IA para empresas, descubre nuestras propuestas de inteligencia artificial y consultoría técnica en servicios de inteligencia artificial. Para proyectos que requieren plataformas a medida y aplicaciones multiplataforma te invitamos a conocer nuestras capacidades en desarrollo de aplicaciones y software a medida.

Conclusión MCP es la evolución natural de la integración de IA: de puentes rígidos entre islas a un puerto universal que permite a cualquier agente tener manos y ojos sobre recursos empresariales. Adoptarlo reduce tiempo de mantenimiento, mejora la seguridad cuando se aplica con buenos controles y multiplica el valor por efecto red. Si tu organización necesita ayuda práctica para diseñar servidores MCP, integrar agentes IA o asegurar flujos con ciberseguridad y pentesting, en Q2BSTUDIO podemos acompañarte en todo el ciclo desde diseño hasta despliegue en cloud y monitorización continua.

Comentarios