Por qué AI ETL necesita diferentes primitivas: lecciones de la construcción de CocoIndex en Rust

Por qué AI ETL necesita diferentes primitivas: lecciones de la construcción de CocoIndex en Rust

Los pipelines ETL tradicionales se diseñaron para informes por lotes, no para sistemas de inteligencia artificial que requieren embeddings frescos, esquemas que cambian y comportamiento de modelos opaco. En entornos AI las suposiciones clásicas fallan: esquemas estables, transformaciones solo en SQL, ejecuciones de 'mejor esfuerzo' y procesos diarios ya no son suficientes.

El problema clave es que embeddings obsoletos provocan hallucinations. Si una base de conocimiento se actualiza cada 30 minutos pero tu sistema RAG usa embeddings de hace días, el modelo responderá sobre datos que ya no existen. Además los esquemas evolucionan constantemente: el código cambia, la documentación se actualiza y los formatos de tickets se transforman. Para AI eso no es una excepción, es la norma.

Otro reto es la naturaleza de las transformaciones: no todo es SQL. Hay llamadas a APIs de embeddings, chunking de documentos, ejecución de Python personalizado, y ruteo simultáneo a múltiples destinos como bases vectoriales, grafos y almacenes relacionales. Reprocesar todo el corpus cada vez significa costes altos, límites de tasa y reconstrucciones innecesarias que degradan el rendimiento de forma silenciosa.

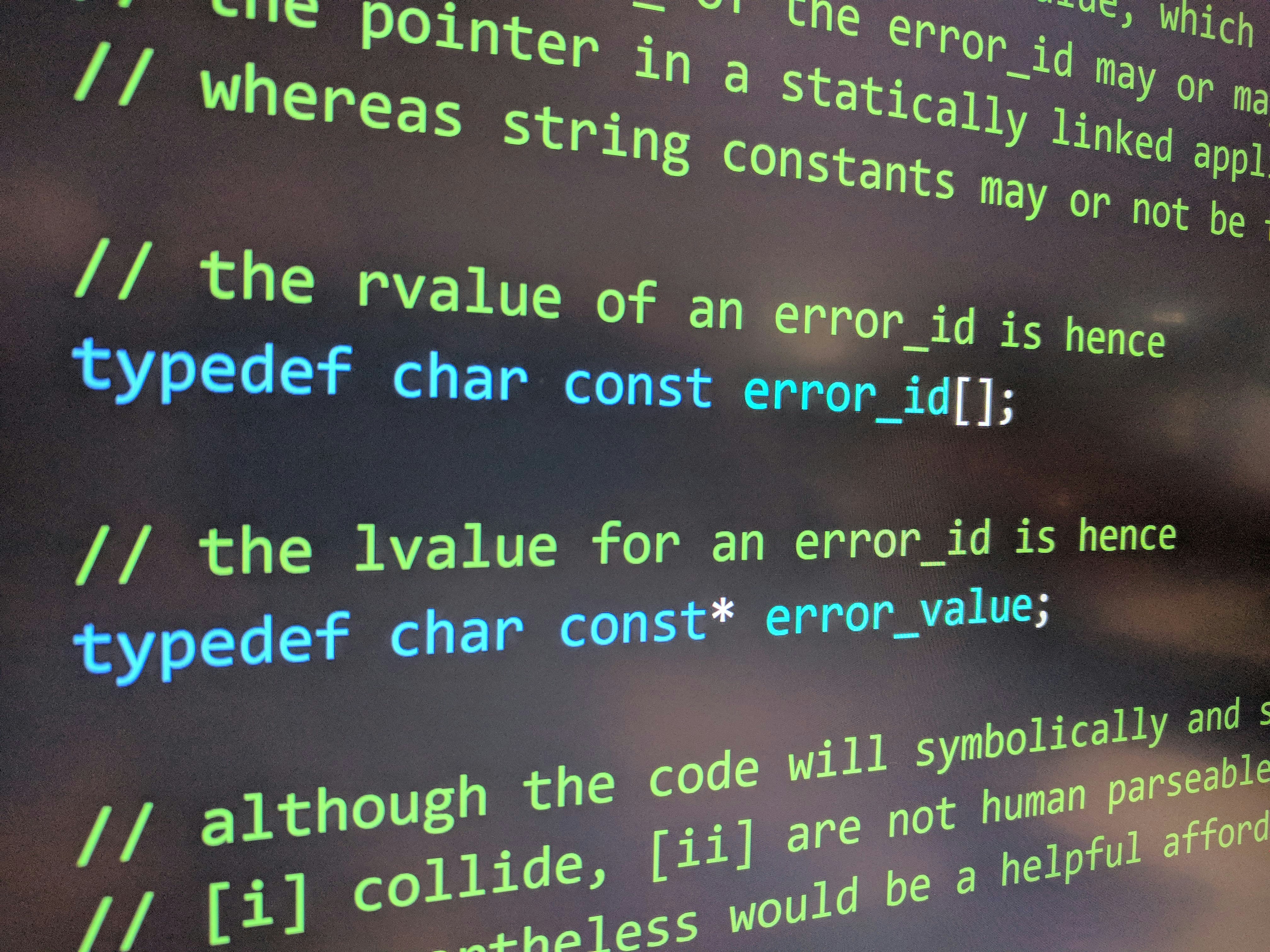

CocoIndex aborda ese salto de paradigma con cinco primitivas fundamentales. Primera: dataflow en lugar de tablas mutables. En vez de comandos imperativos insert update delete, se define un DAG de transformaciones donde cada nodo es una función pura. Entrada cruda parseado chunk embedding normalización y luego fan out hacia Vector DB Postgres y Graph. Ventajas: declarativo, cachable de forma segura, composicional e intuitivo como una hoja de cálculo donde cada campo es una fórmula.

Segunda: procesado incremental como ciudadano de primera clase. CocoIndex detecta cambios en dos niveles: a nivel fuente usa fingerprints para saltarse contenidos no modificados; a nivel flujo calcula qué partes del DAG son afectadas por una nueva transformación y recomputa solo esos nodos. Resultado: índices casi en tiempo real sin reconstrucciones completas.

Tercera: ejecución durable frente a APIs poco fiables. El motor incluye semánticas de reintento a nivel fila, commits conscientes de versión y manejo estable de errores para evitar datos inconsistentes entre destinos. Esto transforma la fiabilidad de un script endeble a un sistema con fallos,reintentos y seguimiento de progreso incorporados.

Cuarta: linaje y observabilidad. Cuando un resultado de búsqueda produce una mala respuesta necesitas saber qué documentos originaron ese chunk qué modelo de embedding se usó si la estrategia de chunking fue correcta y qué versión de la fuente se indexó. CocoIndex integra trazabilidad end to end y visibilidad antes y después de cada paso, con una interfaz tipo hoja de cálculo para inspección visual.

Quinta: conectividad multi destino nativa para AI. Las pilas de IA escriben en muchos sistemas: Qdrant o LanceDB para embeddings, Postgres o Snowflake para metadatos, grafos de conocimiento, y feature stores. CocoIndex trata cada destino como un socio de primer orden y sincroniza automáticamente un flujo lógico hacia todos ellos.

¿Por qué Rust Para escalar estas primitivas se necesita rendimiento predecible sin pausas de GC seguridad en la concurrencia y capacidad de interoperar con Python y TypeScript. Rust permite ejecuciones eficientes de detección incremental y servicios sin pérdidas de rendimiento, al mismo tiempo que mantiene una API accesible.

Qué significa esto para los equipos de IA Si sigues reconstruyendo índices completos cada día depurando fallos a base de grep o sincronizando manualmente Postgres Qdrant y feature stores estás operando con baja eficiencia y acumulando deuda técnica. La forma emergente del AI ETL es continua y consciente de fingerprints declarativa y observable con linaje end to end sincronización multi destino ejecución durable y herramientas nativas de depuración.

En Q2BSTUDIO entendemos estos retos y ayudamos a empresas a transformar sus pipelines de datos y modelos. Somos una empresa de desarrollo de software especializada en aplicaciones a medida y software a medida con experiencia en inteligencia artificial, ia para empresas, agentes IA y servicios inteligencia de negocio. Diseñamos soluciones que integran servicios cloud aws y azure, plataformas analíticas basadas en power bi y prácticas sólidas de ciberseguridad para proteger datos y modelos. Si necesitas una solución personalizada podemos ayudarte a modernizar ETL, construir pipelines incrementales y desplegar infraestructuras escalables como servicio.

Explora cómo podemos desarrollar tu proyecto de aplicaciones a medida visitando desarrollo de aplicaciones y software multiplataforma y conoce nuestras propuestas en inteligencia artificial para empresas. Ofrecemos también servicios de ciberseguridad pentesting y consultoría para garantizar un despliegue seguro y conforme a las mejores prácticas.

En resumen AI ETL no es solo otra tarea de BI: requiere primitivas que traten el cambio la incertidumbre y la heterogeneidad como preocupaciones centrales. Si tu mayor dolor son embeddings obsoletos el drift de esquemas o la reingeniería constante de pipelines cuéntanos tu caso y veremos cómo automatizar incrementalmente y reducir costes mientras mejoramos la calidad de tus resultados.

Comentarios