Lo mínimo que todo desarrollador debe saber sobre los modelos de IA (¡Sin excusas!)

Lo mínimo que todo desarrollador debe saber sobre los modelos de IA (¡Sin excusas!)

Si eres desarrollador en 2025 y aún no dominas los fundamentos de cómo funcionan los modelos de inteligencia artificial, esto va para ti. Las herramientas de ayuda para programar como asistentes IA son poderosas pero no mágicas. Usarlas sin entender su funcionamiento es tan peligroso como operar con medicamentos sin formación: útil en manos expertas, letal si se confía ciegamente.

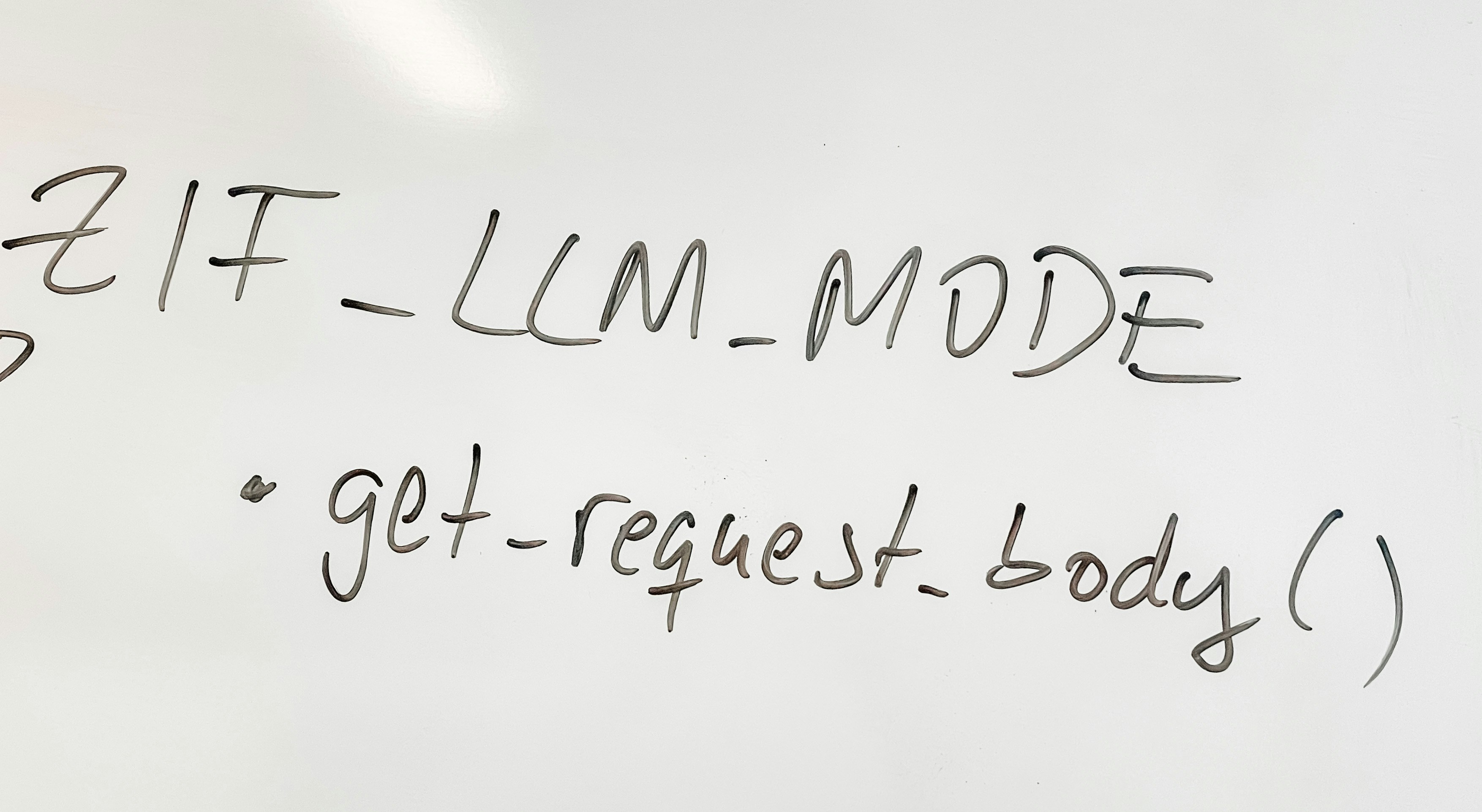

Cómo funcionan a alto nivel: olvida la ejecución de código y piensa en predicción de patrones. Un modelo de lenguaje grande hace una sola cosa repetidamente: predecir el siguiente token. Tus prompts se convierten en tokens, el modelo usa estadísticas aprendidas de enormes corpus y elige el token más probable, añade ese token al contexto y repite hasta terminar. Ese loop token a token explica por qué los resultados son conjeturas muy educadas, no razonamientos deterministas.

Consecuencias prácticas: los prompts no son instrucciones de ejecución. Son más parecidos a pedirle a un compañero junior que entregue un primer borrador. El mismo prompt puede producir resultados diferentes por el parámetro temperature, por el estado interno del modelo o por cambios en el contexto. Verifica siempre, prueba y revisa el código que genera la IA antes de desplegarlo en producción.

Limitaciones frecuentes que debes conocer: los modelos no entienden tu código ni tu arquitectura específica. Proponen patrones comunes que vieron en su entrenamiento, lo que puede chocar con convenciones internas, frameworks personalizados o decisiones de diseño que tomaste en tu base de código. Sé explícito con restricciones: indica librerías usadas, patrones de error, convenciones de nombres y cualquier requisito de seguridad.

Fecha de corte y obsolescencia: los modelos se entrenan hasta una fecha límite. No conocen novedades posteriores, vulnerabilidades recientes ni cambios en APIs. Confía en ellos para generar bocetos y explicaciones, pero valida implementaciones críticas con documentación y fuentes actuales.

Tokens, contexto y costes: los modelos trabajan en tokens, no en caracteres. Comentarios, identación y nombres largos consumen tokens. Cada modelo tiene una ventana de contexto limitada y además la respuesta cuenta contra ese límite. Gestiona el contexto con buen diseño: solicita diffs en lugar de archivos completos para reducir coste y consumo de tokens, y resume requisitos clave en los mensajes más recientes para evitar el problema conocido como lost in the middle.

Rendimiento y límites operativos: además del coste, existen límites de tasa que pueden bloquear tus flujos de trabajo. RPM, TPM y RPD son reales y compartidos por clave de API u organización. Diseña mecanismos de tolerancia, uso centralizado y failover entre proveedores para evitar que un incidente o una oleada de peticiones deje al equipo sin acceso justo en un despliegue crítico.

Seguridad y privacidad: entiende la diferencia entre creador del modelo e infraestructura de inferencia. Usar un servicio web no siempre significa que los datos se queden en el proveedor original. Revisa políticas de retención y elige opciones de zero retention o planes empresariales cuando trabajes con código sensible. Recuerda que, por defecto, algunos interfaces web pueden usar tus inputs para seguir entrenando modelos, así que evita pegar secretos o lógica de autenticación sin garantías contractuales.

Buenas prácticas para equipos de desarrollo: no despliegues código generado por IA sin revisión humana y pruebas automatizadas. Pide cambios en formato diff, ajusta prompts para limitar longitud de salida, integra comprobaciones de seguridad en el pipeline y documenta qué generó la IA y por qué. Educa al equipo sobre tokens, temperatura, context window y políticas de datos para evitar filtraciones y facturas inesperadas.

Cómo Q2BSTUDIO puede ayudarte: en Q2BSTUDIO combinamos experiencia en desarrollo de aplicaciones a medida y software a medida con capacidades avanzadas de inteligencia artificial para empresas. Implementamos agentes IA responsables, pipelines que minimizan costes y riesgos, y soluciones que respetan la privacidad y el cumplimiento normativo.

Además, integramos servicios profesionales en servicios cloud aws y azure para desplegar modelos de inferencia en infraestructuras seguras y con cumplimiento, y ofrecemos auditorías de seguridad y pentesting para proteger tus activos digitales. Si necesitas informes y cuadros de mando, también trabajamos con servicios inteligencia de negocio y power bi para convertir resultados de IA en decisiones de negocio accionables.

Resumen práctico y checklist mínimo: 1) piensa en tokens, no en caracteres; 2) pide diffs y resultados concisos; 3) valida siempre con pruebas y revisión de seguridad; 4) documenta y registra uso de IA; 5) usa proveedores y configuraciones de retención de datos que cumplan tu política. Si quieres acelerar desarrollo sin sacrificar seguridad ni control, Q2BSTUDIO puede implementar una estrategia de IA para empresas que combina automatización, agentes IA y gobernanza técnica.

No trates la IA como oráculo. Úsala como la poderosa herramienta que es: un multiplicador de productividad cuando se aplica con disciplina, y un riesgo evitable cuando se usa a la ligera. Evita desplegar código hallucinado y adopta prácticas profesionales que mantengan tu software robusto, seguro y alineado con tus normas internas.

Contacta a Q2BSTUDIO para diseñar soluciones de IA seguras y eficientes que integren automatización de procesos, ciberseguridad y software a medida para tu organización.

Comentarios