Cómo utilizo los LLM locales para eliminar las pequeñas tareas molestas

Durante el último año he ido trasladando muchas de las pequeñas tareas repetitivas de mi flujo de trabajo de ingeniería a modelos LLM locales. Son esas labores menores que aparecen docenas de veces al día y acaban agotando la motivación, las que quitan la alegría de programar. Automatizarlas ha sido una bendición que me permite centrarme en lo que de verdad aporta valor.

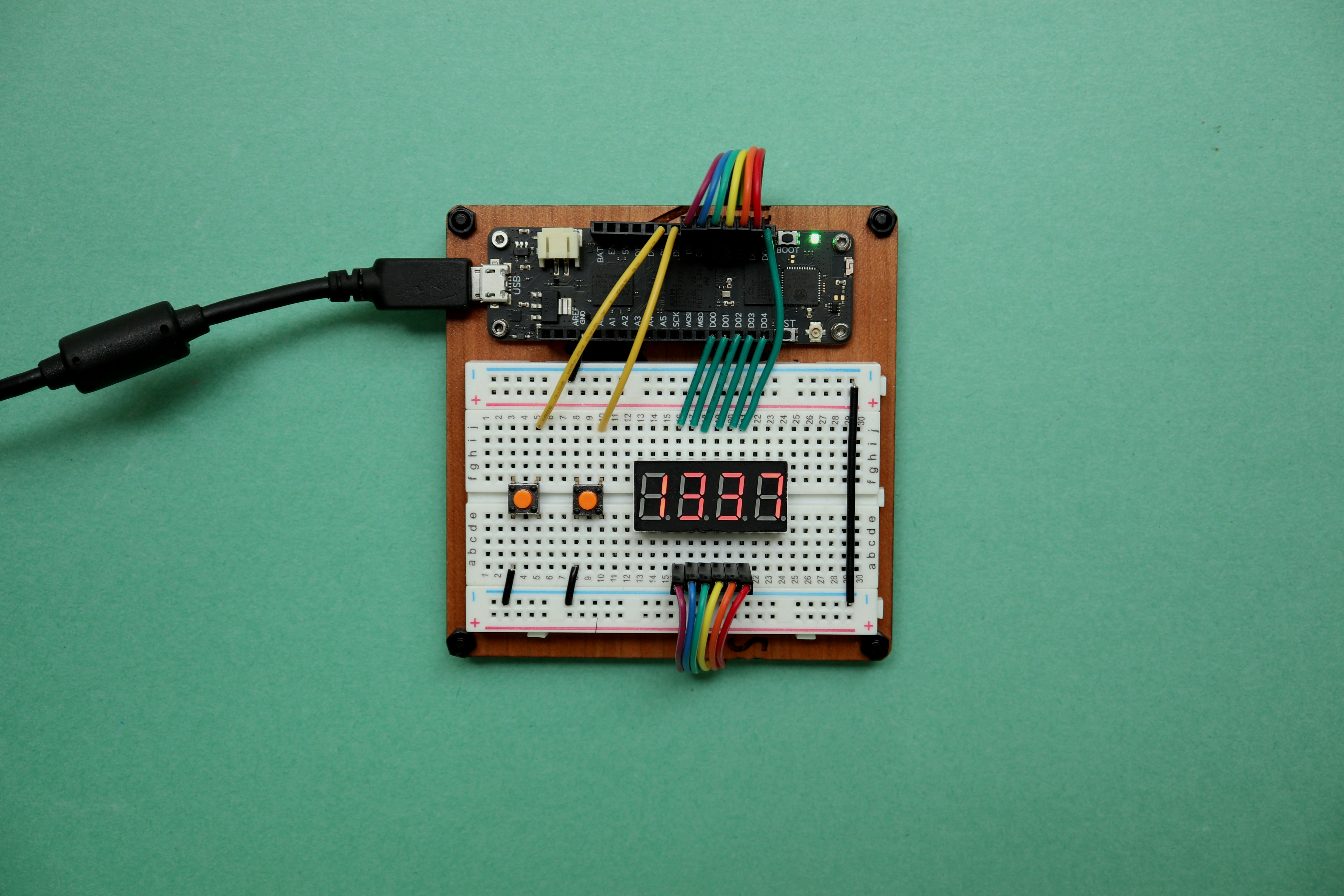

El núcleo de mi entorno es Ollama ejecutando modelos optimizados para código. En mi equipo M4 los modelos qwen2.5-coder:7b y qwen2.5-coder:14b rinden de forma excelente. El primero va muy rápido y cubre la mayoría de tareas, el segundo es algo más lento pero ofrece mejor razonamiento y calidad de código. Ejecutar modelos localmente aporta privacidad automática, respuesta instantánea y cero costes de API, ideal para experimentar y para uso intensivo.

Para tareas concretas he escrito scripts en Python que automatizan labores cotidianas. Por ejemplo un script que genera mensajes de commit a partir del diff staged, solicitando al modelo un único objeto JSON con el mensaje. Otro script compara la rama de feature con la rama base, extrae los diffs y pide al modelo un resumen técnico breve que luego uso como descripción de pull request mediante la CLI de GitHub. Commit frecuentes crean un contexto pequeño y enfocado que ayuda al LLM a producir mejores resultados.

Estas automatizaciones mejoran la productividad al eliminar las partes tediosas del flujo de trabajo y reducen la fricción en procesos repetitivos como redacción de mensajes, resúmenes de cambios y creación de PRs. Además, al ser resoluciones locales se integran bien con políticas de ciberseguridad y cumplimiento de datos corporativos.

En Q2BSTUDIO somos especialistas en transformar estos enfoques en soluciones de valor para clientes. Ofrecemos desarrollo de software a medida y aplicaciones a medida pensadas para integrar capacidades de inteligencia artificial y agentes IA de forma segura y escalable. Si buscas incorporar LLMs locales o proyectos de IA para empresas te invitamos a conocer nuestros servicios de Inteligencia Artificial y a explorar casos de éxito en desarrollo de aplicaciones a medida con los que mejorar procesos y experiencia de usuario desarrollo de aplicaciones a medida.

Además de IA y desarrollo, Q2BSTUDIO cubre ciberseguridad y pentesting para proteger los entornos donde se ejecutan modelos y scripts, servicios cloud AWS y Azure para desplegar cargas mixtas y soluciones de inteligencia de negocio y Power BI para explotar datos generados por agentes y automatizaciones. Palabras clave que guían nuestra oferta incluyen aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA y power bi.

Si te interesa empezar con LLMs locales, recomendaciones prácticas: elegir modelos equilibrados entre latencia y calidad, automatizar pasos pequeños pero frecuentes, integrar con control de versiones y revisar siempre la salida generada por el modelo antes de publicarla. Con una inversión moderada en infraestructura y buenas prácticas de seguridad puedes eliminar fricciones y liberar tiempo para trabajo creativo de mayor impacto.

En resumen, usar LLMs locales para las pequeñas tareas molestas no es solo una mejora de eficiencia, es una forma de recuperar la alegría de la ingeniería. En Q2BSTUDIO ayudamos a diseñar e implementar esas automatizaciones dentro de proyectos reales, asegurando integración con políticas de seguridad, servicios cloud y análisis de negocio para crear soluciones completas y seguras.

Comentarios