Cómo la pereza eficiente arregla flujos de trabajo frágiles LLM

Resumen: Dejé de perder horas depurando errores de parseo JSON y empecé a entregar características reales aplicando un enfoque declarativo para agentes IA. En vez de construir nodos de validación y arreglos ad hoc cada vez que un modelo generaba un campo fuera de formato, definí un contrato y lo dejé ejecutar al sistema.

La historia: mi pipeline de newsletter semanal debía ser sencillo. Extraer artículos, convertir HTML a Markdown, pedir a un LLM un análisis estructurado, insertar en PostgreSQL y generar el boletín. En la práctica, la etapa de IA fallaba cada lunes por causas previsibles: JSON mal formado, campos faltantes, valores fuera de rango, categorías mal escritas. Pasaba 2 a 3 horas por semana arreglando flujos en n8n en lugar de añadir funciones útiles.

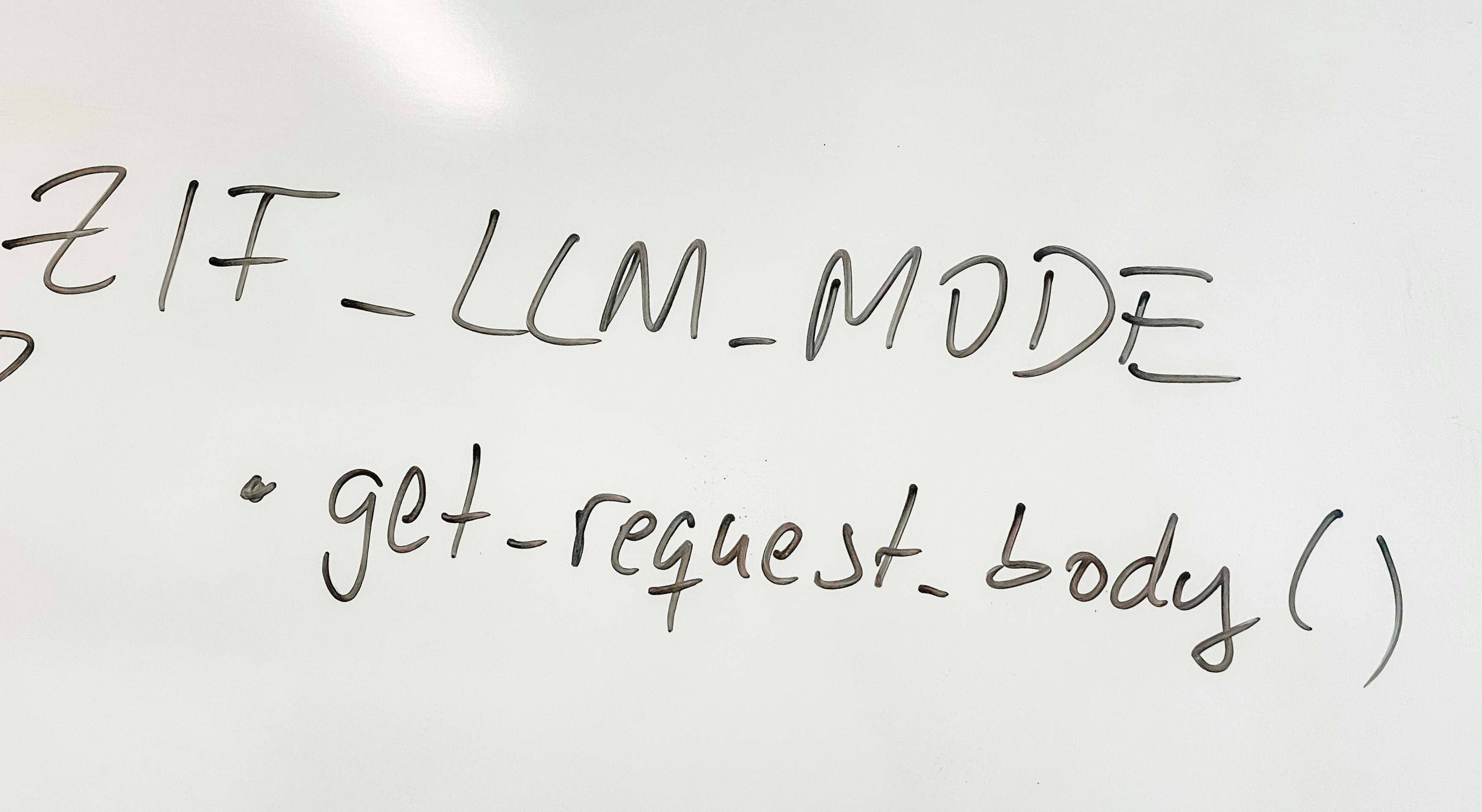

La idea clave: y si la validación fuera responsabilidad del sistema en lugar de mía. Antes de tocar código me pregunté qué resultado necesitaba realmente: un objeto ContentAnalysisOutput validado a partir de markdown content. Todo lo demás es plomería que no debería reconstruir cada semana.

La solución práctica: agentes declarativos. Definir entradas, salida y restricciones en YAML y un modelo de Pydantic como contrato. Con esto la validación es automática, los errores claros y los reintentos gestionados por el runner. En lugar de un flujo con 12 nodos y ramas, se reduce a un único archivo YAML que describe qué se espera y un proceso que se encarga del resto.

Por qué funciona: Pydantic ofrece validación automática, mensajes de error legibles y serialización. YAML aporta legibilidad, control de versiones y facilidad para que no desarrolladores revisen prompts y contratos. El runner usa plantillas para renderizar el prompt, llama al LLM, intenta parsear JSON y valida contra el modelo. Si falla el parseo o la validación, reintenta con instrucciones de corrección. Resultado: menos tiempo debugando, logs estructurados y retries automáticos.

Beneficios reales y ROI: inversión inicial 1 dia para montar el runner y escribir el primer agente en YAML. Por cada nuevo agente apenas 30 minutos. Antes gastaba 3 a 4 horas semanales en depuración; después cero. Ahorro estimado 12 a 16 horas al mes y, más importante, tranquilidad y predictibilidad. Ya no me despierto a las 2 de la mañana por un campo keywords devuelto como cadena en lugar de lista.

Ejemplo operativo: ampliar la analítica para incluir sentimiento fue cuestión de copiar el YAML, agregar un campo sentiment en el modelo Pydantic y ajustar el prompt. Despliegue sin tocar código del runner, sin refactorizaciones y sin días de pruebas. Si hubiera usado 12 nodos y validaciones hardcodeadas, habría sido un reto de varios dias.

Limitaciones a considerar: costo de reintentos, seguridad y gestión de estado. Retries incrementan consumo de API, por lo que conviene balancear prompt engineering con tolerancia a coste. Implementación en producción requiere validación de nombres de agente para evitar path traversal, detección de inyección de prompts, rate limiting, rotación de claves y firmas de archivos para confianza. Para flujos multiagente y orquestación con estado son necesarias herramientas como Temporal, Argo o Airflow.

Guía práctica en 4 pasos aplicable a cualquier proyecto con LLMs: 1 Identificar el contrato: qué salida necesitas siempre. 2 Definir el esquema con Pydantic incluyendo restricciones. 3 Escribir el agente en YAML con prompt claro y config de reintentos. 4 Testear con 10 a 20 entradas reales, ajustar prompt o esquema por separado.

Escalado: al tener decenas de agentes conviene modularizar prompts y esquemas mediante includes y carga de fragmentos para mantener un único punto de verdad de criterios de scoring y formatos. Esto permite versionado, A B testing y reutilización de roles o fragmentos de prompt.

Por qué tu equipo debería adoptarlo: la mayoría codifica primero y valida después. Yo propongo pensar una vez y validar para siempre. Definir esquema antes de prompts evita repetir debugging y mejora la escalabilidad. Incluso para proyectos exploratorios, un esquema mínimo en 15 minutos obliga a concretar campos esenciales y rangos válidos, reduciendo desperdicio.

Checklist para ponerlo en marcha: semana 1 definir 1 o 2 agentes y montar runner básico, semana 2 endurecer retries con backoff, exponer por FastAPI y añadir autenticación y logging, semana 3 hardening en input validation y rate limiting, mes 2 modularización y tracking de costes por agente.

Cómo lo aplicamos en Q2BSTUDIO: como empresa de desarrollo de software y aplicaciones a medida especializada en inteligencia artificial, ciberseguridad y servicios cloud aws y azure ayudamos a clientes a diseñar arquitecturas de agentes IA robustas que evitan el mantenimiento constante. Si necesitas construir soluciones de software a medida o incorporar agentes IA en tus procesos, revisa nuestro enfoque en Desarrollo de aplicaciones multiplataforma con equipos expertos en automatización y seguridad visitando desarrollo de aplicaciones a medida y conoce nuestras capacidades en inteligencia artificial para empresas.

Palabras clave integradas naturalmente: aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA y power bi para posicionamiento y relevancia en búsquedas relacionadas.

Reflexión final: trata los resultados de un LLM como transacciones de base de datos. Define el esquema, haz que se aplique automáticamente y deja que el sistema gestione los errores. Evitarás depurar el mismo error JSON dos veces y ganarás tiempo para crear valor. Si en tu equipo aún validan a mano las respuestas de IA, pregúntate cuánto tiempo vale tu tranquilidad y considera adoptar un sistema declarativo para agentes IA.

Invitación: comparte tus experiencias sobre debugging de salidas de LLM y si quieres que te ayudemos a implantar este patrón en tus pipelines de IA, nuestras soluciones integrales cubren desde automatización de procesos hasta inteligencia de negocio y ciberseguridad.

Comentarios