Predicción del riesgo de enfermedad a partir de variantes no codificantes a través de la decodificación de la gramática regulatoria con IA

Introducción: descifrar la gramática regulatoria del genoma humano. El genoma humano contiene amplias regiones no codificantes que durante años se consideraron ADN basura; hoy sabemos que muchas de esas secuencias actúan como elementos reguladores que dictan cuándo, dónde y con qué intensidad se expresan los genes. Las variantes en regiones no codificantes influyen en la unión de factores de transcripción, en la accesibilidad de la cromatina y en los patrones de expresión génica, y cada vez se asocian con susceptibilidad a enfermedades. Predecir con precisión el riesgo que aportan estas variantes no codificantes sigue siendo un reto. Proponemos un marco de Inteligencia Artificial capaz de decodificar esa gramática regulatoria y estimar riesgo de enfermedad aprovechando técnicas consolidadas de bioinformática, aprendizaje automático y inferencia causal.

Definición del problema y objetivos. El problema central es la interacción compleja entre variantes no codificantes, motivos regulatorios, accesibilidad de la cromatina y expresión génica. Los estudios tradicionales de asociación genómica (GWAS) suelen quedar cortos para identificar variantes causales debido al efecto indirecto de muchas señales. Objetivos del sistema: 1) Decodificar la gramática regulatoria identificando y modelando reglas de regulación en regiones no codificantes. 2) Predecir el riesgo de enfermedad asociado a variantes individuales no codificantes. 3) Ofrecer explicaciones mecanísticas sobre cómo esas variantes alteran circuitos regulatorios.

Solución propuesta: Red Jerárquica de Inferencia Causal HCIN. Presentamos una Hierarchical Causal Inference Network HCIN que combina detección de motivos conservados evolutivamente y emparejamiento de patrones combinatorios para caracterizar elementos regulatorios. La arquitectura se organiza en tres módulos principales.

Módulo 1 Motivo y representación. Este módulo utiliza un algoritmo de alineamiento de secuencias optimizado similar a BLAST++ junto con modelos ocultos de Markov HMM para descubrir y caracterizar motivos regulatorios en secuencias no codificantes. Los motivos se codifican como hipervectores de alta dimensión mediante Hyperdimensional Computing HDC, lo que facilita la comparación y el reconocimiento eficiente de patrones en espacios de gran dimensión.

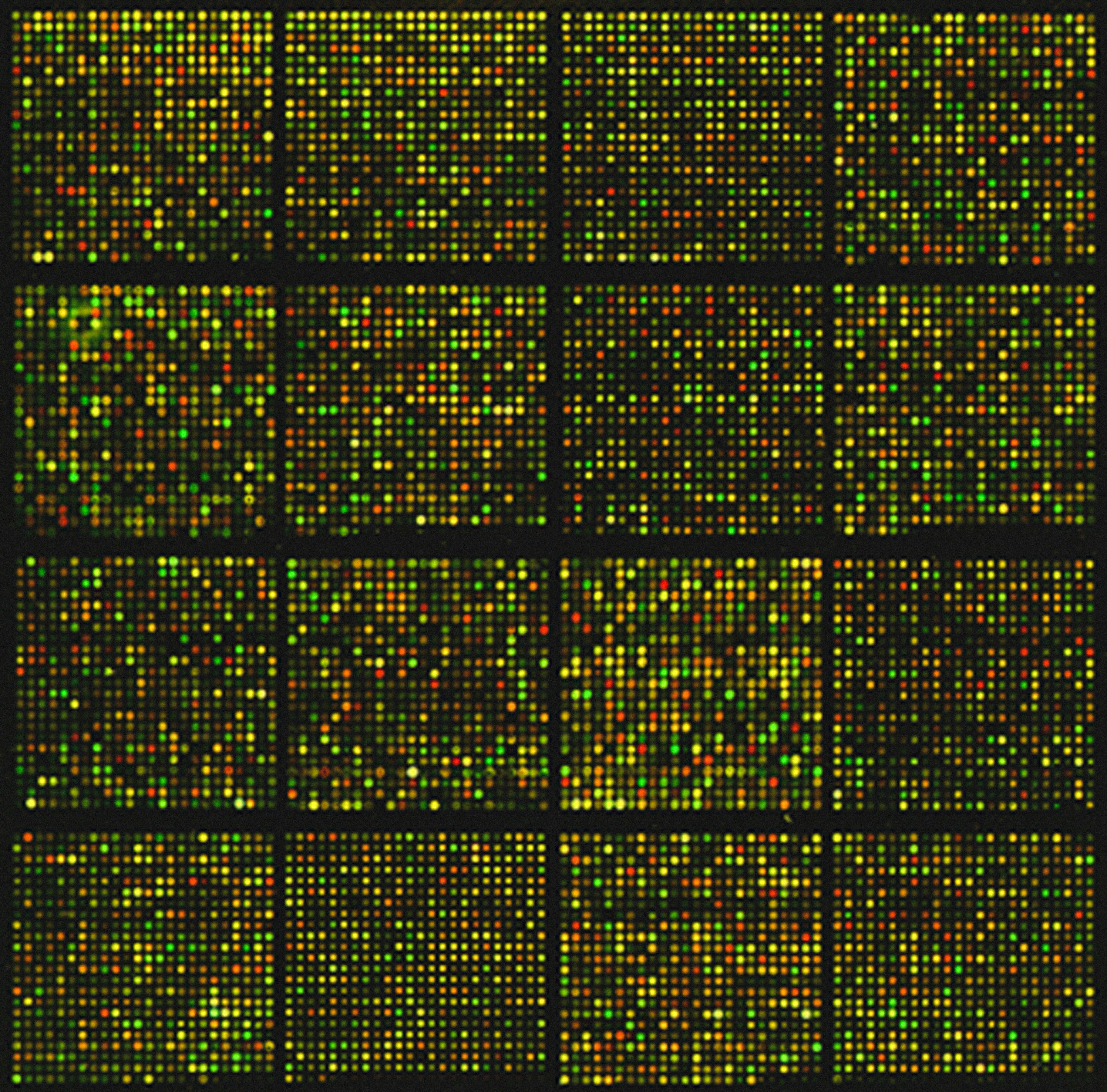

Módulo 2 Construcción de la red causal. Se emplea un marco de redes Bayesianas para modelar relaciones causales entre variantes no codificantes, motivos regulatorios, accesibilidad de cromatina y niveles de expresión génica. La estructura de la red se aprende a partir de datos multiomics como ChIP-seq, RNA-seq y ATAC-seq usando algoritmos basados en restricciones como PC. Los parámetros y pesos de las aristas se ajustan por máxima verosimilitud sobre los datos observados.

Módulo 3 Predicción de riesgo y refinamiento. Sobre la estructura y parámetros aprendidos de la red Bayesiana se calcula la probabilidad posterior de enfermedad dada la firma de variantes de un individuo. Se incorpora una red neuronal recurrente RNN con celdas LSTM para capturar dependencias temporales y dinámicas regulatorias que la red Bayesiana puede no representar explícitamente. Los pesos del LSTM se refinan mediante aprendizaje por refuerzo con el objetivo de optimizar la precisión predictiva y minimizar falsos positivos y negativos.

Metodología y diseño experimental. Fuentes de datos: conjuntos públicos consolidados como ENCODE, Roadmap Epigenomics y el GWAS Catalog. Se propone focalizar inicialmente en una enfermedad concreta como diabetes tipo 2 para acelerar la validación. Conjunto de algoritmos: BLAST++ para alineamiento, HMM para motivos, HDC para representación, redes Bayesianas con algoritmo PC para estructura causal, LSTM(RNN) para dinámica temporal y aprendizaje por refuerzo para optimización final. Se empleará particionado clásico en datos de entrenamiento, validación y prueba para entrenar, ajustar y evaluar el modelo.

Métricas de rendimiento. AUC-ROC para la capacidad discriminativa entre casos y controles, AUC-PR para evaluar la identificación precisa de positivos en presencia de clases desequilibradas, y curvas de calibración para verificar que las probabilidades posteriores estimadas correspondan con las frecuencias observadas.

Formulación matemática. La probabilidad de riesgo se expresa como P(Disease | VariantProfile) = sum sobre estados de nodos P(Disease | EstadoNodos, VariantProfile) * P(EstadoNodos | VariantProfile), donde P(EstadoNodos | VariantProfile) se obtiene por inferencia bayesiana en la red. El LSTM afina esta predicción con una función de pérdida binaria del tipo L = - [ y * log(p) + (1-y) * log(1-p) ] donde y es la etiqueta real (0 o 1) y p la probabilidad predicha.

Escalabilidad y rutas futuras. Corto plazo 1-2 años: refinar la arquitectura HCIN y adaptar pipelines en clusters de alto rendimiento. Medio plazo 3-5 años: desplegar una plataforma en la nube escalable que integre datos longitudinales. Largo plazo 5-10 años: integrar perfiles regulatorios personalizados en decisiones clínicas y descubrir dianas terapéuticas novedosas.

Ventajas y limitaciones. Ventaja clave: ir más allá de la correlación hacia inferencias causales que proporcionen explicaciones biológicas accionables. Limitaciones: la inferencia causal en sistemas biológicos complejos depende de la calidad y cobertura de los datos multiomics y de supuestos en la estructura de la red.

Diseño experimental y verificación. Validación cruzada, benchmarking frente a GWAS y modelos estadísticos convencionales y verificación de la robustez del entrenamiento por refuerzo son pasos esenciales. Se evaluará consistencia biológica de las predicciones comprobando si las variantes señaladas alteran realmente la unión de factores de transcripción, la accesibilidad de la cromatina y la expresión de genes relevantes en experimentos independientes.

Impacto potencial. La HCIN tiene capacidad para mejorar la medicina preventiva y la medicina personalizada al transformar variantes no codificantes en predicciones de riesgo interpretables y en hipótesis mecanísticas para intervención clínica. La combinación de inferencia causal y redes neuronales temporales permite tanto predicciones más precisas como explicaciones plausibles sobre mecanismos moleculares.

Sobre Q2BSTUDIO. Q2BSTUDIO es una empresa especializada en desarrollo de software y aplicaciones a medida con amplia experiencia en soluciones de inteligencia artificial, ciberseguridad y servicios cloud aws y azure. Ofrecemos proyectos de software a medida y aplicaciones a medida que integran inteligencia artificial para empresas, agentes IA y soluciones de inteligencia de negocio. Si su organización necesita diseñar una plataforma capaz de procesar datos omics a escala, modelar relaciones causales o desplegar modelos predictivos en producción, en Q2BSTUDIO contamos con la experiencia para construirla. Conozca nuestros servicios de desarrollo de aplicaciones y software a medida en desarrollo de aplicaciones y software multiplataforma y descubra cómo implementamos proyectos de inteligencia artificial en Inteligencia artificial para empresas.

Servicios complementarios. Además del desarrollo a medida ofrecemos ciberseguridad y pentesting para proteger datos críticos de investigación y modelos predictivos, servicios de cloud para AWS y Azure que garantizan escalabilidad y cumplimiento, y servicios de inteligencia de negocio con Power BI para visualizar resultados y facilitar la toma de decisiones clínicas y de negocio. Palabras clave que describen nuestra oferta incluyen aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA y power bi.

Conclusión. Decodificar la gramática regulatoria del genoma con un enfoque como HCIN combina inferencia causal, representación de motivos mediante HDC y modelado temporal con LSTM para producir predicciones de riesgo de enfermedad más interpretables y accionables. Q2BSTUDIO puede acompañar a equipos de investigación y a empresas en la implementación práctica de estas soluciones, desde la ingesta de datos multiomics y la arquitectura cloud hasta el despliegue de modelos y la visualización de resultados con Power BI, garantizando seguridad y escalabilidad.

Contacto y próximos pasos. Si desea explorar una colaboración para llevar este tipo de investigación a soluciones operativas, solicite un estudio de viabilidad o una propuesta técnica a nuestro equipo mediante las landing pages citadas arriba donde podrá encontrar casos de éxito y servicios detallados que conectan ciencia de datos avanzada con desarrollo de software a medida y operaciones en la nube.

Comentarios