Cómo piensan realmente los LLMs: El marco de suposiciones refinadas

Cómo piensan realmente los LLMs: el marco de suposiciones y refinamiento explica que los grandes modelos de lenguaje no generan todas las palabras finales de una sola pasada sino que recorren una trayectoria en profundidad con dos fases diferenciadas: adivinar y refinar. En las capas iniciales el modelo produce hipótesis rápidas basadas en frecuencias y patrones de corpus; en las capas profundas esas hipótesis se reevalúan, se consolidan con atención contextual y se corrigen para alcanzar coherencia semántica.

Investigaciones recientes de grupos como UC Berkeley y Georgia Tech muestran que más del 70 por ciento de las suposiciones tempranas son reemplazadas antes de la salida final. Esto sucede porque las primeras capas actúan como un motor heurístico que prioriza tokens de alta probabilidad a nivel de corpus, mientras que las capas posteriores integran sintaxis, semántica y propósito global. En la práctica, palabras de función se estabilizan antes que las palabras de contenido y hechos de varias palabras requieren capas profundas para emerger con precisión.

Desde el punto de vista práctico esto tiene tres consecuencias claras. Primero, los atajos de inferencia que cortan la pila demasiado pronto aumentan errores semánticos: si se interrumpe la fase de refinamiento se pierde la integración contextual que corrige ambigüedades y evita alucinaciones. Segundo, la estrategia óptima es usar inferencia con profundidad adaptable, aplicando pases superficiales para spans sencillos y profundos para razonamiento complejo o tokens raros. Tercero, monitorizar cuándo un token se estabiliza facilita la interpretabilidad y ayuda a diagnosticar dónde aparecen fallos y por qué surgen las alucinaciones.

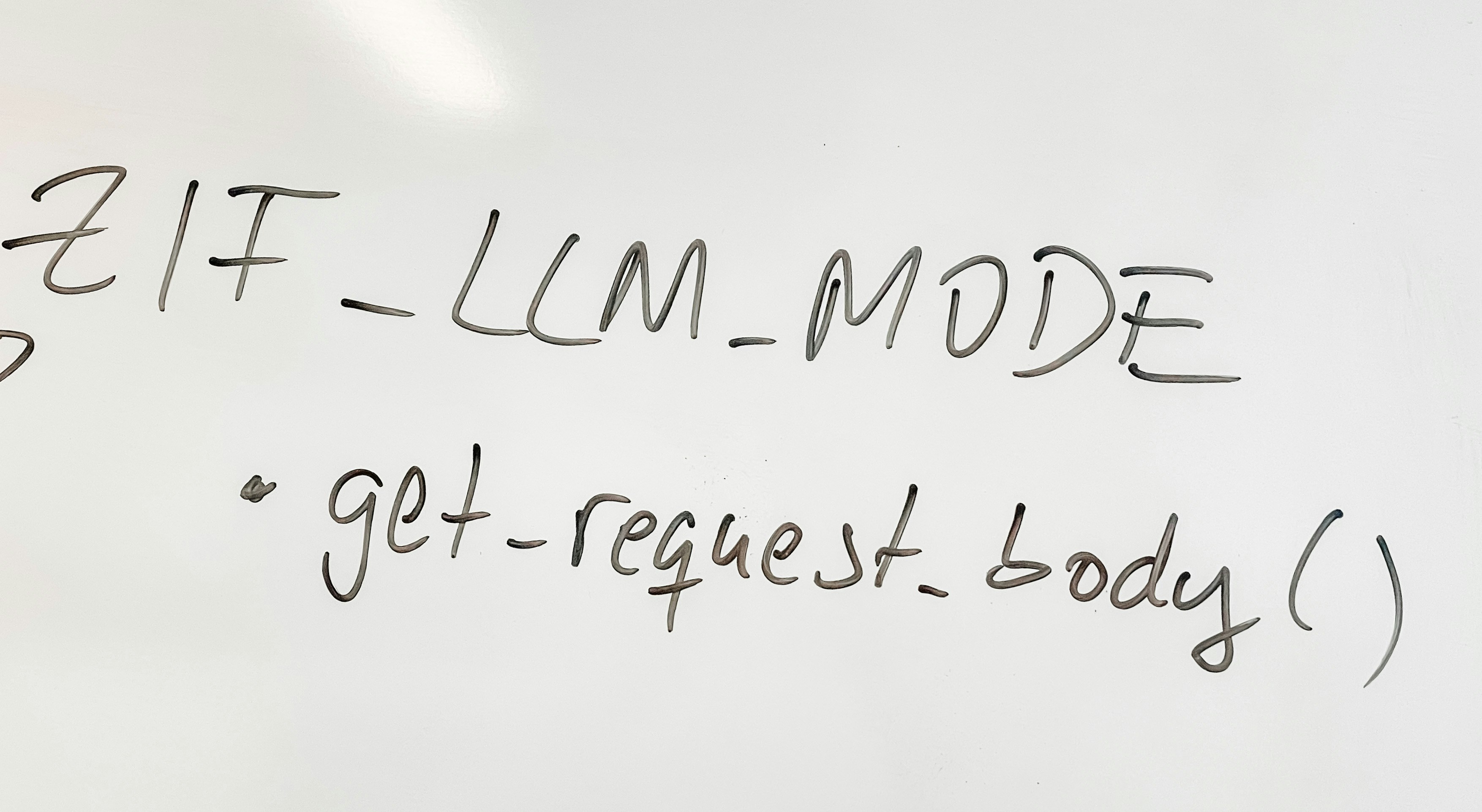

En términos de diseño de sistemas esto se traduce en rutas de cómputo inteligentes que asignan recursos según la dificultad del token o la tarea. Una implementación típica mantiene estados intermedios cacheados, mide estabilidad entre capas y decide continuar solo cuando haga falta. Este enfoque mejora latencia y coste sin sacrificar precisión, especialmente útil en aplicaciones empresariales que combinan generación de texto con requisitos de fiabilidad.

En Q2BSTUDIO, especialistas en desarrollo de software a medida y aplicaciones a medida, aplicamos estos principios para construir soluciones de inteligencia artificial que piensan de forma eficiente y segura. Nuestro equipo integra modelos con rutas de profundidad adaptable en proyectos de ia para empresas, agentes IA y asistentes conversacionales, optimizando el uso de recursos en despliegues productivos.

Además de IA, ofrecemos servicios integrales que incluyen ciberseguridad y pentesting, servicios cloud AWS y Azure, y servicios de inteligencia de negocio con Power BI. Estas capacidades permiten desplegar modelos con garantía de seguridad, escalabilidad y observabilidad, desde prototipos de agentes IA hasta soluciones de análisis con Power BI que convierten la salida del modelo en indicadores accionables.

Para organizaciones que requieren alto rendimiento y cumplimiento, combinamos ingeniería de modelos con prácticas de seguridad y despliegue en la nube. Trabajamos con infraestructuras en AWS y Azure para ofrecer escalado controlado y seguridad reforzada, y desarrollamos pipelines que integran modelos, monitorización de estabilidad de tokens y controles de calidad automatizados.

Si buscas mejorar procesos con IA o crear aplicaciones a medida que incorporen agentes IA robustos y seguros, en Q2BSTUDIO diseñamos arquitecturas de inferencia adaptativa y soluciones llave en mano. Conectamos el conocimiento sobre cómo piensan los LLMs con la ingeniería de software para entregar productos fiables, escalables y alineados con tus objetivos de negocio.

¿Quieres ver cómo implementar inferencia con profundidad adaptable en tu proyecto o explorar servicios de inteligencia artificial, ciberseguridad o Power BI para tu compañía? Ponte en contacto con nosotros para una consultoría técnica y descubre cómo transformar tus ideas en soluciones reales.

Comentarios