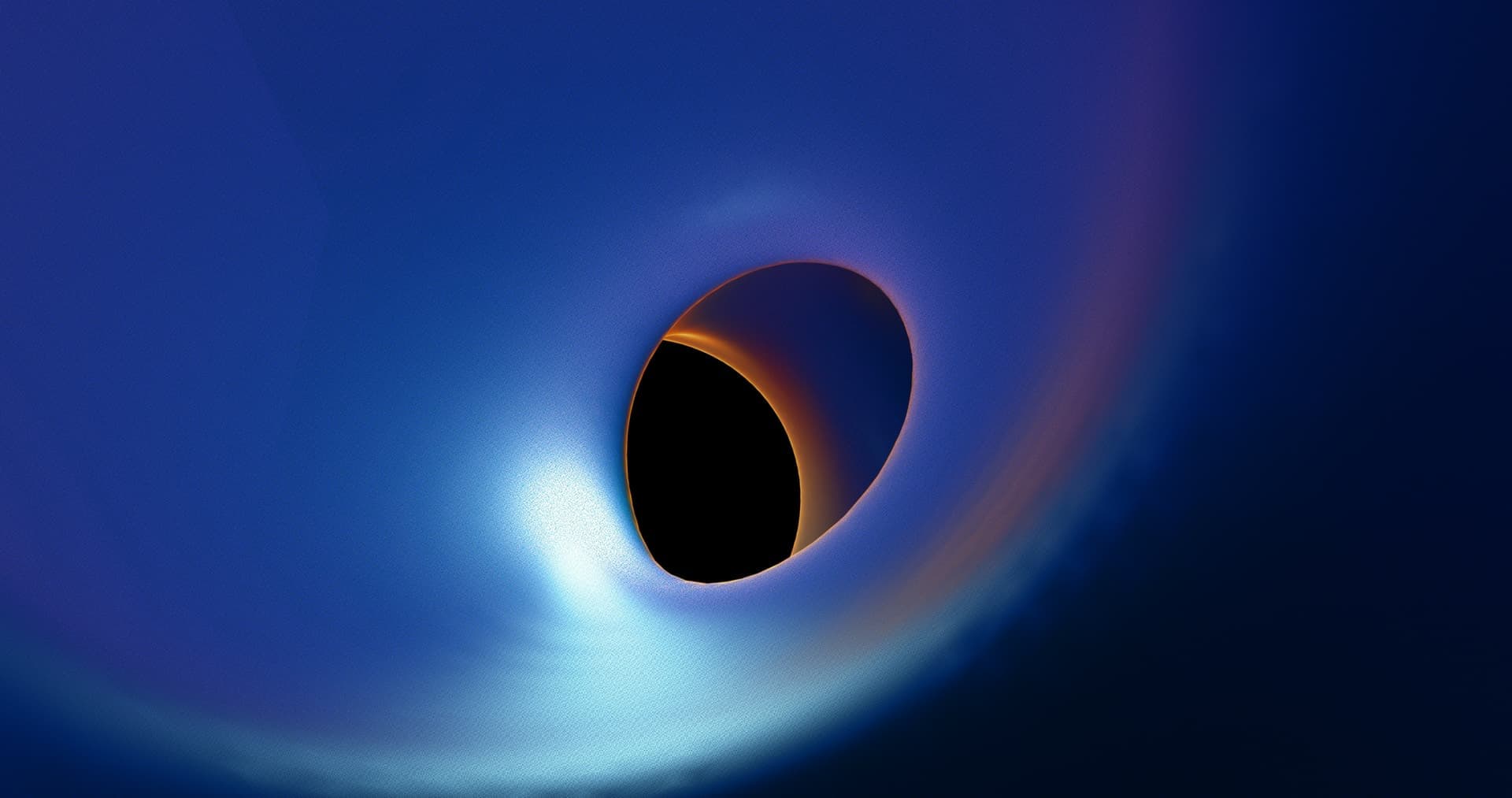

Detección de anomalías multimodales en simulaciones de agujeros negros de Kerr a través del análisis del espacio de características hiperdimensionales

Introducción Penrose processes aplicados a simulaciones de agujeros negros de Kerr generan conjuntos de datos masivos que contienen anomalías sutiles indicativas de nueva física potencial o errores computacionales. Los métodos actuales de detección de anomalías no capturan adecuadamente las correlaciones intrincadas entre modalidades de datos diversas como curvatura del espacio-tiempo, trayectorias de partículas y flujos de energía. Presentamos una solución novedosa: un pipeline de detección de anomalías multimodal basado en análisis del espacio de características hiperdimensionales, diseñado para identificar y caracterizar anomalías en simulaciones de agujeros negros de Kerr con mayor sensibilidad y explicabilidad.

Resumen de la propuesta El Hyper-Dimensional Anomaly Detection Pipeline HDAP descompone los datos complejos de simulación en modalidades independientes, las transforma en vectores de características hiperdimensionales, integra estas representaciones y aplica una función robusta de puntuación de anomalía. Este enfoque permite detectar anomalías multifacéticas que pasan desapercibidas para técnicas uninomodales o basadas en características simples.

Modulo 1 - Ingesta de datos y extracción de características El sistema ingiere datos en formatos heterogéneos: mallas del espacio-tiempo, registros de trayectorias de partículas, series temporales de flujos de energía y metadatos de ejecución. Un parser especializado normaliza estas fuentes en objetos de datos estructurados. Se contempla OCR avanzado para extraer valores de figuras y material suplementario cuando no existan datos tabulados, garantizando que incluso reportes visuales alimenten el proceso de detección.

Modulo 2 - Codificación hiperdimensional Cada modalidad se codifica en vectores hiperdimensionales mediante técnicas adaptadas a su naturaleza. Curvatura del espacio-tiempo se discretiza y se proyecta mediante una capa de embedding entrenable. Trayectorias de partículas se procesan con redes recurrentes para capturar dependencias temporales y luego se transforman en hipervectores. Flujos de energía se analizan mediante transformadas de Fourier y autoencoders para extraer patrones temporales representativos. Un algoritmo de proyecciones aleatorias expande selectivamente la dimensionalidad para capturar relaciones complejas manteniendo eficiencia computacional.

Modulo 3 - Fusión multimodal y puntuación de anomalía Los hipervectores de cada modalidad se fusionan mediante un esquema de promedio ponderado cuyas ponderaciones se aprenden con técnicas de reinforcement learning. El vector combinado h se evalúa contra un modelo de mezcla gaussiana para obtener una puntuación de anomalía. La función de puntuación utilizada es AnomalyScore = -log(sum_{i=1}^K N(h + mu_i, S_i)) donde h es el hipervector combinado, mu_i es la media del i-ésimo componente gaussiano, S_i su matriz de covarianza, K el número de componentes y N(.,.) la densidad gaussiana multivariante. Valores altos de AnomalyScore indican desviaciones improbables respecto a la distribución esperada.

Modulo 4 - Metaevaluación y afinamiento Un bucle de metaevaluación compara detecciones con un conjunto de simulaciones etiquetadas como normales o anómalas. Reinforcement learning ajusta dinámicamente las ponderaciones de fusión y los parámetros del GMM para optimizar métricas de rendimiento. Este ciclo permite adaptar HDAP a variaciones en condiciones de simulación y reducir falsos positivos sin perder sensibilidad a anomalías sutiles.

Diseño experimental y validación Validaremos HDAP con un benchmark de simulaciones de Kerr generadas con condiciones iniciales y parámetros numéricos variados. Las pruebas incluirán anomalías físicamente plausibles, como desviaciones pequeñas del métrico de Kerr posiblemente asociadas a efectos cuánticos, y artefactos numéricos como inestabilidades de malla o colisiones mal resueltas.

Generación de dataset Emplearemos datos públicos combinados con simulaciones propias ejecutadas con herramientas open source. La introducción controlada de anomalías se realizará mediante variaciones en condiciones iniciales y eventos inyectados para evaluar sensibilidad y robustez ante distintos tipos de fallo.

Métricas de rendimiento Se medirán Precision, Recall y F1-Score para cuantificar exactitud de detección. Un proceso Monte Carlo de 100 simulaciones aportará intervalos de confianza y evaluará estabilidad estadística de los resultados frente a incertidumbres en condiciones iniciales.

Escalabilidad e implementación práctica La arquitectura modular de HDAP admite procesamiento paralelo por modalidad y despliegue en infraestructura cloud. El diseño permite analizar datasets con miles o millones de puntos mediante computación distribuida. Plan de despliegue: corto plazo 6 meses piloto en cluster GPU para 100 simulaciones; medio plazo 12 meses integración con plataforma de almacenamiento y procesamiento masivo para 10 000+ simulaciones; largo plazo 24+ meses despliegue en tiempo real para monitorizar simulaciones y retroalimentar ajustes de parámetros numéricos.

Resultados esperados y ventajas técnicas Anticipamos una mejora de sensibilidad en detección de anomalías de hasta 10x respecto a técnicas existentes, permitiendo identificar anomalías sutiles y multifacéticas. Ventajas clave: fusión multimodal adaptativa, representación hiperdimensional rica que combina RNN, transformadas de Fourier y autoencoders, y uso de proyecciones aleatorias para escala. Limitaciones a considerar: dependencia en la calidad de datos etiquetados para entrenamiento, coste computacional del entrenamiento por reinforcement learning y la necesidad de validación física para evitar sobredetecciones por ruido numérico.

Contribuciones científicas y prácticas La novedad de HDAP reside en la integración de ingeniería de características hiperdimensionales con fusión multimodal aprendida y modelado probabilista robusto. Aplicaciones inmediatas incluyen análisis de simulaciones para investigación en gravedad fuerte, mejora de precisión en predicciones para ondas gravitacionales y apoyo en la verificación de métodos numéricos.

Contexto empresarial y servicios de Q2BSTUDIO Q2BSTUDIO es una empresa de desarrollo de software y aplicaciones a medida especializada en inteligencia artificial, ciberseguridad y soluciones cloud. Ofrecemos software a medida y aplicaciones a medida para clientes de investigación y empresas que requieren plataformas de análisis intensivo. Nuestra experiencia en IA para empresas y agentes IA permite diseñar pipelines como HDAP e integrarlos con servicios empresariales y dashboards de control. Si su organización necesita desarrollar soluciones de inteligencia artificial a la medida, consulte nuestros servicios de servicios de inteligencia artificial o explore nuestras capacidades de desarrollo de aplicaciones y software a medida.

Servicios complementarios y posicionamiento SEO Además de desarrollo a medida ofrecemos ciberseguridad y pentesting para entornos de simulación, servicios cloud aws y azure para despliegues escalables, servicios inteligencia de negocio y dashboards con power bi, automatización de procesos y consultoría en agentes IA. Palabras clave integradas naturalmente en nuestra oferta: aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA y power bi.

Casos de uso y ejemplo práctico Imagina un laboratorio que valida un nuevo esquema numérico para fusiones de agujeros negros. HDAP procesa las simulaciones en tiempo cercano al tiempo real y detecta patrones anómalos en flujos de energía y trayectorias de partículas antes de que la inestabilidad numérica corrompa toda la carrera de simulación. La detección temprana permite intervenir ajustando parámetros y reducir coste computacional y tiempo de investigación.

Conclusión El Hyper-Dimensional Anomaly Detection Pipeline representa una vía práctica y escalable para extraer valor de grandes volúmenes de datos generados por simulaciones de Kerr. Combinando técnicas avanzadas de machine learning, modelado probabilista y una arquitectura preparada para la nube, HDAP abre la puerta a nuevas observaciones científicas y a mejoras operativas en proyectos de simulación. Para colaborar en proyectos de desarrollo de soluciones a medida, ciberseguridad, despliegues en servicios cloud aws y azure o integración con herramientas de inteligencia de negocio como power bi, contacte con Q2BSTUDIO y descubra cómo podemos adaptar esta tecnología a sus necesidades.

Comentarios