Creando y Visualizando Redes Neuronales en R: Orígenes, Aplicaciones y Estudios de Caso

Creando y Visualizando Redes Neuronales en R: Orígenes, Aplicaciones y Estudios de Caso

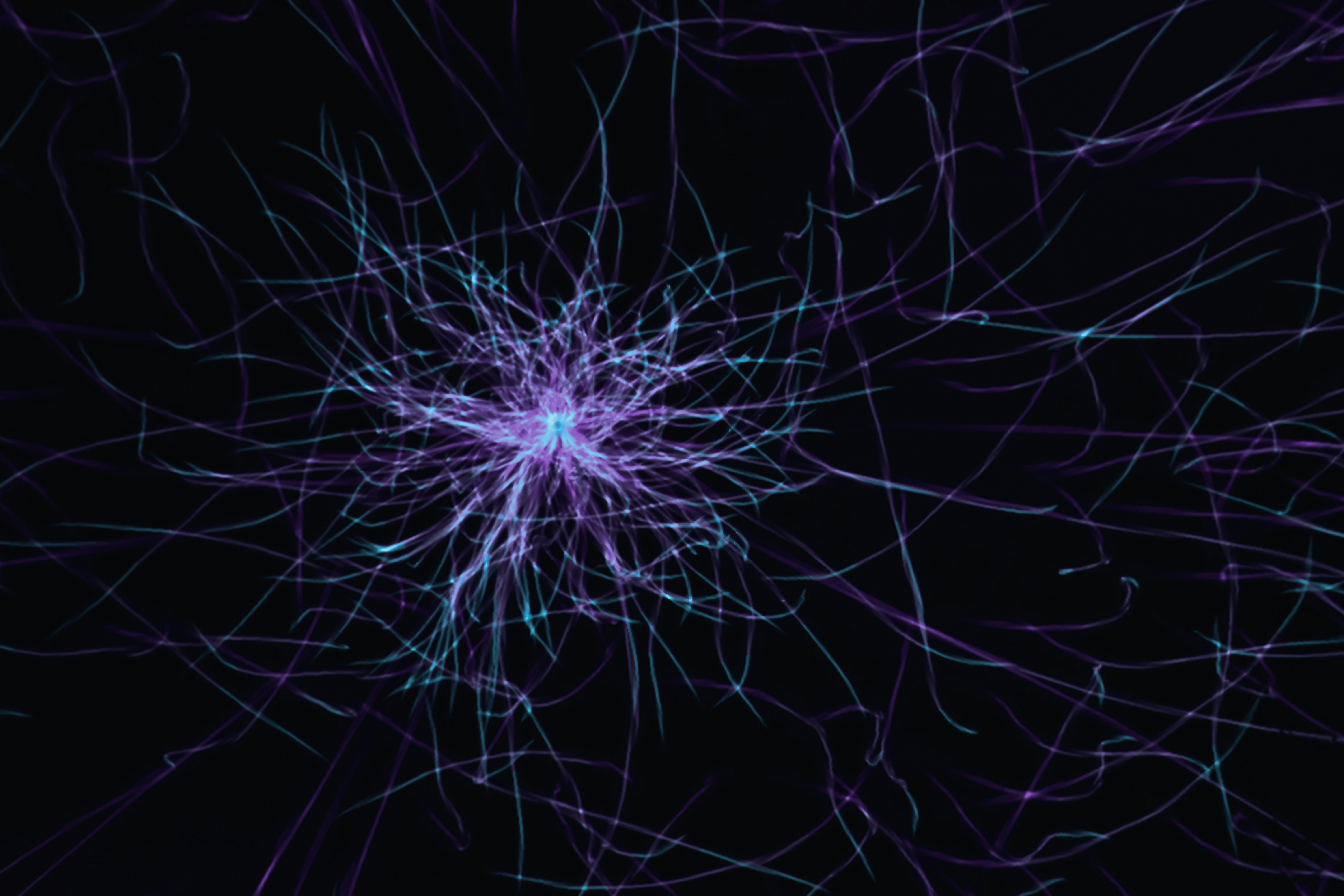

Introducción: Las redes neuronales figuran entre los avances más transformadores de la inteligencia artificial moderna. Alimentan desde reconocimiento de imágenes y asistentes de voz hasta detección de fraude y recomendaciones personalizadas. Su arquitectura se inspira en el sistema nervioso humano, con neuronas interconectadas que procesan información en paralelo, lo que permite detectar patrones complejos, modelar relaciones no lineales y generar predicciones precisas. Aunque a menudo se las denomina modelos caja negra, comprender sus fundamentos reduce la opacidad y facilita su uso responsable.

Orígenes: La idea de redes neuronales surge en la década de 1940 con trabajos como el de McCulloch y Pitts que propusieron un modelo matemático inspirado en neuronas biológicas. En los años 50 Donald Hebb formuló principios de aprendizaje basados en la coactivación de neuronas y en 1957 Frank Rosenblatt presentó el perceptrón, el primer modelo entrenable. Las limitaciones iniciales en la representacion de relaciones no lineales se superaron más tarde con la rediscovery del algoritmo de retropropagación en los años 80, sentencia que abrió la puerta a redes profundas y al deep learning actual.

Fundamentos: Una red neuronal típica se organiza en capas: capa de entrada para recibir datos, capas ocultas que transforman la información mediante conexiones ponderadas y una capa de salida que entrega predicciones. Cada neurona aplica una función de activación como ReLU, sigmoid o tanh para introducir no linealidad. El entrenamiento consiste en sumar ponderaciones, activar, calcular error y propagarlo hacia atrás para ajustar pesos mediante optimizadores como descenso por gradiente. Este proceso iterativo vuelve a las redes adaptativas y potentes.

Construir redes neuronales en R: R ofrece paquetes como neuralnet, caret, nnet y keras. Para usuarios que buscan simplicidad y visualización clara, el paquete neuralnet resulta práctico para experimentar y entender la arquitectura de la red. La visualización muestra conexiones, intensidades de peso y nodos de sesgo, facilitando la interpretación y depuración del modelo.

Preparación y escalado de datos: Las redes son sensibles a la escala de las variables. Si una característica está en cientos y otra en decimales, el modelo puede atribuir importancia de forma incorrecta. El escalado Min-Max que lleva los valores al rango 0 a 1 es una técnica habitual que preserva la distribución y mejora la convergencia durante el entrenamiento.

División entrenamiento y prueba: Para evaluar rendimiento se divide el conjunto en entrenamiento y prueba. Una partición 60–40 es común, aunque el tamaño óptimo depende de la disponibilidad de datos. Tras ajustar el modelo en el conjunto de entrenamiento, se evalúa la capacidad predictiva en datos no vistos y se calcula métricas como RMSE para cuantificar el error de predicción.

Visualización y ajuste en R: Con neuralnet se especifican variables dependientes e independientes, la estructura de capas ocultas y parámetros de entrenamiento. La representación gráfica identifica pesos y nodos de sesgo; líneas más gruesas o más oscuras suelen indicar mayor influencia. Al generar predicciones es importante desescalar los resultados para interpretarlos en la escala original.

Validación cruzada: Más allá de una sola partición, la validación cruzada k-fold ofrece estimaciones más robustas del rendimiento al entrenar y evaluar en múltiples particiones. En redes neuronales la variabilidad puede depender de la inicialización de pesos, arquitectura y tamaño del conjunto de entrenamiento, por eso evaluar medianas o promedios de RMSE en varios pliegues mejora la fiabilidad.

Aplicaciones reales: Las redes neuronales se aplican transversalmente en la economía digital. En salud permiten clasificación de tumores, interpretación de imágenes médicas y detección temprana de enfermedades, en muchos casos con redes convolucionales que rivalizan con especialistas. En finanzas se emplean para detección de fraude, scoring crediticio y predicción de precios. En retail y marketing optimizan motores de recomendación, predicción de churn y forecasting de demanda. En manufactura e IoT se usan para mantenimiento predictivo, inspección de calidad y detección de defectos por visión artificial.

Estudios de caso: Caso 1 Predicción de puntuaciones de cereales mediante datos nutricionales. Usando R y neuralnet se predijeron calificaciones a partir de calorías, proteína, grasa, sodio y fibra. El resultado mostró un RMSE aproximado de 6.05 y mejoró conforme aumentó la muestra de entrenamiento. La visualización permitió identificar pesos influyentes y términos de sesgo, demostrando que incluso con conjuntos pequeños las redes capturan relaciones no lineales. Caso 2 Predicción de compras en retail. Un gran minorista incorporó navegación, compras previas, demografía y respuesta a cupones; el uso de redes mejoró la predicción de compras de alto valor en 22 por ciento, optimizando campañas. Caso 3 Predicción de fallos en manufactura. Una compañía global analizó vibración, temperatura y presión para anticipar fallos de máquinas, logrando una reducción de 30 por ciento en tiempos de inactividad y ahorros en mantenimiento.

Implementación en empresas y servicios complementarios: Para llevar modelos de redes neuronales a producción es habitual combinar desarrollo de software a medida, despliegue en servicios cloud y prácticas de ciberseguridad y monitoreo. En Q2BSTUDIO somos una empresa de desarrollo de software y aplicaciones a medida, especialistas en inteligencia artificial, ciberseguridad y servicios cloud. Podemos ayudar desde la creación de modelos IA para empresas hasta el despliegue seguro en plataformas escalables. Si buscas soluciones de software a medida visita desarrollo de aplicaciones y software a medida y si tu prioridad es aplicar inteligencia artificial en procesos de negocio descubre nuestros servicios en inteligencia artificial.

Palabras clave y posicionamiento: En Q2BSTUDIO integramos aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA y power bi para ofrecer soluciones completas que abarcan diseño, desarrollo, despliegue y operación. También ofrecemos servicios de Business Intelligence y Power BI para transformar datos en insight accionable y mejorar la toma de decisiones.

Buenas prácticas y consideraciones finales: Para obtener modelos robustos conviene tener en cuenta calidad y cantidad de datos, escalado adecuado, selección de arquitectura, regularización para evitar overfitting y validación cruzada para estimaciones confiables. La interpretación de pesos y la visualización ayudan a explicar decisiones y a generar confianza en stakeholders. Finalmente, integrar modelos en un entorno productivo requiere decisiones sobre servicios cloud, seguridad y automatización de procesos.

Conclusión: Las redes neuronales, desde el perceptrón hasta las redes profundas actuales, son herramientas esenciales para extraer valor de datos complejos. Con R es posible experimentar, visualizar y validar modelos de forma accesible. Si tu organización necesita desarrollar soluciones de IA, protegerlas con ciberseguridad adecuada y desplegarlas en la nube con AWS o Azure, Q2BSTUDIO ofrece experiencia en todos esos frentes para convertir proyectos de datos en resultados tangibles.

Contacto: Si quieres conversar sobre proyectos de aplicaciones a medida, inteligencia artificial, servicios cloud aws y azure, ciberseguridad o soluciones de inteligencia de negocio como Power BI, en Q2BSTUDIO estaremos encantados de ayudarte a diseñar la mejor ruta técnica y de negocio.

Comentarios