Cómo creé una biblioteca de caché semántico para IA

¿Te has preguntado por qué las aplicaciones basadas en grandes modelos de lenguaje se vuelven más lentas y caras a medida que escalan, aun cuando el 80 por ciento de las preguntas de los usuarios suenan muy parecidas? Esa misma duda me llevó a indagar en el concepto de caché semántico y a crear VCAL Vector Cache-as-a-Library, un proyecto open source pensado para que las aplicaciones de inteligencia artificial recuerden respuestas ya generadas.

La idea surgió al optimizar un chatbot de soporte interno que corría sobre un modelo local. Los registros mostraban cientos de consultas casi idénticas pidiendo acceso a un panel de analítica, y cada consulta disparaba una inferencia completa del LLM: generar embedding, crear respuesta y consumir muchos tokens a pesar de que el problema era el mismo. La solución fue sencilla en concepto y potente en efecto crear una capa intermedia que inserta cada pregunta como embedding y, si existe una entrada suficientemente parecida, devuelve la respuesta almacenada sin llamar al modelo.

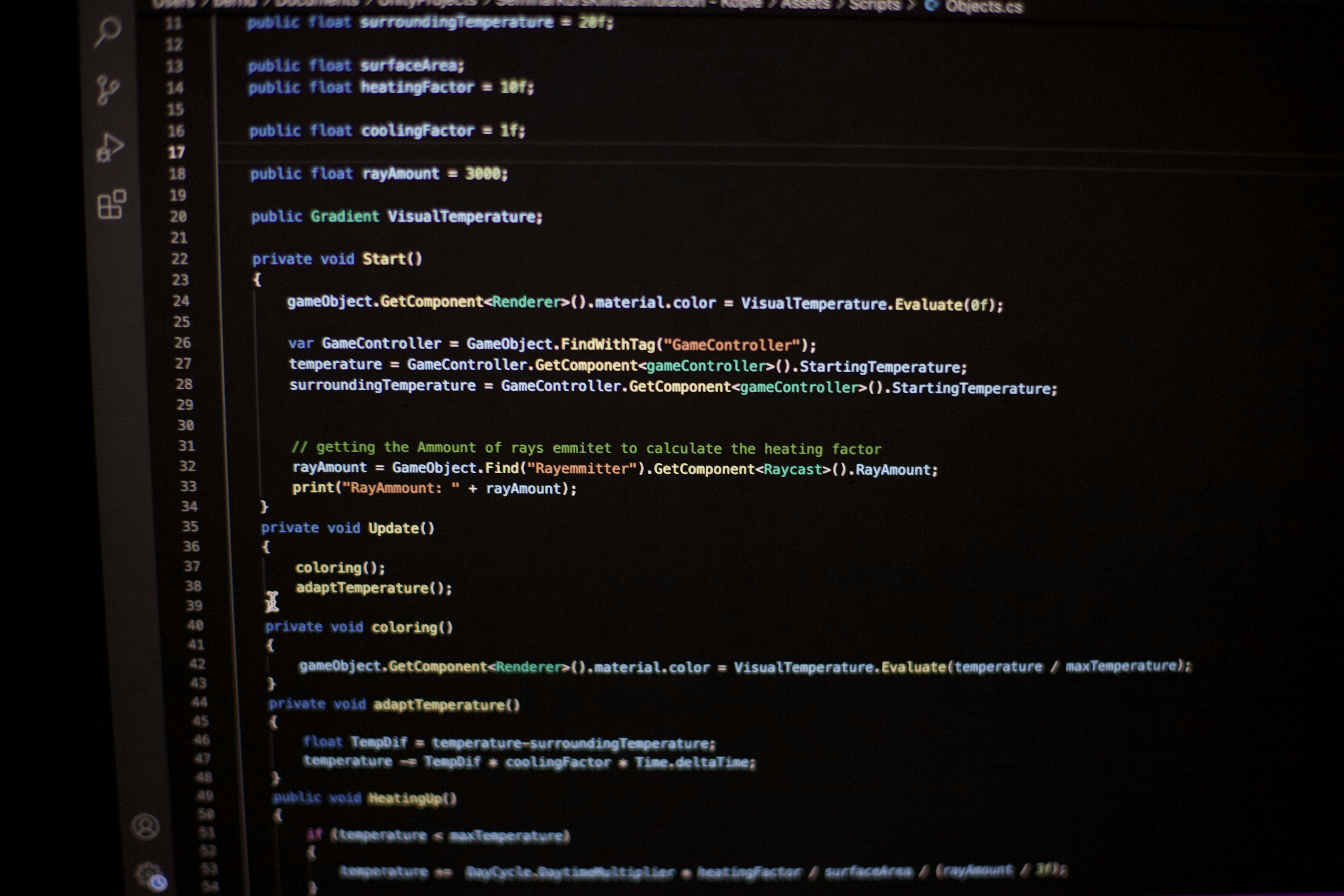

Desarrollé un prototipo en Rust por su rendimiento y fiabilidad y lo empaqueté como vcal-core, una librería pequeña que cualquier app puede incorporar. La primera versión de VCAL permitía almacenar y buscar embeddings en memoria usando índices HNSW, gestionar caducidad con TTL y políticas LRU, y guardar snapshots en disco para reinicios rápidos.

Más tarde creamos VCAL Server, una versión con API HTTP para equipos que necesitaban compartir caché entre servicios y desplegar en on-premise o en la nube. El objetivo nunca fue construir otra base de datos vectorial gigante, sino una caché semántica ligera en memoria optimizada para consultas LLM repetidas y de baja latencia.

Integrar VCAL es rápido. En lugar de llamar al modelo directamente, se envía la consulta a VCAL. Si ya existe una pregunta semánticamente similar, la respuesta se obtiene en milisegundos. Si es nueva, VCAL consulta al modelo, almacena el resultado y lo devuelve. La próxima vez que llegue una variación semántica, la respuesta es instantánea. Es como añadir una capa de memoria entre la aplicación y el modelo, ligera, explicable y totalmente controlada por el equipo de desarrollo.

Algunos aprendizajes clave fueron claros: los LLMs aman la redundancia y los usuarios reformulan mucho las mismas preguntas; por eso cachear semánticamente equivale a cachear texto útil. La similitud por coseno y las distancias vectoriales importan más que las coincidencias exactas. Con un caché bien afinado, el rendimiento escala de forma elegante y puede manejar miles de consultas por segundo en hardware modesto. Una sola instancia de VCAL Server puede almacenar y servir millones de respuestas según la dimensión de los embeddings y la capacidad del equipo.

En la hoja de ruta estamos desarrollando un servidor de licencias, formatos de snapshot empresariales y extensiones estilo RAG para que los equipos usen VCAL no solo para caching de preguntas y respuestas, sino como base de una memoria semántica privada y persistente. Si trabajas con agentes IA, mesas de soporte o asistentes de conocimiento, dar a tu sistema un cerebro que recuerda ofrece grandes ventajas en costos y experiencia de usuario.

En Q2BSTUDIO somos una empresa de desarrollo de software y aplicaciones a medida con especialistas en inteligencia artificial, ciberseguridad y servicios cloud. Ofrecemos soluciones completas para IA para empresas y desarrollamos agentes IA y sistemas de automatización que aprovechan técnicas como la caché semántica para mejorar rendimiento y coste. Si necesitas desarrollar una plataforma o integrar capacidades avanzadas de IA te invitamos a conocer nuestras propuestas de aplicaciones a medida y software a medida y nuestras soluciones de inteligencia artificial e IA para empresas.

Además, en Q2BSTUDIO complementamos estos desarrollos con servicios de ciberseguridad y pentesting para proteger modelos y datos, despliegues en servicios cloud aws y azure, y soluciones de inteligencia de negocio como Power BI para explotar los datos de forma estratégica. Nuestro enfoque integral asegura que la mejora de rendimiento con caché semántico vaya acompañada de seguridad, escalabilidad y métricas accionables.

Si te interesa explorar cómo una capa de memoria semántica puede optimizar tus aplicaciones de IA, agentes conversacionales o plataformas de soporte, en Q2BSTUDIO podemos ayudarte a diseñar la arquitectura, integrar librerías como VCAL y desplegar soluciones seguras en la nube o en infraestructuras privadas. Contacta para una consultoría y descubre cómo reducir costes de inferencia, mejorar tiempos de respuesta y habilitar una memoria empresarial efectiva para tus sistemas de inteligencia artificial.

Palabras clave relevantes para mejorar posicionamiento: aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA, power bi.

Comentarios