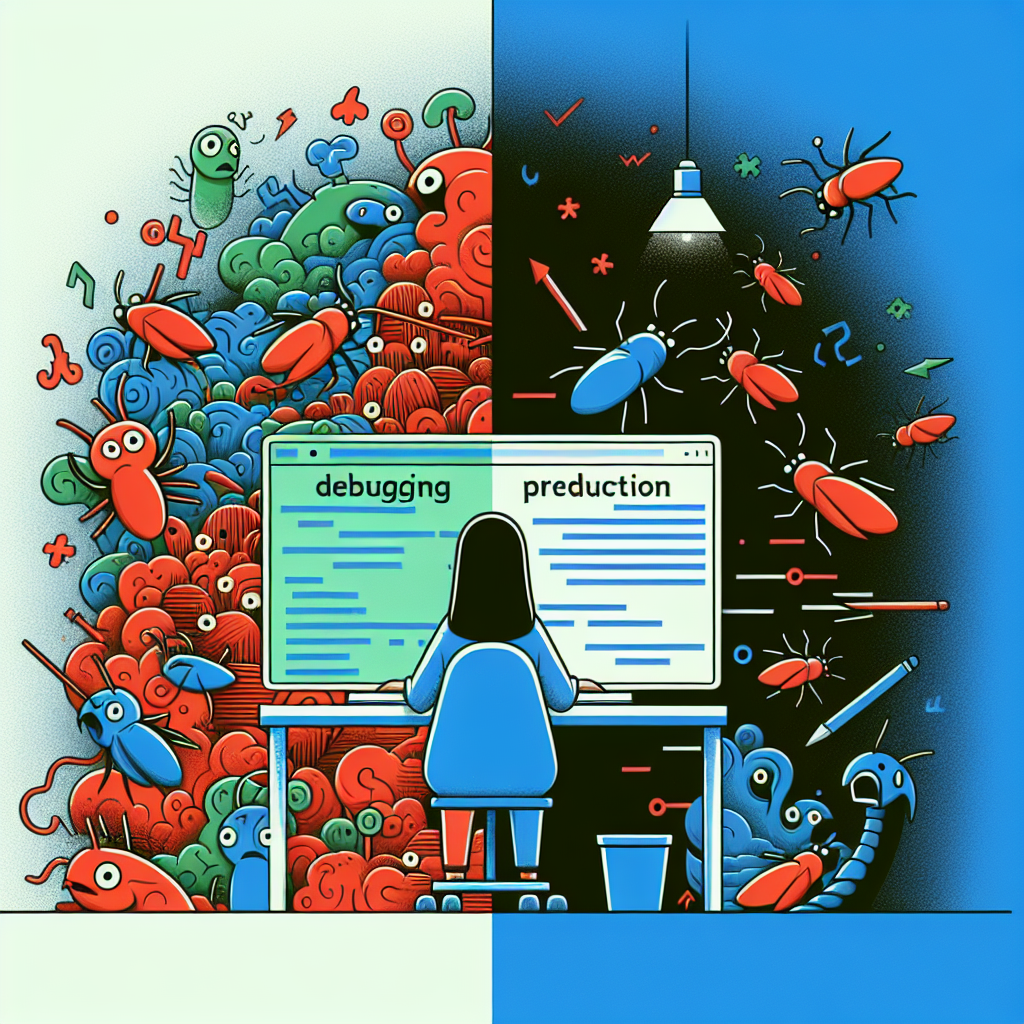

Depurar en producción no siempre es malo

Nunca depures en producción suele ser la primera regla que aprende todo desarrollador, junto a siempre hacer copias de seguridad y probar todo dos veces. Tras 15 años desarrollando software he comprobado que, en ocasiones y con las debidas precauciones, depurar en producción no solo es aceptable sino imprescindible.

Una madrugada me vi conectado por SSH a un servidor de producción a las 2:00 AM añadiendo registros y trazas para entender por qué el procesamiento de pagos fallaba en exactamente 23% de las transacciones. Según la sabiduría convencional estaba cometiendo un sacrilegio, pero esa decisión salvó a la empresa 50 000 euros en ingresos y demostró que la ingeniería de software del mundo real es más compleja y matizada que los manuales.

La noche en que todo comenzó: alertas de monitorización indicando fallos intermitentes en pagos. Revisamos despliegues, logs y el proveedor de pagos nos dijo que todo parecía normal. Sin embargo la situación empeoraba: pérdida de ingresos por hora, tickets de soporte inundando el sistema, quejas en redes sociales y el CEO pidiendo actualizaciones cada hora.

El entorno de staging no replicaba el problema. El error solo ocurría con datos reales, métodos de pago reales y volúmenes reales. Teníamos dos opciones: perder días intentando reproducir el entorno de producción o depurar directamente en producción. A la 1:47 AM decidimos intervenir en producción.

La justificación fue clara: el incidente estaba afectando a clientes ahora mismo, cada hora de retraso costaba más que el riesgo de depurar con cautela, y contábamos con salvaguardas como feature flags, capacidad de rollback y copias de seguridad de base de datos. Antes de tocar nada establecimos reglas estrictas: todos los cambios tenían que ser registrables y reversibles, solo se permitía código de depuración no destructivo, monitorizamos el rendimiento en tiempo real, teníamos un plan de reversión inmediato y un segundo ingeniero revisaba cada cambio.

El primer paso fue aumentar la visibilidad del sistema. Con trazas estratégicas identificamos patrones en minutos: los fallos se producían exactamente 30 segundos tras iniciar el pago, afectaban a usuarios cuyos identificadores terminaban en dígitos concretos y el error venía de una consulta a la base de datos, no del proveedor de pagos.

Las trazas permitieron seguir las migas del problema. Analizando planes de ejecución descubrimos que una actualización reciente del motor de base de datos había cambiado el comportamiento del optimizador, provocando que para ciertos patrones de datos se eligiera un plan ineficiente que desembocaba en un timeout en 30 segundos. Nuestro generador de IDs de usuario había producido una distribución no uniforme y cerca del 23% de usuarios terminaban en los dígitos que disparaban la ruta lenta.

Con la causa raíz identificada aplicamos una solución focalizada en producción: forzar el uso del índice correcto en la consulta afectada como solución temporal. El resultado fue inmediato: los fallos de pago cayeron a 0% en menos de cinco minutos, el tiempo medio de procesamiento mejoró un 40%, las quejas de clientes cesaron y los ingresos comenzaron a recuperarse al instante.

Al día siguiente implementamos la corrección definitiva: actualización de estadísticas de la base de datos para corregir el optimizador, monitorización de consultas lentas, alertas de rendimiento y pruebas automatizadas para detectar regresiones. Tiempo total hasta la resolución aplicando depuración en producción: tres horas. Estimación de la vía tradicional para recrearlo en local: semanas.

Este episodio cristalizó una regla práctica: depurar en producción tiene sentido cuando se cumplen ciertas condiciones. Criterios para romper la regla: el problema solo existe en producción por volúmenes o patrones reales, el coste del retraso supera el riesgo, existen medidas de protección y las técnicas tradicionales han fracasado. Además debe haber opciones no destructivas de depuración, capacidad de rollback y seguimiento constante de métricas.

Para hacerlo de forma segura propongo un playbook en fases. Fase 1 preparación: asegurar reversibilidad, activar monitorización aumentada, preparar procedimientos de rollback y documentar en tiempo real. Fase 2 depuración mínima invasiva: operaciones readonly, añadir observabilidad sin cambiar la lógica de negocio y usar feature flags. Fase 3 pruebas de hipótesis: cambiar poco a poco y validar antes de ampliar. Fase 4 implementación cuidadosa: desplegar incrementalmente, monitorizar impacto y estar listo para revertir.

Algunas lecciones prácticas: invertir en observabilidad es esencial, feature flags permiten experimentar y revertir sin desplegar, las debugging de bases de datos requieren precauciones extra y la comunicación con stakeholders durante el incidente es crítica. Las empresas deben aceptar un cambio de mentalidad desde nunca depurar en producción hacia depurar con seguridad cuando la situación lo exige.

En Q2BSTUDIO aplicamos estos principios en nuestro trabajo diario de desarrollo de aplicaciones y software a medida. Somos una compañía especializada en aplicaciones a medida y software a medida, con capacidades avanzadas en inteligencia artificial y servicios de ciberseguridad. Sabemos que a veces los problemas solo se ven en entornos reales, por eso combinamos buenas prácticas de observabilidad con herramientas modernas para minimizar riesgo y maximizar tiempo de respuesta.

Si tu proyecto necesita soluciones robustas y seguras, en Q2BSTUDIO diseñamos y desplegamos plataformas con monitorización integrada y feature flags, además de ofrecer servicios cloud aws y azure que facilitan rollback y despliegues controlados. Para proyectos que requieren inteligencia artificial o agentes IA a medida podemos ayudarte a integrar modelos en producción con salvaguardas y pruebas que evitan sorpresas. Conoce más sobre nuestras soluciones de aplicaciones personalizadas en desarrollo de aplicaciones multiplataforma y software a medida y explora nuestras capacidades en IA en inteligencia artificial para empresas.

Palabras clave que aplicamos en cada proyecto: aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA y power bi. Implementamos buenas prácticas de Business Intelligence y Power BI para monitorizar el impacto de cambios en producción y reducir riesgos en tiempo real.

En resumen, la ingeniería pragmática exige balancear riesgo y valor. Depurar en producción no es un acto de irresponsabilidad cuando se hace con disciplina, herramientas adecuadas y comunicación transparente. La regla moderna podría formularse así: no depures en producción por sistema, pero prepárate para depurarla de forma segura cuando la situación lo requiera. En Q2BSTUDIO ponemos esa disciplina en práctica para proteger el negocio y ofrecer soluciones fiables y escalables.

Comentarios