Dentro del Transformer

Este artículo fue escrito originalmente en abril de 2023, por lo que algunas partes pueden estar un poco desactualizadas, pero la mayoría de las ideas clave sobre los modelos de lenguaje grande siguen siendo relevantes hoy.

Dentro del Transformer existe una arquitectura flexible que se adapta a distintas necesidades: encoder only, decoder only y la combinación encoder plus decoder. No siempre hacen falta las dos mitades completas. Cada variante tiene ventajas según la tarea que se quiera resolver.

Encoder only: modelos como BERT conservan únicamente la pila del encoder. Su fortaleza no está en generar texto sino en producir representaciones contextuales ricas, embeddings que funcionan estupendamente para tareas de clasificación y extracción: ¿Es esta reseña positiva o negativa? ¿Contiene esta frase el nombre de una persona? Mejores embeddings implican mejores clasificadores. BERT procesa el texto de forma bidireccional y aprende a recuperar palabras enmascaradas durante el entrenamiento, lo que difiere del entrenamiento auto regresivo típico de los modelos de lenguaje tradicionales.

Decoder only: en el otro extremo están modelos como GPT que mantienen la pila del decoder. Si el objetivo es predecir la siguiente palabra y generar continuaciones coherentes, el decoder auto regresivo es la opción más directa. Alimentas al modelo con el texto hasta el momento y este predice el siguiente token, lo incorpora y continúa. Por eso arquitecturas decoder only son la receta para muchos agentes conversacionales y motores generativos a gran escala.

Encoder más Decoder: modelos como T5 o BART combinan ambas mitades y son ideales cuando existe una transformación clara entre entrada y salida, por ejemplo traducción, resumen o tareas donde el encoder captura la fuente y el decoder genera la representación final.

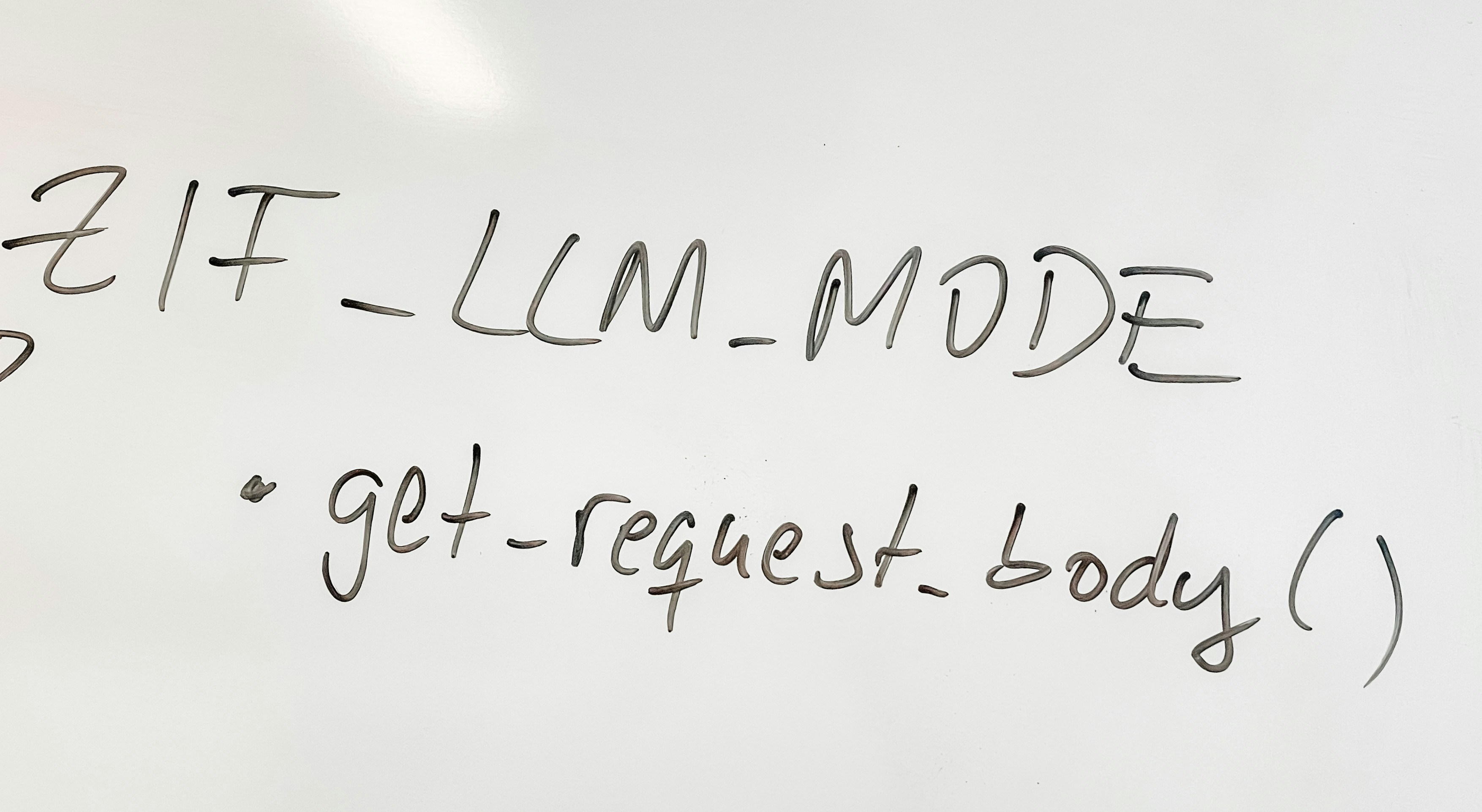

Atención y Self Attention son el corazón de los Transformers. La atención permite que, al generar cada token, el modelo reponderé a las partes relevantes de la entrada. La self attention extiende esa idea dentro de una misma secuencia: cada palabra aprende a ponderar otras palabras del mismo contexto. Esto resuelve ambigüedades como a qué se refiere un pronombre o qué palabra determina el tiempo verbal en una frase.

La atención multi cabezal añade otro nivel: en lugar de una sola mirada, el modelo ejecuta múltiples cabezas en paralelo, cada una con una proyección distinta del embedding. Una cabeza puede enfocarse en relaciones gramaticales, otra en vínculos semánticos y otra en atributos contextuales. Esa multiplicidad de puntos de vista es parte de la razón por la que los Transformers superaron a las RNN tradicionales.

¿Qué significan realmente los números de parámetros como 175B o 540B? Son el conteo de pesos del modelo. Más parámetros suelen ofrecer más capacidad, pero no garantizan mejor desempeño por sí solos. La calidad y cantidad de datos, el diseño de entrenamiento, los hiperparámetros y las infraestructuras de cómputo importan tanto o más. Si alguien sólo compara modelos por el número de parámetros, conviene ser cauto: puede ser una simplificación excesiva o un argumento de marketing.

El desarrollo de LLMs fue posible gracias a la conjunción de tres factores: datos a escala web que permiten aprendizaje auto supervisado, arquitecturas basadas en Transformers que escalan bien y potencia de cómputo con GPUs/TPUs y ecosistemas cloud que permiten entrenamientos masivos. Por separado cada avance habría sido notable; juntos provocaron el salto cualitativo que vemos hoy.

En cuanto a la práctica y la industria, empresas como Q2BSTUDIO combinan esos avances tecnológicos con servicios reales para clientes. En Q2BSTUDIO desarrollamos soluciones de software a medida y aplicaciones a medida que integran modelos de lenguaje y capacidades de IA para resolver problemas concretos de negocio. Ofrecemos servicios de inteligencia artificial adaptados a empresas, creación de agentes IA, y soluciones analíticas con Power BI para potenciar la inteligencia de negocio.

Nuestro enfoque combina experiencia en desarrollo de software a medida con buenas prácticas en ciberseguridad, lo que asegura que las soluciones no solo sean innovadoras sino también robustas y seguras. Si necesita integrar modelos de lenguaje en procesos empresariales, optimizar flujos con automatización o desplegar soluciones en la nube, en Q2BSTUDIO cubrimos desde la consultoría hasta el despliegue y mantenimiento. Explore nuestras soluciones de inteligencia artificial y descubra cómo implementamos ia para empresas y agentes IA que se alinean con objetivos de negocio.

A nivel de infraestructura, disponemos experiencia en servicios cloud aws y azure y diseñamos despliegues que escalan con seguridad y eficiencia. Para proyectos que requieren aplicaciones concretas, construimos plataformas y aplicaciones a medida que integran modelos de lenguaje, pipelines de datos y paneles de control como Power BI para que la información sea accionable.

Finalmente, es importante recordar que los LLMs no aparecen por arte de magia: su potencial se extiende mucho más allá de generar texto. Con la arquitectura correcta, datos de calidad y prácticas de desarrollo seguras, pueden transformar la forma en que las empresas automatizan procesos, analizan datos y ofrecen experiencias inteligentes a sus usuarios. En próximos artículos exploraremos temas como zero-shot, few-shot, prompting y técnicas prácticas para integrar modelos en soluciones empresariales.

Palabras clave: aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA, power bi.

Comentarios