Crea un servidor MCP desde cero

Crea un servidor MCP desde cero: guía práctica para implementar un Task Manager compatible con Model Context Protocol

Introducción: El Model Context Protocol MCP es un protocolo estandarizado para que modelos de lenguaje trabajen con sistemas externos mediante JSON-RPC 2.0. En este artículo explicamos cómo diseñar e implementar un servidor MCP para gestión de tareas, con buenas prácticas de validación, persistencia, despliegue y seguridad. Además mostramos cómo Q2BSTUDIO, empresa especializada en desarrollo de software a medida, inteligencia artificial y ciberseguridad, puede ayudar a integrar soluciones avanzadas y servicios cloud aws y azure.

Resumen arquitectural: Un servidor MCP profesional combina tres familias de componentes: herramientas o actions que el LLM puede invocar para crear, modificar, completar o eliminar tareas; recursos que se leen y exponen como documentos estructurados; y prompts que añaden plantillas y workflows para análisis como revisiones semanales o planificación de sprints. La comunicación se realiza mediante JSON-RPC y puede exponerse por HTTP para integraciones web o por stdio para integraciones directas con aplicaciones de escritorio.

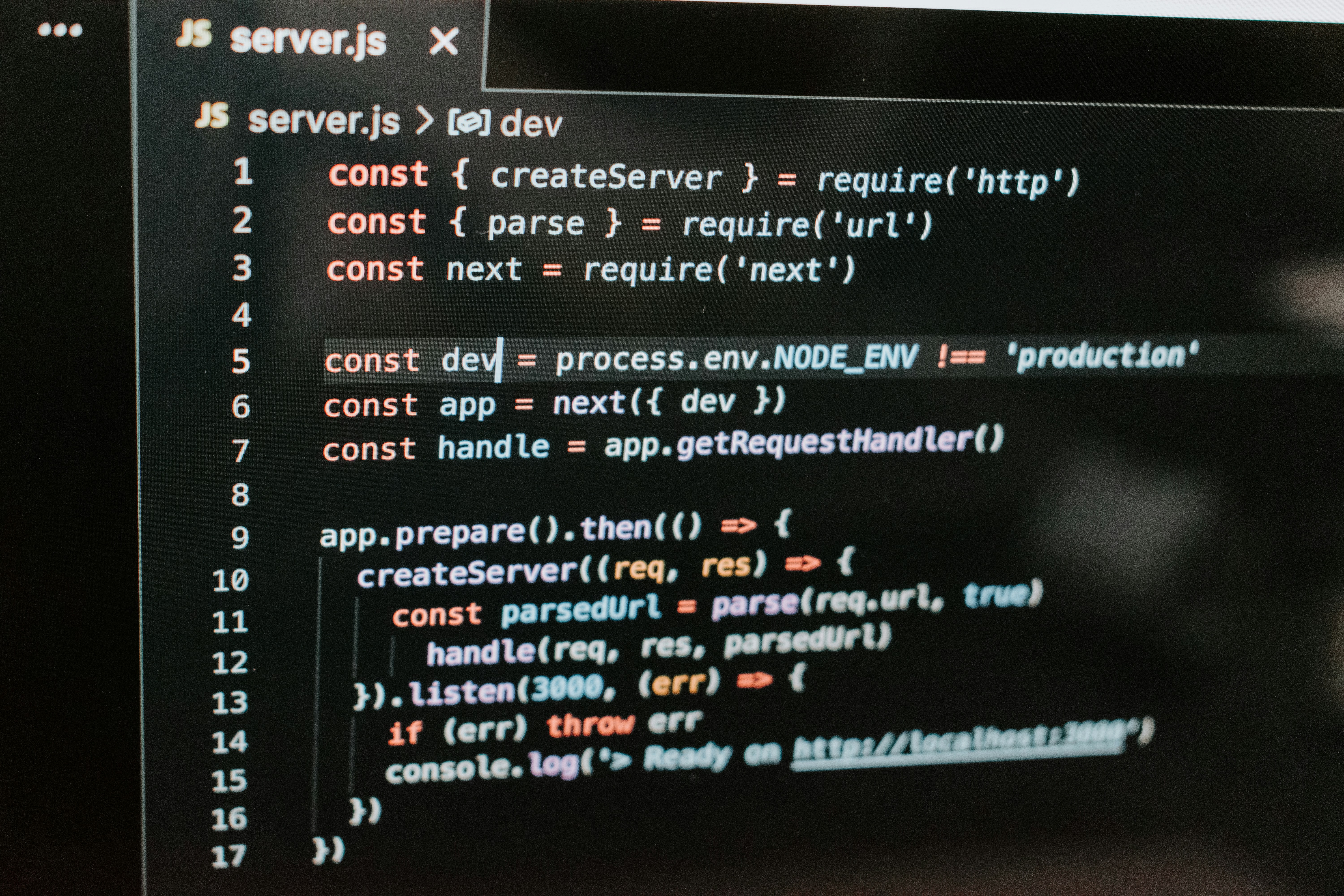

Requisitos y tecnologías recomendadas: Nodejs 18 o superior con Typescript para tipado estricto, Zod para validación de esquemas, sqlite para un prototipo rápido y modularidad para migrar a bases como Postgres en producción. Para despliegue recomendamos Docker con multi stage builds y uso de un usuario no root.

Estructura de proyecto sugerida: src servidor y orquestación, src database con inicialización y consultas, src tools con implementaciones de create update complete delete, src resources con list stats detail, src prompts con plantillas para weekly review y sprint planning, src types con esquemas Zod, src utils con manejo de errores y cache. Esta organización facilita mantenimiento, pruebas y extensibilidad.

Validación y tipos: Usar Zod para definir el esquema de tarea permite validación en runtime y generación de tipos en Typescript. Validar en capas: primero esquemas, luego reglas de negocio como fechas de vencimiento no pasadas, luego operaciones en base de datos. Esto mejora la seguridad y la trazabilidad de errores.

Persistencia: Un ejemplo práctico utiliza sqlite con tablas indexadas para status priority assignee y campos JSON para tags. Encapsular acceso en una clase TaskDatabase que promisifica callbacks de sqlite facilita pruebas e intercambio por otro motor en el futuro. Prefijo de IDs y normalización de campos simplifican transformaciones entre DB y MCP.

Implementación de herramientas: Cada herramienta expone metadatos y validación de entrada. Al crear tareas retornar identificador creado created_at y estado. Al actualizar validar existencia y proteger tareas ya completadas. Al completar registrar completed_at notas y tiempo empleado. Al eliminar exigir confirmación para evitar borrados accidentales.

Recursos de solo lectura: task://list expone un inventario con metadatos, task://stats devuelve métricas agregadas como por estado prioridad tareas vencidas tasa de finalización y timepo medio, task://detail id devuelve la ficha completa. Implementar cache con TTL para recursos costosos y mejorar latencia.

Prompts y plantillas LLM: Diseñar prompts para weekly review y sprint planning que incorporen datos del sistema y guías de análisis. Los prompts actúan como plantillas reutilizables que la IA consume para generar resúmenes, planes y recomendaciones operativo estratégicas.

Manejo de errores: Definir códigos de error MCP y una excepción rica que se traduzca a JSON-RPC. Separar errores de validación errores de negocio y fallos internos. Registrar errores y exponer respuestas claras para facilitar la detección desde clientes y herramientas de integración.

Servidor principal: Arquitectura híbrida HTTP stdio. HTTP aporta facilidad de integración con aplicaciones web y herramientas como Postman curl y permite health check para monitoreo. stdio facilita integraciones con entornos de escritorio. Implementar un endpoint /health y un endpoint /mcp que traduzca JSON-RPC a handlers locales con validación de esquemas y control centralizado de errores.

Pruebas y calidad: Configurar Jest para pruebas unitarias e integración. Usar bases en memoria para tests y scripts automáticos para validar ciclo completo de creación consulta actualización y eliminación. Incorporar pruebas de error y casos límite para asegurar robustez.

Despliegue con Docker: Multi stage build para reducir imagen final, uso de usuario no root y healthcheck. Volumen persistente para la base sqlite y variables de entorno para DB_PATH PORT y modo de transporte. Opcionalmente docker compose para orquestación y reinicio automático en producción.

Monitoreo y mantenimiento: Exponer métricas básicas y health checks logs de contenedor y alertas. Plan de backup y restore para volumen de datos y procedimientos para actualizaciones con downtime mínimo mediante rebuild y redeploy con orquestador o docker compose.

Patrones aplicados: promisification de sqlite, encapsulación de acceso a datos, capas de validación, export centralizado de herramientas y handlers para autodescubrimiento, cache para recursos, manejo centralizado de errores y formatos de respuesta MCP.

Extensiones y evolución: Autenticación JWT OAuth para proteger endpoints, webhooks para notificaciones en tiempo real, integraciones con Slack Teams o GitHub Issues, migración a Postgres para alta concurrencia, analítica con Prometheus y dashboards, y una interfaz web administrativa basada en frameworks modernos.

Ejemplos y comandos útiles: Interacción básica por HTTP con JSON-RPC para listar herramientas crear tareas leer recursos y consultar estadísticas. Scripts bash o node para automatizar tests y gestión. En producción usar variables de entorno y volumenes para asegurar persistencia y seguridad.

Valor diferencial de Q2BSTUDIO: En Q2BSTUDIO diseñamos e implementamos soluciones a medida que integran desarrollo de aplicaciones a medida con capacidades avanzadas de inteligencia artificial y ciberseguridad. Ofrecemos servicios integrales desde arquitectura cloud hasta dashboards de inteligencia de negocio y power bi. Nuestro equipo puede acelerar la puesta en producción de un servidor MCP y conectar agentes IA y pipelines seguros con mejores prácticas de servicios cloud aws y azure.

Si necesitas ayuda profesional para desarrollar e integrar un servidor MCP con flujos de IA para empresas o para construir una plataforma de gestión de tareas adaptada a tus procesos contacta con nosotros. Consulta nuestros servicios de Inteligencia artificial o descubre cómo implementamos soluciones de software a medida y aplicaciones a medida para potenciar la productividad de tu organización.

Palabras clave integradas: aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA y power bi. Estas keywords ayudarán a mejorar posicionamiento web y a conectar tus necesidades con nuestras capacidades técnicas y de consultoría.

Conclusión: Crear un servidor MCP desde cero es viable y escalable si se aplican patrones de validación control de errores persistencia modular y despliegue seguro. La arquitectura presentada permite evolucionar desde un prototipo sqlite a una plataforma empresarial con alta disponibilidad y analítica avanzada. Para acelerar ese camino Q2BSTUDIO ofrece experiencia en desarrollo personalizado integraciones IA seguridad y operaciones cloud.

Comentarios