De 5 segundos a 0.7 segundos: Cómo construí un agente de IA de voz listo para producción (y reduje la latencia en un 7x)

Resumen rápido para el desarrollador ocupado: construí un agente de IA de voz listo para producción que pasó de más de 5 segundos de latencia a respuestas por debajo del segundo tras 8 fases de optimización sistemática. No fue solo código: fue identificar dónde se esconden los cuellos de botella y aplicar cambios sencillos con gran impacto.

En Q2BSTUDIO, empresa de desarrollo de software y aplicaciones a medida especializada en inteligencia artificial, ciberseguridad y servicios cloud aws y azure, aplicamos este enfoque metodológico a proyectos reales para ofrecer soluciones de software a medida robustas y rápidas. Si buscas servicios de IA para empresas o desarrollo de aplicaciones a medida, te interesará cómo optimizamos cada componente del pipeline de voz para producir resultados medibles.

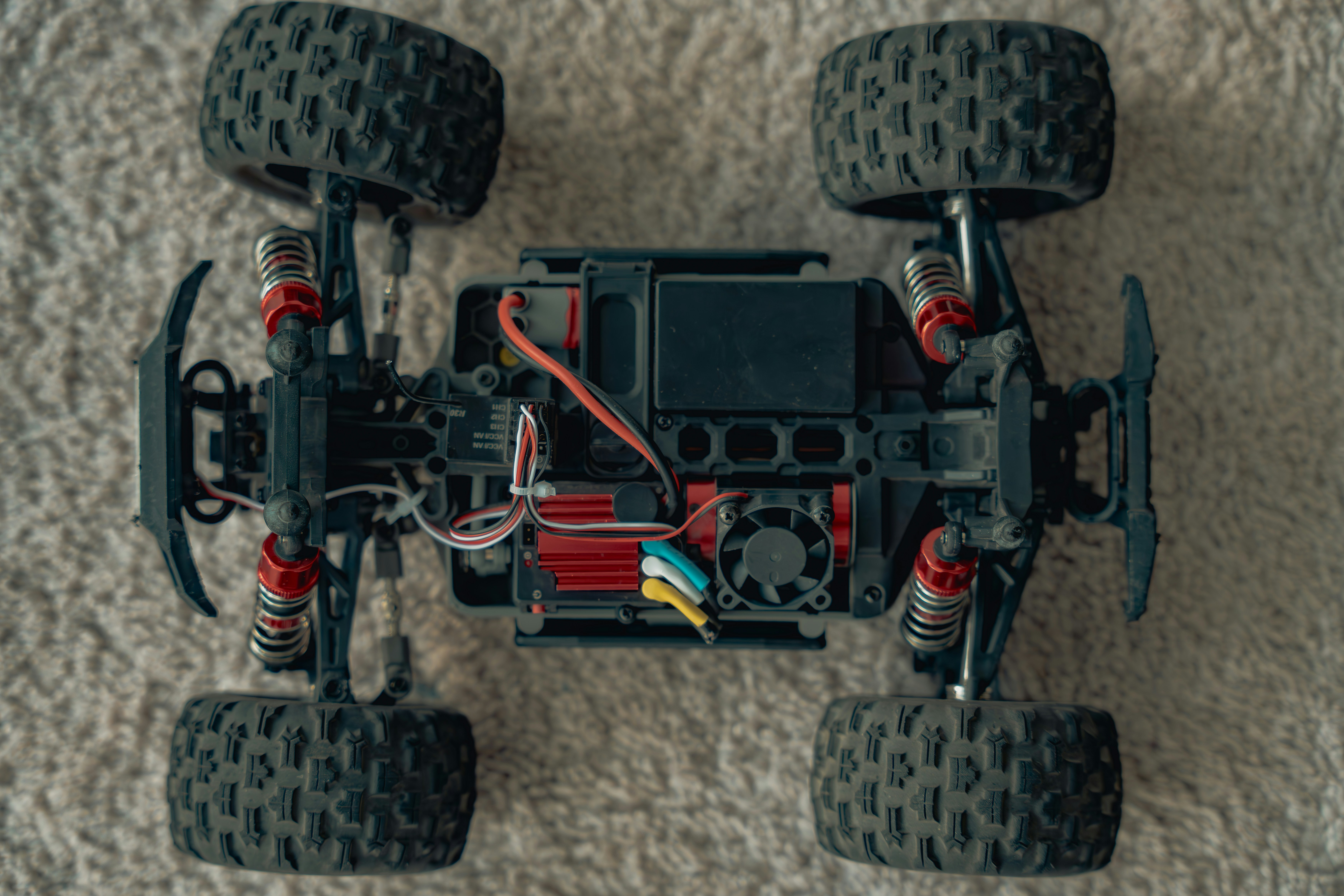

Stack utilizado: LiveKit Agents SDK para WebRTC en tiempo real, OpenAI para STT y LLM, ElevenLabs para TTS y Python 3.11 para la implementación. Resultado final: 7x más rápido en latencia total, 3-8x de mejora en LLM TTFT, 98 por ciento de mejora en latencia de STT en transcripciones posteriores y reducción de costos de hasta 10x al elegir modelos optimizados. Todo ello manteniendo calidad y añadiendo gestión de contexto y capacidades para operar sobre documentos mediante comandos de voz.

El reto: crear un agente que no suene robótico. La línea base humana nos marcó un objetivo ambicioso: tiempos de respuesta humanos promedio alrededor de 236 ms con desviación típica de ~520 ms. Mi implementación inicial tenía latencias totales de 3.9 a 5.5 segundos, con el LLM como cuello de botella principal. Objetivo: acercarse al mejor caso teórico del pipeline, alrededor de 540 ms.

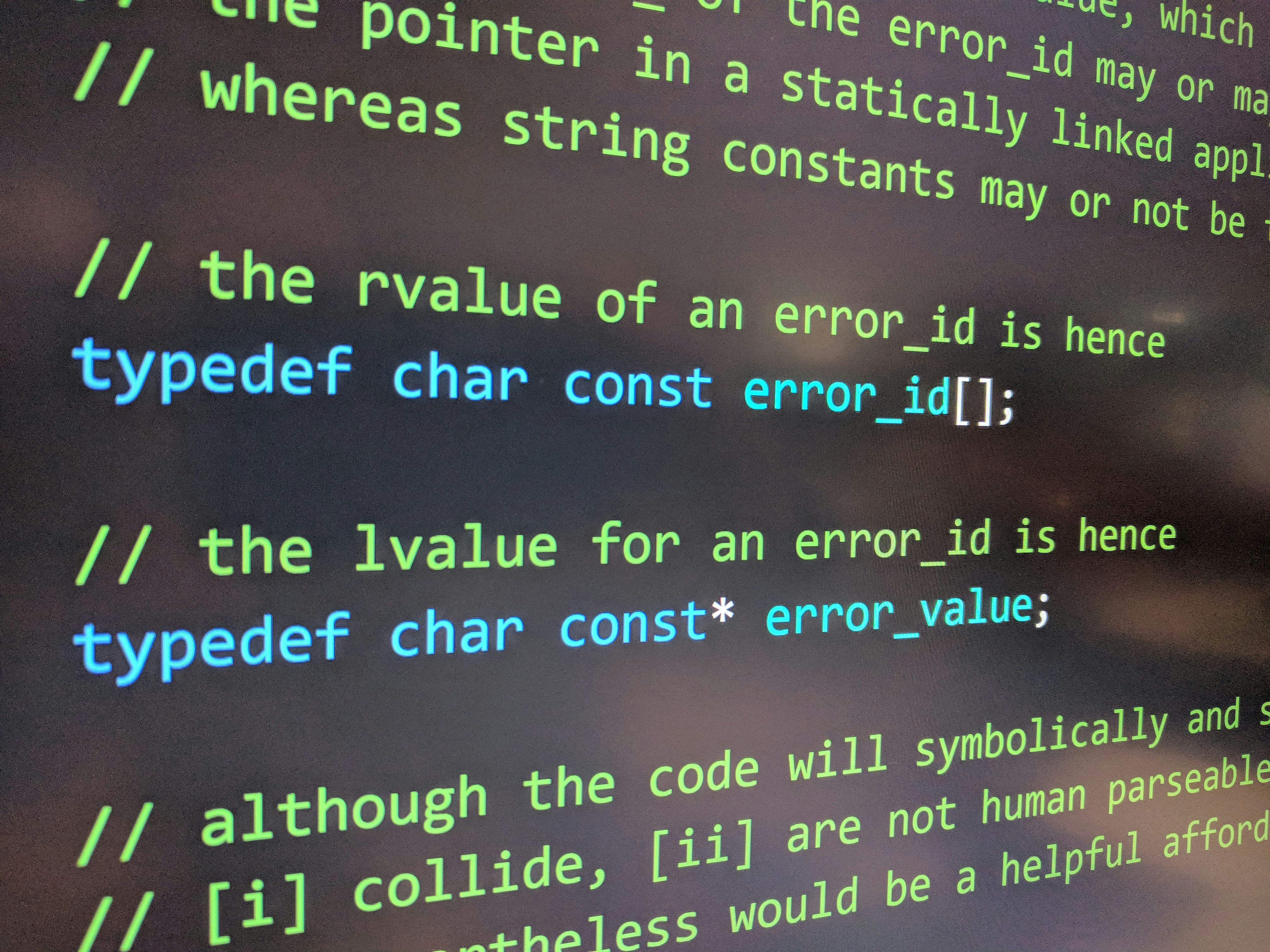

Decisión arquitectónica: adoptamos un enfoque por pipeline STT luego LLM luego TTS en lugar de un modelo end-to-end. Esto dio control fino, flexibilidad para intercambiar modelos y proveedores, y capacidad para depurar y optimizar cada etapa por separado. Para casos reales esto permite priorizar razonamiento del LLM o precisión de STT según la necesidad, por ejemplo reservas de restaurante frente a triage médico.

Fases clave de optimización:

1 Fase inicial: Implementación con Whisper-1 en batch, GPT-4o como LLM y ElevenLabs para TTS. Latencia total alrededor de 5.5 s. Identificamos que el LLM consumía la mayor parte del tiempo.

2 Cambio obvio y contundente: sustituir GPT-4o por gpt-4o-mini. Menor coste, mayor velocidad y consistencia. Resultado inmediato 3-8x más rápido en TTFT y 10x menos coste en muchas interacciones.

3 Streaming en STT: habilitar transcripción en tiempo real redujo la latencia de transcripciones subsiguientes de segundos a centésimas de segundo. Un solo parámetro cambió la experiencia de forma radical y permitió interrupciones y transcripciones parciales en tiempo real.

4 Optimización del prompt de sistema: reducir instrucciones verbosas a un prompt esencial de ~30 tokens redujo costo y latencia sin perder calidad.

5 Selección de modelo STT en tiempo real: cambiar de whisper-1 a un modelo optimizado para realtime mejoró el primer transcript y mantuvo transcripciones subsiguientes casi instantáneas. La elección del modelo es crítica para perfiles de latencia y coste.

6 y 7 Gestión de contexto: implementamos pruning automático, ventana deslizante y resumen asíncrono de mensajes medios para evitar crecimiento descontrolado de tokens. Esto preservó calidad y mantuvo la latencia por debajo de 1 s en conversaciones largas.

8 Integración MCP: conectamos el agente de voz con un servidor MCP para permitir operaciones sobre documentos mediante voz. Para tareas largas usamos heartbeats, llamadas asíncronas en thread pools y manejo de errores específico para evitar timeouts y procesos marcados como no responsivos. Resultado: análisis documentales de más de 57 s sin romper la experiencia conversacional.

Métricas y aprendizaje: instrumentar todo fue clave. Medimos TTFT del LLM, tokens por segundo, duración de STT, TTFB en TTS, tamaño y crecimiento de contexto, eventos de pruning y retrasos de fin de enunciado. TTFT y TTFB resultaron métricas críticas para la percepción del usuario.

Lecciones prácticas: optimización iterativa, cambios simples con gran impacto, selección de modelos según caso de uso, streaming obligatorio, gestión de contexto imprescindible y operaciones asíncronas para no bloquear la conversación. Todo ello orientado por métricas en tiempo real.

Resultados actuales de producción: LLM TTFT promedio 0.699 s, TTS TTFB promedio 0.327 s, STT primer transcript alrededor de 0.824 s y transcripciones subsiguientes 0.010-0.036 s. Latencia total típica 0.9 a 1.2 s con mejores casos cerca de 0.7 s.

En Q2BSTUDIO aprovechamos este conocimiento para ofrecer soluciones de inteligencia artificial adaptadas a empresas, desde agentes IA conversacionales hasta integraciones con sistemas corporativos. Si necesitas desarrollar una solución de software a medida o una aplicación móvil y web que incluya agentes de voz avanzados, podemos ayudarte con experiencia en diseño de pipelines, optimización de latencia y despliegues seguros en servicios cloud aws y azure. Descubre nuestros servicios de IA para empresas en IA para empresas y conoce cómo desarrollamos aplicaciones multiplataforma en desarrollo de aplicaciones y software a medida.

Qué sigue: mejorar la detección de turnos, cachear respuestas frecuentes, soporte multilenguaje, opciones de self-hosting para bajar latencias, integración RAG y un panel de monitorización en tiempo real. En Q2BSTUDIO combinamos experiencia en software a medida, inteligencia artificial, ciberseguridad y Business Intelligence para entregar soluciones completas y seguras, incluyendo power bi y servicios de inteligencia de negocio para transformar datos en valor.

Si quieres optimizar tu propio agente de voz o explorar cómo la IA y la ciberseguridad pueden potenciar tu producto, ponte en contacto con nosotros. En Q2BSTUDIO transformamos ideas en productos escalables, seguros y orientados al negocio.

Comentarios