Construyendo un servidor MCP en Cloudflare Workers con búsqueda semántica

En este artículo explico cómo construir un servidor MCP en Cloudflare Workers que ofrezca búsqueda semántica mediante Vectorize y Workers AI, y cómo adaptar el SDK oficial pensado para transporte stdio a un entorno serverless basado en HTTP. Además incluyo consideraciones prácticas para producción y ejemplos de arquitecturas, todo pensado para equipos que desarrollan aplicaciones a medida y software a medida con inteligencia artificial integrada.

Qué vamos a construir: un servidor MCP que permita a un asistente LLM consultar una base de conocimiento por similitud vectorial en lugar de por palabras clave. El servicio se despliega globalmente en la red de Cloudflare Workers, genera embeddings con Workers AI y realiza búsquedas con Vectorize para obtener resultados en menos de 50 ms desde la mayoría de ubicaciones.

Por qué MCP en Workers: MCP es el protocolo estándar para que asistentes accedan a herramientas y datos externos. El reto es que el SDK oficial usa transporte stdio, útil para desarrollo local con Claude Desktop, pero no válido en entornos serverless. Workers ofrece despliegue en el edge, latencias bajas, integración nativa con AI y Vectorize, ausencia de cold starts gracias a V8 isolates y costes eficientes, ideal para soluciones de inteligencia artificial y agentes IA en producción.

Tres arquitecturas prácticas y cuando usarlas: 1 Local stdio: sirve para desarrollo rápido y debugging local con el SDK oficial. 2 Híbrida puente local a Workers: el servidor local actúa de puente stdio a HTTP y delega embeddings y búsqueda en Workers; buena para usuarios de Claude Desktop que quieren potencia en la nube. 3 Full HTTP en Workers: el MCP corre íntegramente en Workers exponiendo endpoints HTTP; accesible desde web, móvil y APIs; recomendada para SaaS y productos en producción.

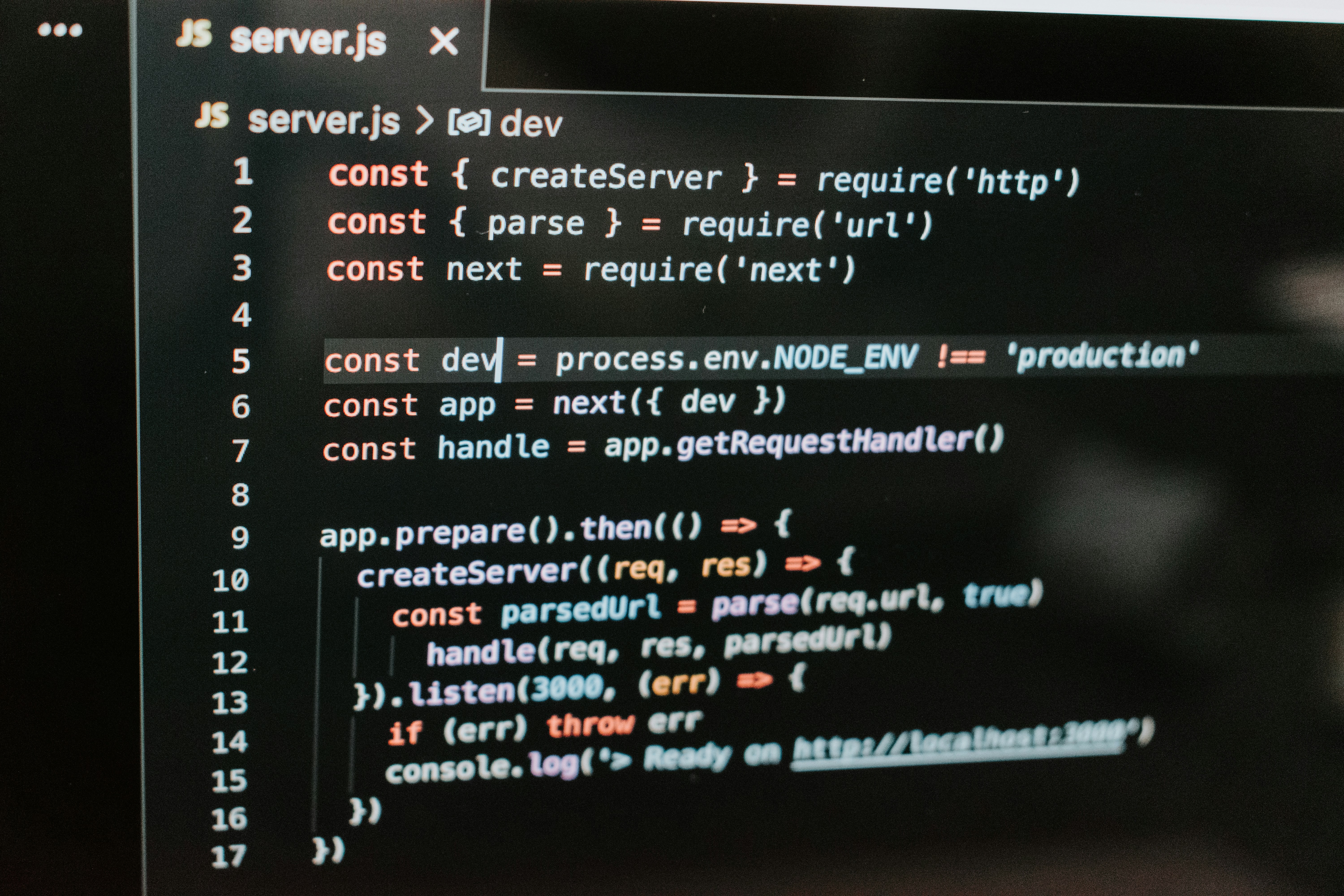

Adaptar el SDK a HTTP: la clave es implementar el protocolo MCP sobre HTTP mapeando llamadas JSON RPC a rutas POST en Workers. En Workers se recibe fetch con request y se enrutan métodos como tools/list y tools/call a handlers que generan embeddings con Workers AI y consultan Vectorize. El flujo general: recibir petición HTTP, parsear método MCP, generar embedding si es necesario, consultar Vectorize, formatear respuesta conforme al esquema MCP y devolver JSON.

Configuración y pasos esenciales: crear un proyecto Worker, añadir bindings de AI y Vectorize, habilitar nodejs_compat para dependencias del SDK si se usa parte del mismo, y configurar un índice Vectorize con dimensiones 384 si se usa bge-small-en-v1.5. Para poblar el índice se generan embeddings para cada documento y se insertan con batching. Recomendación: cachear embeddings frecuentes en KV para reducir costes y latencia.

Rendimiento y costes: Vectorize con HNSW mantiene búsquedas sub 50 ms incluso en decenas de miles de vectores. Workers AI embeddings y Vectorize juntos permiten un coste muy competitivo frente a alternativas centralizadas. Para escalado use particionado, batch inserts y monitorización.

Consideraciones de producción: autenticación de requests, rate limiting con Durable Objects, cache en KV, monitorización con Workers Analytics Engine, y pruebas de latencia desde distintas regiones. Estas prácticas son clave cuando se entrega software a medida para clientes o se integran agentes IA en productos empresariales.

Ejemplos de uso y negocio: un bot de soporte con conocimiento interno, asistentes de código con repositorios indexados, herramientas de investigación con datos especializados, y aplicaciones empresariales que necesitan IA para empresas y servicios de inteligencia de negocio integrados con Power BI. Si su organización necesita integrar modelos en el edge, Q2BSTUDIO puede ayudar con desarrollo de aplicaciones y software a medida y con la integración de soluciones de Inteligencia artificial y despliegues en servicios cloud aws y azure.

Sobre Q2BSTUDIO: somos una empresa de desarrollo de software especializada en aplicaciones a medida, inteligencia artificial, ciberseguridad y servicios cloud. Ofrecemos soluciones de software a medida para integrar agentes IA, proyectos de power bi y servicios de inteligencia de negocio, además de auditorías y pentesting para garantizar seguridad y cumplimiento. Si busca un partner para construir un MCP en el edge, integrar Vectorize o desplegar agentes IA dentro de su infraestructura cloud, podemos apoyarle desde el diseño hasta la puesta en producción.

Conclusión y próximos pasos: MCP en Cloudflare Workers convierte implementaciones locales en servicios accesibles globalmente con baja latencia. Construya primero una prueba local, luego un puente híbrido si necesita compatibilidad con Claude Desktop, y finalmente migre a un MCP full HTTP en Workers para producción. Añada autenticación, rate limiting, caching y monitorización, y aproveche las capacidades de ia para empresas y agentes IA para crear experiencias de búsqueda semántica y automatización robustas. Para más información sobre cómo podemos ayudar en un proyecto a medida, contacte con Q2BSTUDIO y explore nuestras capacidades en inteligencia artificial, ciberseguridad y servicios cloud.

Comentarios