Construyendo Modelos de Regresión en R Utilizando Regresión de Vectores de Soporte SVR

La regresión es una de las técnicas fundamentales en el modelado estadístico y en machine learning; permite predecir variables continuas a partir de una o varias variables de entrada. Aunque modelos clásicos como la Regresión Lineal Simple han sido ampliamente usados para relaciones lineales, los conjuntos de datos modernos suelen mostrar patrones no lineales que requieren métodos más flexibles. La Regresión de Vectores de Soporte SVR, derivada de las Máquinas de Vectores de Soporte SVM, es una alternativa potente para capturar esa complejidad. A continuación presentamos una explicación completa y práctica sobre cómo construir modelos de regresión en R usando SVR, su origen, comparativa con la regresión lineal, aplicaciones reales, casos de estudio y recomendaciones de implementación.

Origen y fundamento de Support Vector Regression

La Regresión de Vectores de Soporte nace de los mismos principios teóricos que SVM, desarrollados por Vladimir Vapnik y Alexey Chervonenkis. Mientras SVM se concibió inicialmente para clasificación, el principio central de maximizar el margen se adaptó a problemas de regresión. En SVR no se busca minimizar el error cuadrático por cada observación; en su lugar se construye una función que aproxima los datos dentro de una banda de tolerancia definida por epsilon, penalizando solo las desviaciones que exceden ese margen mediante el parámetro C. Gracias al truco del kernel, SVR puede operar en espacios de alta dimensión y modelar relaciones no lineales sin transformar explícitamente las variables originales.

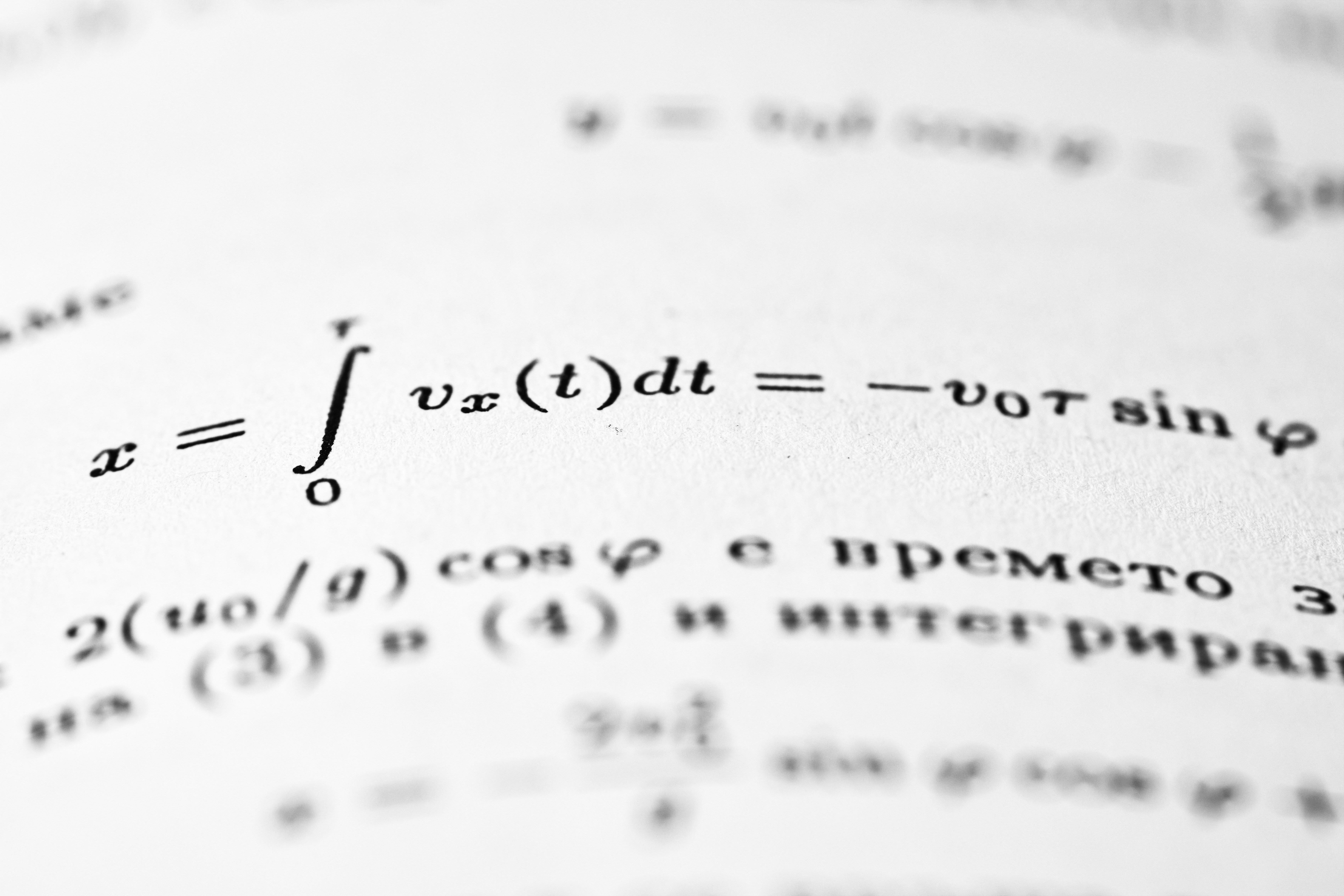

Breve repaso de la Regresión Lineal Simple

La Regresión Lineal Simple modela la relación lineal entre una variable independiente X y una dependiente Y con la ecuación Y = a + bX + e. Este enfoque, optimizado por mínimos cuadrados ordinarios OLS, asume linealidad, errores normalmente distribuidos, homocedasticidad y ausencia de colinealidad cuando se extiende a múltiples variables. Si la relación es claramente no lineal o la varianza de los errores cambia según X, la regresión lineal puede subestimar la complejidad real del problema.

Por qué SVR supera a la regresión lineal en muchos casos

SVR ofrece ventajas clave frente a la regresión lineal tradicional: maneja la no linealidad de forma natural mediante kernels como RBF y polinómico; es más robusta frente a valores atípicos porque solo penaliza errores que superan la banda epsilon; emplea un enfoque de margen que favorece la generalización en lugar de ajustar cada punto; y exige menos suposiciones sobre la distribución de los datos, actuando como un método no paramétrico en la práctica.

Implementación conceptual en R

Un flujo de trabajo habitual para comparar SLR y SVR en R incluye: carga y visualización de datos; ajuste de un modelo SLR y evaluación con métricas como RMSE; ajuste de un SVR usando paquetes como e1071 y evaluación inicial; comparación de RMSE entre modelos; y afinado de parámetros mediante búsqueda en rejilla para seleccionar el mejor modelo. Aunque este artículo no incluye código literal, ese esquema sirve de hoja de ruta para quienes comienzan a desarrollar modelos robustos en R.

Aplicaciones reales donde SVR brilla

SVR es ampliamente usado en sectores donde la relación entre variables es compleja y ruidosa: en finanzas para predecir precios de acciones, volatilidad y métricas de riesgo; en salud para estimar progresión de enfermedades o tasas de crecimiento tumoral; en energía para forecasting de carga, precios eléctricos y producción renovable; en marketing para modelar valor del cliente y demanda; y en ingeniería para predecir desgaste de máquinas y calidad de producto a partir de sensores. Su capacidad para capturar patrones no lineales y protegerse de outliers la hace muy útil en escenarios reales.

Casos de estudio ilustrativos

Case study 1: Predicción de precios de vivienda. Un modelo SLR presentó un RMSE alto al no capturar relaciones curvas entre metros cuadrados y precio. Un SVR con kernel RBF redujo significativamente el RMSE y, tras tuning, mejoró aún más al identificar efectos de prima en ciertos rangos de propiedad. Case study 2: Forecasting de energía solar. Dadas las dinámicas cíclicas y no lineales de la radiación solar, SVR con RBF obtuvo predicciones más precisas que SLR, especialmente tras ajustar parámetros para captar la estacionalidad. Case study 3: Comportamiento de compra del cliente. En retail, donde la demanda responde a promociones, estacionalidad y patrones complejos, SVR ofreció ajustes más suaves y predicciones más útiles para reducir roturas de stock y exceso de inventario.

Parámetros clave y afinado

El tuning es crítico para obtener buen desempeño con SVR. Los dos parámetros principales son epsilon, que controla la banda de tolerancia y afecta el sesgo del modelo, y C, que penaliza las desviaciones fuera de esa banda y regula la complejidad. Una búsqueda en rejilla bien diseñada sobre combinaciones de epsilon y C, posiblemente junto con la parametrización del kernel como gamma en RBF, suele mejorar las métricas de error y la capacidad de generalización. En ejemplos prácticos, el tuning puede reducir RMSE de manera notable, demostrando el valor de la optimización sistemática.

Recomendaciones prácticas

Antes de aplicar SVR es recomendable explorar y visualizar los datos, normalizar o estandarizar las variables cuando se usan kernels, reservar conjuntos de validación para tuning y emplear métricas robustas como RMSE y MAE. Para producción, considerar pipelines que incluyan preprocesamiento reproducible, validación cruzada y monitorización del rendimiento para detectar deriva de datos.

Por qué elegir Q2BSTUDIO para proyectos con SVR y soluciones avanzadas

En Q2BSTUDIO somos una empresa de desarrollo de software especializada en aplicaciones a medida, software a medida e inteligencia artificial aplicada a negocio. Ayudamos a empresas a llevar modelos como SVR desde la experimentación hasta soluciones productivas escalables, integrando prácticas de DevOps y despliegue en servicios cloud. Podemos acompañar su proyecto con servicios de ciberseguridad, pruebas de penetración y endurecimiento de entornos para proteger modelos y datos. Si necesita desarrollar una plataforma que incorpore modelos predictivos, agentes IA o soluciones de IA para empresas, nuestro equipo diseña e implementa arquitecturas seguras y escalables. Con experiencia en integración con plataformas en la nube, también ofrecemos despliegues en servicios cloud aws y azure y capacidad para integrar pipelines de inteligencia de negocio y visualización con Power BI.

Servicios complementarios y posicionamiento

Ofrecemos desde la creación de soluciones de software a medida y aplicaciones a medida hasta la implementación de servicios de inteligencia de negocio, integración con Power BI, automatización de procesos y desarrollo de agentes IA personalizados. Nuestras soluciones consideran seguridad, escalabilidad y operaciones, sumando capacidades en ciberseguridad para proteger los activos digitales y los modelos de machine learning.

Conclusión

Support Vector Regression es una técnica poderosa y versátil, especialmente indicada para conjuntos de datos no lineales o ruidosos. Frente a la Regresión Lineal Simple, SVR aporta mayor flexibilidad, robustez frente a outliers y mejor generalización cuando se aplica correctamente y se afina. Para empresas que buscan aprovechar inteligencia artificial aplicada, automatizar decisiones o desplegar modelos predictivos en producción, Q2BSTUDIO ofrece servicios integrales de desarrollo, seguridad y cloud que permiten transformar modelos estadísticos en valor tangible.

Contacte con nosotros para evaluar su caso y diseñar una solución a medida que combine modelos como SVR con arquitectura segura, despliegue en cloud y visualización de resultados con herramientas de inteligencia de negocio.

Comentarios