Construyendo un Chatbot impulsado por la memoria con LangGraph: Una guía para estudiantes sobre la IA conversacional

Construyendo un Chatbot impulsado por la memoria con LangGraph: Una guía para estudiantes sobre la IA conversacional

En este artículo aprenderás cómo funcionan la memoria y la gestión del contexto en chatbots tipo ChatGPT y cómo construir una aplicación completa usando LangGraph que demuestre dos estrategias de memoria: temporal en memoria RAM y persistente respaldada por base de datos. Esta guía es ideal si eres estudiante o desarrollador que quiere dominar conceptos clave de inteligencia artificial conversacional y aplicarlos en proyectos reales.

Por qué la memoria importa en la IA conversacional: cuando interactúas con un agente conversacional cada mensaje requiere contexto de mensajes previos. Sin memoria cada interacción sería aislada y el agente no recordaría nombre, preferencias ni el hilo de la conversación. La memoria cumple dos funciones principales: preservación de contexto para referenciar mensajes anteriores y gestión de estado para seguir el flujo de la conversación y mantener preferencias del usuario entre sesiones.

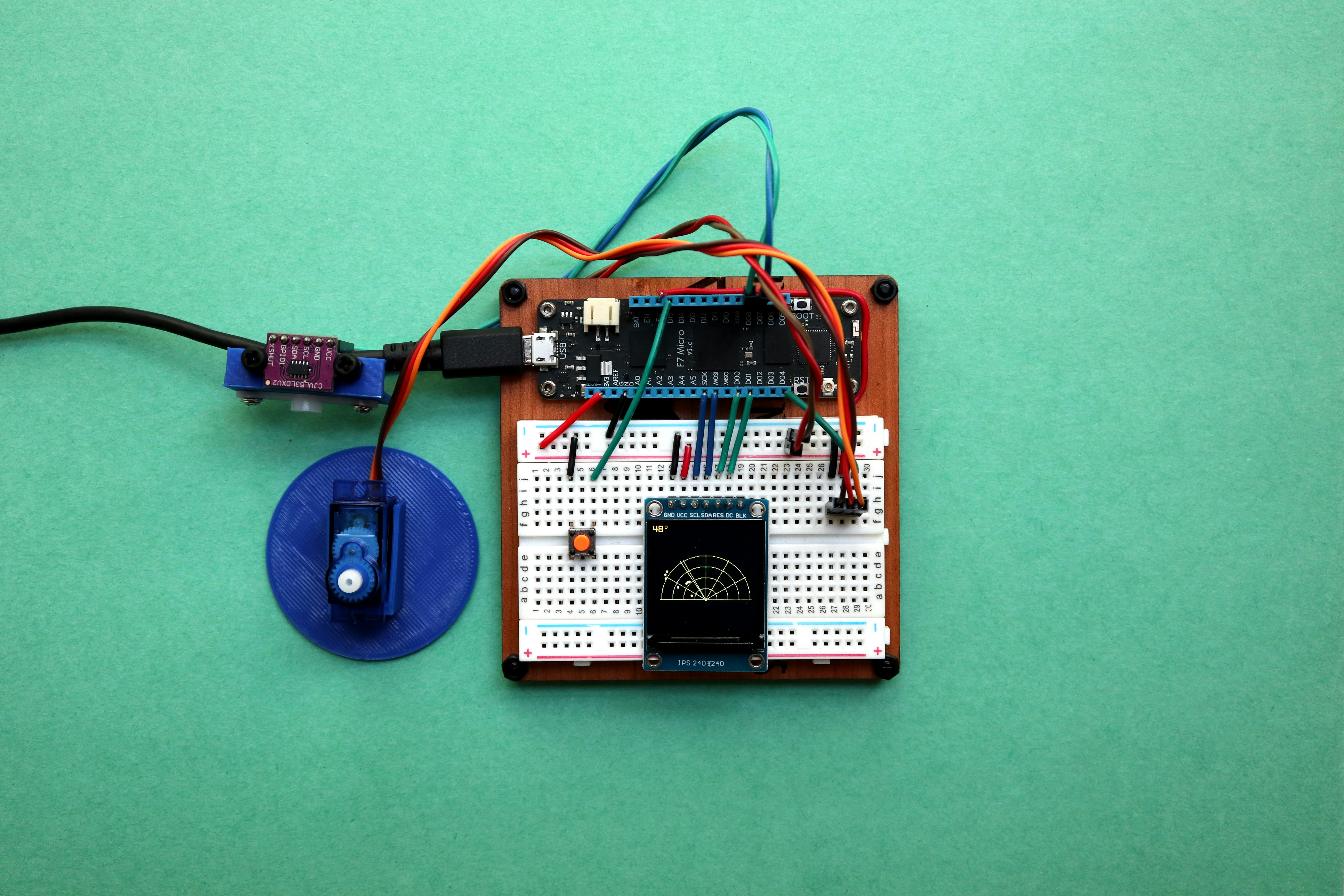

Arquitectura del proyecto: la aplicación se organiza de forma modular para separar responsabilidades. Un frontend ligero envía mensajes a un backend en FastAPI que invoca un workflow de LangGraph. El flujo típico es: entrada del usuario, backend FastAPI, workflow LangGraph, almacenamiento de memoria y respuesta. LangGraph se encarga de procesar mensajes, decidir si usar herramientas externas y persistir el estado mediante componentes llamados checkpointers.

Modos de memoria: LangGraph permite cambiar entre dos checkpointers principales. MemorySaver mantiene el estado en RAM, ideal para pruebas y conversaciones efímeras, rápido pero volátil. SqliteSaver persiste el estado en SQLite, sobreviviendo reinicios del servidor y listo para entornos de producción donde la retención de conversaciones es necesaria. Elegir el checkpointer adecuado es crítico según el caso de uso.

Diseño del estado de conversación: define un contenedor de estado que incluya la lista de mensajes y el input del usuario. Usar reductores que fusionen automáticamente mensajes hace más sencilla la carga y persistencia de historiales. En LangGraph se usan checkpointers junto con un identificador de hilo o session_id para cargar y guardar el estado de la conversación sin que el desarrollador tenga que gestionarlo manualmente.

Flujo típico al recibir un mensaje: 1 Carga de estado mediante thread_id; 2 Inserción del nuevo mensaje; 3 Llamada al modelo con el contexto completo; 4 Guardado del estado actualizado en el checkpointer. Gracias a esa abstracción es posible invocar el workflow con una lista de mensajes vacía y confiar en que LangGraph recuperará el historial asociado a la sesión.

Construcción de la lógica conversacional: el nodo de respuesta carga y recorta el histórico, decide si usar herramientas externas como consultas a Wikipedia o servicios meteorológicos, invoca el LLM y devuelve los mensajes a persistir. Es recomendable evitar duplicar el mensaje del usuario y manejar casos donde una herramienta ya produjo una respuesta reciente.

Gestión de tokens y recorte de contexto: para no superar la ventana de contexto del modelo conviene recortar mensajes manteniendo los más recientes. Utilizar utilidades de recorte que cuenten tokens de forma precisa con el modelo elegido asegura que las conversaciones largas no provoquen errores por exceso de contexto.

Enrutamiento condicional y uso de herramientas: LangGraph permite rutas condicionales en el grafo. Por ejemplo solo dirigir el flujo a un nodo de herramientas si el último mensaje AI contiene llamadas a herramientas. Esto habilita workflows dinámicos donde el agente puede alternar entre conversación pura y llamadas a APIs externas para enriquecer respuestas.

Despliegue y pruebas: arranca el backend con uvicorn y un UI ligero como Streamlit para probar ambos modos de memoria. En modo temporal las conversaciones se pierden al recargar, en modo persistente se almacenan en SQLite y sobreviven reinicios, útil para demos y para producción respectivamente.

Buenas prácticas y recomendaciones para estudiantes: usa checkpointers para abstraer la gestión de estado; diseña bien el ChatState para controlar qué se recuerda; implementa recorte de mensajes para gestionar tokens; y aprovecha enrutamiento condicional para integrar herramientas y flujos complejos.

Cómo encaja Q2BSTUDIO: en Q2BSTUDIO somos especialistas en desarrollo de software y aplicaciones a medida, con experiencia en inteligencia artificial aplicada a empresas y soluciones seguras y escalables. Si buscas llevar este tipo de proyectos a producción podemos ayudarte con arquitectura, integración de agentes IA, servicios cloud y seguridad. Para proyectos de inteligencia artificial y consultoría en IA te invitamos a conocer nuestros servicios de inteligencia artificial en Q2BSTUDIO Inteligencia Artificial. Si lo que necesitas es crear una aplicación o software a medida tenemos experiencia completa en ciclo de vida de producto y desarrollo multiplataforma en desarrollo de aplicaciones y software a medida.

Palabras clave y servicios relacionados: nuestro equipo ofrece servicios orientados a aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA y power bi. Además trabajamos en integración con pipelines cloud, automatización de procesos y despliegues seguros para entornos productivos.

Pasos siguientes sugeridos: empieza con un chatbot básico sin memoria; añade memoria temporal con MemorySaver; evoluciona a SqliteSaver para persistencia; integra herramientas externas y optimize el recorte de contexto; y finalmente incorpora autenticación y soporte multiusuario para entornos reales.

Conclusión: implementar memoria en chatbots es una habilidad esencial en la IA conversacional. LangGraph ofrece abstracciones potentes como checkpointers para que te centres en la lógica conversacional y no en el boilerplate de estado. Con una estrategia dual de memoria temporal y persistente puedes adaptar tu solución desde pruebas rápidas hasta aplicaciones en producción. Si quieres acompañamiento técnico para llevar tu idea a producción, Q2BSTUDIO puede aportar experiencia en desarrollo personalizado, ciberseguridad y despliegue cloud para que tu agente IA sea robusto y escalable.

Si te resultó útil esta guía comparte el proyecto, prueba los ejemplos y considera explorar más integraciones y optimizaciones para crear agentes IA avanzados y adaptados a casos de uso empresariales.

Comentarios