Cómo construí un servidor MCP para crear mi propia guía de estilo de escritura experta AI

Como redactor técnico mi trabajo gira en torno a las guías de estilo corporativas. Estas guías son mi referencia básica en cada empresa donde trabajo y condicionan cómo redacto la documentación técnica, APIs o CLIs. El problema común es que una guía de estilo suele ser un PDF extenso que interrumpe el flujo de trabajo: buscar si se permite usar contracciones, si hace falta coma antes de la conjunción y, en general, cómo formatear direcciones IP o términos sensibles consume tiempo y rompe la concentración.

En Q2BSTUDIO, empresa especializada en desarrollo de software a medida, aplicaciones a medida, inteligencia artificial, ciberseguridad y servicios cloud aws y azure, diseñamos una solución práctica: construir un servidor MCP que lea la guía de estilo corporativa y responda preguntas al instante dentro de herramientas como Claude Desktop y VS Code. El objetivo fue sencillo: dejar de jugar a detective con Ctrl+F y consultar la guía desde el flujo de trabajo habitual.

Qué es MCP y por qué usarlo. MCP actúa como un puerto universal para modelos IA similar a un puerto USB para dispositivos. En lugar de hacer integraciones puntuales para cada cliente o editor, se crea un servidor MCP una sola vez y cualquier cliente compatible lo puede usar. Eso permite que Claude, VS Code o editores como Zed conecten con la misma fuente de conocimiento sin desarrollar conectores distintos cada vez.

Arquitectura y principios. La implementación se basa en RAG, es decir Retrieval Augmented Generation, que recupera fragmentos relevantes de una fuente externa antes de generar la respuesta. La fuente en este caso es el archivo writing-style-documentation.pdf. Los cuatro componentes principales son: archivo fuente con la guía, un procesador que divide el PDF en fragmentos, un vector store con FAISS para búsquedas semánticas y un modelo de lenguaje que genera las respuestas basadas en el contexto recuperado.

Resumen del flujo: se extrae el texto del PDF con un loader adecuado, se parte en fragmentos manejables con un text splitter con solape para conservar contexto, se crean embeddings con un modelo ligero de HuggingFace para indexar en FAISS y, finalmente, un LLM hospedado en Groq con Llama 3 procesa las consultas junto con los fragmentos relevantes para devolver respuestas citando el pasaje o la página cuando sea posible.

Pasos para construir el servidor MCP. Requisitos previos: conocimientos básicos de Python y conceptos de Agentic AI. Paso 1 configurar el proyecto creando un entorno virtual, instalar dependencias clave como mcp, langchain, langchain-community, langchain-groq, sentence-transformers, langchain-huggingface, pypdf, faiss-cpu, python-dotenv y uvicorn, y preparar un archivo .env con la clave de Groq.

Paso 2 configurar el motor RAG. Crear un script rag.py que cargue variables de entorno, valide la existencia del PDF, cargue el documento con un loader de PDFs, divida el contenido en fragmentos con RecursiveCharacterTextSplitter usando tamaños y solape que preserven contexto, genere embeddings con el modelo all-MiniLM-L6-v2 y cree un índice FAISS para búsquedas rápidas. Configurar el LLM de Groq con el modelo Llama 3.3 70B y temperatura cero para respuestas deterministas y crear una cadena RetrievalQA que recupere los k fragmentos más relevantes, por ejemplo k igual a 5, y devuelva documentos fuente cuando sea necesario.

Paso 3 funciones de consulta y manejo de errores. Implementar una función que inicialice el pipeline RAG si no está listo, capture errores de inicialización y que invoque la cadena de QA para procesar consultas. Esta función debe devolver la respuesta generada o un mensaje descriptivo en caso de fallo. Añadir una prueba simple que consulte las reglas sobre el uso de contracciones para verificar que el pipeline devuelve las normas esperadas de la guía.

Paso 4 el servidor MCP. La cara pública de la herramienta se implementa con FastMCP y expone un tool llamado ask_writing_style_guide que acepta una pregunta y delega en la función de consulta del módulo RAG. Menos de 30 líneas de código pueden bastar para el servidor en sí, el resto es la lógica de procesamiento y recuperación.

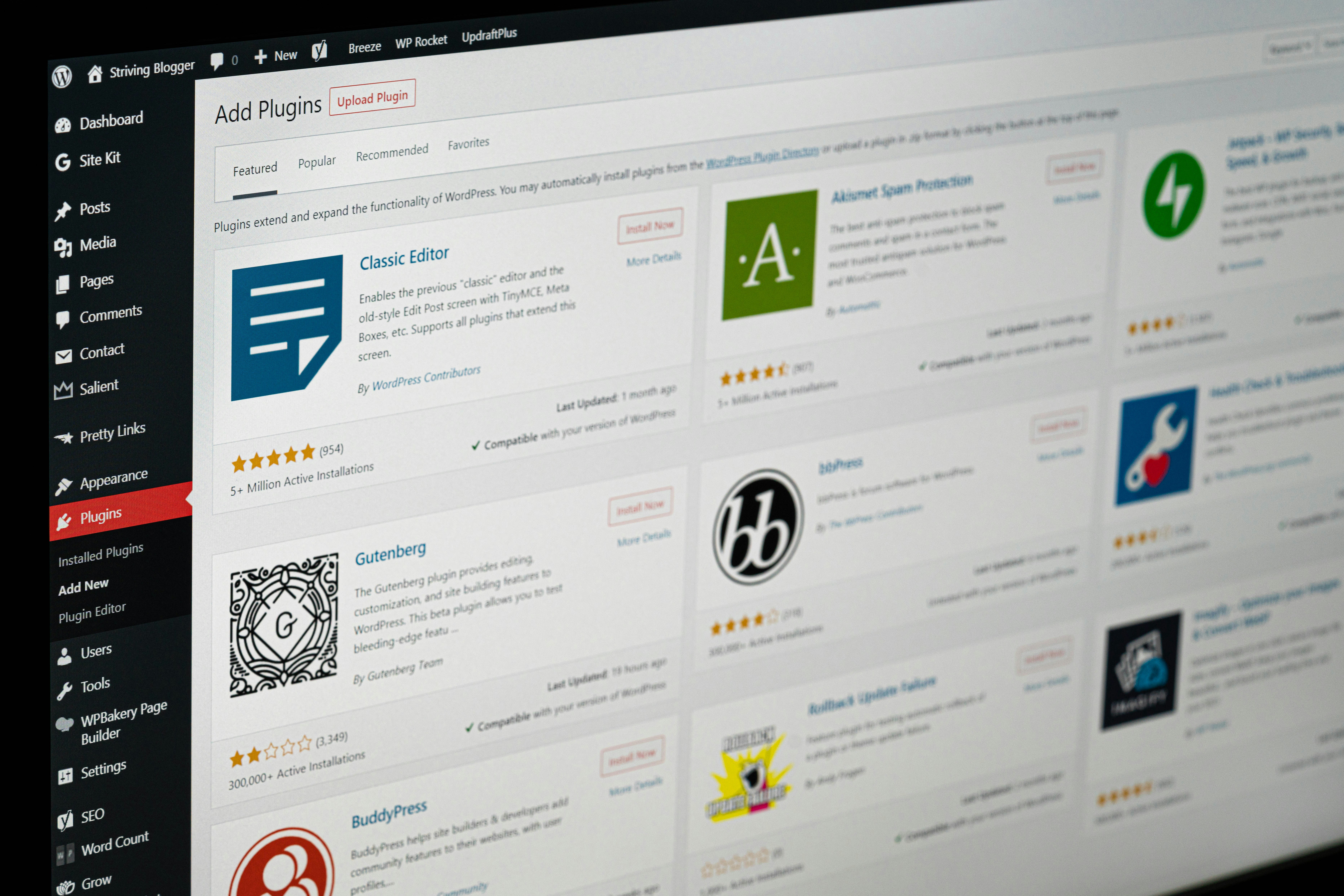

Conexión con Claude Desktop y editores. En Claude Desktop se añade la entrada de MCP Servers en la configuración de desarrollador indicando el comando python del entorno virtual y el script del servidor MCP. De este modo, al chatear con Claude se pueden invocar herramientas específicas y obtener respuestas directas desde la guía sin salir del editor. Lo mismo aplica para integraciones con VS Code u otros clientes compatibles con MCP.

Ejemplo de uso en el flujo de trabajo. Imagina estar redactando documentación y preguntar si se puede usar el término slave. Claude llama a la herramienta, la herramienta consulta la guía en el índice FAISS y responde con la regla precisa y la página correspondiente. Todo sin abandonar el editor, lo que acelera la documentación técnica y reduce errores terminológicos.

Beneficios para empresas y cómo Q2BSTUDIO puede ayudar. Implementar un servidor MCP para una guía de estilo es una tarea de integración y orquestación que añade un valor enorme: convierte documentación estática en conocimiento accionable para asistentes IA y agentes IA en la organización. En Q2BSTUDIO ofrecemos servicios para diseñar este tipo de soluciones dentro de proyectos de software a medida y aplicaciones a medida, así como la integración con arquitecturas cloud y políticas de seguridad. Si quieres llevar la capacidad de consultar conocimiento corporativo desde tu asistente IA podemos ayudarte con el diseño e implementación y con la seguridad y gobernanza necesarias.

Además, proveemos servicios complementarios que potencian estas integraciones, como migración y despliegue en servicios cloud aws y azure, auditorías de ciberseguridad y pentesting para proteger los endpoints de consulta, y soluciones de inteligencia de negocio y Power BI para explotar el conocimiento estructurado en métricas y reportes. Si lo que buscas es incorporar capacidades de IA a tus procesos, nuestros equipos trabajan en IA para empresas y agentes IA que conectan conocimiento interno con modelos conversacionales y pipelines RAG.

Conclusión. Crear un servidor MCP para una guía de estilo es accesible y transforma la forma en que los equipos técnicos consultan normas y ejemplos. No es magia, es principalmente código de integración y buenas prácticas de RAG y gobernanza de datos. En Q2BSTUDIO combinamos experiencia en desarrollo de software a medida, inteligencia artificial, ciberseguridad y servicios cloud para entregar soluciones que aumentan la productividad y reducen fricción en procesos de documentación y soporte. Si te interesa explorar una implementación personalizada podemos ayudarte a diseñarla e integrarla con tu stack actual, desde el índice FAISS hasta la orquestación de agentes y la visualización con Power BI a través de nuestros servicios de software a medida

Comentarios