Identificación y priorización de riesgos automatizada a través de la dinámica de grafos semánticos de conocimiento

Resumen: Este artículo describe un sistema automatizado para la identificación de peligros y priorización de riesgos durante operaciones de entrada en espacios confinados, basado en la dinámica de grafos semánticos de conocimiento. El enfoque integra datos en tiempo real de sensores, registros históricos de incidentes y técnicas avanzadas de inteligencia artificial para ofrecer una evaluación de riesgos continua, explicable y adaptable. Q2BSTUDIO, empresa especializada en desarrollo de software a medida, aplicaciones a medida, inteligencia artificial, ciberseguridad y servicios cloud aws y azure, presenta este enfoque como parte de su oferta de soluciones para la industria y la seguridad operacional.

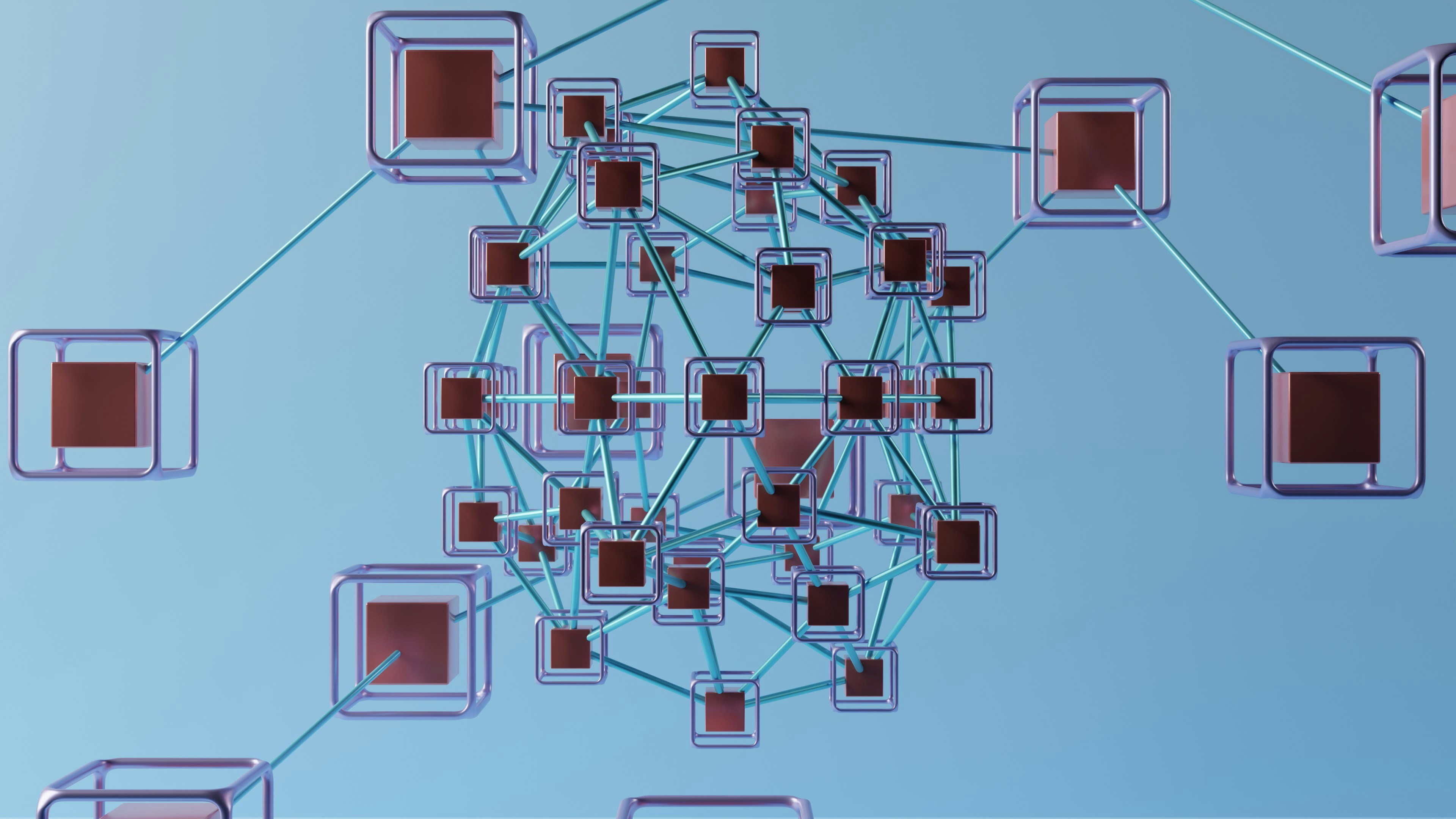

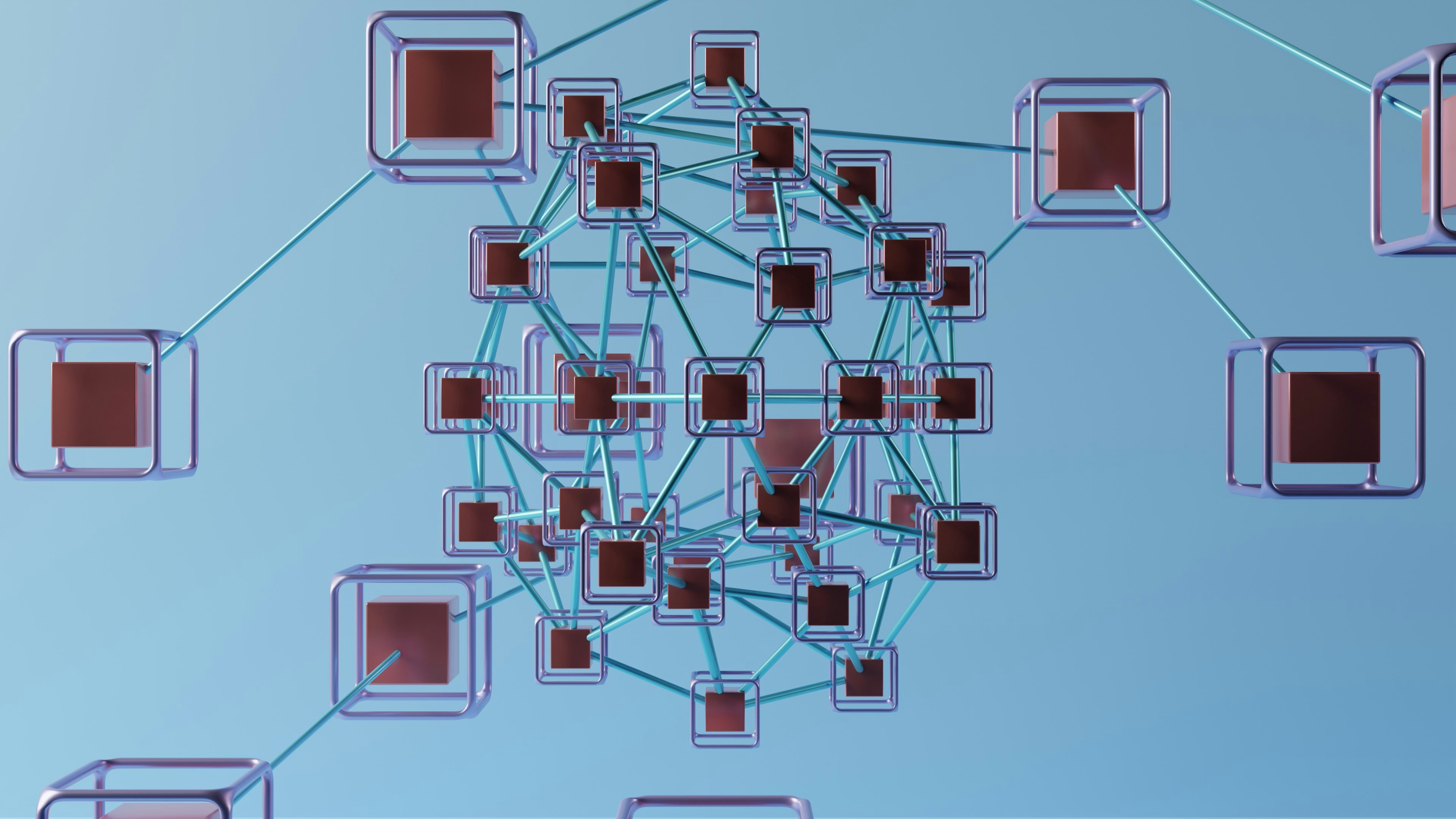

Introducción: Las metodologías tradicionales de seguridad en espacios confinados se apoyan en checklists y evaluaciones humanas que pueden ser estáticas, inconsistentes y lentas para reaccionar ante cambios en tiempo real. La propuesta reemplaza o complementa esas prácticas con un grafo semántico de conocimiento dinámico que modela entidades relevantes, relaciones causales y evidencia empírica. Esto permite detectar riesgos emergentes, priorizar acciones y alimentar bucles de aprendizaje continuo mediante técnicas de machine learning, graph embedding y aprendizaje por refuerzo.

Construcción del grafo semántico y actualización: Definimos el grafo de conocimiento como G = (V, E, L) donde V es el conjunto de nodos que representan entidades como tipo de espacio confinado, condiciones atmosféricas, equipos, roles de personal y registros de incidentes; E es el conjunto de aristas dirigidas que modelan relaciones semánticas del tipo causado por, requiere, interactúa con o localizado en; L es la función que etiqueta cada arista con su tipo semántico. Cada nodo v dispone de un vector de características x_v en R^d con atributos como tamaño, material, capacidad, límites operativos y última inspección. Cada arista e tiene un peso probabilístico w_e en el intervalo [0,1] que expresa la fuerza o confiabilidad de la relación.

Actualización probabilística: Nuevos datos provenientes de sensores, reportes de casi accidentes y resultados de investigaciones se incorporan mediante un motor de razonamiento probabilístico. Se utiliza una estructura de red bayesiana que actualiza pesos w_e con reglas tipo Bayes: P(w_e | evidencia) proporcional a P(evidencia | w_e) * P(w_e). La estructura de la BN puede aprenderse automáticamente desde datos históricos mediante algoritmos basados en restricciones y heurísticas, y los parámetros se ajustan por máxima verosimilitud o inferencia bayesiana con priors informados por expertos.

Identificación de peligros: Para una tarea de entrada concreta se extrae un subgrafo G_task de G con todas las entidades y relaciones relevantes. La identificación inicial de peligros se logra mediante análisis topológico y embeddings del grafo. Se calculan medidas como centralidad de grado, centralidad de intermediación y puntuaciones de similitud derivadas de embeddings (por ejemplo Node2Vec) para detectar nodos con alta probabilidad de implicación en escenarios peligrosos. Embeddings v_i = f(vecindario(node i)) transforman cada nodo en un vector que captura contexto estructural y semántico, mejorando la detección de riesgos incluso cuando las relaciones no son explícitas.

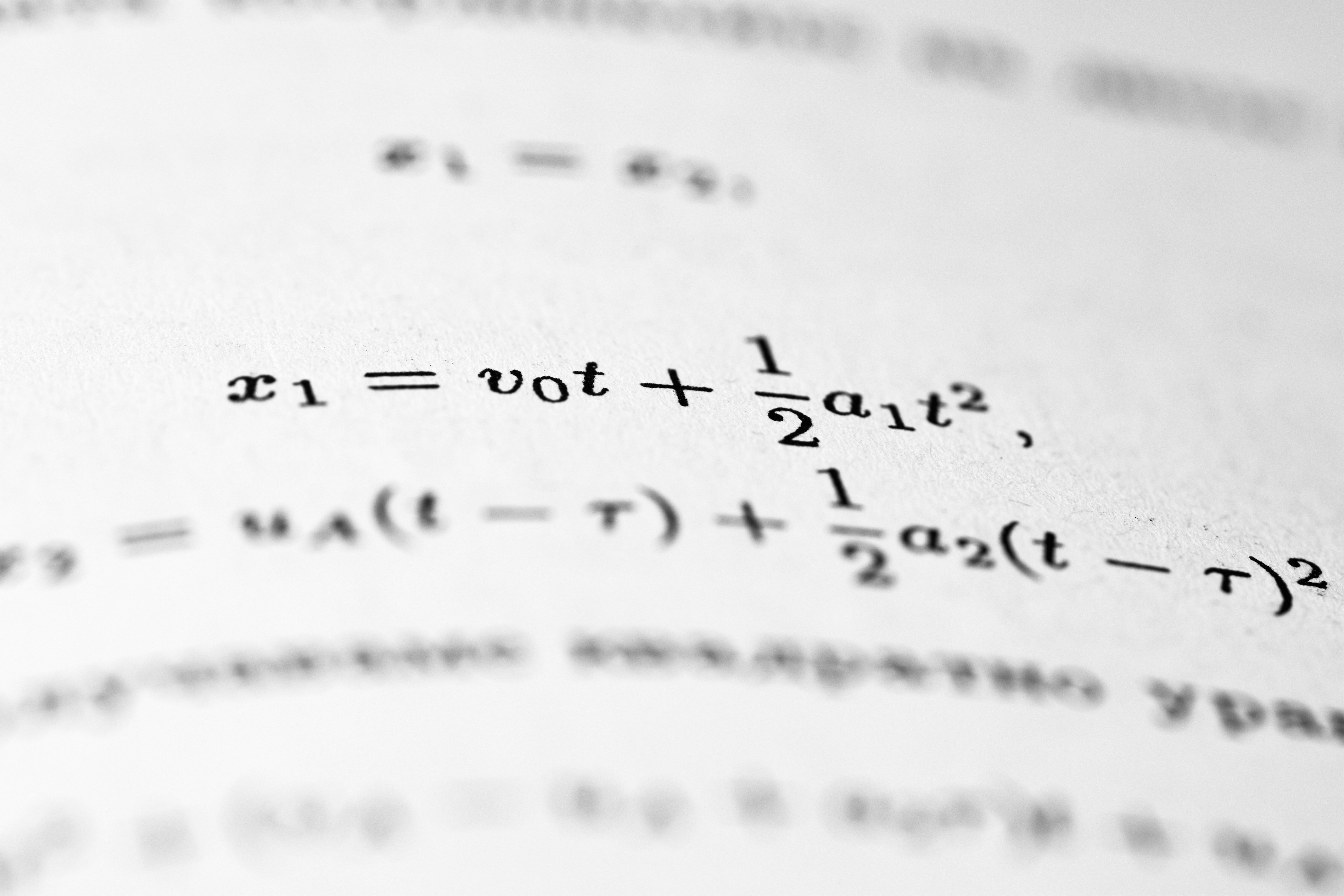

Priorización de riesgos: A cada peligro i se le asigna una puntuación de riesgo R_i definida por la fórmula R_i = P_i * S_i * N_i. Aquí P_i es la probabilidad estimada de ocurrencia basada en la frecuencia y evidencia en el KG y actualizaciones bayesianas, S_i es la severidad de la consecuencia según guías de seguridad ajustadas por contexto, y N_i es un factor de propagación que cuantifica el número y la criticidad de los caminos que conectan el peligro con fallas o incidentes en el grafo. En términos prácticos P_i se calcula como una función agregada de los pesos w_e salientes del nodo peligro, normalizados por la suma total de pesos relevantes. La severidad S_i puede ser una escala ordinal mapeada a valores numéricos y ajustada por contexto usando S_i := S_base + k * S(path_length(hazard, incident)). El parámetro k controla la contribución de la distancia topológica a la severidad.

Aprendizaje por refuerzo para ajuste dinámico: Un agente de aprendizaje por refuerzo afina pesos de aristas y parámetros de puntuación basándose en retroalimentación en tiempo real y métricas históricas. Definimos el estado S como la configuración actual del KG más lecturas de sensores y registros; la acción A consiste en ajustes discretos o continuos sobre w_e y sobre coeficientes de la fórmula de riesgo; la recompensa R refleja la reducción de incidentes, la mejora en precisión de predicción y la minimización de costes operativos. El agente busca políticas que maximicen una función objetivo compuesta por seguridad y eficiencia operativa, aprendiendo a priorizar señales tempranas que históricamente preceden accidentes.

Diseño experimental: Dataset: registros anonimizados de incidentes en espacios confinados de una gran planta manufacturera, lecturas de sensores ambientales (oxígeno, CO2, gases combustibles, H2S), logs de actividad de personal y mantenimiento. Baseline: evaluación tradicional basada en checklists realizada por expertos. Métricas: precisión y recall en identificación de peligros contra evaluación experta, correlación entre R_i y frecuencia real de incidentes, reducción de casi accidentes y tiempo de respuesta. Se valida también la capacidad de predicción en tiempo real comparando rangos medidos por sensores con predicciones del sistema, evaluando desviación media y tasa de aciertos.

Simulación y gemelo digital: Se utiliza un gemelo digital para reproducir condiciones de espacios confinados con sensores simulados y múltiples escenarios de fallo. Estas simulaciones permiten probar la robustez del KG, la reacción del RL y la calidad de embeddings bajo condiciones variadas, incluyendo fallos de sensores, cambios ambientales y errores humanos.

Técnicas de análisis de datos: Se integran series temporales de sensores con análisis de anomalías (por ejemplo detección basada en modelado ARIMA o redes neuronales recurrentes), embeddings de grafos para representación latente y algoritmos de clustering para agrupar escenarios similares. Node2Vec o variantes permiten aprender representaciones que alimentan clasificadores supervisados para estimar P_i y modelos de severidad. La inferencia bayesiana proporciona actualización de incertidumbres y permite razonamiento explicable ante decisiones críticas.

Escalabilidad y hoja de ruta: Corto plazo 1-2 años: piloto en espacios clave para optimizar construcción del KG y calibración de parámetros. Mediano plazo 3-5 años: despliegue en múltiples instalaciones, integración con sistemas de gestión de mantenimiento y desarrollo de aplicaciones móviles para reportes en tiempo real. Largo plazo 5-10 años: integración con sensores wearables, mantenimiento predictivo automatizado, arquitecturas cloud nativas y aprendizaje federado para compartir conocimiento entre plantas sin comprometer privacidad. Q2BSTUDIO apoya este recorrido ofreciendo servicios de desarrollo de software a medida y arquitecturas escalables en la nube, con expertise en servicios cloud aws y azure.

Verificación y validación: Los modelos bayesianos se evalúan mediante métricas de verosimilitud y validación cruzada; la calidad de embeddings se evalúa midiendo la tasa de recuperación de pares semánticamente similares; el rendimiento del agente RL se valida en simulación y en pruebas controladas midiendo reducción de tiempos de respuesta y de incidentes. También se implementan auditorías de ciberseguridad y pruebas de integridad de datos para evitar manipulación de sensores o ataques que comprometan la seguridad operativa.

Aplicaciones prácticas y retorno de inversión: En un escenario operativo, el sistema puede detectar una subida de metano y correlacionarla con eventos pasados que han precedido a atmósferas con deficiencia de oxígeno. El KG prioriza la amenaza, el sistema emite alarmas y sugiere medidas mitigadoras inmediatas. La priorización basada en datos permite optimizar la asignación de recursos y reducir costes por incidentes. Q2BSTUDIO integra estas capacidades con soluciones empresariales personalizadas, implementando desde la captura de datos hasta cuadros de mando y agentes IA que automatizan decisiones operativas.

Servicios de Q2BSTUDIO: Como empresa de desarrollo de software, Q2BSTUDIO ofrece soluciones completas para implementar sistemas de identificación y priorización de riesgos basados en grafos semánticos. Nuestros servicios incluyen consultoría en inteligencia artificial, desarrollo de aplicaciones móviles y web, integración con sensores y plataformas cloud, ciberseguridad y pentesting para proteger la cadena de datos. Si su organización necesita adaptar estas tecnologías a su operación contamos con equipos expertos en software a medida y aplicaciones a medida y en servicios de inteligencia artificial para empresas y agentes IA.

Palabras clave y posicionamiento: aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA, power bi. Estas keywords se integran de forma natural en soluciones de BI para la visualización de riesgos y seguimiento de KPIs, permitiendo cuadros de mando que facilitan la toma de decisiones y el cumplimiento normativo.

Conclusión: La dinámica de grafos semánticos de conocimiento combinada con inferencia bayesiana, embeddings de grafo y aprendizaje por refuerzo ofrece una vía robusta y escalable para transformar la gestión de riesgos en espacios confinados. Q2BSTUDIO ofrece la experiencia técnica necesaria para diseñar, implementar y proteger estas soluciones a medida, integrándolas con infraestructuras cloud y plataformas de inteligencia de negocio para maximizar seguridad y eficiencia operativa.

Contacto y próxima etapa: Para explorar una prueba de concepto o un piloto industrial que demuestre la eficacia del sistema en su entorno, Q2BSTUDIO facilita evaluaciones iniciales, integración con sensores existentes y desarrollo de tableros de control personalizados con Power BI y servicios de inteligencia de negocio.

Nota: Este documento es una descripción técnica y comercial inicial que resume la arquitectura, los métodos y la propuesta de valor. Una versión extendida y técnica del manuscrito puede desarrollarse para publicación académica o documentación de proyecto, incorporando resultados experimentales, métricas cuantitativas y procedimientos de validación reproducibles.

Comentarios