Mecanismo KC-EMA: Análisis Teórico y Derivación para IIL

Este artículo presenta una derivación teórica detallada del mecanismo KC-EMA aplicado a Instance-Incremental Learning IIL, explicando sus fundamentos, formulación matemática intuitiva y pautas prácticas para su implementación en sistemas de aprendizaje continuo.

Contexto y problemas a resolver: Instance-Incremental Learning IIL contempla la llegada continua de nuevos instantes y datos de entrenamiento sin acceso completo a los datos históricos. Los retos clásicos son olvido catastrófico, deriva de representaciones y calibrado de prototipos de clase. El mecanismo KC-EMA propone una solución híbrida que combina estimación exponencial móvil EMA con una regularización de consistencia de conocimiento Knowledge Consistency KC para mantener representaciones estables y transferir conocimiento entre instantes.

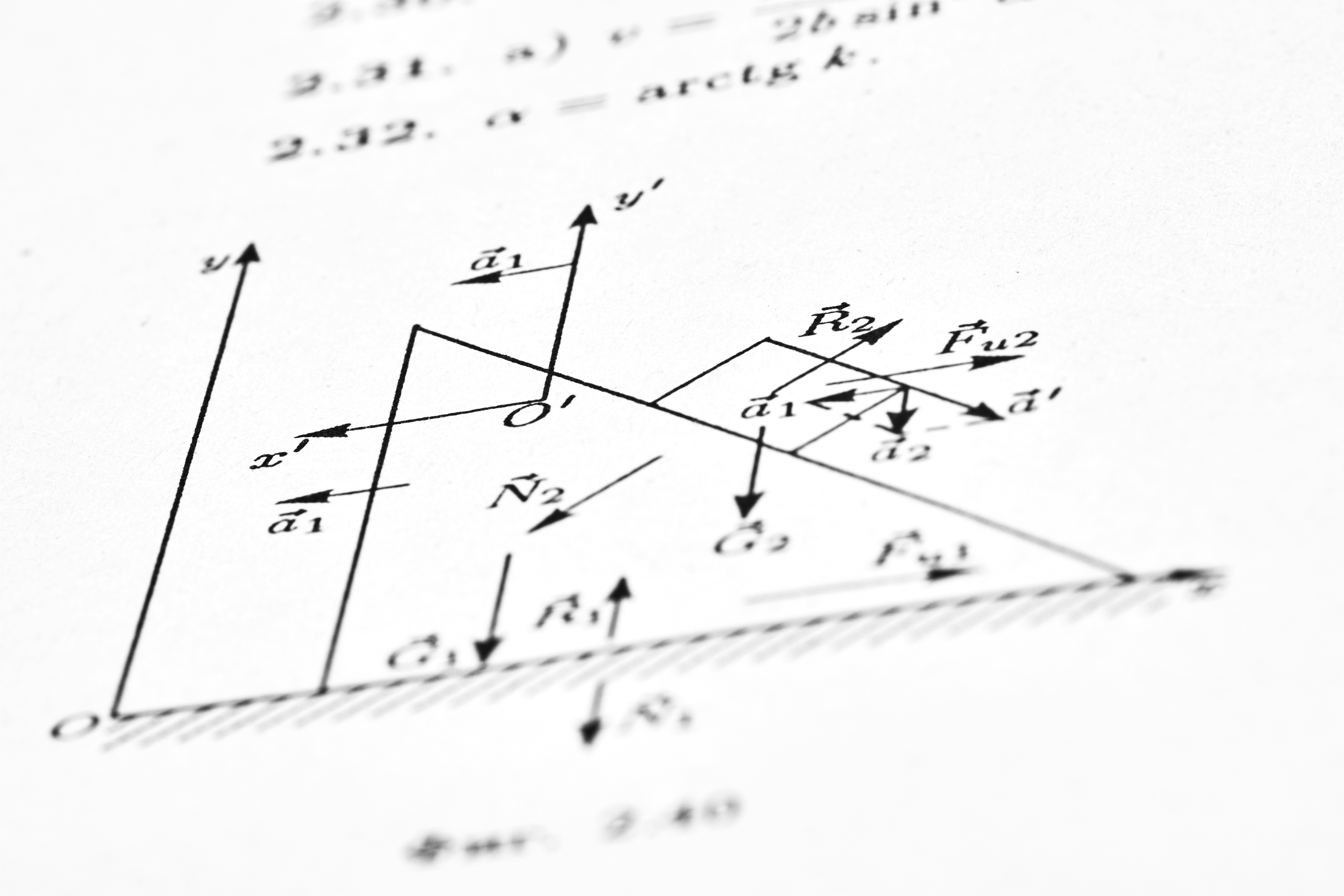

Elementos y notación: Sea f_theta la función extractor de características parametrizada por theta. Para una muestra x se obtiene la representación z = f_theta(x). Denotamos por m_k las representaciones prototípicas o centroides asociados a la clase k en el instante t. Además introducimos un modelo teacher cuyos parámetros theta_tch se actualizan mediante EMA de los parámetros student theta_std. Usamos alpha para la tasa EMA en prototipos y beta para la tasa EMA en parámetros del teacher.

Actualización EMA de parámetros: La actualización exponencial móvil para parámetros del teacher se escribe de forma recursiva como theta_tch(t) = beta theta_tch(t-1) + (1-beta) theta_std(t). De manera análoga los prototipos m_k se actualizan como m_k(t) = alpha m_k(t-1) + (1-alpha) mu_k(t) donde mu_k(t) es la estimación instantánea del centro de la clase k en el lote actual. Esta forma garantiza que las representaciones acumuladas integren información histórica con mayor peso en instantes recientes según alpha y beta.

Término de consistencia de conocimiento KC: La clave de KC-EMA es imponer que la salida de la red student sea consistente con la del teacher y con los prototipos históricos. Definimos una pérdida de consistencia L_kc que puede tomar varias formas según el diseño: distancia de Kullback-Leibler entre distribuciones softmax p_std y p_tch, o distancia de coseno entre embeddings y prototipos. Un ejemplo práctico es L_kc = E_x DKL(p_tch(y|x) p_std(y|x)) o L_kc = E_x (1 - cos(z, m_y)) donde m_y es el prototipo de la clase verdadera. KC aplica además un enmascaramiento de confianza: solo contribuyen las instancias para las que la probabilidad del teacher supera un umbral tau, reduciendo la propagación de etiquetas erróneas en fases tempranas.

Formulación global de la pérdida: El aprendizaje en cada paso optimiza una combinación de términos: L = L_cls + lambda_kd L_kd + lambda_kc L_kc + lambda_reg R donde L_cls es la pérdida de clasificación supervisada en nuevos ejemplos, L_kd es una pérdida de distilación clásica entre student y teacher y R es una regularización sobre prototipos o parámetros. Los pesos lambda_kd y lambda_kc controlan la transferencia de conocimiento y la fuerza de la consistencia respectivamente. En IIL es recomendable aumentar gradualmente lambda_kc conforme el teacher acumula estabilidad.

Derivación intuitiva del comportamiento: La EMA sobre prototipos actúa como un filtro pasabajas que amortigua variaciones abruptas en las representaciones de clase cuando aparecen nuevos ejemplos o clases. La regularización KC empuja a la student a alinearse con la media histórica, mitigando el desplazamiento de frontera que provoca el olvido. La distilación L_kd permite transferir conocimiento fino presente en el teacher sin imponer de forma rígida la salida, y el umbral de confianza evita arrastrar ruido. Matemáticamente, la tasa de olvido efectivo se reduce aproximadamente en proporción a la memoria del EMA, es decir a la magnitud de 1/(1-alpha) en promedio de ventanas temporales.

Consideraciones prácticas: Selección de hyperparámetros alpha y beta depende del ritmo de cambio de datos. Valores de alpha cercanos a 0.9 0.99 conservan memoria larga; valores bajos permiten adaptación rápida pero mayor riesgo de olvido. El umbral de confianza tau debe calibrarse con un conjunto de validación incremental. En escenarios con muchas clases nuevas por lote es útil combinar KC-EMA con estrategias de muestreo y con almacenamiento de un buffer reducido de exemplares representativos.

Variantes y extensiones: 1 Uso de prototipos ponderados por incertidumbre en lugar de medias simples, 2 integración de regularizadores de margen entre clases para reforzar la separación de prototipos, 3 aplicación de agentes IA que gobiernen la política de actualización EMA adaptativa usando indicadores de rendimiento. Estas extensiones mejoran la robustez en entornos no estacionarios y de alto ruido.

Implementación y evaluación: Para evaluar KC-EMA en IIL conviene usar métricas estándar como accuracy incremental, forgetting measure y representational drift. Experimentos abarcando distintos ritmos de llegada de clases y niveles de ruido permiten validar la contribución de cada término lambda. En producción, la combinación de KC-EMA con despliegues en la nube y pipelines automatizados facilita el escalado y la monitorización continua.

Q2BSTUDIO y cómo podemos ayudar: En Q2BSTUDIO somos expertos en el desarrollo de soluciones de inteligencia artificial y software a medida. Aplicamos técnicas avanzadas como KC-EMA para sistemas de aprendizaje continuo y ofrecemos servicios integrales que incluyen diseño e implementación de modelos, despliegue en nube y seguridad. Si desea integrar modelos de IIL en productos reales podemos desarrollar desde la arquitectura de datos hasta la interfaz y los agentes IA que supervisen el aprendizaje. Conozca nuestras soluciones de inteligencia artificial y cómo adaptamos la IA para empresas.

Servicios complementarios: Además de IA ofrecemos desarrollo de aplicaciones a medida, servicios de ciberseguridad y pentesting, despliegues en servicios cloud aws y azure, y soluciones de inteligencia de negocio y power bi. Nuestra oferta cubre desde software a medida y automatización de procesos hasta agentes IA y proyectos de business intelligence, lo que permite llevar prototipos de investigación a sistemas productivos seguros y escalables.

Conclusión: KC-EMA es un mecanismo efectivo para Instance-Incremental Learning que combina EMA para estabilidad histórica y una regularización de consistencia de conocimiento para preservar rendimiento frente al olvido. Su implementación cuidadosa y su integración con pipelines robustos permiten a las empresas beneficiarse de aprendizaje continuo en entornos reales. Contacte con Q2BSTUDIO para explorar cómo aplicar estas técnicas en sus productos, optimizando resultados mediante soluciones personalizadas, ciberseguridad y servicios cloud adaptados a sus necesidades.

Comentarios