Análisis de artefactos basado en papel automatizado a través de Grafo Semántico Jerárquico y Fusión Métrica Adaptativa

Este artículo presenta un marco innovador para el análisis automatizado de artefactos en soporte papel, basado en Grafos Semánticos Jerárquicos y una fusión métrica adaptativa que mejora notablemente la detección de daños sutiles y falsificaciones. La propuesta trasciende el procesamiento de imagen convencional al integrar comprensión estructural y contexto semántico, permitiendo detectar incoherencias que antes pasaban desapercibidas y ofreciendo una solución escalable para autenticación documental.

Introducción: La autenticación de documentos históricos, billetes, certificados y obras en papel plantea retos por la complejidad material y la sutileza de alteraciones y copias fraudulentas. Los métodos actuales dependen en exceso de inspección manual o de técnicas de imagen limitadas, con costes elevados y tasas de error significativas. Nuestro enfoque automatiza el análisis, reduciendo la dependencia humana y mejorando la trazabilidad y reproducibilidad de las evaluaciones.

Metodología: La arquitectura propuesta consta de cuatro módulos principales integrados en un flujo de trabajo coherente: Ingesta multimodal y normalización, Descomposición semántica y estructural, Canal de evaluación multinivel y Bucle de metaautoevaluación.

1 Ingesta multimodal y normalización: Se procesan imágenes en alta resolución en visible (RGB), sensores NIR y medidas de reflectancia junto con documentos digitales (PDF). El preprocesado incluye conversión PDF a AST, OCR avanzado para extracción de texto, limpieza y normalización de imágenes para mitigar ruido y variabilidad de escaneos.

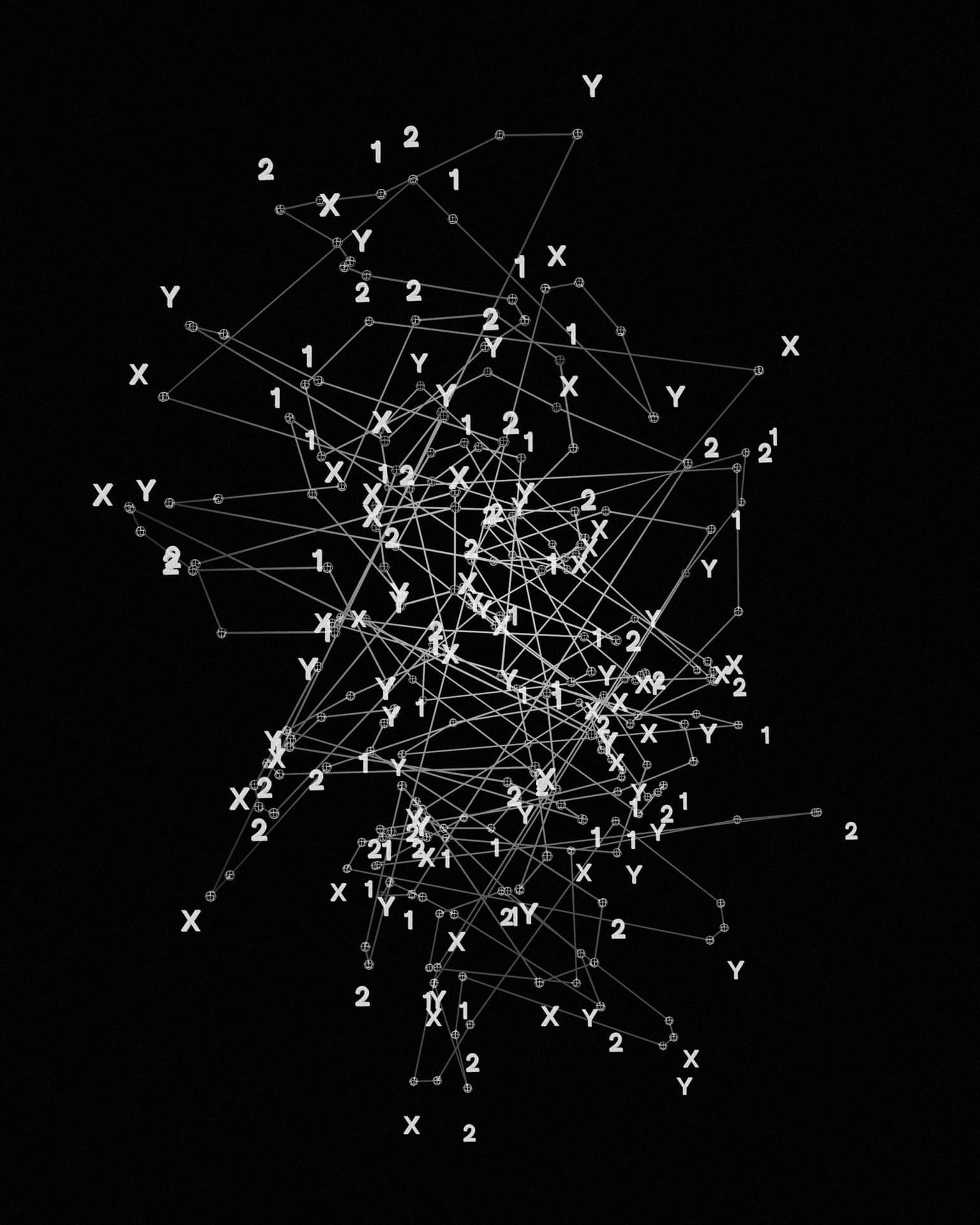

2 Descomposición semántica y estructural: Un parser basado en Transformers integra texto, símbolos, marcas de agua y datos de figuras en una representación unificada que luego se transforma en un Grafo Semántico Jerárquico HSG. Los nodos del HSG representan segmentos textuales, elementos gráficos o características físicas como fibras o depósitos de tinta; las aristas codifican relaciones espaciales, referencias semánticas y dependencias causales.

3 Canal de evaluación multinivel: Múltiples motores evalúan distintos aspectos de autenticidad y estado del documento. Motor de consistencia lógica emplea demostradores automáticos para detectar contradicciones textuales o cronológicas. Sandbox de verificación de fórmulas y códigos ejecuta cálculos embebidos y analiza marcas de agua digitales mediante simulaciones Monte Carlo. Análisis de novedad y originalidad compara el HSG con una base vectorial de millones de documentos, midiendo centralidad e independencia para identificar patrones inusuales. Pronóstico de impacto usa Redes Neuronales de Grafos entrenadas con datos de citas y patentes para estimar la relevancia a largo plazo. Puntuación de reproducibilidad genera protocolos automáticos y simulaciones de gemelo digital para validar experimentos previos.

4 Bucle de metaautoevaluación: Un lazo cerrado ajusta dinámicamente pesos y parámetros del pipeline mediante una función de autoevaluación que combina métricas operativas y un factor de aprendizaje continuo. Este mecanismo permite converger hacia evaluaciones más finas al incorporar retroalimentación de resultados verificados.

Diseño experimental y datos: Los conjuntos de datos incluyen repositorios públicos de documentos históricos, muestras de moneda y colecciones de arte, complementadas con colecciones privadas autenticadas. La partición propuesta es 60 por ciento entrenamiento, 20 por ciento validación y 20 por ciento prueba. Las métricas de evaluación contemplan precisión, recall, F1 y ROC AUC para caracterizar balance entre detecciones verdaderas y falsas alarmas.

Hipótesis y métricas: La combinación de análisis estructural y semántico con fusión métrica adaptativa pretende aumentar la tasa de detección de manipulaciones sutiles respecto a métodos tradicionales. La experimentación debe confirmar mejoras cuantificables en precision y recall manteniendo una tasa controlada de falsos positivos.

Fórmula HyperScore y arquitectura de cálculo: Para priorizar documentos de alto valor se propone un HyperScore que amplifica la valoración V producida por el pipeline. Fórmula HyperScore = 100 * [1 + (s(beta * ln(V) + bias))^gamma] donde V es la puntuación cruda en rango 0 a 1, ln(V) aplica compresión logarítmica, s(z) es la función sigmoide s(z) = 1 / (1 + e^-z), beta controla sensibilidad de la curva, bias centra la sigmoide y gamma es un exponente de potenciación que enfatiza puntuaciones altas. La arquitectura de cálculo sigue etapas de log-stretch, ganancia beta, shift por bias, aplicación de sigmoide, potencia y escalado final a 0 100.

Escalabilidad y hoja de ruta: En el corto plazo se planea despliegue en nube capaz de procesar decenas de miles de documentos por mes, enfocándose en servicios especializados de autenticación. En el medio plazo la integración con sistemas de gestión documental y expansión a sectores como verificación de siniestros e empresas de subastas. A largo plazo se prevé desarrollo de dispositivos edge con sensores miniaturizados y cómputo acelerado para autenticación en origen en tiempo real.

Limitaciones y consideraciones: El rendimiento depende de OCR y calidad de imagen; fuentes raras o degradación extrema pueden degradar los resultados. La construcción y mantenimiento de una base vectorial extensa implica inversión inicial y gobernanza de datos. Además, la interpretación de resultados para contextos legales o curatoriales requiere criterios humanos y trazabilidad clara.

Aplicaciones prácticas y valor para empresas: El marco es aplicable en conservación de patrimonio, bancos centrales, casas de subastas y aseguradoras. Para empresas que requieren soluciones a medida, Q2BSTUDIO ofrece desarrollo de software a medida y aplicaciones a medida especialmente diseñadas para integración con flujos de trabajo existentes. Nuestras capacidades en inteligencia artificial permiten adaptar parsers Transformer y modelos de GNN a colecciones propietarias, mientras que los servicios cloud aws y azure se utilizan para escalabilidad y seguridad operacional.

Sobre Q2BSTUDIO: Q2BSTUDIO es una empresa de desarrollo de software y soluciones tecnológicas que combina experiencia en software a medida, inteligencia artificial, ciberseguridad y servicios cloud. Ofrecemos consultoría y ejecución completa desde la captura de requisitos hasta la puesta en producción, incluyendo servicios de ciberseguridad y pentesting, y soluciones de inteligencia de negocio y power bi para explotar insights derivados de los análisis. Si quiere conocer nuestras soluciones de desarrollo a medida visite servicios de desarrollo de aplicaciones y software multiplataforma y para proyectos de inteligencia artificial y automatización de modelos consulte nuestras soluciones de inteligencia artificial.

Palabras clave y posicionamiento: aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA, power bi aparecen integradas de forma natural en la propuesta para mejorar la visibilidad en búsquedas relacionadas y atraer clientes que necesitan soluciones personalizadas y seguras.

Conclusión: La integración de Grafos Semánticos Jerárquicos con fusión métrica adaptativa representa un avance significativo en el análisis automatizado de documentos en papel, permitiendo detectar patrones semánticos y estructurales que complementan el análisis físico. Combinado con prácticas robustas de ingeniería de software y servicios cloud hoy disponibles a través de empresas como Q2BSTUDIO, este enfoque ofrece una ruta práctica y escalable hacia una autenticación más precisa, reproducible y eficiente.

Contacto y próximos pasos: Para proyectos de implementación, pilotos o consultoría técnica contacta con Q2BSTUDIO y descubre cómo podemos adaptar esta tecnología a tus necesidades de negocio y seguridad documental.

Comentarios