Traer el modelo de lenguaje localmente corrido (LLM) a tu proyecto NodeJS

Introducción: si quieres incorporar inteligencia artificial en tu proyecto, una opción práctica es ejecutar un modelo de lenguaje localmente y conectarlo desde NodeJS sin depender de servicios de pago. En este artículo explico cómo traer un LLM a tu equipo, configurarlo con Docker y consumirlo desde una aplicación NodeJS, además de cómo esto encaja con los servicios profesionales que ofrecemos en Q2BSTUDIO como desarrollo de aplicaciones a medida y soluciones de inteligencia artificial para empresas.

Elegir el modelo: visita la web de Ollama y revisa los modelos disponibles. En este ejemplo utilizo deepseek-r1 porque funciona bien en equipos con GPU. Selecciona la variante que se adapte a la memoria de tu tarjeta: por ejemplo deepseek-r1:14b ocupa aproximadamente 9 GB y es adecuada para una GPU con 12 GB como una RTX 4070 Ti. Ejecutar modelos en GPU acelera la inferencia y mejora la experiencia de prueba.

Preparar Docker: si no tienes Docker, instala Docker Desktop desde la web oficial y sigue las instrucciones para tu sistema operativo. Para levantar los servicios conviene usar Docker Compose con al menos dos contenedores: uno para Ollama que expone el endpoint del modelo y otro para la interfaz web que facilita la administración. En la sección de recursos del compose incluye la reserva de dispositivo GPU mediante deploy resources reservations devices capabilities [ gpu ] para dar acceso a la tarjeta desde el contenedor.

Configurar Ollama: una vez que los contenedores estén en marcha, abre la Web UI típica en http://localhost:8088 y accede al panel de administración. En Settings y Connections puedes gestionar las conexiones de la API y descargar modelos desde Ollama.com usando la opción Pull a model from introduciendo la etiqueta del modelo como deepseek-r1:14b. El proceso de descarga puede tardar según el tamaño del modelo y la velocidad de tu disco.

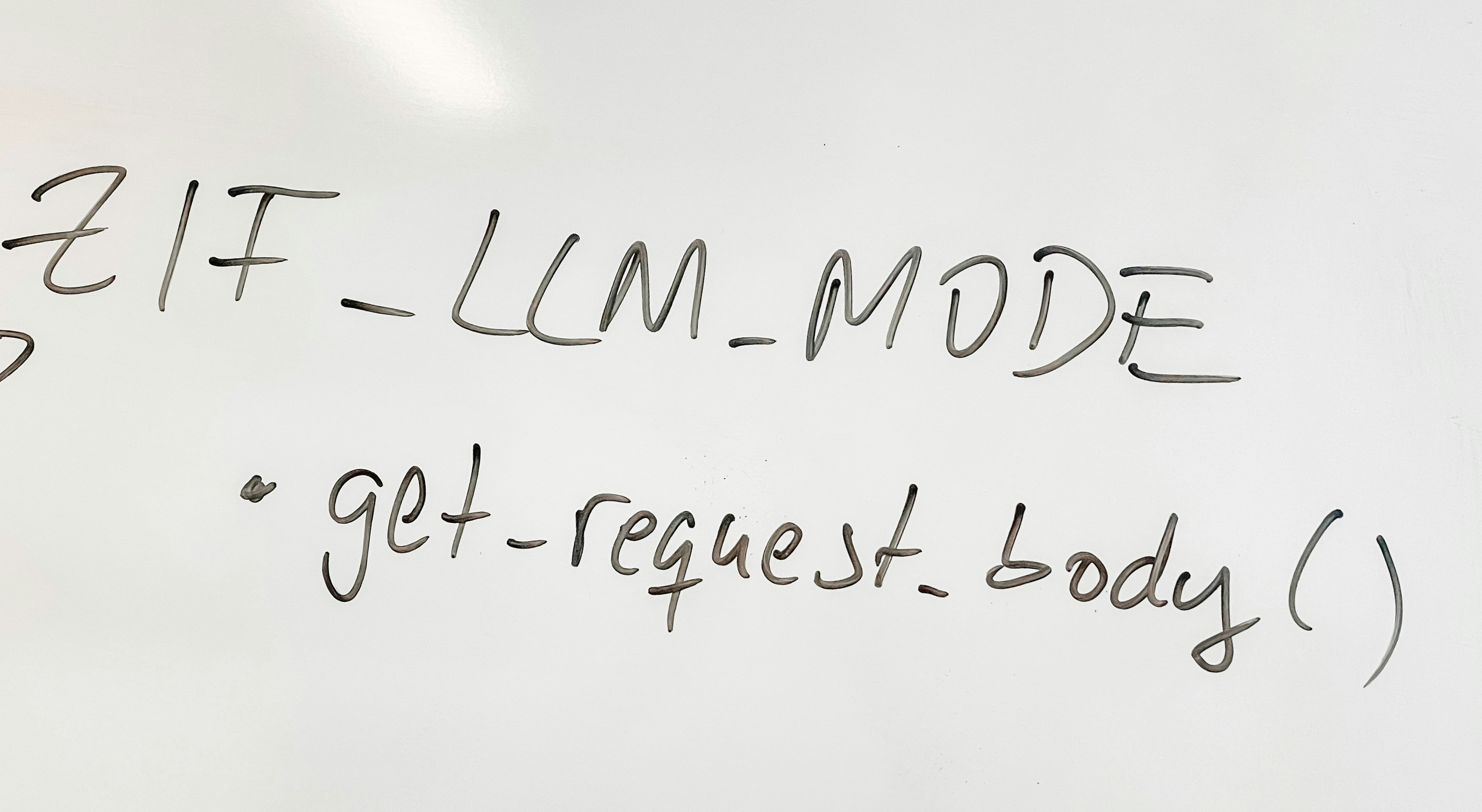

Probar el modelo en local: tras descargar el modelo puedes interactuar desde la Web UI o desde tu aplicación. En NodeJS instala el cliente oficial con npm add ollama y desde tu código inicializa el cliente apuntando al host local en el puerto 11434. Envía una petición de chat especificando el modelo deepseek-r1:14b y una lista de mensajes con roles system y user; finalmente procesa la respuesta y transforma el contenido a JSON si el formato devuelto lo requiere. Esta integración permite validar prompts, cadenas de diálogo y estructuras de respuesta antes de escalar a entornos más controlados.

Buenas prácticas y seguridad: aunque correr un LLM local es una excelente manera de experimentar, ten en cuenta aspectos de seguridad y operativa. Si necesitas acceso remoto, compra una IP estática o configura VPN y autentica las conexiones. Para entornos de producción es preferible usar soluciones gestionadas o infraestructuras dedicadas con políticas de acceso, cifrado y auditoría. En Q2BSTUDIO combinamos experiencia en ciberseguridad y pentesting para auditar despliegues y minimizar riesgos en proyectos que manejen datos sensibles.

Caso de uso y conectividad remota: yo ejecuté el LLM en un equipo Windows con GPU y una IP estática contratada con el ISP, y desde un servidor externo me conecté al endpoint para realizar pruebas. Esta arquitectura es útil para proyectos piloto, pruebas de concepto y para desarrollar agentes IA que residan cerca de los datos. Si buscas escalabilidad y alta disponibilidad, es recomendable migrar a servicios cloud gestionados o a infraestructuras en AWS o Azure según demanda.

Servicios relacionados y cómo podemos ayudar: en Q2BSTUDIO ofrecemos desarrollo de aplicaciones a medida que integran modelos LLM y agentes IA en flujos de negocio, además de servicios de integración con la nube. Si necesitas construir una solución a medida podemos ayudarte a definir la arquitectura y a implementar la seguridad necesaria. Conecta con nuestro equipo de inteligencia artificial en servicios de inteligencia artificial o consulta nuestras capacidades para crear aplicaciones y software a medida que incluyan agentes IA, pipelines de inferencia y visualización con Power BI.

Palabras clave y valor añadido: este enfoque apoya proyectos de aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA y power bi. Si tu objetivo es validar ideas rápidamente, probar modelos y reducir costos iniciales, ejecutar un LLM local es una opción sólida antes de pasar a una infraestructura productiva.

Conclusión: desplegar un LLM en local y conectarlo desde NodeJS es una vía ágil para experimentar con IA, validar prompts y construir prototipos. Para producción conviene evaluar opciones gestionadas y reforzar seguridad. En Q2BSTUDIO podemos acompañarte en todo el ciclo, desde la prueba de concepto hasta la puesta en marcha segura y escalable de soluciones de inteligencia artificial y software a medida.

Comentarios