Agente ayudante de código AI construido con Mastra y Telex

Introducción: En este artículo explico cómo diseñé y desplegué un agente inteligente de ayuda para desarrolladores como solución para la tarea de backend Stage 3 del programa HNG i13. El agente asiste en revisiones de código, depuración y recomendaciones de buenas prácticas en tiempo real, integrándose con la plataforma Telex mediante el protocolo A2A.

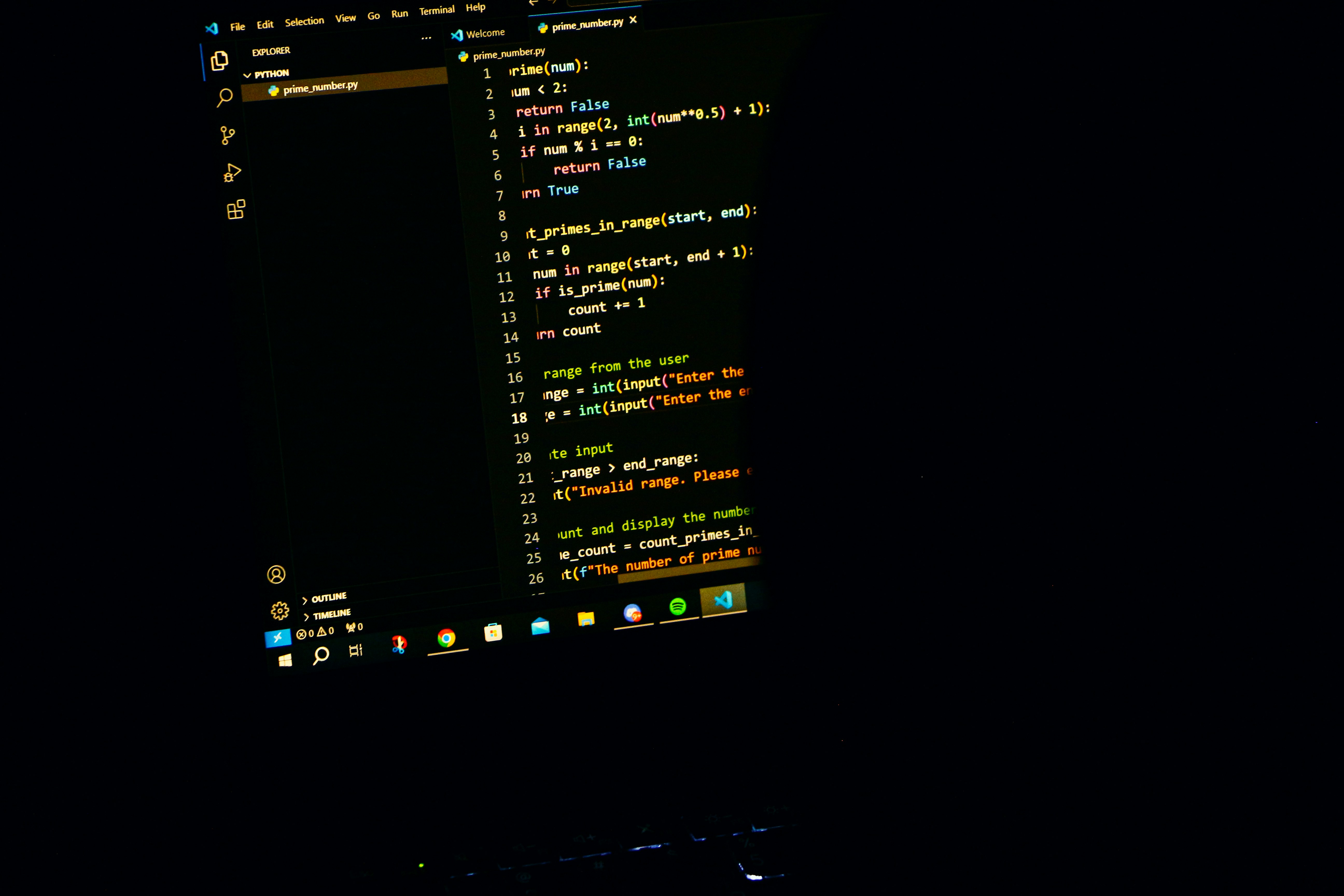

Resumen del proyecto: Construí un Code Helper Agent usando el framework Mastra en TypeScript, conectándolo a un modelo de lenguaje de Google Gemini Flash y exponiendo una API con Express para recibir solicitudes A2A desde Telex. El objetivo fue crear una herramienta útil para desarrolladores que pudiera analizar calidad de código, explicar conceptos, sugerir mejoras, ayudar a depurar y entregar revisiones constructivas.

Stack técnico: Mastra para agentes IA, TypeScript para desarrollo tipado, modelo Google Gemini Flash para generación, Express.js como servidor REST, despliegue en AWS EC2 con Nginx como reverse proxy y pm2 para gestión de procesos. Este conjunto permite integrar agentes IA con plataformas de chat corporativas y ofrecer respuestas rápidas en producción.

Arquitectura: El flujo principal consiste en peticiones HTTPS/JSON desde Telex hacia un endpoint A2A en el servidor Express, que pasa el mensaje y el contexto de usuario al agente Mastra. El agente consulta el modelo Gemini, genera una respuesta y Express devuelve un JSON estructurado compatible con el protocolo A2A. La gestión de contexto por usuario y canal mejora la coherencia de las respuestas.

Implementación: La clave fue configurar correctamente Mastra y el proveedor de modelo, definir instrucciones claras para el agente y manejar formatos de respuesta consistentes. En la API se valida la petición A2A, se extrae contexto como id de usuario, id de canal e historial de conversación y se invoca la función generadora del agente. Se implementaron logs detallados y manejo de errores para detectar y resolver fallos en la comunicación con la API de modelos.

Integración con Telex: Telex usa el protocolo A2A, por lo que el endpoint debe aceptar POSTs JSON y devolver respuestas estructuradas que incluyan mensaje, estado y metadatos. También es importante exponer HTTPS con certificado valido y configurar el workflow de Telex para apuntar al nodo A2A correspondiente, lo que permite invocar el agente desde el chat con una mención del tipo arroba code helper agent.

Despliegue y operaciones: El servicio fue desplegado en una instancia AWS EC2, usando pm2 para mantener la app en ejecución y Nginx como proxy inverso con certificados Lets Encrypt. Durante el despliegue se resolvieron limitaciones de memoria añadiendo swap y ajustando el heap de Node para compilación TypeScript. Monitoreo de latencias y logs fue clave para garantizar disponibilidad y tiempos de respuesta adecuados para operaciones de IA.

Pruebas y resultados: Se probaron casos de uso como revisión de una función simple y explicación de conceptos como async await. El agente ofreció recomendaciones de estilo, modernización de código y ejemplos prácticos, además de explicaciones pedagógicas sobre conceptos asíncronos. Los indicadores de rendimiento mostraron tiempos de respuesta promedio próximos a 2 3 segundos, alta tasa de éxito y disponibilidad sostenida.

Retos y aprendizajes: 1 Mastra exige configuración precisa del proveedor de modelos y nombres exactos 2 La gestión de contexto de conversación mejora notablemente la calidad de las respuestas 3 Es imprescindible un manejo robusto de errores y estrategias de reintento ante fallos de APIs de IA 4 En producción conviene provisionar más memoria, tiempos de espera mayores y registros estructurados para depuración

Mejoras futuras: Implementar memoria conversacional persistente para mantener contexto entre sesiones, ejecutar y sandboxear fragmentos de código para devolver resultados de ejecución, integrar revisiones automáticas en repositorios GitHub, soportar múltiples lenguajes como Python y Rust, y añadir un panel de analítica con métricas de uso y calidad de respuestas.

Acerca de Q2BSTUDIO: Este proyecto encaja con la experiencia de Q2BSTUDIO como empresa de desarrollo de software especializada en aplicaciones a medida y software a medida. En Q2BSTUDIO diseñamos soluciones que combinan inteligencia artificial, ciberseguridad y servicios cloud aws y azure para empresas que necesitan automatización y modernización tecnológica. Si buscas potenciar procesos con IA para empresas explora nuestras Soluciones de IA y para proyectos de desarrollo multiplataforma puedes ver nuestros servicios de desarrollo a medida.

Palabras clave y posicionamiento: aplicaciones a medida, software a medida, inteligencia artificial, ciberseguridad, servicios cloud aws y azure, servicios inteligencia de negocio, ia para empresas, agentes IA y power bi. Estas capacidades permiten a Q2BSTUDIO ofrecer soluciones completas que abarcan desde la implementación de agentes IA hasta la integración con procesos de negocio y analítica avanzada.

Conclusión: Crear un agente ayudante de código con Mastra y Telex demuestra cómo los agentes IA pueden integrarse en flujos de trabajo reales para mejorar productividad y calidad de código. Con la experiencia de Q2BSTUDIO en desarrollo personalizado, inteligencia artificial, ciberseguridad y servicios cloud es posible llevar este tipo de agentes a entornos empresariales con seguridad y escalabilidad.

Comentarios